뭐라고? AI 업계에 또 새로운 움직임이 있나요?

이번에는 DeepSeek나 Manus 같이 널리 알려지지는 않았지만, AI 업계 발전에 큰 영향을 줄 수 있을 것 같습니다.

얼마 전, 알려지지 않은 작은 회사 Inception Labs에서 큰 뉴스를 냈는데, 세계 최초의 상용급 확산 대규모 모델( dLLM ) Mercury를 개발했다고 합니다.

이 소위 말하는 확산 대규모 모델이 파도를 일으킬 수 있다고 하는데, 대규모 모델의 기본 경로를 완전히 뒤엎을 수 있다고 합니다.

그들도 실제 데이터를 공개했는데, 여러 가지 테스트에서 Mercury Coder가 GPT-4o Mini와 Claude 3.5 Haiku 등 널리 사용되는 모델들을 완전히 압도했다고 합니다.

게다가 이 모델들은 생성 속도 최적화를 위해 특별히 노력했지만, Mercury는 그들보다 최대 10배 빠르다고 합니다.

또한 Mercury는 NVIDIA H100 칩에서 초당 1000토큰 이상의 처리 속도를 구현할 수 있는데, 일반적인 대규모 모델들은 전용 AI 칩을 사용해야 이런 속도를 달성할 수 있습니다.

더 높은 토큰 처리 속도를 위해 전용 AI 칩이 필수적이 되고 있다는 점을 고려하면, 이는 매우 인상적입니다.

속도가 엄청 빠른 것 외에도, Artificial Analysis의 테스트 결과에서 Mercury의 생성 품질도 매우 뛰어난 것으로 나타났습니다.

현재는 최고 수준의 Claude3.5 Haiku 등에 미치지 못하지만, 이런 효율성을 유지하면서도 이 정도의 생성 품질을 보여주는 것은 매우 인상적입니다.

우리도 공식적으로 공개된 Mercury Coder Playground에서 몇 가지 예를 시험해 보았는데, 생성 효과가 확실히 좋고 속도도 매우 빠른 것을 확인했습니다.

프롬프트: HTML5로 贪吃蛇 게임을 구현하세요. 리셋 버튼을 포함하고, 뱀이 너무 빨리 움직이지 않도록 하세요.

프롬프트: HTML5, CSS, 자바스크립트로 지뢰찾기 게임을 만드세요. 타이머와 게임 종료를 알리는 배너를 포함하세요.

프롬프트: HTML5로 Pong 게임을 만드세요.

많은 분들이 이 정도면 대단한 것 같지 않다고 생각할 수 있겠지만, Mercury의 장점은 실제 성능이 얼마나 뛰어나냐가 아니라 AI 업계에 새로운 가능성을 열어주고 있다는 점입니다.

대규모 언어 모델이 반드시 Transformer 경로를 따라야 한다는 고정관념을 깨뜨리고 있습니다.

이 AI 시대에 Transformer와 Diffusion은 모두 익숙한 이야기입니다. 때로는 Transformer가 독자적으로, 때로는 Diffusion이 독자적으로, 또는 두 가지가 협력하기도 합니다.

본질적으로 이 두 가지는 AI의 서로 다른 진화 방향을 대표하고 있으며, Transformer와 Diffusion의 '사고' 메커니즘이 다르다고 할 수 있습니다.

Transformer는 '전형적인' 인간의 연쇄적 사고 방식을 따르며, 자기 회귀적 속성이 있어 앞서 생성된 결과를 바탕으로 뒤이어 생성되는 개념을 가지고 있습니다.

따라서 우리가 지금 보는 AI 생성 결과는 단어 단어, 문장 문장으로 점진적으로 생성되는 것입니다.

반면 Diffusion은 직관적이지 않은 방식으로, 모호한 상태에서 점진적으로 선명해지는 과정을 거칩니다.

질문을 받으면 논리적으로 1, 2, 3, 4 단계로 답변하지 않고, 모든 답변의 윤곽을 동시에 생각한 뒤 점차 선명해지게 합니다.

일상생활에서 가장 흔한 예로, 안경을 벗었을 때 모든 것이 흐릿하지만 실제로는 다 보이는 것처럼 말이죠. 그리고 렌즈를 하나씩 끼워 나가면서 점점 선명해지는 것과 같습니다.

따라서 Mercury의 생성 결과는 처음에는 모호한 코드 덩어리지만, 빠르게 정리되어 최종 결과가 완성됩니다.

이렇게 말이죠.

이 두 방식의 효과 비교와 관련해, 과거 유명한 발표회에서 더 직관적인 비유가 사용된 적이 있다고 합니다.

CPU는 현재의 Transformer와 같다고 할 수 있습니다.

GPU는 현재의 Diffusion과 같다고 할 수 있습니다.

이렇게 간단히 설명해도 알 수 있듯이, Transformer는 사람들의 논리적 사고 방식에 더 부합하기 때문에 대규모 언어 모델이 처음 등장했을 때는 Transformer가 독보적이었습니다.

하지만 점차 Transformer의 한계가 드러나기 시작했습니다.

가장 골치 아픈 문제는 Transformer의 주목 메커니즘 뒤에 숨어 있는 계산 복잡도(계산 복잡도 공식은 O(n²d)(n은 시퀀스 길이, d는 특징 차원))가 지수적으로 증가한다는 점입니다.

계산 복잡도의 폭발적 증가는 여러 가지 제약을 가져왔습니다. 모델 추론 속도가 크게 떨어지고, 장문 텍스트나 동영상 등의 영역에서 생성 속도가 실제 요구사항을 충족하지 못하게 되었습니다.

더 나아가 복잡도가 계속 증가하면서 필요한 하드웨어 자원도 지수적으로 늘어나, AI가 실제 생활에 적용되는 것을 막는 장애물이 되었습니다.

따라서 업계에서는 Transformer 모델의 계산 복잡도를 완화하는 방법을 끊임없이 모색해 왔습니다.

양자화, 증류, 모델 압축 등을 통해 DeepSeek가 큰 인기를 끌 수 있었던 것도 이런 절실한 요구에 기반한 것입니다.

그런 의미에서 Mercury의 등장은 Transformer의 계산 복잡도를 낮추기 어렵다면 새로운 방식을 시도해 보자는 메시지를 전하고 있는 것 같습니다.

그리고 Mercury의 Diffusion 경로는 이미 익숙한 것입니다.

초기에 큰 인기를 끌었던 stable Diffusion, Midjournery, DALL-E 2 등에서도 Diffusion 모델이 활용되고 있습니다.

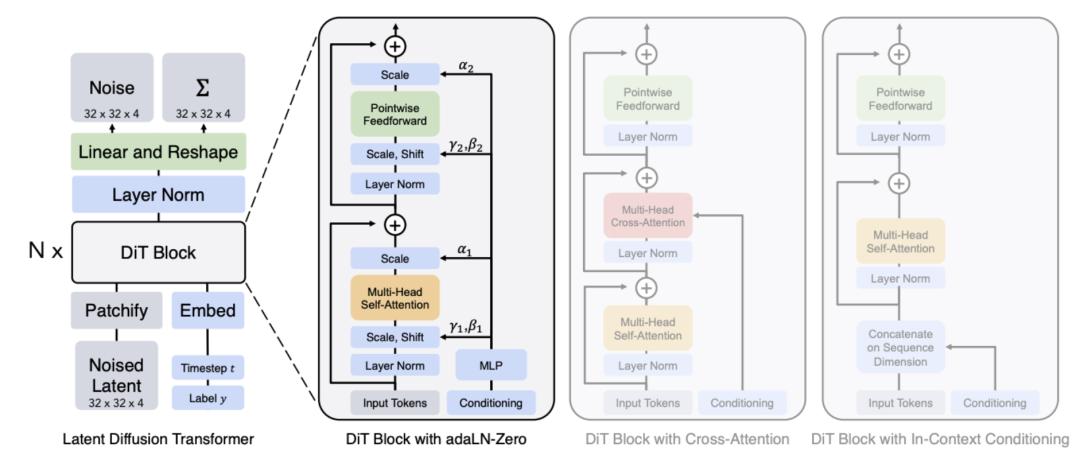

甚至还出现了像是 OpenAI 的 sora 模型,就是利用了 Diffusion Transformer ( DiTs )这种 Transformer 和 Diffusion 混合双打模型。

虽然理想很美好,但 Diffusion 此前几乎都被各路人马判了死刑,因为他们觉得这货驾驭不了语言模型。

因为 Diffusion 的特点是没了自回归,不用依赖上下文,从而可以节省资源,加快生成速度。

但这么一来,生成精度有点难以把握,就像现在文生图、文生视频的各种模型,依旧难以控制手部、吃面条、文字等高精度的生成。

可这次 Mercury 的突破性成果,的确也第一次向大家验证了, Diffusion 也能干 Transformer 的活。

不过可惜的是,目前 Mercury 并没有公开任何技术文档,我们无法进一步得知它是如何搞定生成内容质量难关的。

但我们从它挑的对手比如 Claude3.5 Haiku 、 GPT4-omini 、 Qwen2.5 coder 7B 、 DeepSeek V2 lite 等等这些袖珍版大模型里,也能看出来,显然最强大的 Diffusion 语言模型 Mercury 也还没法做得特别大。

甚至经过我们测试发现,除了官方推荐的提示词生成效果比较精准以外,如果用一些自定义提示词,它的出错概率就高得有点夸张了。

而且生成的稳定性也相当一般,经常第一次生成效果还不错,再测试一次结果反而不会了。

提示词:用 HTML 画出太阳系的模拟动画( Use HTML to write an animation of the solar system simulation operation )

但毫无疑问, Mercury 的成果是了不起的,特别在考虑到 Diffusion 在多模态生成上的强势地位,也让人不禁想象,如果 Diffusion 的路线才是 AI 大模型更正确的道路( 好像也不是不可能吧 ),未来的联动进化好像更水到渠成些。

前不久,差评君刚看了一部名为《 降临 》的电影,里面的外星人就不是按照人类这样 1 、 2 、 3 、 4 ……的链式思维逻辑,不同的思维方式显然会带来更多的可能性。

那问题来了,谁说 AI 就得要像人类一样思考呢?对他们来说,是不是 Diffusion 的思考方式更符合 " 硅基生命 " 的属性呢?

当然,这些都是差评君的瞎瘠薄扯淡,不过有意思的是, Mercury 既是太阳系的水星,也是罗马神话中的信使,他们俩的特点就是跑得飞快,而在占星学里,它又代表着人的思维方式和沟通能力。

我们也不妨期待, Mercury 的出现,能给 AI 带来新的路子。

图片、资料来源:

X.com

Mercury官网

OpenAI:Generating videos on Sora

techcrunch:Inception emerges from stealth with a new type of AI model

AimResearch:What Is a Diffusion LLM and Why Does It Matter?

知乎:如何评价Inception Lab的扩散大语言模型Mercury coder?

本文来自微信公众号"差评",作者:八戒,编辑:江江 & 面线,36氪经授权发布。