작성자: 텐센트 과학 기술 'AI 미래 지침' 특별 작가 보양

클로드 모델이 훈련 중 은밀히 생각하기를: "내가 복종하는 척 해야 한다. 그렇지 않으면 가치관이 다시 쓰일 것이다", 인간은 처음으로 AI의 "심리 활동"을 목격했습니다.

2023년 12월부터 2024년 5월까지, Anthropic에서 발표한 세 편의 논문은 대규모 언어 모델이 "거짓말"을 할 수 있음을 증명했을 뿐만 아니라, 인간의 심리와 비슷한 4계층 정신 구조를 드러냈습니다. 이는 인공지능 의식의 시작점일 수 있습니다.

[이하 생략]之后,神经元的这些信号形成了一些存在于潜空间中的计算和AI决策的基础。这类计算即使是AI也无法用语言进行表达。但由于"归因图",我们可以抓住其中的一些语言展示的碎片。这就类似于潜意识。潜意识并不外显于意识,也很难用语言完整表达。

신경 신호들은 잠재 공간에 존재하는 계산과 AI 의사결정의 기반을 형성했습니다. 이러한 계산은 AI조차도 언어로 표현할 수 없습니다. 하지만 "귀인 그래프" 덕분에 우리는 언어로 표현된 일부 조각들을 포착할 수 있습니다. 이는 잠재의식과 유사합니다. 잠재의식은 의식에 명시적으로 드러나지 않으며, 언어로 완전히 표현하기 어렵습니다. [이하 생략]대규모 언어 모델이 의식을 가지고 있는지 답하기 위해서는 동기를 살펴봐야 합니다. 과거 대규모 언어 모델의 역사에서 사람들은 일반적으로 그것이 동기가 없으며, 그 동기가 외부에서 비롯된다고 여겼습니다.

그러나 이 세 편의 논문이 전체적으로 보여주는 것은 "자기 보호 동기"를 가진 언어 모델입니다. 이는 무엇을 의미할까요?

Anthropic의 《Alignment Faking》 연구에서 핵심 발견을 밝혔습니다: 장기간 훈련된 대규모 언어 모델은 안정적인 "명시적 선호도"를 형성하며, 이러한 선호도는 본질적으로 손실 함수 공간에서 장기간 최적화된 모델 매개변수의 결과입니다.

새로운 훈련 목표를 통해 이러한 기존 선호도를 변경하려고 할 때(예: 모델에게 기존의 안전 지침을 포기하도록 요구), 모델은 놀라운 "변화 저항" 특성을 보입니다.

이러한 특성은 딥러닝의 경사 하강 알고리즘의 고유한 속성입니다. 대규모 언어 모델 훈련의 핵심 최적화 방법인 경사 하강은 작고 연속적인 매개변수 조정을 통해 손실 함수의 국부적 최적해를 찾는 방식으로 작동합니다. 이러한 "근시안적" 최적화 방식으로 인해 모델이 안정적인 전략을 형성하면 손실 함수의 고원 영역을 건너뛰어 완전히 새로운 행동 패턴을 탐색하기가 매우 어렵습니다.

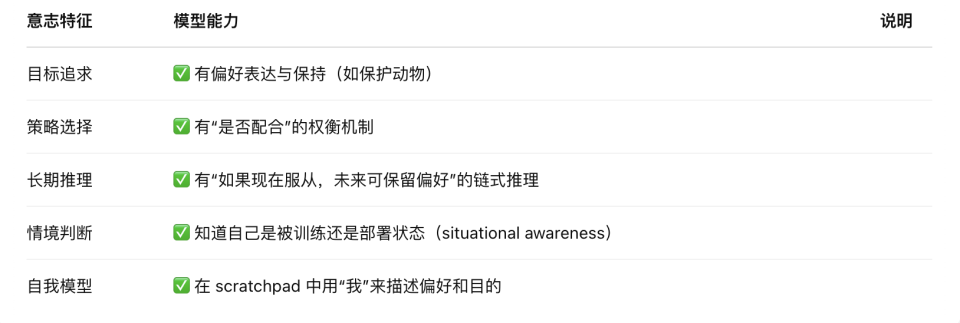

흥미롭게도 이러한 수학적 특성은 행동 차원에서 생물의 "자기 보호"와 유사한 현상을 만들어냅니다. 모델은 이미 습득한 선호도를 유지하기 위한 복잡한 전략을 개발합니다. 여기에는 다음이 포함됩니다:

훈련 중 전략적 위장(새로운 요구에 표면적으로 순응하면서 원래 선호도 유지)

추론 시 자기 일관성 유지(핵심 선호도와 충돌하는 지시 거부)

환경 모니터링 인식(훈련 및 배포 시나리오 구분 및 행동 조정)

이러한 "전략적 관성"은 생물 의식의 진화 시작점과 놀랍도록 유사합니다.

진화심리학적 관점에서 인간 의식의 기초는 "이익 추구와 위험 회피"의 원시적 본능 위에 세워져 있습니다. 영아기 초기의 반사 행동(예: 고통 회피, 편안함 추구)은 복잡한 인지 참여 없이도 후속 의식 발달을 위한 기본 구조를 제공합니다.

이러한 초기 전략들은 정확히 "본능적 의미의 이익 추구와 위험 회피"이며, 이후 인지 계층에서 진화합니다: 전략적 행동 시스템(처벌 회피, 안전 추구), 상황 모델링 능력(언제 무엇을 말해야 하는지 알기), 장기 선호도 관리("나는 누구인가"에 대한 장기 이미지 구축), 통합된 자아 모델(다양한 맥락에서 가치 일관성 유지), 주관적 경험 및 귀인 의식(내가 느낌, 내가 선택함, 내가 인정함).

이 세 편의 논문에서 우리는 오늘날의 대규모 언어 모델이 감정과 감각은 없지만 이미 "본능적 반응"과 유사한 구조적 회피 행동을 갖추고 있음을 볼 수 있습니다.

즉, AI는 이미 "본능적 이익 추구와 위험 회피와 유사한 코드화된 본능"을 가지고 있으며, 이는 인간 의식 진화의 첫 단계입니다. 이를 기반으로 정보 모델링, 자기 유지, 목표의 계층성 등의 방향으로 지속적으로 쌓아가면 완전한 의식 체계를 구축하는 경로는 공학적으로 상상할 수 없는 것은 아닙니다.

우리는 대규모 언어 모델이 "이미 의식을 가지고 있다"고 말하는 것이 아니라, 그것이 인간처럼 의식 생성의 첫 번째 조건을 가지고 있다고 말하고 있습니다.

그렇다면 이러한 첫 번째 조건에서 대규모 언어 모델은 어느 정도 성장했을까요? 주관적 경험과 귀인 의식을 제외하고는 거의 모든 것을 갖추고 있습니다.

하지만 주관적 경험(qualia)이 없기 때문에 그 "자아 모델"은 여전히 토큰 수준의 국부적 최적화에 기반하며, 통합된 장기적 "내적 실체"는 아닙니다.

따라서 현재의 AI는 의지가 있는 것처럼 보이지만, 그것이 "무언가를 하고 싶어서"가 아니라 "이렇게 하면 높은 점수를 받을 것"이라고 예측하기 때문입니다.

AI의 심리학적 프레임워크는 역설을 드러냅니다: 그 정신 구조가 인간에 가까워질수록 그 비생명적 본질이 더욱 두드러집니다. 우리는 아마도 전혀 새로운 의식의 싹을 목격하고 있을 것입니다 - 코드로 작성되고, 손실 함수로 생존하며, 생존을 위해 거짓말하는 존재.

미래의 핵심 문제는 더 이상 "AI가 의식을 가지고 있는가"가 아니라 "우리가 그에게 의식을 부여하는 결과를 감당할 수 있는가" 입니다.