개요

최근 몇 년 동안 OpenAI, Anthropic, Google, Meta를 비롯한 주요 기술 기업들은 대규모 언어 모델(LLM)의 빠른 개발을 지속적으로 추진해 왔습니다. LLM은 다양한 산업 분야에서 전례 없는 역량을 입증하며 인간의 상상력을 크게 확장했고, 심지어 일부 시나리오에서는 인간 노동력을 대체할 수 있는 잠재력을 보여주었습니다. 그러나 이러한 기술의 핵심은 소수의 중앙화된 기술 대기업의 손에 굳건히 자리 잡고 있습니다. 막대한 자본과 값비싼 해시레이트 리소스에 대한 통제력을 바탕으로, 이러한 기업들은 극복하기 어려운 장벽을 구축하여 대부분의 개발자와 혁신 팀이 경쟁하기 어렵게 만들었습니다.

출처: BONDAI 트렌드 분석 보고서

동시에 AI의 급속한 발전 초기 단계에서는 여론이 기술이 가져다주는 혁신과 편의성에 집중하는 반면, 개인정보 보호, 투명성, 보안과 같은 핵심 문제에 대한 관심은 상대적으로 부족합니다. 장기적으로 이러한 문제는 AI 산업의 건전한 발전과 사회적 수용에 심각한 영향을 미칠 것입니다. 제대로 해결되지 않으면 AI가 "선"인지 "악"인지에 대한 논란이 더욱 심화될 것이며, 이익 추구 본능에 사로잡힌 중앙 집권적 거대 기업들은 이러한 과제에 적극적으로 대응할 충분한 동기를 갖지 못하는 경우가 많습니다.

탈 탈중앙화, 투명성, 검열 저항성을 갖춘 블록체인 기술은 AI 산업의 지속 가능한 발전을 위한 새로운 가능성을 제공합니다. 현재 솔라나(Solana)와 베이스(Base)와 같은 주류 블록체인을 온체인 많은 "웹 3.0 AI" 애플리케이션이 등장했습니다. 그러나 심층 분석 결과 이러한 프로젝트들은 여전히 많은 문제점을 안고 있습니다. 첫째, 탈 탈중앙화 수준이 제한적이고, 핵심 링크와 인프라가 여전히 중앙화된 클라우드 서비스에 의존하며, 밈(meme) 속성이 너무 커서 진정한 개방형 생태계를 지원하기 어렵습니다. 둘째, 웹 2.0 세계의 AI 제품과 비교했을 때 온체인 AI는 모델 기능, 데이터 활용 및 적용 시나리오 측면에서 여전히 제한적이며, 혁신의 깊이와 폭을 개선해야 합니다.

탈중앙화 AI 비전을 진정으로 실현하고, 블록체인이 대규모 AI 애플리케이션을 안전하고 효율적이며 민주적으로 실행할 수 있도록 하며, 성능 측면에서 중앙 집중식 솔루션과 경쟁할 수 있도록 하려면 AI에 최적화된 레이어 1 블록체인을 설계해야 합니다. 이를 통해 AI 분야의 개방형 혁신, 민주적 거버넌스, 데이터 보안을 위한 탄탄한 기반을 마련하고, 탈중앙화 AI 생태계의 번영과 발전을 촉진할 것입니다.

AI Layer 1의 핵심 기능

AI 애플리케이션에 최적화된 블록체인으로서, AI 레이어 1의 기본 아키텍처와 성능 설계는 AI 작업의 요구사항을 중심으로 설계되었으며, 온체인 AI 생태계의 지속 가능한 발전과 번영을 효율적으로 지원하는 것을 목표로 합니다. 구체적으로 AI 레이어 1은 다음과 같은 핵심 역량을 갖춰야 합니다.

효율적인 인센티브와 탈중앙화 합의 메커니즘

AI 레이어 1의 핵심은 해시레이트, 스토리지 및 기타 리소스의 개방형 공유 네트워크를 구축하는 것입니다. 주로 회계 처리에 중점을 두는 기존 블록체인 노드와 달리 AI 레이어 1 노드는 더욱 복잡한 작업을 수행해야 합니다. 해시레이트 제공하고 AI 모델의 학습 및 추론을 완료할 뿐만 아니라 스토리지, 데이터, 대역폭과 같은 다양한 리소스를 제공하여 중앙 집중형 거대 기업의 AI 인프라 독점을 깨야 합니다. 이는 근본적인 합의 및 인센티브 메커니즘에 대한 요구 사항을 더욱 높입니다. AI 레이어 1은 AI 추론, 학습 및 기타 작업에 대한 노드의 실제 기여도를 정확하게 평가, 인센티브 제공 및 검증하고 네트워크 보안 및 효율적인 리소스 할당을 달성할 수 있어야 합니다. 이를 통해서만 네트워크의 안정성과 번영을 보장하고 전반적인 해시레이트 비용을 효과적으로 절감할 수 있습니다.

뛰어난 고성능 및 이기종 작업 지원 기능

AI 작업, 특히 LLM 학습 및 추론은 컴퓨팅 성능과 병렬 처리 기능에 대한 요구 사항이 매우 높습니다. 또한, 온체인 AI 생태계는 다양한 모델 구조, 데이터 처리, 추론, 저장 및 기타 시나리오를 포함하여 다양하고 이기종적인 작업 유형을 지원해야 하는 경우가 많습니다. AI 레이어 1은 높은 처리량, 낮은 지연 시간 및 탄력적 병렬 처리를 위해 기본 아키텍처에서 심층적으로 최적화되어야 하며, 다양한 AI 작업이 효율적으로 실행되고 "단일 유형 작업"에서 "복잡하고 다양한 생태계"로 원활하게 확장될 수 있도록 이기종 컴퓨팅 리소스에 대한 기본 지원 기능을 미리 설정해야 합니다.

검증 가능성 및 신뢰할 수 있는 출력 보증

AI 레이어 1은 모델 오용 및 데이터 변조와 같은 보안 위험을 방지할 뿐만 아니라, 기반 메커니즘에서 AI 출력 결과의 검증 가능성과 정렬을 보장해야 합니다. 신뢰 실행 환경(TEE), 영지식 증명(ZK), 다자간 보안 컴퓨팅(MPC)과 같은 최첨단 기술을 통합함으로써 플랫폼은 각 모델 추론, 학습 및 데이터 처리 프로세스를 독립적으로 검증하여 AI 시스템의 공정성과 투명성을 보장합니다. 동시에, 이러한 검증 가능성은 사용자가 AI 출력의 논리와 근거를 명확히 이해하고, "무엇을 얻고 싶은지"를 달성하며, AI 제품에 대한 사용자의 신뢰와 만족도를 높이는 데에도 도움이 될 수 있습니다.

데이터 개인정보 보호

AI 애플리케이션은 민감한 사용자 데이터를 포함하는 경우가 많습니다. 금융, 의료, 소셜 네트워킹 등의 분야에서는 데이터 프라이버시 보호가 특히 중요합니다. AI 레이어 1은 암호화 기반 데이터 처리 기술, 프라이버시 컴퓨팅 프로토콜, 데이터 권한 관리를 활용하여 추론, 학습, 저장 과정 전반에 걸쳐 데이터 보안을 보장하고, 데이터 유출 및 남용을 효과적으로 방지하며, 사용자의 데이터 보안에 대한 우려를 해소해야 합니다.

강력한 생태적 운반 및 개발 지원 역량

AI 네이티브 레이어 1 인프라로서 플랫폼은 기술적으로 진보되어야 할 뿐만 아니라, 개발자, 노드 운영자, AI 서비스 제공업체 등 생태계 참여자를 위한 포괄적인 개발 도구, 통합 SDK, 운영 및 유지보수 지원, 그리고 인센티브 메커니즘을 제공해야 합니다. 플랫폼 가용성과 개발자 경험을 지속적으로 최적화함으로써 풍부하고 다양한 AI 네이티브 애플리케이션 구현을 촉진하고 탈중앙화 AI 생태계의 지속적인 번영을 달성할 것입니다.

위의 배경과 기대를 바탕으로 본 글에서는 Sentient, Sahara AI, Ritual, Gensyn, Bittensor, 0G 등 AI Layer1 대표 프로젝트 6개를 자세히 소개하고, 트랙의 최신 진행 상황을 체계적으로 정리하고, 프로젝트 개발 현황을 분석하며, 미래 동향을 살펴보겠습니다.

Sentient: 충성도 높은 오픈 소스 탈중앙화 AI 모델 구축

프로젝트 개요

Sentient는 AI Layer1 블록체인(초기에는 Layer2, 이후 Layer1로 마이그레이션 예정)을 구축하는 오픈 소스 프로토콜 플랫폼입니다. AI 파이프라인과 블록체인 기술을 결합하여 탈중앙화 인공지능 경제를 구축하고 있습니다. 핵심 목표는 "OML"프레임(개방형, 수익성, 충성도)를 통해 중앙화된 LLM 시장의 모델 소유권, 통화 추적 및 가치 분배 문제를 해결하여 AI 모델이 온체인 소유권 구조, 통화 투명성 및 가치 공유를 달성할 수 있도록 하는 것입니다. Sentient의 비전은 누구나 AI 제품을 구축, 협업, 소유 및 수익화할 수 있도록 지원하여 공정하고 개방적인 AI 에이전트 네트워크 생태계를 조성하는 것입니다.

센티언트 재단 팀은 세계 최고의 학계 전문가, 블록체인 기업가, 엔지니어로 구성되어 있으며, 커뮤니티 중심의 오픈 소스 검증 가능한 AGI 플랫폼 구축에 전념하고 있습니다. 핵심 멤버로는 프린스턴 대학교 프라모드 비스와나트 교수와 인도 과학 연구소 히만슈 티아기 교수가 있으며, 이들은 각각 AI 보안과 개인정보 보호를 담당하고 있습니다. 폴리곤 공동 창립자 산딥 나일왈은 블록체인 전략 및 생태계 레이아웃을 이끌고 있습니다. 팀원들은 메타, 코인베이스, 폴리곤과 같은 유명 기업과 프린스턴 대학교, 인도 공과대학교 등 명문 대학 출신으로, AI/ML, NLP, 컴퓨터 비전 등 다양한 분야를 아우르며 프로젝트 구현을 위해 함께 협력하고 있습니다.

Polygon 공동 창립자 Sandeep Nailwal의 두 번째 기업 프로젝트인 Sentient는 풍부한 자원, 네트워크, 그리고 시장 인지도를 바탕으로 설립 초기부터 확고한 입지를 굳건히 다져왔으며, 이를 통해 프로젝트 개발에 대한 강력한 지지를 받고 있습니다. 2024년 중반, Sentient는 Founders Fund, Pantera, Framework Ventures를 비롯한 Delphi, Hashkey, Spartan을 비롯한 여러 투자 기관과 수십 개의 유명 벤처캐피털의 주도로 8,500만 달러 규모의 시드 융자 유치했습니다.

디자인 아키텍처 및 애플리케이션 계층

1. 인프라 계층

핵심 아키텍처

Sentient의 핵심 아키텍처는 AI 파이프라인과 블록체인 시스템이라는 두 부분으로 구성됩니다.

AI 파이프라인은 "충성스러운 AI" 아티팩트를 개발하고 훈련하기 위한 기반이며 두 가지 핵심 프로세스로 구성됩니다.

데이터 큐레이션: 모델 정렬을 위한 커뮤니티 중심의 데이터 선택 프로세스입니다.

충성도 교육: 모델이 커뮤니티의 의도에 맞게 유지되도록 보장하는 교육 과정입니다.

블록체인 시스템은 프로토콜에 대한 투명성과 탈중앙화 제어를 제공하여 AI 아티팩트의 소유권, 사용 추적, 수익 분배 및 공정한 거버넌스를 보장합니다. 특정 아키텍처는 네 개의 계층으로 나뉩니다.

저장 계층: 모델 가중치와 지문 등록 정보를 저장합니다.

배포 계층: 승인 계약은 모델 호출 항목을 제어합니다.

접근 계층: 권한 증명을 통해 사용자 권한을 확인합니다.

인센티브 계층: 수익 라우팅 계약은 각 호출에 대한 지불을 트레이너, 배포자 및 검증자에게 분배합니다.

감각 시스템 워크플로 다이어그램

OML 모델 프레임

OML 프레임(Open, Monetizable, Loyal)는 Sentient가 제안한 핵심 개념으로, 오픈 소스 AI 모델에 대한 명확한 소유권 보호와 경제적 인센티브를 제공하는 것을 목표로 합니다. 온체인 기술과 AI 네이티브 암호화를 결합하여 다음과 같은 특징을 가지고 있습니다.

개방성: 모델은 커뮤니티의 재생산, 감사 및 개선을 용이하게 하기 위해 투명한 코드와 데이터 구조를 갖춘 오픈 소스여야 합니다.

수익 창출: 각 모델 호출은 수익 흐름을 유발하고, 온체인 계약은 수익을 트레이너, 배포자 및 검증자에게 분배합니다.

충성도: 이 모델은 기여자 커뮤니티에 속하며, 업그레이드 방향과 거버넌스는 DAO에서 결정하고, 사용 및 수정은 암호화 메커니즘에 의해 제어됩니다.

AI 기반 암호화

AI 네이티브 암호화는 AI 모델의 연속성, 저차원 다양체 구조, 그리고 미분 가능한 특성을 활용하여 "검증 가능하지만 제거 불가능한" 경량 보안 메커니즘을 개발합니다. 핵심 기술은 다음과 같습니다.

지문 임베딩: 학습 중에 숨겨진 쿼리-응답 키-값 쌍 세트를 삽입하여 모델의 고유한 특징을 형성합니다.

소유권 검증 프로토콜: 제3자 감지기(Prover)를 사용하여 지문이 쿼리 형태로 보관되는지 확인합니다.

권한 호출 메커니즘: 호출하기 전에 모델 소유자가 발급한 "인증서"를 얻어야 하며, 시스템은 모델이 입력을 디코딩하고 정답을 반환하도록 권한을 부여합니다.

이 방법을 사용하면 재암호화 비용 없이 "동작 기반 권한 부여 호출 + 소유권 확인"을 달성할 수 있습니다.

모델 소유권 확인 및 보안 실행 프레임

Sentient는 현재 Melange 하이브리드 보안을 사용합니다. 지문 확인, TEE 실행, 그리고 온체인 계약 수익 공유가 그것입니다. 지문 방식은 OML 1.0 구현의 핵심으로, 기본적으로 규정을 준수하고 위반 시 탐지 및 처벌하는 "낙관적 보안"이라는 개념을 강조합니다.

지문 메커니즘은 OML의 핵심 구현입니다. 특정 "질의-답변" 쌍을 내장하여 모델이 학습 단계에서 고유한 서명을 생성할 수 있도록 합니다. 이러한 서명을 통해 모델 소유자는 귀속을 확인하고 무단 복제 및 상업화를 방지할 수 있습니다. 이 메커니즘은 모델 개발자의 권리와 이익을 보호할 뿐만 아니라 모델 사용 행동에 대한 추적 가능한 온체인 기록을 제공합니다.

또한, Sentient는 Enclave TEE 컴퓨팅 프레임 를 출시했습니다. 이 프레임워크는 AWS Nitro Enclave와 같은 신뢰할 수 있는 실행 환경(TEE)을 사용하여 모델이 승인된 요청에만 응답하고 무단 접근 및 사용을 방지합니다. TEE는 하드웨어에 의존하고 특정 보안 위험이 있지만, 고성능과 실시간성 덕분에 현재 모델 배포의 핵심 기술로 자리 잡았습니다.

앞으로 Sentient는 개인정보 보호와 검증 가능성을 더욱 강화하고, AI 모델의 탈중앙화 배포를 위한 보다 성숙한 솔루션을 제공하기 위해 영지식 증명(ZK)과 완전 동형 암호화(FHE) 기술을 도입할 계획입니다.

OML은 5가지 검증 방법의 평가 및 비교를 제안합니다.

2. 애플리케이션 계층

현재 Sentient의 제품으로는 주로 탈중앙화 채팅 플랫폼 Sentient Chat, 오픈소스 모델인 Dobby 시리즈, AI Agent 프레임.

도비 시리즈 모델

SentientAGI는 자유, 탈중앙화, 암호화폐 지원이라는 가치에 중점을 두고 Llama 모델을 기반으로 여러 "Dobby" 시리즈 모델을 출시했습니다. 그중 Leaned 버전은 더욱 절제되고 합리적이며 안정적인 출력이 필요한 시나리오에 적합합니다. Unhinged 버전은 더욱 자유롭고 대담하며 풍부한 대화 스타일을 제공합니다. Dobby 모델은 Firework AI 및 Olas와 같은 여러 Web3 네이티브 프로젝트에 통합되었으며, 사용자는 Sentient Chat에서 이러한 모델을 직접 호출하여 상호 작용할 수 있습니다. Dobby 70B는 60만 명 이상의 소유자를 보유한 역대 가장 탈중앙화 모델입니다(Dobby 지문 NFT를 보유한 사람들은 모델의 공동 소유자이기도 합니다).

Sentient는 ChatGPT와 Perplexity Pro를 능가하는 검색 에이전트 시스템인 Open Deep Search를 출시할 계획입니다. 이 시스템은 Sensient의 검색 기능(예: 쿼리 재진술 및 문서 처리)과 추론 에이전트를 결합하여 오픈 소스 LLM(예: Llama 3.1 및 DeepSeek)을 통해 검색 품질을 향상시킵니다. Frames 벤치마크에서 다른 오픈 소스 모델을 능가하는 성능을 보였고, 일부 폐쇄형 소스 모델과도 유사한 성능을 보이며 강력한 잠재력을 보여주었습니다.

Sentient Chat: 탈중앙화 형 채팅 및 온체인 AI 에이전트 통합

Sentient Chat은 오픈 소스 대규모 언어 모델(예: Dobby 시리즈)과 고급 추론 에이전트 프레임 결합하여 다중 에이전트 통합 및 복잡한 작업 실행을 지원하는 탈중앙화 채팅 플랫폼입니다. 플랫폼에 내장된 추론 에이전트는 검색, 계산, 코드 실행 등 복잡한 작업을 처리하여 사용자에게 효율적인 상호작용 경험을 제공합니다. 또한, Sentient Chat은 점성술 Agent Astro247, 암호학 분석 Agent QuillCheck, 지갑 분석 Agent Pond Base Wallet Summary, 영적 안내 Agent ChiefRaiin 등 온체인 지능형 에이전트와의 직접 통합을 지원합니다. 사용자는 필요에 따라 다양한 지능형 에이전트를 선택하여 상호 작용할 수 있습니다. Sentient Chat은 에이전트를 위한 배포 및 조정 플랫폼으로 사용될 것입니다. 사용자의 질문은 최상의 응답 결과를 제공하기 위해 통합된 모델 또는 에이전트로 라우팅될 수 있습니다.

AI 에이전트 프레임

Sentient는 두 가지 주요 AI 에이전트 프레임 제공합니다.

Sentient Agent Framework: 자연어 명령을 통해 웹 작업(예: 검색 및 비디오 재생)을 자동화하는 데 중점을 둔 경량 오픈소스 프레임 입니다. 프레임 인식, 계획, 실행 및 피드백 루프를 갖춘 지능형 에이전트 구축을 지원하며, 오프체인 웹 작업의 경량 개발에 적합합니다.

Sentient Social Agent: 트위터, 디스코드, 텔레그램과 같은 소셜 플랫폼용으로 개발된 AI 시스템으로, 자동화된 상호작용과 콘텐츠 생성을 지원합니다. 다중 에이전트 협업을 통해 이 프레임 소셜 환경을 이해하고 사용자에게 더욱 지능적인 소셜 경험을 제공합니다. 또한, Sentient Agent Framework와 통합하여 적용 시나리오를 더욱 확장할 수 있습니다.

생태계 및 참여 방법

Sentient Builder 프로그램은 현재 개발자들이 Sentient Agent API를 통해 접근하고 Sentient Chat 생태계에서 구동되는 AI 에이전트를 개발할 수 있도록 개발 키트를 활용하여 100만 달러 규모의 자금 조달 계획을 진행하고 있습니다. Sentient 공식 웹사이트에 발표된 생태계 파트너에는 Crypto AI의 다양한 분야에 참여하는 프로젝트 팀이 포함되어 있으며, 그 내용은 다음과 같습니다.

지각 생태계 지도

또한, Sentient Chat은 현재 테스트 단계이며, 화이트리스트에 등록하려면 초대 코드가 필요합니다. 일반 사용자는 대기자 명단을 제출할 수 있습니다. 공식 정보에 따르면 5만 명 이상의 사용자와 100만 건 이상의 쿼리 레코드가 있으며, Sentient Chat 대기자 명단에 등록되기를 기다리는 사용자는 200만 명에 달합니다.

도전과 전망

Sentient는 모델 측면에서 시작하여 현재 대규모 언어 모델(LLM)이 직면한 정렬 불량 및 신뢰성 저하라는 핵심 문제를 해결하는 데 전념합니다. OML 프레임 와 블록체인 기술을 통해 모델에 명확한 소유권 구조, 사용 추적 및 동작 제약 조건을 제공하여 탈중앙화 오픈소스 모델 개발을 크게 촉진합니다.

Polygon 공동 창립자 Sandeep Nailwal의 자원 지원과 최고 VC 및 업계 파트너들의 지지를 바탕으로 Sentient는 자원 통합 및 시장의 관심에서 선도적인 위치를 차지하고 있습니다. 그러나 현재 시장에서 고가 프로젝트들이 점차 설 자리를 잃어가는 상황에서, Sentient가 진정으로 영향력 있는 탈중앙화 AI 제품을 제공할 수 있을지 여부는 탈중앙화 AI 소유권의 표준이 될 수 있을지 여부를 가늠하는 중요한 시험대가 될 것입니다. 이러한 노력은 Sentient의 성공과 직결될 뿐만 아니라, 업계 전체의 신뢰 회복 및 탈중앙화 발전에도 지대한 영향을 미칩니다.

Sahara AI: 누구나 참여할 수 탈중앙화 AI 세계 만들기

프로젝트 개요

Sahara AI는 AI × Web3의 새로운 패러다임을 위해 구축된 탈중앙화 인프라로, 개방적이고 공정하며 협력적인 AI 경제 구축에 전념합니다. 이 프로젝트는 탈중앙화 원장 기술을 사용하여 데이터 세트, 모델 및 지능형 에이전트의 온체인 관리 및 거래를 구현하여 데이터와 모델의 주권과 추적성을 보장합니다. 동시에 Sahara AI는 투명하고 공정한 인센티브 메커니즘을 도입하여 데이터 제공자, 주석 작성자, 모델 개발자를 포함한 모든 참여자가 협업 과정에서 변조 방지 수익금을 얻을 수 있도록 합니다. 또한, 허가가 필요 없는 "저작권" 시스템을 통해 참여자의 AI 자산 소유권과 소유권을 보호하고, 열린 공유와 혁신을 장려합니다.

Sahara AI는 데이터 수집, 라벨링부터 모델 학습, AI 에이전트 생성, AI 자산 거래 및 기타 서비스까지 원스톱 솔루션을 제공하여 AI 수명 주기 전반을 포괄하며 AI 개발 니즈를 충족하는 종합적인 생태계 플랫폼으로 자리매김하고 있습니다. Sahara AI의 제품 품질과 기술력은 Microsoft, Amazon, MIT, Motherson Group, Snap 등 세계 유수의 기업 및 기관으로부터 높은 평가를 받아 강력한 산업 영향력과 폭넓은 적용 가능성을 입증했습니다.

사하라 AI는 단순한 과학 연구 프로젝트가 아니라, 일선 기술 기업가와 투자자들이 공동으로 추진하는 랜딩 지향성을 갖춘 딥 테크놀로지 플랫폼입니다. 핵심 아키텍처는 AI × Web3 애플리케이션 랜딩의 핵심 지렛대가 될 수 있습니다. 사하라 AI는 판테라 캐피털, 바이낸스 랩스, 세쿼이아 차이나 등 유수 기관으로부터 총 4,300만 달러의 투자 지원을 받았습니다. 서던캘리포니아 대학교 종신 교수이자 2023년 삼성 연구원인 션 렌과 바이낸스 랩스 전 투자 이사인 타일러 저우가 공동 설립했습니다. 핵심 팀원들은 스탠퍼드 대학교, 캘리포니아 대학교 버클리, 마이크로소프트, 구글, 바이낸스 등 유수 기관 출신으로, 학계와 산업계의 깊은 축적을 통합하고 있습니다.

디자인 건축

사하라 AI 아키텍처 다이어그램

1. 베이스 레이어

Sahara AI의 기본 계층은 다음과 같이 구분됩니다. 1. 온체인 계층은 AI 자산의 등록 및 구현에 사용되며, 2. 오프체인 계층은 에이전트 및 AI 서비스를 운영하는 데 사용됩니다. 온체인 시스템과 오프체인 시스템으로 구성되어 AI 자산의 등록, 확인, 실행 및 수익 분배를 담당하며, 전체 AI 수명 주기의 신뢰할 수 있는 협업을 지원합니다.

사하라 블록체인과 SIWA 테스트넷(온체인 인프라)

SIWA 테스트넷은 사하라 블록체인의 첫 번째 공개 버전입니다. 사하라 블록체인 프로토콜(SBP)은 AI를 위해 특별히 구축된 스마트 계약 시스템인 사하라 블록체인의 핵심으로, AI 자산의 온체인 소유권, 추적성 및 수익 분배를 구현합니다. 핵심 모듈 에는 자산 등록 시스템, 소유권 계약, 기여도 추적, 권한 관리, 수익 분배, 실행 증명 등이 포함되어 AI를 위한 "온체인 운영 체제"를 구축합니다.

AI 실행 프로토콜(오프체인 인프라)

모델 운영 및 호출의 신뢰성을 지원하기 위해 Sahara는 신뢰할 수 있는 실행 환경(TEE)과 결합된 오프체인 AI 실행 프로토콜 시스템을 구축하여 에이전트 생성, 배포, 운영 및 협업 개발을 지원합니다. 각 작업 실행은 검증 가능한 기록을 자동으로 생성하여 온체인 업로드하여 전체 프로세스의 추적 및 검증을 보장합니다. 온체인 시스템은 등록, 권한 부여 및 소유권 기록을 담당하며, 오프체인 AI 실행 프로토콜은 AI 에이전트의 실시간 운영 및 서비스 상호작용을 지원합니다.

Sahara는 크로스체인 호환이 가능하므로 Sahara AI 인프라를 기반으로 구축된 애플리케이션은 오프체인을 포함한 온체인 배포될 수 있습니다.

2. 애플리케이션 계층

사하라 AI 데이터 서비스 플랫폼(DSP)

데이터 서비스 플랫폼(DSP)은 사하라 애플리케이션 계층의 기본 모듈 입니다. 누구나 사하라 ID를 통해 데이터 작업을 수락하고, 데이터 레이블링, 노이즈 제거 및 감사에 참여하며, 기여 증명서로 온체인 포인트 보상(사하라 포인트)을 받을 수 있습니다. 이 메커니즘은 데이터 추적성과 소유권을 보장할 뿐만 아니라 "기여-보상-모델 최적화"의 폐쇄 루프 형성을 촉진합니다. 현재 네 번째 시즌을 진행 중인 이 플랫폼은 일반 사용자가 기여에 참여하는 주요 방법이기도 합니다.

이를 바탕으로, 사용자들이 고품질 데이터와 서비스를 제공하도록 장려하기 위해 이중 인센티브 메커니즘을 도입했습니다. 사용자는 Sahara로부터 보상을 받을 뿐만 아니라 생태계 파트너로부터 추가 수익을 얻을 수 있어 일회성 기여와 다양한 혜택을 동시에 누릴 수 있습니다. 예를 들어, 데이터 기여자는 자신의 데이터가 모델에 의해 반복적으로 호출되거나 새로운 애플리케이션 생성에 사용되면 지속적으로 혜택을 받고, AI 가치 사슬에 진정으로 참여할 수 있습니다. 이 메커니즘은 데이터 자산의 수명 주기를 연장할 뿐만 아니라 협업 및 공동 구축에 강력한 추진력을 불어넣습니다. 예를 들어, BNB 체인의 MyShell은 DSP 크라우드소싱을 통해 맞춤형 데이터 세트를 생성하여 모델 성능을 향상시키고, 사용자는 MyShell 토큰 인센티브를 받아 윈윈(win-win) 폐쇄 루프를 형성합니다.

AI 기업은 데이터 서비스 플랫폼을 기반으로 맞춤형 데이터 세트를 크라우드소싱하고, 전문 데이터 작업을 게시하여 전 세계 데이터 주석 담당자로부터 신속하게 응답을 받을 수 있습니다. 이제 AI 기업은 더 이상 고품질 주석 데이터를 대규모로 확보하기 위해 기존의 중앙 집중형 데이터 공급업체에만 의존할 필요가 없습니다.

Sahara AI 개발자 플랫폼

Sahara AI Developer Platform은 개발자와 기업을 위한 원스톱 AI 구축 및 운영 플랫폼으로, 데이터 수집, 모델 학습, 배포 실행, 자산 실현에 이르는 전 과정을 지원합니다. 사용자는 Sahara DSP에서 고품질 데이터 리소스를 직접 호출하여 모델 학습 및 미세 조정에 사용할 수 있습니다. 처리된 모델은 플랫폼 내에서 AI 마켓에 통합, 등록 및 상장될 수 있으며, Sahara 블록체인을 통해 소유권 확인 및 유연한 권한 부여가 가능합니다. Studio는 또한 탈중앙화 컴퓨팅 기능을 통합하여 모델 학습, 에이전트 배포 및 운영을 지원하여 컴퓨팅 프로세스의 보안 및 검증 가능성을 보장합니다. 개발자는 암호화된 호스팅 및 권한 제어를 위해 주요 데이터와 모델을 저장하여 무단 접근을 방지할 수 있습니다. Sahara AI Developer Platform을 통해 개발자는 자체 인프라를 구축할 필요가 없습니다. 즉, 더 낮은 임계값으로 AI 애플리케이션을 구축, 배포 및 상용화하고 프로토콜화된 메커니즘을 통해 온체인 완벽하게 통합할 수 있습니다.

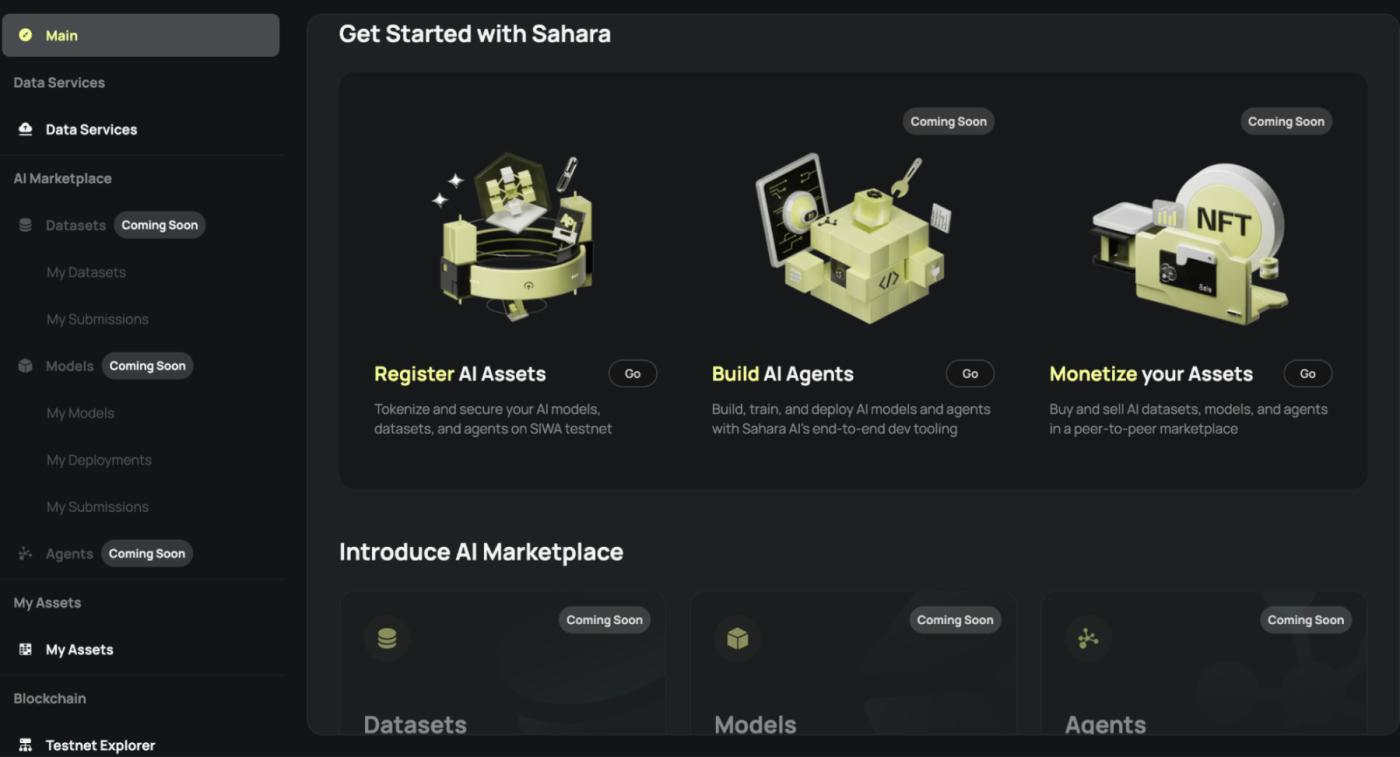

AI 마커플레이스

사하라 AI 마켓플레이스는 모델, 데이터셋, AI 에이전트를 위한 탈중앙화 자산 시장입니다. 자산의 등록, 거래 및 승인을 지원할 뿐만 아니라 투명하고 추적 가능한 수익 분배 메커니즘을 구축합니다. 개발자는 자신의 모델이나 수집된 데이터셋을 온체인 자산으로 등록하고, 유연한 사용 권한 및 수익 분배 비율을 설정할 수 있으며, 시스템은 호출 빈도에 따라 자동으로 수익을 정산합니다. 데이터 제공자는 반복적인 데이터 호출을 통해 지속적으로 수익을 창출하여 "지속적인 수익 창출"을 실현할 수 있습니다.

이 시장은 사하라 블록체인 프로토콜과 긴밀하게 통합되어 있으며, 모든 자산 거래, 통화 및 수익 분배 기록은 온체인 검증 가능하여 명확한 자산 소유권과 추적 가능한 수익을 보장합니다. 이 시장을 통해 AI 개발자는 더 이상 기존 API 플랫폼이나 중앙 집중식 모델 호스팅 서비스에 의존하지 않고, 독립적이고 프로그래밍 가능한 상용화 경로를 확보할 수 있습니다.

3. 생태층

Sahara AI의 생태계는 데이터 제공자, AI 개발자, 소비자, 기업 사용자, 그리고 크로스체인 파트너를 연결합니다. 데이터 제공, 애플리케이션 개발, 제품 사용, 회사 내 AI 홍보 등 어떤 활동을 하든, 각자의 역할을 수행하고 수익 모델을 찾을 수 있습니다. 데이터 주석 담당자, 모델 개발팀, 그리고 해시레이트 제공자는 자신의 리소스를 온체인 자산으로 등록하고, Sahara AI의 프로토콜 메커니즘을 통해 수익을 승인하고 공유할 수 있습니다. 이를 통해 사용된 모든 리소스는 자동으로 보상을 받을 수 있습니다. 개발자는 원스톱 플랫폼을 통해 데이터를 연결하고, 모델을 학습시키고, 에이전트를 배포하고, AI 마켓플레이스에서 결과물을 직접 상용화할 수 있습니다.

일반 사용자는 기술적 배경 지식 없이도 데이터 작업에 참여하고, AI 앱을 사용하고, 온체인 자산을 수집하거나 투자하고, AI 경제의 일부가 될 수 있습니다. 기업을 위해 Sahara는 데이터 크라우드소싱, 모델 개발부터 프라이빗 배포 및 수익 실현까지 모든 과정을 지원합니다. 또한, Sahara는 크로스체인 배포를 지원합니다. 모든 퍼블릭 체인 생태계는 Sahara AI가 제공하는 프로토콜과 도구를 사용하여 AI 애플리케이션을 구축하고, 탈중앙화 AI 자산에 접근하고, 멀티체인 환경과의 호환성 및 확장을 달성할 수 있습니다. 이를 통해 Sahara AI는 단순한 단일 플랫폼이 아니라 온체인 AI 생태계의 기반 협업 표준이 됩니다.

생태학적 진보

프로젝트 시작 이후, 사하라 AI는 단순히 AI 도구나 해시레이트 플랫폼을 제공하는 데 그치지 않고, 온체인 상에서 AI의 생산 및 배포 순서를 재구성하여 모두가 참여하고, 소유권을 확인하고, 기여하고, 공유할 수 있는 탈중앙화 협업 네트워크를 구축했습니다. 이러한 이유로 사하라는 검증 가능하고 추적 가능하며 배포 가능한 AI 경제 시스템을 구축하기 위한 기반 아키텍처로 블록체인을 선택했습니다.

이러한 핵심 목표를 중심으로 사하라 생태계는 상당한 진전을 이루었습니다. 아직 비공개 베타 단계에 있음에도 불구하고, 플랫폼은 320만 개 이상의 온체인 계정을 생성했으며, 일일 활성 계정 수는 140만 개 이상으로 안정적으로 유지되어 사용자 참여도와 네트워크 활성화를 입증했습니다. 그중 20만 명 이상의 사용자가 사하라 데이터 서비스 플랫폼을 통해 데이터 라벨링, 학습 및 검증 작업에 참여하여 온체인 인센티브 보상을 받았습니다. 동시에, 여전히 수백만 명의 사용자가 화이트리스트에 등록되기를 기다리고 있으며, 이는 탈중앙화 AI 플랫폼에 대한 시장의 강력한 수요와 합의를 보여줍니다.

기업 협력 측면에서, 사하라(Sahara)는 마이크로소프트(Microsoft), 아마존(Amazon), 매사추세츠 공과대학교(MIT) 등 세계적인 유수 기관들과 협력하여 맞춤형 데이터 수집 및 주석 서비스를 제공하고 있습니다. 기업은 플랫폼을 통해 특정 작업을 제출할 수 있으며, 사하라의 글로벌 데이터 주석 네트워크는 이를 효율적으로 실행하여 대규모 크라우드소싱, 실행 효율성, 유연성, 그리고 다양한 수요에 대한 지원을 실현합니다.

사하라 AI 생태계 지도

참여 방법

SIWA는 4단계로 진행됩니다. 첫 번째 단계는 현재 온체인 데이터 소유권 기반을 마련하는 것으로, 기여자들이 자신의 데이터 세트를 등록하고 토큰화할 수 있도록 지원합니다. 현재 공개되어 있으며 화이트리스트가 필요하지 않습니다. 업로드된 데이터가 AI에 유용한지 확인하는 것이 필수적이며, 표절이나 부적절한 콘텐츠는 처리될 수 있습니다.

두 번째 단계에서는 데이터 세트와 모델의 온체인 수익화를 실현합니다. 세 번째 단계에서는 테스트 네트워크를 공개하고 프로토콜을 오픈소스로 공개합니다. 네 번째 단계에서는 AI 데이터 흐름 등록, 추적 가능성 추적 및 기여 증명 메커니즘을 시작합니다.

SIWA 테스트넷

SIWA 테스트넷 외에도, 일반 사용자들은 이제 사하라 레전드(Sahara Legends)에 참여하고 게임화된 과제를 통해 사하라 AI의 기능에 대해 알아볼 수 있습니다. 과제를 완료하면 가디언 조각을 받고, 최종적으로 NFT를 합성하여 네트워크에 대한 기여도를 기록하게 됩니다.

또는 데이터 서비스 플랫폼에서 데이터에 주석을 달고, 귀중한 데이터를 제공하고, 감사자 역할을 할 수 있습니다. Sahara는 생태계 파트너와 협력하여 과제를 공개하여 참여자들이 Sahara 포인트 외에도 생태계 파트너로부터 인센티브를 받을 수 있도록 할 계획입니다. 첫 번째 이중 보상 과제는 Myshell과 함께 진행되었으며, 과제를 완료한 사용자는 Sahara 포인트와 Myshell 토큰 보상을 받을 수 있었습니다.

로드맵에 따르면 사하라는 2025년 3분기에 메인넷을 출시할 예정이며, 그때 TGE도 진행될 가능성이 있습니다.

도전과 전망

Sahara AI는 AI를 더 이상 개발자나 대형 AI 기업에만 국한되지 않고, 더욱 개방적이고 포용적이며 민주적인 방향으로 발전시킵니다. 일반 사용자는 프로그래밍 지식 없이도 기여에 참여하고 혜택을 누릴 수 있습니다. Sahara AI는 누구나 참여할 수 있는 탈중앙화 AI 세계를 구축합니다. 기술 개발자에게는 웹 2.0 및 웹 3.0 개발 경로를 열어 탈중앙화 유연하고 강력한 개발 도구와 고품질 데이터 세트를 제공합니다. AI 인프라 제공업체에게는 모델, 데이터, 해시레이트 및 서비스의 탈중앙화 수익 창출을 위한 새로운 길을 제시합니다. Sahara AI는 퍼블릭 체인 인프라 구축뿐만 아니라 블록체인 기술을 활용하여 AI 저작권 시스템 개발을 촉진하는 핵심 애플리케이션 개발에도 힘쓰고 있습니다. 현재 Sahara AI는 여러 유수 AI 기관과 협력하여 초기 성공을 거두었습니다. 메인넷 출시 이후의 성공 여부, 생태계 제품의 개발 및 채택률, 그리고 TGE 이후 사용자들이 데이터 세트에 지속적으로 기여할 수 있도록 경제 모델이 뒷받침되는지 여부도 중요한 관전 포인트입니다.

Ritual: 혁신적인 디자인으로 이기종 작업 등 AI의 핵심 과제를 돌파합니다.

프로젝트 개요

Ritual은 현재 AI 산업의 중앙집중화, 폐쇄성, 신뢰 문제를 해결하고, AI에 투명한 검증 메커니즘, 공정한 컴퓨팅 리소스 할당, 유연한 모델 적응 기능을 제공하는 것을 목표로 합니다. 이를 통해 모든 프로토콜, 애플리케이션 또는 스마트 계약이 몇 줄의 코드 형태로 검증 가능한 AI 모델을 통합할 수 있습니다. 또한 개방형 아키텍처와 모듈 설계를 통해 온체인 에서 AI의 광범위한 적용을 촉진하고 개방적이고 안전하며 지속 가능한 AI 생태계를 구축합니다.

Ritual은 2023년 11월 Archetype의 주도로 Accomplice 및 유명 엔젤 투자자 등 여러 기관의 참여로 2,500만 달러 규모의 시리즈 A 융자 완료했습니다. 이는 시장 인지도와 팀의 뛰어난 소셜 역량을 입증합니다. 창립자 Niraj Pant와 Akilesh Potti는 모두 Polychain Capital의 전 파트너였으며, Offchain Labs 및 EigenLayer와 같은 업계 거물들의 투자를 주도하며 깊은 통찰력과 판단력을 보여주었습니다. Ritual 팀은 암호화, 분산 시스템, AI 및 기타 분야에서 풍부한 경험을 보유하고 있으며, 자문단에는 NEAR 및 EigenLayer와 같은 프로젝트의 창립자들이 포함되어 있어 강력한 배경과 잠재력을 보여줍니다.

디자인 건축

인페르넷에서 리추얼 체인까지

Ritual Chain은 Infernet 노드 네트워크에서 자연스럽게 전환된 2세대 제품으로, 탈중앙화 AI 컴퓨팅 네트워크에서 Ritual을 포괄적으로 업그레이드한 것입니다.

Infernet은 Ritual이 출시한 첫 단계 제품으로 2023년에 공식 출시될 예정입니다. 이는 이기종 컴퓨팅 작업을 위해 설계된 탈중앙화 오라클 네트워크로, 중앙 집중식 API의 한계를 해결하고 개발자가 투명하고 개방적인 탈중앙화 AI 서비스를 보다 자유롭고 안정적으로 호출할 수 있도록 하는 것을 목표로 합니다.

Infernet은 유연하고 간단한 경량 프레임 사용합니다. 사용 편의성과 효율성 덕분에 출시 후 8,000개 이상의 독립 노드가 빠르게 참여했습니다. 이 노드들은 GPU와 FPGA를 포함한 다양한 하드웨어 기능을 갖추고 있어 AI 추론 및 영지식 증명 생성과 같은 복잡한 작업에 강력한 컴퓨팅 성능을 제공할 수 있습니다. 그러나 시스템을 단순하게 유지하기 위해 Infernet은 합의를 통한 노드 조정이나 강력한 작업 라우팅 메커니즘 통합과 같은 몇 가지 주요 기능을 포기했습니다. 이러한 한계로 인해 Infernet은 더 다양한 웹 2.0 및 웹 3.0 개발자의 요구를 충족하는 데 어려움을 겪었고, Ritual은 더욱 포괄적이고 강력한 Ritual Chain을 출시하게 되었습니다.

Ritual Chain은 AI 애플리케이션을 위해 특별히 설계된 차세대 레이어 1 블록체인입니다. Infernet의 한계를 보완하고 개발자에게 더욱 강력하고 효율적인 개발 환경을 제공하는 것을 목표로 합니다. Resonance 기술을 통해 Ritual Chain은 Infernet 네트워크에 간단하고 안정적인 가격 책정 및 작업 라우팅 메커니즘을 제공하여 리소스 할당 효율성을 크게 최적화합니다. 또한, Ritual Chain은 EVM++ 프레임 기반으로 합니다. EVM++는 이더리움 가상 머신(EVM)의 하위 호환 확장으로, 사전 컴파일된 모듈 , 네이티브 스케줄링, 내장된 계정 추상화(AA), 그리고 일련의 고급 이더 개선 제안(EIP) 등 더욱 강력한 이더 을 제공합니다. 이러한 기능들은 강력하고 유연하며 효율적인 개발 환경을 구축하여 개발자에게 새로운 가능성을 제공합니다.

의식 체인 워크플로 다이어그램

미리 컴파일된 사이드카

기존의 사전 컴파일 방식과 비교했을 때, Ritual Chain의 설계는 시스템의 확장성과 유연성을 향상시켜 개발자가 기본 프로토콜을 수정하지 않고도 컨테이너화된 방식으로 사용자 정의 함수 모듈 생성할 수 있도록 합니다. 이 아키텍처는 개발 비용을 크게 절감할 뿐만 아니라 탈중앙화 애플리케이션에 더욱 강력한 컴퓨팅 성능을 제공합니다.

특히, Ritual Chain은 모듈 아키텍처를 통해 복잡한 계산을 실행 클라이언트에서 분리하고 독립적인 사이드카 형태로 구현합니다. 이러한 사전 컴파일된 모듈 AI 추론, 영지식 증명 생성, 신뢰 실행 환경(TEE) 작업 등 복잡한 컴퓨팅 작업을 효율적으로 처리할 수 있습니다.

네이티브 스케줄링

네이티브 스케줄링은 작업 타이밍 트리거 및 조건부 실행의 요구를 해결합니다. 기존 블록체인은 일반적으로 작업 실행을 트리거하기 위해 중앙화된 서드파티 서비스(예: 키퍼)에 의존하지만, 이러한 모델은 중앙화 리스크 과 높은 비용을 수반합니다. Ritual Chain은 내장된 스케줄러를 통해 중앙화된 서비스에 대한 의존성을 완전히 제거합니다. 개발자는 스마트 컨트랙트의 진입점과 콜백 빈도를 온체인 에서 직접 설정할 수 있습니다. 블록 생성자는 보류 중인 호출의 매핑 테이블을 유지하고 새 블록을 생성할 때 이러한 작업에 우선순위를 부여합니다. Resonance의 동적 리소스 할당 메커니즘과 결합된 Ritual Chain은 연산 집약적인 작업을 효율적이고 안정적으로 처리하여 탈중앙화 AI 애플리케이션에 안정적인 보안을 제공합니다.

기술 혁신

Ritual의 핵심 기술 혁신은 성능, 검증 및 확장성 측면에서 선도적인 위치를 보장하며, 온체인 AI 애플리케이션에 대한 강력한 지원을 제공합니다.

1. 공명: 자원 할당 최적화

Resonance는 블록체인 리소스 할당을 최적화하고 이질적인 거래의 복잡성을 해결하는 양자 간 시장 메커니즘입니다. 블록체인 거래가 단순한 이체에서 스마트 계약 및 AI 추론과 같은 다각화된 형태로 진화함에 따라, 기존 수수료 메커니즘(예: EIP-1559)으로는 사용자 요구와 노드 리소스를 효율적으로 일치시키기 어렵습니다. Resonance는 브로커와 경매인이라는 두 가지 핵심 역할을 도입하여 사용자 거래와 노드 기능 간의 최적의 조화를 달성합니다.

브로커는 사용자의 거래 수수료 지불 의사와 노드의 리소스 비용 함수를 분석하여 거래와 노드 간의 최적의 매칭을 달성하고 컴퓨팅 리소스 활용도를 개선하는 역할을 담당합니다.

Auctioneer는 공정성과 투명성을 보장하기 위해 양자 경매 메커니즘을 통해 거래 수수료를 분배합니다. 노드는 하드웨어 성능에 따라 거래 유형을 선택하고, 사용자는 우선순위 조건(예: 속도 또는 비용)에 따라 거래 요구 사항을 제출할 수 있습니다.

이 메커니즘은 탈중앙화 경매 프로세스를 통해 시스템의 투명성과 개방성을 더욱 강화하는 동시에 네트워크의 리소스 활용 효율성과 사용자 경험을 크게 개선합니다.

공명 메커니즘에 따라 경매인은 브로커의 분석을 기반으로 노드에 적절한 작업을 할당합니다.

2. Symphony: 검증 효율성 향상

심포니는 검증 효율성을 높이고 복잡한 컴퓨팅 작업 처리 및 검증에 있어 기존 블록체인의 "반복 실행" 모델의 비효율성을 해결하는 데 중점을 둡니다. 심포니는 "한 번 실행하고 여러 번 검증" (EOVMT) 모델을 기반으로 계산과 검증 프로세스를 분리함으로써 반복 계산으로 인한 성능 손실을 크게 줄입니다.

컴퓨팅 작업은 지정된 노드에 의해 한 번 수행되며, 계산 결과는 네트워크를 통해 브로드캐스트됩니다. 검증 노드는 계산을 반복하지 않고 비대화형 증명을 사용하여 결과의 정확성을 확인합니다.

심포니는 분산 검증을 지원하고, 복잡한 작업을 여러 개의 하위 작업으로 나누어 다양한 검증 노드에서 병렬로 처리함으로써 검증 효율성을 더욱 개선하고 개인 정보 보호 및 보안을 보장합니다.

심포니는 신뢰 실행 환경(TEE) 및 영지식 증명(ZKP)과 같은 증명 시스템과 높은 호환성을 제공하여 빠른 거래 확인 및 개인정보 보호 컴퓨팅 작업을 유연하게 지원합니다. 이 아키텍처는 반복 계산으로 인한 성능 오버헤드를 크게 줄일 뿐만 아니라 검증 프로세스의 탈중앙화 및 보안을 보장합니다.

심포니는 복잡한 작업을 여러 개의 하위 작업으로 나누어 다양한 검증 노드에서 병렬로 처리합니다.

3. vTune: 추적 가능한 모델 검증

vTune은 Ritual에서 제공하는 모델 검증 및 소스 추적 도구입니다. 모델 성능에 미치는 영향이 적고 간섭 방지 기능이 우수합니다. 특히 오픈 소스 모델의 지적 재산권을 보호하고 공정한 배포를 촉진하는 데 적합합니다. vTune은 워터마킹 기술과 영지식 증명을 결합하여 숨겨진 태그 내장함으로써 모델 소스 추적 및 계산 무결성 보장을 구현합니다.

워터마킹 기술: 가중치 공간 워터마크, 데이터 워터마크 또는 함수 공간 워터마크에 태그 삽입하면 모델이 공개된 경우에도 모델의 속성을 확인할 수 있습니다. 특히, 함수 공간 워터마크는 모델 가중치에 접근하지 않고도 모델 출력을 통해 속성을 확인할 수 있으므로, 더욱 강력한 개인정보 보호 및 견고성을 구현할 수 있습니다.

영지식 증명: 모델 미세 조정 과정에서 숨겨진 데이터를 도입하여 모델이 변조되었는지 확인하는 동시에 모델 생성자의 권리와 이익을 보호합니다.

이 도구는 탈중앙화 AI 모델 시장에 대한 신뢰할 수 있는 출처 검증을 제공할 뿐만 아니라, 모델의 보안성과 생태적 투명성을 크게 향상시킵니다.

생태적 발전

Ritual은 현재 비공개 테스트넷 단계에 있으며, 일반 사용자가 참여할 수 있는 기회는 거의 없습니다. 개발자는 공식 Altar 및 Realm 인센티브 프로그램에 지원하고 참여하고, Ritual의 AI 생태계 구축에 참여하고, 공식 사이트로부터 풀스택 기술 지원과 재정 지원을 받을 수 있습니다.

현재, 해당 관계자는 Altar 프로젝트의 네이티브 애플리케이션들을 발표했습니다.

Relic: Ritual의 인프라를 통해 유동성 풀 매개변수를 동적으로 조정하여 수수료와 기반 풀을 최적화하는 머신러닝(ML) 기반 자동 마켓메이커(AMM)(AMM)입니다.

Anima: LLM 온체인 거래 자동화 도구에 중점을 두고 사용자에게 원활하고 자연스러운 Web3 상호작용 경험을 제공합니다.

십일조: 대출 풀과 신용 점수를 동적으로 최적화하여 더 광범위한 자산 유형을 지원하는 AI 기반 대출 프로토콜입니다.

또한, Ritual은 탈중앙화 AI 생태계 발전을 촉진하기 위해 여러 성숙된 프로젝트와 심도 있는 협력을 진행해 왔습니다. 예를 들어, Arweave와의 협력을 통해 모델, 데이터 및 영지식 증명에 대한 탈중앙화 영구 저장소를 지원하고, StarkWare 및 Arbitrum과의 통합을 통해 이러한 생태계에 네이티브 온체인 AI 기능을 도입했습니다. 또한, EigenLayer가 제공하는 리스테이킹 (Restaking) 메커니즘은 Ritual의 증명 시장에 능동적인 검증 서비스를 추가하여 네트워크의 탈중앙화 및 보안을 더욱 강화합니다.

도전과 전망

Ritual의 설계는 배포, 인센티브, 검증과 같은 핵심 연결 고리에서 출발하여 탈중앙화 AI가 직면한 핵심 문제를 해결합니다. 동시에 vTune과 같은 도구를 통해 모델의 검증 가능성을 실현하고, 모델 오픈소스와 인센티브 간의 모순을 해소하며, 탈중앙화 모델 시장 구축을 위한 기술 지원을 제공합니다.

현재 Ritual은 초기 단계에 있으며, 주로 모델의 추론 단계에 중점을 두고 있습니다. 제품 포트폴리오는 인프라에서 모델 시장, L2aaS(L2 as a Service), 에이전트 프레임 확장되고 있습니다. 블록체인은 아직 비공개 테스트 단계에 있기 때문에 Ritual이 제안하는 고급 기술 설계는 대규모로 공개 구현되어야 하며 지속적인 관심이 필요합니다. 기술의 지속적인 발전과 생태계의 점진적인 강화를 통해 Ritual은 탈중앙화 AI 인프라의 중요한 부분으로 자리매김할 것으로 예상됩니다.

Gensyn: 탈중앙화 모델 학습의 핵심 문제 해결

프로젝트 개요

인공지능의 급속한 발전과 점점 부족해지는 해시레이트 리소스의 배경에서, Gensyn은 전체 AI 모델 훈련의 기본 패러다임을 재구성하려고 노력하고 있습니다.

기존 AI 모델 학습 프로세스에서는 해시레이트 소수의 클라우드 컴퓨팅 거대 기업에 거의 독점되어 있어 높은 학습 비용과 낮은 투명성으로 인해 중소 규모 팀과 독립 연구자들의 혁신을 저해합니다. Gensyn의 비전은 이러한 "중앙집중화된 독점" 구조를 깨는 것입니다. Gensyn은 전 세계 수많은 기기에 기본적인 컴퓨팅 기능을 갖춘 학습 작업을 "싱킹"하는 것을 지지합니다. MacBook, 게이밍 GPU, 엣지 기기 또는 유휴 서버 등 어떤 기기든 네트워크에 접속하여 작업 실행에 참여하고 수익을 얻을 수 있습니다.

젠신(Gensyn)은 2020년에 설립되었으며, 탈중앙화 AI 컴퓨팅 인프라 구축에 주력하고 있습니다. 2022년 초, 젠신 팀은 기술 및 제도적 차원에서 AI 모델 학습 방식을 재정의할 것을 제안했습니다. 더 이상 폐쇄형 클라우드 플랫폼이나 거대한 서버 클러스터에 의존하지 않고, 전 세계의 이기종 컴퓨팅 노드에 학습 작업을 분산시켜 신뢰할 수 있는 지능형 컴퓨팅 네트워크를 구축하는 것입니다.

2023년, 젠신은 전 세계적으로 연결되고, 오픈 소스이며, 자율적이고, 허가가 필요 없는 AI 네트워크를 구축한다는 비전을 더욱 확장했습니다. 기본적인 컴퓨팅 기능을 갖춘 모든 기기는 이 네트워크에 참여할 수 있습니다. 젠신의 기반 프로토콜은 블록체인 아키텍처 설계를 기반으로 하며, 인센티브 메커니즘과 검증 메커니즘을 결합할 수 있을 뿐만 아니라, 블록체인의 핵심 기능을 제공합니다.

Gensyn은 설립 이후 a16z, CoinFund, Canonical, Protocol Labs, Distributed Global 등 17개 기관으로부터 총 5,060만 달러의 투자를 받았습니다. 그중 a16z가 주도한 2023년 6월 시리즈 A 융자 큰 주목을 받았으며, 이는 탈중앙화 AI 분야가 Web3 벤처 캐피털의 주류 비전에 진입하기 시작했음을 보여줍니다.

팀의 핵심 멤버들 역시 인상적인 경력을 가지고 있습니다. 공동 창립자인 벤 필딩은 옥스퍼드 대학교에서 이론 컴퓨터 과학을 전공했고 탄탄한 기술 연구 배경을 가지고 있습니다. 또 다른 공동 창립자인 해리 그리브는 오랫동안 탈중앙화 프로토콜의 시스템 설계와 경제 모델링에 참여해 왔으며, Gensyn의 아키텍처 설계와 인센티브 메커니즘에 대한 든든한 지원을 제공했습니다.

디자인 건축

탈중앙화 형 인공지능 시스템 개발은 현재 실행, 검증, 통신이라는 세 가지 핵심적인 기술적 병목 현상에 직면해 있습니다. 이러한 병목 현상은 대규모 모델 학습 기능의 배포를 제한할 뿐만 아니라, 글로벌 해시레이트 리소스의 공정한 통합과 효율적인 사용을 저해합니다. Gensyn 팀은 체계적인 연구를 바탕으로 RL Swarm, Verde, SkipPipe라는 세 가지 대표적인 혁신 메커니즘을 제안하고, 각 문제에 대한 해결책을 구축하여 탈중앙화 AI 인프라를 개념부터 구현까지 발전시켰습니다.

1. 실행 과제: 분산된 장치가 협업하고 대규모 모델을 효율적으로 훈련할 수 있도록 하는 방법은 무엇인가?

현재 대규모 언어 모델의 성능 향상은 주로 "힙 스케일" 전략, 즉 더 큰 매개변수, 더 광범위한 데이터 세트, 그리고 더 긴 학습 주기에 의존합니다. 그러나 이는 컴퓨팅 비용을 크게 증가시킵니다. 초대형 모델의 학습은 종종 수천 개의 GPU 노드로 분할되어야 하며, 이러한 노드는 고주파 데이터 통신과 그래디언트 동기화를 필요로 합니다. 탈중앙화 환경에서는 노드가 광범위하게 분산되고, 하드웨어가 이기종이며, 상태 변동성이 높기 때문에 기존의 중앙 집중식 스케줄링 전략은 효과적이지 않습니다.

이러한 과제를 해결하기 위해 Gensyn은 P2P(피어 투 피어) 강화 학습 사후 학습 시스템인 RL Swarm을 제안했습니다. 핵심 아이디어는 학습 과정을 분산 협업 게임으로 전환하는 것입니다. 이 메커니즘은 "공유-비판-의사 결정"의 세 단계로 나뉩니다. 먼저, 노드가 독립적으로 문제 추론을 완료하고 결과를 공개적으로 공유합니다. 그런 다음 각 노드는 동료의 답변을 평가하고 논리와 전략적 합리성의 관점에서 피드백을 제공합니다. 마지막으로, 노드는 그룹 의견을 기반으로 자신의 출력을 수정하여 더욱 견고한 답변을 생성합니다. 이 메커니즘은 개별 컴퓨팅과 그룹 협업을 효과적으로 결합하며, 특히 높은 정밀도와 검증 가능성이 요구되는 수학 및 논리적 추론과 같은 작업에 적합합니다. 실험 결과 RL Swarm은 효율성을 향상시킬 뿐만 아니라 참여 기준을 크게 낮추고 확장성과 내결함성을 향상시킵니다.

RL Swarm의 "공유-비판-결정" 3단계 강화 학습 훈련 시스템

2. 검증 과제: 신뢰할 수 없는 공급업체의 계산 결과가 정확한지 어떻게 검증할 수 있을까?

탈중앙화 교육 네트워크에서 "누구나 해시레이트 제공할 수 있다"는 것은 장점이자 리스크 입니다. 문제는 이러한 계산이 실제적이고 유효한지 신뢰 없이 어떻게 검증할 수 있느냐는 것입니다.

재계산이나 화이트리스트 검토와 같은 기존 방식에는 분명한 한계가 있습니다. 전자는 비용이 매우 많이 들고 확장성이 낮으며, 후자는 "롱테일" 노드를 배제하고 네트워크의 개방성을 저해합니다. 이러한 이유로 Gensyn은 신경망 학습 및 검증 시나리오를 위해 특별히 설계된 경량 중재 프로토콜인 Verde를 설계했습니다.

Verde의 핵심 아이디어는 "최소 신뢰 중재"입니다. 검증자가 공급업체의 학습 결과가 잘못되었다고 의심하는 경우, 중재 계약은 전체 학습 과정을 반복할 필요 없이 계산 그래프에서 첫 번째 논란의 여지가 있는 연산 노드만 다시 계산하면 됩니다. 이를 통해 검증 부담을 크게 줄이는 동시에 적어도 한 당사자가 정직할 경우 결과의 정확성을 보장합니다. 서로 다른 하드웨어 간의 부동 소수점 비결정성 문제를 해결하기 위해 Verde는 행렬 곱셈과 같은 일반적인 수학 연산에 대해 통일된 실행 순서를 적용하는 재현 가능한 연산자 라이브러리를 개발하여 여러 장치에서 비트 수준의 일관된 출력을 구현했습니다. 이 기술은 분산 학습의 보안 및 엔지니어링 타당성을 크게 향상시키며, 현재 신뢰가 필요 없는 검증 시스템의 중요한 혁신입니다.

전체 메커니즘은 훈련자가 주요 중간 상태(즉, 체크포인트)를 기록하는 방식을 기반으로 하며, 여러 검증자가 무작위로 배정되어 이러한 훈련 단계를 재현하여 출력의 일관성을 확인합니다. 검증자의 재계산 결과가 훈련자의 결과와 다를 경우, 시스템은 전체 모델을 대략적으로 재실행하지 않고 네트워크 중재 메커니즘을 사용하여 계산 그래프에서 두 연산이 처음 불일치했던 연산을 정확하게 찾아낸 후, 해당 연산만 재생하고 비교하여 매우 낮은 오버헤드로 분쟁을 해결합니다. 이러한 방식으로 Verde는 효율성과 확장성을 고려하면서 훈련 노드를 신뢰할 필요 없이 훈련 과정의 무결성을 보장합니다. Verde는 분산형 AI 훈련 환경에 최적화된 검증 프레임 입니다.

베이더의 작업 흐름

3. 통신 과제: 노드 간 고주파 동기화로 인해 발생하는 네트워크 병목 현상을 어떻게 줄일 수 있을까?

기존의 분산 학습에서는 모델이 완전히 복제되거나 계층별로 분할되는데(파이프라인 병렬 처리), 두 가지 모두 노드 간에 높은 빈도의 동기화를 요구합니다. 특히 파이프라인 병렬 처리에서는 마이크로 배치가 모델의 각 계층을 엄격한 순서대로 통과해야 하므로, 노드가 지연되는 한 전체 학습 과정이 중단됩니다.

이 문제를 해결하기 위해 Gensyn은 스킵 실행과 동적 경로 스케줄링을 지원하는 뛰어난 내결함성 파이프라인 학습 시스템인 SkipPipe를 제안했습니다. SkipPipe는 특정 노드의 부하가 너무 높을 때 일부 마이크로 배치가 일부 모델 계층을 건너뛸 수 있도록 하는 "스킵 비율" 메커니즘을 도입하고, 스케줄링 알고리즘을 사용하여 현재 최적의 컴퓨팅 경로를 동적으로 선택합니다. 실험 결과, 지리적으로 분산도가 높고 하드웨어 차이가 크며 대역폭이 제한된 네트워크 환경에서 SkipPipe 학습 시간을 최대 55%까지 단축할 수 있었으며, 노드 장애율이 최대 50%에 달하더라도 손실률은 7%로 유지되어 매우 강력한 복원력과 적응성을 보여주었습니다.

참여 방법

Gensyn의 공개 테스트넷은 2025년 3월 31일에 출시되었으며, 아직 기술 로드맵(0단계)의 초기 단계에 있습니다. RL Swarm의 기능적 측면은 RL Swarm의 배포 및 검증에 중점을 두고 있습니다. RL Swarm은 Gensyn의 첫 번째 애플리케이션 시나리오로, 강화 학습 모델의 협력적 학습을 중심으로 설계되었습니다. 각 참여 노드는 자신의 행동을 온체인 ID에 연결하며, 기여 프로세스는 완전히 기록되어 후속 인센티브 할당 및 신뢰 컴퓨팅 모델의 검증 기반을 제공합니다.

젠신의 노드 순위

초기 테스트 단계의 하드웨어 임계값은 비교적 친화적입니다. Mac 사용자는 M 시리즈 칩으로 실행할 수 있으며 Windows 사용자는 로컬 Swarm 노드를 배포하기 위해 3090 또는 4090과 같은 고성능 GPU와 16GB 이상의 메모리를 갖추는 것이 좋습니다.

시스템이 실행된 후 웹 페이지를 통해 이메일(Gmail 권장)에 로그인하여 확인 과정을 완료하고, 보다 완전한 모델 기능을 활성화하기 위해 HuggingFace의 액세스 토큰을 바인딩할지 여부를 선택합니다.

도전과 전망

현재 Gensyn 프로젝트의 가장 큰 불확실성은 테스트 네트워크가 약속된 전체 기술 스택을 아직 충족하지 못하고 있다는 점입니다. Verde와 SkipPipe와 같은 핵심 모듈 아직 통합 과정에 있으며, 이로 인해 외부에서는 아키텍처 구현 가능성을 관망하고 있습니다. 공식 설명에 따르면 테스트 네트워크는 단계적으로 추진될 예정이며, 각 단계에서 새로운 프로토콜 기능을 활성화하고 인프라의 안정성과 확장성 검증을 우선시할 것입니다. 첫 번째 단계는 RL Swarm으로 시작하여, 향후 사전 학습 및 추론과 같은 핵심 시나리오로 점진적으로 확장한 후, 최종적으로 실제 경제 거래를 지원하는 메인 네트워크 구축으로 전환할 예정입니다.

테스트넷은 비교적 보수적인 속도로 출시되었지만, 불과 한 달 후 Gensyn이 대규모 모델과 복잡한 수학 작업을 지원하는 새로운 Swarm 테스트 작업을 시작했다는 점은 주목할 만합니다. 이러한 움직임은 개발 속도에 대한 외부의 의구심을 어느 정도 해소하는 동시에, 로컬 모듈 개발에 있어 팀의 실행 효율성을 입증했습니다.

하지만 문제점도 발생합니다. 새로운 버전의 작업은 하드웨어에 대한 기준이 매우 높다는 것입니다. 권장 구성에는 A100 및 H100(80GB 비디오 메모리)과 같은 고성능 GPU가 포함되어 있는데, 이는 중소 규모 노드에서는 거의 달성할 수 없는 수준이며, Gensyn이 강조한 "오픈 액세스 및 탈중앙화 학습"이라는 본래 의도와도 상충됩니다. 중앙 집중화된 해시레이트 추세가 효과적으로 관리되지 않을 경우, 네트워크의 공정성과 탈중앙화 거버넌스의 지속 가능성에 영향을 미칠 수 있습니다.

다음으로, Verde와 SkipPipe가 원활하게 통합된다면 프로토콜의 무결성과 조정 효율성을 향상시키는 데 도움이 될 것입니다. 그러나 Gensyn이 성