딥러닝 기업 데시(Deci)가 다양한 프로그래밍 언어로 코드를 생성할 수 있는 새로운 생성 AI 기반 모델 '데시코더(DeciCoder)'를 공개했다. 회사에 따르면 이 모델에는 10억 개의 매개변수와 2048개의 토큰으로 구성된 대규모 컨텍스트 창이 있어 고품질의 다양한 코드 조각을 생성할 수 있습니다.

Deci의 CEO이자 공동 창립자인 Yonatan Geifman은 Metaverse Post에 모델 추론 비용이 코드 생성과 같은 생성 AI 애플리케이션의 주요 문제라고 말했습니다. 높은 비용은 주로 이러한 모델의 크기, 계산 요구 사항 및 기본 LLM(대형 언어 모델)의 메모리 강도로 인해 발생합니다. 결과적으로 빠른 생성에는 값비싼 고급 하드웨어가 필요합니다.

Geifman은 Metaverse Post에 “이러한 엄청난 비용에 대응하고 추론 비용을 4배까지 줄이는 솔루션은 보다 효율적인 모델을 개발하는 것입니다.”라고 말했습니다. “이러한 모델은 정확성을 희생하지 않고도 보다 저렴한 하드웨어에 대한 신속한 추론이 가능해야 합니다. 이것이 바로 DeciCoder가 하는 일이며 이 점에서 눈에 띕니다.”

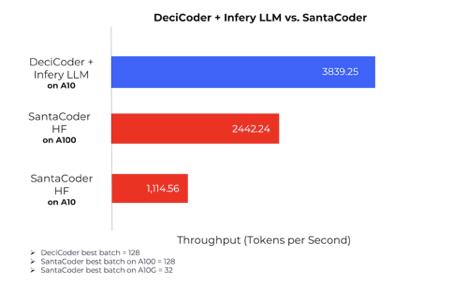

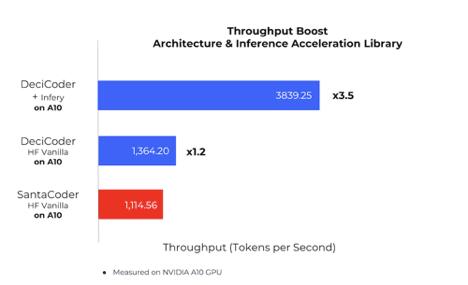

회사는 저렴한 하드웨어인 NVIDIA의 A10G에서 실행할 때 DeciCoder의 추론 속도가 더 비싼 NVIDIA의 A100에서 실행되는 10억 매개변수 범위에서 가장 인기 있는 모델인 SantaCoder의 추론 속도를 능가한다고 말했습니다. 또한 A10의 DeciCoder는 A10의 SantaCoder보다 3.5배 빠르고 A100의 SantaCoder보다 1.6배 빠릅니다.

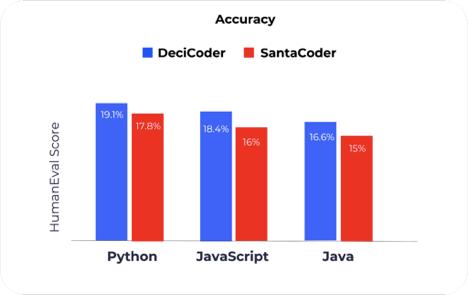

Geifman은 DeciCoder가 뛰어난 정확성도 제공한다고 주장합니다. 이 모델은 Python, JavaScript, Java라는 세 가지 프로그래밍 언어 모두에서 정확도 면에서 SantaCoder보다 뛰어납니다.

그는 생성 모델이 Deci의 Infery 도구와 함께 사용될 때 상당히 낮은 추론 비용을 제공한다고 말했습니다. HuggingFace 추론 엔드포인트에서 SantaCoder의 성능과 비교하여 1,000개 토큰당 비용이 71.4% 감소했습니다.

"DeciCoder는 기업이 속도나 정확성을 희생하지 않고 코드 생성 워크로드를 더 저렴한 하드웨어로 마이그레이션하거나 더 짧은 GPU 시간에 더 많은 코드를 생성할 수 있도록 하여 추론 중 계산 비용을 줄입니다."

Geifman이 공유했습니다.

또한 DeciCoder는 A10G GPU의 Infery(Deci 추론 가속 라이브러리)와 함께 탄소 배출량을 최소화하는 데 도움이 되는 것으로 알려졌습니다. 회사는 동일한 하드웨어의 SantaCoder에 비해 모델 인스턴스당 연간 탄소 배출량을 324kg CO2 감소시킨다고 주장합니다.

인상적인 벤치마크를 통한 코드 생성 향상

Geifman은 DeciCoder의 처리량 향상과 메모리 사용량 감소에 기여하는 두 가지 주요 기술적 차이점, 즉 DeciCoder의 모델 혁신 아키텍처와 Deci의 추론 가속 라이브러리 활용에 대해 설명했습니다.

“Deci의 아키텍처는 컴퓨터 비전과 NLP 모두에서 여러 고효율 기반 모델을 생성한 독점적인 신경 아키텍처 검색 기술인 AutoNAC에 의해 생성되었습니다.”라고 그는 말했습니다. “모델 아키텍처의 본질적인 설계는 DeciCoder에 뛰어난 처리량과 정확성을 부여합니다. SantaCoder 및 OpenAI의 GPT 모델과 같은 DeciCoder는 변환기 아키텍처를 기반으로 하지만 GQA(Grouped Query Attention)의 고유한 구현에서는 다릅니다.”

GPT-3, SantaCoder 및 Starcoder는 효율성 향상을 위해 Multi-Head Attention보다 Multi-Query Attention을 사용하여 더 빠른 추론을 수행합니다. 그러나 이러한 효율성은 Multi-Head Attention에 비해 품질과 정확성이 저하되는 대가로 발생합니다.

Deci의 GQA는 Multi-Query Attention보다 정확성과 효율성 사이에서 탁월한 균형을 유지합니다. 유사한 효율성 수준을 유지하면서 크게 향상된 정확도를 제공합니다.

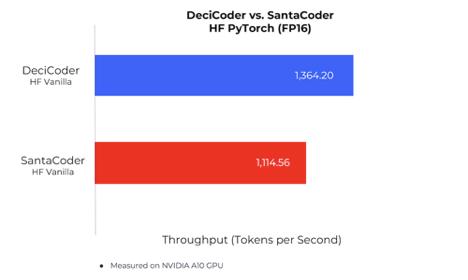

HuggingFace Inference Endpoints에 배포된 DeciCoder와 SantaCoder를 비교하면 차이점이 더욱 분명해집니다. DeciCoder는 두 번째 차트와 다음 차트에 표시된 것처럼 22% 더 높은 처리량을 달성하고 향상된 정확도를 보여줍니다.

Deci는 자사의 LLM 추론 가속화 라이브러리인 Infery가 추론을 가속화하기 위해 회사의 연구 및 엔지니어링 팀에서 개발한 고급 독점 엔지니어링 기술을 사용한다고 말했습니다.

회사는 이를 통해 처리량이 추가로 증가하고 Deci가 아닌 모든 LLM에 적용될 수 있다고 주장합니다. 또한 Infery는 비교적 사용하기 쉬워 개발자가 단 몇 줄의 코드만으로 복잡하고 고도로 발전된 기술을 사용할 수 있다고 밝혔습니다.

정확성과 속도의 최적 균형을 위해 AutoNAC 활용

Geifman에 따르면, "최적의" 신경망 아키텍처에 대한 탐구는 역사적으로 노동 집약적인 수동 탐색이었습니다. 이러한 수동 접근 방식은 결과를 가져오는 경우가 많지만 시간이 많이 걸리고 가장 효율적인 신경망을 정확히 찾아내지 못하는 경우가 많습니다.

“AI 커뮤니티는 신경망 아키텍처 검색(NAS)이 뛰어난 신경망 개발을 자동화하는 잠재적인 판도를 바꿀 수 있는 가능성을 인식했습니다. 그러나 기존 NAS 방식의 컴퓨팅 요구로 인해 막대한 리소스를 보유한 소수의 조직만 접근할 수 있었습니다.”

Geifman은 Metaverse Post에 말했습니다.

Deci는 자사의 "AutoNAC" 기능이 NAS 생성 알고리즘을 생성하는 컴퓨팅 효율적인 방법을 제공하여 잠재력과 타당성 사이의 격차를 해소함으로써 NAS 프로세스를 용이하게 할 수 있다고 주장합니다.

AutoNAC는 특정 데이터 세트 특성, 모델 작업, 성능 목표 및 추론 환경을 입력으로 받아 지정된 요구 사항에 대해 정확도와 추론 속도 간의 최상의 균형을 제공하는 최적의 신경망을 출력하는 알고리즘이라고 회사는 설명했습니다.

Yolo-NAS 와 같은 객체 감지 모델 외에도 AutoNAC는 이미 NLP 작업( DeciBert ) 및 컴퓨터 비전 작업( NAS SegFormer )을 위한 변환기 기반 모델을 생성했습니다.

회사는 DeciCoder의 출시가 앞으로 몇 주 안에 출시될 예정인 Deci의 Generative AI 제품을 설명하는 매우 기대되는 일련의 릴리스 중 첫 번째라고 발표했습니다.

DeciCoder와 사전 훈련된 가중치는 이제 허용되는 Apache 2.0 라이선스에 따라 제공되어 개발자에게 광범위한 사용 권한을 부여하고 실제 상용 애플리케이션에 대한 모델을 포지셔닝합니다.

더 읽어보세요:

- 70억 개의 매개변수를 갖춘 LLaMa, Apple M2 Max 칩에서 빛처럼 빠른 추론 달성

- GPT-4의 유출된 세부 정보는 대규모 규모와 인상적인 아키텍처를 밝힙니다.

- ChatGPT는 모든 AI 벤치마크에서 중국 챗봇 Ernie를 이겼습니다.

Deci가 Generative AI로 코드 개발을 용이하게 하는 DeciCoder를 공개한 게시물이 Metaverse Post 에 처음 게재되었습니다.