Tác giả: Teng Yan, Chuỗi tư tưởng Dịch: Jinse Finance xiaozou;

Một trong những điều hối tiếc lớn nhất vẫn khiến tôi bận tâm là đây chắc chắn là cơ hội đầu tư rõ ràng nhất đối với bất kỳ ai nhìn vào nó, nhưng tôi lại không bỏ một xu nào vào đó. Không, tôi không nói về kẻ giết người Solana tiếp theo hay một đồng xu meme chó đội chiếc mũ ngộ nghĩnh.

Nhưng... NVIDIA.

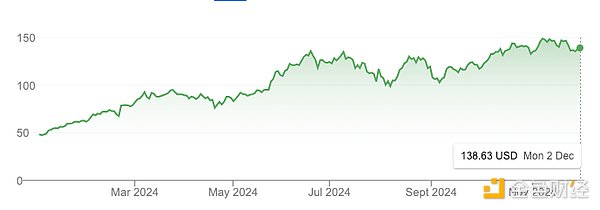

Chỉ trong một năm, giá trị vốn hóa thị trường của NVDA đã tăng vọt từ 1 nghìn tỷ USD lên 3 nghìn tỷ USD, tăng trưởng 3 lần, thậm chí vượt cả Bitcoin trong cùng thời kỳ.

Tất nhiên, sự cường điệu về trí tuệ nhân tạo là không thể thiếu, nhưng phần lớn nó có cơ sở thực tế. NVIDIA đã công bố thu nhập năm tài chính 2024 là 60 tỷ USD, tăng trưởng 126% so với năm tài chính 2023, một hiệu suất đáng kinh ngạc.

Vậy tại sao tôi lại bỏ lỡ nó?

Trong hai năm, tôi tập trung vào lĩnh vực crypto và không nhìn ra thế giới bên ngoài hay chú ý đến lĩnh vực trí tuệ nhân tạo. Tôi đã phạm phải một sai lầm lớn mà đến giờ vẫn ám ảnh tôi.

Nhưng tôi sẽ không phạm sai lầm tương tự nữa.

Ngày nay, Crypto AI có cảm giác rất giống nhau. Chúng ta đang trên đà bùng nổ của sự đổi mới. Điều này quá giống với Cơn sốt vàng California vào giữa thế kỷ 19 để có thể bỏ qua - các ngành công nghiệp và thành phố mọc lên chỉ sau một đêm, cơ sở hạ tầng phát triển với tốc độ chóng mặt và sự giàu có được tạo ra bởi những người dám nghĩ và hành động.

Giống như NVIDIA trong những ngày đầu thành lập, Crypto AI rõ ràng là một cơ hội khi nhìn lại.

Trong phần đầu tiên của bài viết này, tôi sẽ giải thích lý do tại sao Crypto AI lại là cơ hội hấp dẫn nhất dành cho các nhà đầu tư và nhà xây dựng hiện nay.

Tổng quan ngắn gọn như sau:

Nhiều người vẫn cho rằng đó là chuyện viễn tưởng.

AI tiền điện tử vẫn đang ở giai đoạn đầu và có thể còn 1-2 năm nữa mới đạt đến đỉnh cao.

Có ít nhất hơn 230 tỷ USD cơ hội tăng trưởng trong lĩnh vực này.

Về bản chất, Crypto AI là AI dựa trên cơ sở hạ tầng crypto. Điều này có nghĩa là nó có nhiều khả năng đi theo quỹ đạo tăng trưởng theo cấp số nhân của trí tuệ nhân tạo hơn là thị trường crypto rộng lớn hơn. Vì vậy, để không bị bỏ lại phía sau, điều cần thiết là phải theo dõi nghiên cứu AI mới nhất về Arxiv và nói chuyện với những người sáng lập tin rằng họ đang tạo ra những sản phẩm và dịch vụ tuyệt vời tiếp theo.

Trong phần thứ hai của bài viết này, tôi sẽ đi sâu vào bốn lĩnh vực con hứa hẹn nhất của Crypto AI:

Điện toán phi tập trung: Đào tạo, suy luận và thị trường GPU

mạng dữ liệu

AI có thể xác minh

Đại lý AI chạy trên Chuỗi

Bài viết này là đỉnh cao của nhiều tuần nghiên cứu chuyên sâu và trò chuyện với những người sáng lập và đội ngũ trong không gian Crypto AI. Bài viết này không đi sâu vào mọi lĩnh vực mà thay vào đó, bạn có thể coi nó như một lộ trình cấp cao được thiết kế để kích thích trí tò mò, nâng cao trình độ nghiên cứu và định hướng tư duy đầu tư của bạn.

1. Bối cảnh AI về tiền điện tử

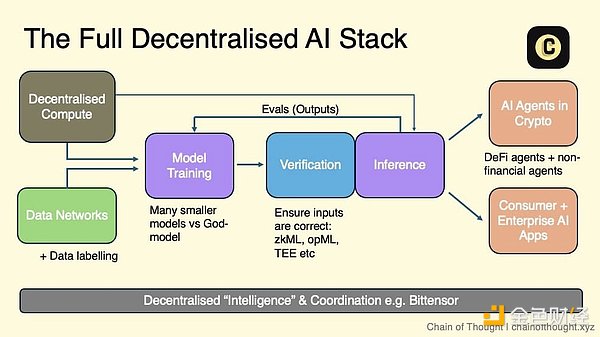

Tôi hình dung hệ thống AI phi tập trung như một hệ sinh thái có nhiều lớp: Một đầu của nó bắt đầu phi tập trung các mạng dữ liệu mở và điện toán phi tập trung cung cấp hỗ trợ cho việc đào tạo mô hình AI phi tập trung .

Sau đó, sự kết hợp giữa mật mã, khích lệ crypto và mạng đánh giá được sử dụng để xác minh từng suy đoán—cả đầu vào và đầu ra. Những kết quả đầu ra đã được xác minh này sẽ chuyển đến các tác nhân trí tuệ nhân tạo có thể chạy tự động trên Chuỗi cũng như các ứng dụng AI dành cho người tiêu dùng và doanh nghiệp mà người dùng có thể thực sự tin tưởng.

Mạng điều phối liên kết mọi thứ lại với nhau, cho phép liên lạc và cộng tác liền mạch trên toàn bộ hệ sinh thái.

Trong viễn cảnh mong đợi này, bất kỳ ai xây dựng trí tuệ nhân tạo đều có thể tận dụng một hoặc nhiều lớp của hệ thống, tùy thuộc vào nhu cầu cụ thể của họ. Cho dù tận dụng điện toán phi tập trung để đào tạo mô hình hay sử dụng mạng đánh giá để đảm bảo đầu ra chất lượng cao, ngăn xếp đều cung cấp sê-ri tùy chọn.

Do khả năng kết hợp vốn có của blockchain , tôi tin rằng chúng ta sẽ tự nhiên hướng tới một tương lai mô-đun . Mỗi lớp đang trở nên chuyên môn hóa cao, với các giao thức được tối ưu hóa cho các chức năng khác nhau thay vì sử dụng phương pháp tích hợp tất cả trong một.

Có lượng lớn các công ty khởi nghiệp ở mọi tầng của hệ thống AI phi tập trung , hầu hết trong đó được thành lập trong 1-3 năm qua. Rõ ràng là lĩnh vực này vẫn còn ở giai đoạn đầu.

Bản đồ khởi động Crypto AI toàn diện và cập nhật nhất mà tôi từng thấy được Casey và đội ngũ của cô ấy duy trì tại topology.vc. Đây là nguồn tài nguyên vô giá cho bất kỳ ai theo dõi lĩnh vực này.

Khi tìm hiểu sâu hơn về lĩnh vực phụ Crypto AI, tôi luôn tự hỏi: Cơ hội là trong đó? Tôi không quan tâm đến những điều nhỏ nhặt – tôi đang tìm kiếm những thị trường có quy mô hàng trăm tỷ đô la.

(1) Quy mô thị trường

Trước tiên hãy nhìn vào quy mô thị trường. Khi đánh giá một thị trường ngách, tôi tự hỏi: Nó đang tạo ra một thị trường hoàn toàn mới hay phá vỡ thị trường hiện có?

Phi tập trung làm ví dụ. Đây là một hạng mục Sự lật đổ mà tiềm năng của nó có thể được đánh giá bằng cách nhìn vào thị trường điện toán đám mây hiện tại, hiện có giá trị vốn hóa thị trường khoảng 680 tỷ USD và dự kiến sẽ đạt 2,5 nghìn tỷ USD vào năm 2032.

Các thị trường mới chưa từng có, chẳng hạn như các tác nhân trí tuệ nhân tạo, khó định lượng hơn. Nếu không có dữ liệu lịch sử , đánh giá của họ đòi hỏi phải phỏng đoán và đánh giá vấn đề họ đang giải quyết. Điều quan trọng cần lưu ý là đôi khi, những gì trông giống như một thị trường mới thực ra chỉ là nỗ lực tìm ra giải pháp cho một vấn đề.

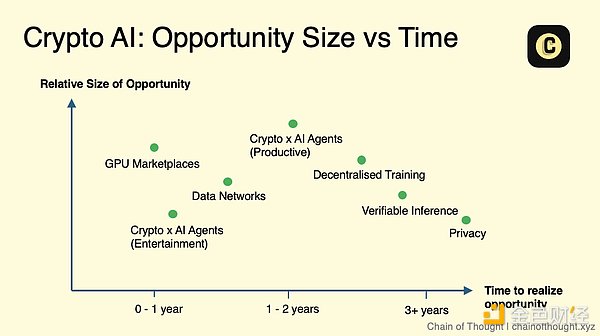

(2) Thời gian

Thời gian là tất cả. Công nghệ có xu hướng cải tiến và trở nên rẻ hơn theo thời gian nhưng ở mức độ khác nhau.

Công nghệ ở một phân khúc cụ thể đã trưởng thành đến mức nào? Nó đã sẵn sàng để được áp dụng đại trà hay vẫn đang trong giai đoạn nghiên cứu và còn có những ứng dụng thực tế trong vài năm nữa? Thời điểm quyết định liệu một ngành có đáng được quan tâm ngay lập tức hay “chờ xem”.

Lấy crypto đồng cấu hoàn toàn (FHE): tiềm năng của nó là không thể phủ nhận, nhưng hiện tại sự phát triển của nó vẫn còn quá chậm để có thể được sử dụng rộng rãi. Có thể phải mất vài năm nữa chúng ta mới thấy được sự áp dụng rộng rãi. Bằng cách tập trung vào những lĩnh vực gần với quy mô hơn trước, tôi có thể dành thời gian và sức lực của mình cho những lĩnh vực đang tạo đà và cơ hội.

Nếu tôi ánh xạ các danh mục này lên biểu đồ tỷ lệ theo thời gian, nó sẽ trông giống như thế này. Hãy nhớ rằng, đây là bản đồ khái niệm, không phải là hướng dẫn cứng nhắc. Có nhiều sắc thái - ví dụ: trong suy luận có thể kiểm chứng, phương pháp khác nhau (chẳng hạn như zkML và opML) có mức độ sẵn sàng sử dụng khác nhau.

Điều đó nói lên rằng, tôi tin rằng AI sẽ lớn đến mức ngay cả một lĩnh vực có vẻ “thích hợp” ngày nay cũng có thể phát triển thành một thị trường quan trọng.

Cũng cần lưu ý rằng tiến bộ công nghệ không phải lúc nào cũng tiến triển theo đường thẳng mà thường diễn ra đột ngột. Khi nó đột ngột bùng phát, quan điểm của tôi về thời điểm và quy mô thị trường sẽ thay đổi.

Với khung này đã có, chúng ta hãy xem xét chi tiết từng trường con.

2. Lĩnh vực 1: Điện toán phi tập trung

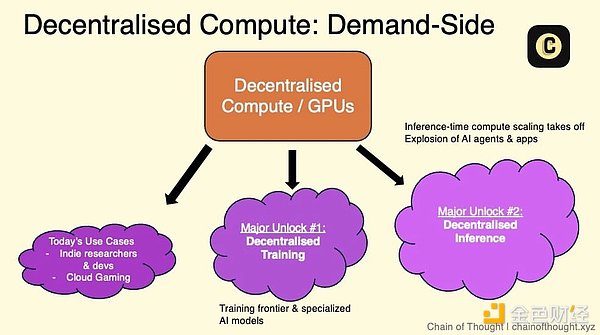

Điện toán phi tập trung là xương sống của trí tuệ nhân tạo phi tập trung.

Thị trường GPU, đào tạo phi tập trung và suy luận phi tập trung được liên kết chặt chẽ với nhau.

Phía cung cấp thường đến từ các trung tâm dữ liệu vừa và nhỏ và GPU tiêu dùng.

Phía cầu tuy nhỏ nhưng vẫn tăng trưởng. Ngày nay, nó đến từ những người dùng nhạy cảm về giá, không nhạy cảm với độ trễ và các công ty khởi nghiệp AI nhỏ hơn.

Thách thức lớn nhất đối với thị trường GPU Web3 hiện nay là làm cho chúng hoạt động bình thường.

Việc phối hợp các GPU trên mạng phi tập trung đòi hỏi các kỹ năng kỹ thuật tiên tiến và kiến trúc mạng đáng tin cậy, được thiết kế tốt.

2.1 Thị trường GPU/Mạng máy tính

Một số đội ngũ Crypto AI đang xây dựng các mạng phi tập trung để tận dụng tỷ lệ băm tiềm năng trên toàn thế giới nhằm đáp ứng tình trạng thiếu GPU không thể đáp ứng nhu cầu.

Đề xuất giá trị cốt lõi của thị trường GPU có ba khía cạnh:

Bạn có thể truy cập điện toán với mức giá "thấp hơn 90%" so với AWS vì không có người trung gian và phía cung cấp luôn mở. Về cơ bản, những thị trường này cho phép bạn tận dụng chi phí điện toán cận biên thấp nhất trên thế giới.

Tính linh hoạt cao hơn: không có hợp đồng bị khóa, không có quy trình KYC, không có thời gian chờ đợi.

chống kiểm duyệt

Để giải quyết vấn đề phía cung thị trường, tỷ lệ băm của các thị trường này đến từ:

GPU cấp doanh nghiệp (chẳng hạn như A100, H100) dành cho các trung tâm dữ liệu vừa và nhỏ khó tìm được nhu cầu hoặc thợ đào Bitcoin đang tìm kiếm sự đa dạng hóa. Tôi cũng biết đội ngũ làm việc trong các dự án cơ sở hạ tầng lớn do chính phủ tài trợ, nơi các trung tâm dữ liệu đã được xây dựng như một phần của kế hoạch tăng trưởng công nghệ. Các nhà cung cấp GPU này thường được khích lệ duy trì GPUT của họ trên mạng, điều này giúp họ bù đắp chi phí khấu hao của GPU.

GPU cấp tiêu dùng dành cho hàng triệu game thủ và người dùng gia đình kết nối máy tính của họ với mạng để đổi lấy phần thưởng mã thông báo.

Mặt khác, nhu cầu về điện toán phi tập trung ngày nay xuất phát từ:

Người dùng nhạy cảm với giá và không nhạy cảm với độ trễ. Phân khúc này ưu tiên giá hơn tốc độ. Hãy nghĩ đến việc các nhà nghiên cứu khám phá các lĩnh vực mới, các nhà phát triển AI độc lập và những người dùng quan tâm đến chi phí khác, những người không yêu cầu xử lý theo thời gian thực. Do hạn chế về ngân sách, nhiều người trong số họ có thể không hài lòng với các máy chủ siêu quy mô truyền thống như AWS hoặc Azure. Bởi vì họ phân bố rộng rãi trong dân chúng nên việc tiếp thị có mục tiêu là rất quan trọng để thu hút nhóm này.

Các công ty khởi nghiệp AI nhỏ phải đối mặt với thách thức trong việc có được tài nguyên điện toán linh hoạt, mở rộng mà không cần ký kết hợp đồng dài hạn với các nhà cung cấp đám mây lớn. Phát triển việc kinh doanh là rất quan trọng để thu hút phân khúc này khi họ tích cực tìm kiếm các giải pháp thay thế cho việc khóa chặt quy mô lớn.

Các công ty khởi nghiệp về tiền điện tử AI xây dựng các sản phẩm trí tuệ nhân tạo phi tập trung nhưng không có nguồn cung cấp tỷ lệ băm riêng sẽ cần khai thác tài nguyên của trong đó các mạng.

Chơi game trên đám mây: Mặc dù không được điều khiển trực tiếp bởi AI nhưng chơi game trên đám mây ngày càng đòi hỏi tài nguyên GPU.

Điều quan trọng cần nhớ là: các nhà phát triển luôn ưu tiên chi phí và độ tin cậy .

Thách thức thực sự là cầu chứ không phải cung.

Các công ty khởi nghiệp trong lĩnh vực này thường coi quy mô mạng lưới cung cấp GPU của họ là một dấu hiệu thành công. Nhưng điều này là sai lầm - trong trường hợp tốt nhất, nó chỉ là thước đo của sự phù phiếm.

Hạn chế thực sự không phải là cung mà là cầu. Số chỉ báo quan trọng cần theo dõi không phải là số lượng GPU có sẵn mà là mức sử dụng và số lượng GPU thực sự được thuê.

Token thực hiện công việc xuất sắc trong việc cung cấp khởi động, tạo ra khích lệ cần thiết để mở rộng quy mô một cách nhanh chóng. Tuy nhiên, về cơ bản chúng không giải quyết được vấn đề nhu cầu. Thử nghiệm thực sự là đưa sản phẩm vào trạng thái đủ tốt để nhận ra nhu cầu tiềm ẩn.

Haseeb Qureshi (Dragonfly) đã nói rất hay về điểm này:

Làm cho mạng máy tính thực sự hoạt động

Trái với suy nghĩ của nhiều người, rào cản lớn nhất hiện nay đối với thị trường GPU phân tán web3 là khiến chúng hoạt động bình thường.

Đây không phải là một câu hỏi tầm thường.

Việc phối hợp GPU trong mạng phân tán rất phức tạp và có nhiều thách thức - phân bổ tài nguyên, mở rộng công việc động, cân bằng tải giữa nút và GPU, quản lý độ trễ, truyền dữ liệu, khả năng chịu lỗi và xử lý các phần cứng phân tán về mặt địa lý khác nhau. Tôi có thể tiếp tục.

Để đạt được điều này đòi hỏi phải có kỹ thuật chu đáo và kiến trúc mạng được thiết kế tốt, đáng tin cậy.

Để hiểu rõ hơn, hãy nghĩ đến Kubernetes của Google. Nó được cho rằng tiêu chuẩn vàng cho việc điều phối vùng chứa, tự động hóa các quy trình như cân bằng tải và mở rộng trong hoàn cảnh phân tán, rất giống với những thách thức mà mạng GPU phân tán phải đối mặt. Bản thân Kubernetes được xây dựng dựa trên hơn một thập kỷ kinh nghiệm của Google và thậm chí sau đó phải mất nhiều năm lặp đi lặp lại không ngừng để hoạt động tốt.

Một số thị trường điện toán GPU hiện đang ra mắt có thể xử lý khối lượng công việc quy mô nhỏ, nhưng một khi họ cố gắng mở mở rộng thì các vấn đề sẽ phát sinh. Tôi nghi ngờ điều này là do nền tảng kiến trúc của họ được thiết kế kém.

Một thách thức/cơ hội khác của mạng điện toán phi tập trung là đảm bảo độ tin cậy: xác minh rằng mỗi nút thực sự cung cấp sức mạnh tính toán được yêu cầu. Hiện tại, điều này phụ thuộc vào danh tiếng của mạng và trong một số trường hợp, các nhà cung cấp tỷ lệ băm được xếp hạng dựa trên điểm danh tiếng. Blockchain có vẻ rất phù hợp cho một hệ thống xác minh không cần sự tin cậy. Các công ty khởi nghiệp như Gensyn và Spheron đang tìm cách giải quyết vấn đề này bằng cách sử dụng phương pháp không tin cậy.

Ngày nay, nhiều đội ngũ web3 vẫn đang phải vật lộn với những thách thức này, điều đó có nghĩa là cánh cửa cơ hội đang rộng mở.

Quy mô thị trường điện toán phi tập trung

Thị trường mạng máy tính phi tập trung lớn đến mức nào?

Ngày nay, nó có lẽ chỉ là một phần nhỏ trong ngành công nghiệp điện toán đám mây trị giá 680 tỷ USD đến 2,5 nghìn tỷ USD. Tuy nhiên, bất chấp những trở ngại gia tăng đối với người dùng, sẽ luôn có nhu cầu miễn là chi phí thấp hơn so với các nhà cung cấp truyền thống.

Tôi tin rằng chi phí sẽ vẫn ở mức thấp trong ngắn và trung hạn do trợ cấp mã token và mở khóa nguồn cung cho những người dùng không nhạy cảm về giá (ví dụ: nếu tôi có thể cho thuê máy tính xách tay chơi game của mình để kiếm thêm tiền, với giá 20 đô la Mỹ một tháng hoặc 50 đô la, tôi sẽ hạnh phúc).

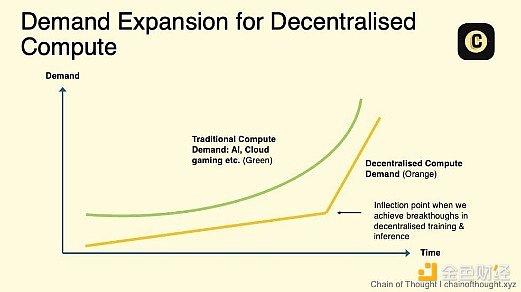

Nhưng tiềm năng tăng trưởng thực sự của các mạng máy tính phi phi tập trung —và mở rộng thực sự của TAM—sẽ xuất hiện khi:

Đào tạo phi tập trung các mô hình trí tuệ nhân tạo trở nên thiết thực.

Nhu cầu suy luận đang bùng nổ và các trung tâm dữ liệu hiện tại không thể theo kịp nhu cầu. Điều này đã bắt đầu xảy ra. Jensen Huang cho rằng nhu cầu suy luận sẽ tăng trưởng“hàng tỷ lần”.

Các thỏa thuận cấp độ dịch vụ (SLA) phù hợp sẽ có sẵn, giải quyết rào cản chính đối với việc áp dụng doanh nghiệp . Hiện tại, hoạt động của điện toán phi tập trung cho phép người dùng trải nghiệm các mức chất lượng dịch vụ khác nhau (chẳng hạn như chiếm tỷ lệ thời gian hoạt động). Với SLA, các mạng này có thể cung cấp chỉ báo hiệu suất và độ tin cậy được tiêu chuẩn hóa, làm cho điện toán phi tập trung trở thành một giải pháp thay thế khả thi cho các nhà cung cấp điện toán đám mây truyền thống.

Điện toán không cần cấp phép phi tập trung là lớp nền tảng của hệ sinh thái AI phi tập trung- cơ sở hạ tầng.

Mặc dù Chuỗi cung ứng GPU ngày càng mở rộng nhưng tôi tin rằng chúng ta vẫn đang ở buổi bình minh của kỷ nguyên trí tuệ nhân loại. Nhu cầu về điện toán sẽ là vô tận.

Điều quan trọng cần lưu ý là điểm uốn có thể kích hoạt việc đánh giá lại tất cả các thị trường GPU đang hoạt động có thể sẽ sớm xuất hiện.

Các ghi chú khác:

Thị trường GPU thuần túy đang rất đông đúc, với sự cạnh tranh khốc liệt giữa các nền tảng phi tập trung và sự nổi lên của các dịch vụ đám mây web2 AI mới nổi như Vast.ai và Lambda.

Nút nhỏ (như 4 x H100) không có nhu cầu lớn do khả năng sử dụng hạn chế, nhưng chúc may mắn tìm được người bán cụm lớn hơn - vẫn có một số nhu cầu đối với chúng.

Liệu một người chơi vị trí chủ đạo sẽ tổng hợp tất cả các nguồn cung cấp tỷ lệ băm cho các giao thức phi tập trung hay nó sẽ vẫn bị tỷ lệ băm trên nhiều thị trường? Tôi thích cách thứ nhất hơn vì việc hợp nhất thường dẫn đến hiệu quả cơ sở hạ tầng được cải thiện. Nhưng sẽ mất thời gian, và trong lúc đó, sự chia rẽ và nhầm lẫn vẫn tiếp tục.

Các nhà phát triển muốn tập trung vào phát triển ứng dụng hơn là xử lý việc triển khai và cấu hình. Thị trường phải loại bỏ những sự phức tạp này và làm cho việc truy cập tính toán trở nên dễ dàng nhất có thể.

2.2 Đào tạo phi tập trung

Nếu quy luật mở rộng là đúng thì việc đào tạo thế hệ mô hình AI tiên tiến tiếp theo trong một trung tâm dữ liệu duy nhất một ngày nào đó sẽ trở nên bất khả thi.

Việc đào tạo các mô hình AI yêu cầu truyền lượng lớn dữ liệu giữa các GPU. Tốc độ truyền dữ liệu(kết nối) thấp hơn giữa các GPU phân tán thường là trở ngại lớn nhất.

Các nhà nghiên cứu đang khám phá nhiều phương pháp cùng lúc và đang tạo ra những bước đột phá (ví dụ: Open DiLoCo, DisTrO). Những tiến bộ này sẽ tích lũy và đẩy nhanh tiến độ trong lĩnh vực này.

Tương lai của đào tạo phi tập trung có thể nằm ở việc thiết kế các mô hình nhỏ, chuyên biệt cho các ứng dụng thích hợp, thay vì các mô hình tiên tiến, lấy AGI làm trung tâm.

Với việc chuyển sang các mô hình như OpenAI o1, nhu cầu suy luận sẽ tăng cao, tạo cơ hội cho các mạng suy luận phi tập trung.

Hãy tưởng tượng thế này: một mô hình trí tuệ nhân tạo khổng lồ, có thể thay đổi thế giới, được phát triển không phải trong các phòng thí nghiệm bí mật ưu tú mà được định hình bởi hàng triệu người bình thường. Các game thủ, những người có GPU thường tạo ra các vụ nổ giống như rạp hát trong Call of Duty, hiện đang cho mượn phần cứng của họ cho một thứ gì đó lớn lao hơn nhiều — một mô hình trí tuệ nhân tạo mã nguồn mở, thuộc sở hữu chung mà không có người gác cổng trung tâm.

Trong tương lai như vậy, các mô hình quy mô nền tảng không chỉ giới hạn ở các phòng thí nghiệm AI hàng đầu.

Nhưng hãy đặt viễn cảnh mong đợi này vào thực tế ngày nay. Hiện tại, hầu hết hoạt động đào tạo trí tuệ nhân tạo hạng nặng vẫn tập trung ở các trung tâm dữ liệu tập trung và điều này có thể trở thành tiêu chuẩn trong một thời gian.

Các công ty như OpenAI đang mở rộng các cụm lớn của họ. Elon Musk mới đây thông báo rằng xAI sắp xây dựng một trung tâm dữ liệu tương đương 200.000 GPU H100.

Nhưng vấn đề không chỉ là số lượng GPU thô. Mô hình sử dụng FLOPS (MFU) là chỉ báo được Google đề xuất trong bài viết nghiên cứu PaLM năm 2022 nhằm theo dõi mức độ hiệu quả của việc sử dụng công suất tối đa của GPU. Điều đáng ngạc nhiên là MFU thường dao động trong khoảng 35-40%.

Tại sao nó lại thấp như vậy? Theo Định luật Moore, hiệu suất GPU đột ngột tăng vọt trong vài năm trở lại đây, nhưng những cải tiến về mạng, bộ nhớ và lưu trữ lại tụt hậu đáng kể, tạo thành nút thắt cổ chai. Vì vậy, GPU thường ở trạng thái tiết lưu, chờ dữ liệu.

Việc đào tạo AI ngày nay vẫn được chú trọng cao độ vì một từ – hiệu quả .

Việc huấn luyện các mô hình lớn phụ thuộc vào các kỹ thuật sau:

Song song dữ liệu: Thực hiện các thao tác song song trên dữ liệu được phân tách trên nhiều GPU, đẩy nhanh quá trình đào tạo.

Song song mô hình: phân phối các phần của mô hình trên nhiều GPU, bỏ qua các hạn chế về bộ nhớ.

Phương pháp này yêu cầu GPU phải liên tục trao đổi dữ liệuvà tốc độ kết nối — tốc độ truyền dữ liệu giữa các máy tính trong mạng — trở nên quan trọng.

Khi chi phí đào tạo các mô hình trí tuệ nhân tạo tiên tiến vượt quá 1 tỷ USD, mọi cải tiến hiệu quả đều có ý nghĩa quan trọng.

Với các kết nối tốc độ cao, các trung tâm dữ liệu tập trung có thể nhanh chóng truyền dữ liệu giữa các GPU và tiết kiệm lượng lớn chi phí trong thời gian đào tạo mà các thiết lập phi tập trung không thể sánh được.

Khắc phục tốc độ kết nối chậm

Nếu bạn nói chuyện với những người làm việc trong lĩnh vực trí tuệ nhân tạo, nhiều người sẽ nói với bạn rằng đào tạo phi tập trung đơn giản là không hiệu quả.

Trong thiết lập phi tập trung, các cụm GPU không cùng tồn tại về mặt vật lý, do đó việc truyền dữ liệu giữa chúng chậm hơn nhiều và trở thành nút cổ chai. Quá trình đào tạo yêu cầu GPU phải đồng bộ hóa và trao đổi dữ liệu ở mọi bước. Chúng càng cách xa nhau thì độ trễ càng cao. Độ trễ cao hơn có nghĩa là đào tạo chậm hơn và chi phí cao hơn.

Trong một trung tâm dữ liệu tập trung có thể mất vài ngày, trong phi tập trung trung tâm dữ liệu phi tập trung có thể kéo dài đến hai tuần và chi phí cao hơn. Điều này đơn giản là không khả thi.

Nhưng điều đó sắp thay đổi.

Tin tốt là mối quan tâm nghiên cứu về đào tạo phân tán đang tăng lên. Các nhà nghiên cứu đang khám phá nhiều phương pháp cùng một lúc, bằng chứng là lượng lớn các nghiên cứu và bài báo đã xuất bản. Những tiến bộ này sẽ chồng lên nhau và hợp nhất để đẩy nhanh tiến độ trong lĩnh vực này.

Đó cũng là thử nghiệm hoàn cảnh để xem chúng tôi có thể vượt qua các ranh giới đến mức nào.

Một số kỹ thuật đào tạo phi tập trung đã có thể xử lý các mô hình nhỏ hơn trong hoàn cảnh kết nối chậm. Giờ đây, nghiên cứu tiên tiến đang thúc đẩy việc áp dụng phương pháp này cho các mô hình lớn.

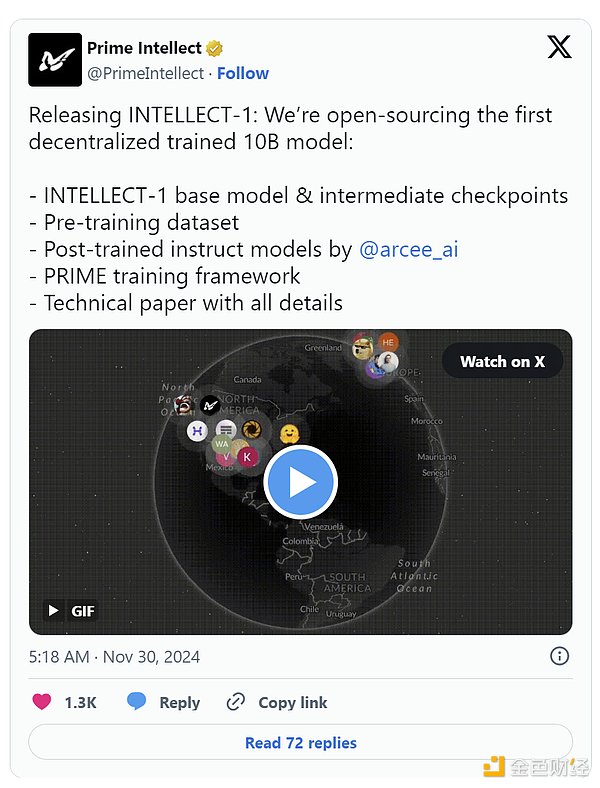

Ví dụ: bài viết DiCoLo mã nguồn mở của Prime Intellect cho thấy một phương pháp thực tế liên quan đến các "đảo" GPU phương pháp hiện 500 bước cục bộ trước khi đồng bộ hóa, giảm yêu cầu băng thông xuống hệ số 500. Những gì bắt đầu khi nghiên cứu của Google DeepMind về các mô hình nhỏ đã mở rộng sang đào tạo mô hình tham số 10 tỷ vào tháng 11 và hiện là mã nguồn mở hoàn toàn.

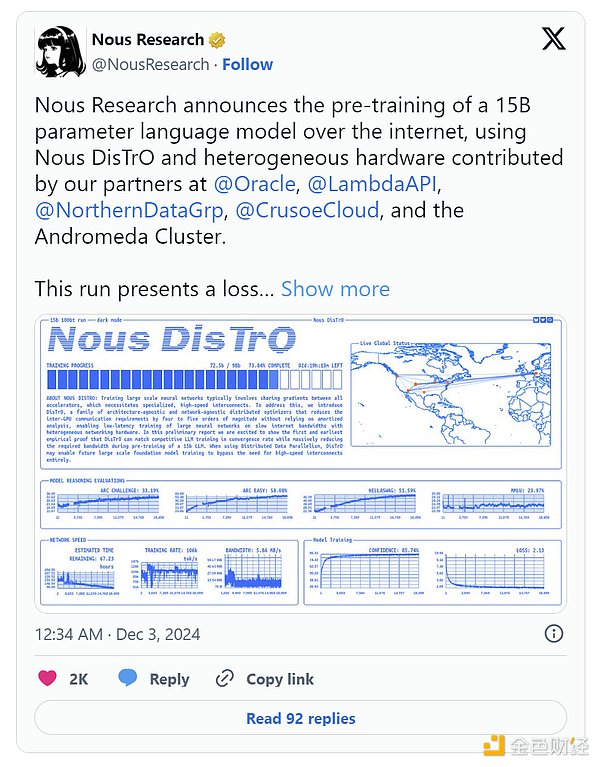

Nous Research đang nâng cao tiêu chuẩn với khung DisTrO của họ, sử dụng trình tối ưu hóa để giảm yêu cầu giao tiếp giữa các GPU xuống mức đáng kinh ngạc 10.000 lần trong khi đào tạo mô hình tham số 1,2B.

Và động lực tiếp tục được xây dựng. Vào tháng 12, Nous đã công bố đào tạo trước mô hình tham số 15B với các đường cong tổn thất (cách lỗi mô hình giảm theo thời gian) và tốc độ hội tụ (tốc độ ổn định hiệu suất mô hình) thậm chí còn phù hợp với kết quả điển hình của đào tạo tập trung. Có, tốt hơn là tập trung hóa.

SWARM Parallelism và DTFMHE là phương pháp khác nhau để đào tạo các mô hình AI lớn trên các loại thiết bị khác nhau, ngay cả những thiết bị có tốc độ và mức độ kết nối khác nhau.

Quản lý nhiều loại phần cứng GPU là một thách thức khác, bao gồm cả GPU tiêu dùng bị hạn chế về bộ nhớ điển hình của các mạng phi tập trung. Các kỹ thuật như song song mô hình (phân chia các lớp mô hình trên các thiết bị) có thể giúp đạt được điều này.

Tương lai của đào tạo phi tập trung

Kích thước mô hình của phương pháp đào tạo phi tập trung hiện tại vẫn thấp hơn nhiều so với các mô hình tiên tiến (GPT-4 được báo cáo có gần một nghìn tỷ tham số, lớn hơn 100 lần so với mô hình 10B của Prime Intellect). Để đạt được quy mô thực sự, chúng ta cần những đột phá về kiến trúc mô hình, cơ sở hạ tầng mạng tốt hơn và phân bổ nhiệm vụ thông minh hơn trên các thiết bị.

Chúng ta có thể mơ lớn. Hãy tưởng tượng một thế giới nơi đào tạo phi tập trung tổng hợp nhiều sức mạnh tính toán GPU hơn cả những trung tâm dữ liệu tập trung lớn nhất có thể tập hợp được.

Nghiên cứu Pluralis (một đội ngũ ưu tú tập trung vào đào tạo phi tập trung đáng được chú ý) cho rằng điều này không chỉ có thể xảy ra mà còn là điều không thể tránh khỏi. Trong khi các trung tâm dữ liệu tập trung bị giới hạn bởi các hạn chế về mặt vật lý như không gian và nguồn điện sẵn có, thì các mạng phi tập trung có thể khai thác nguồn tài nguyên toàn cầu thực sự không giới hạn.

Ngay cả Jensen Huang của NVIDIA cũng thừa nhận rằng đào tạo phi tập trung không đồng bộ có thể mở ra tiềm năng thực sự của mở rộng AI. Mạng đào tạo phân tán cũng có khả năng chịu lỗi tốt hơn.

Do đó, trong một thế giới tương lai có thể xảy ra, các mô hình AI mạnh nhất thế giới sẽ được đào tạo theo phương thức phi tập trung .

Đó là một viễn cảnh thú vị nhưng tôi vẫn chưa hoàn toàn bị thuyết phục. Chúng ta cần bằng chứng mạnh mẽ hơn rằng việc đào tạo phi tập trung cho các mô hình lớn nhất là khả thi về mặt kỹ thuật và kinh tế.

Tôi thấy điều này có nhiều hứa hẹn: Điều tốt nhất về đào tạo phi tập trung có thể nằm ở các mô hình mã nguồn mở nhỏ, chuyên biệt được thiết kế cho các trường hợp sử dụng mục tiêu , thay vì cạnh tranh với các mô hình tiên tiến do AGI điều khiển rất lớn. Một số kiến trúc nhất định, đặc biệt là các mô hình không biến áp, đã được chứng minh là rất phù hợp phi tập trung.

Có một mảnh ghép khác cho câu đố: token. Khi việc đào tạo phi tập trung trở nên khả thi trên quy mô lớn, token có thể đóng một vai trò quan trọng trong khích lệ và khen thưởng những người đóng góp, khởi động các mạng này một cách hiệu quả.

Con đường hiện thực hóa viễn cảnh mong đợi này vẫn còn dài nhưng có nhiều tiến bộ đáng khích lệ. Khi các mô hình trong tương lai sẽ mở rộng vượt quá khả năng của một trung tâm dữ liệu duy nhất, những tiến bộ trong đào tạo phi tập trung sẽ mang lại lợi ích cho tất cả mọi người, ngay cả các công ty công nghệ lớn và các phòng thí nghiệm nghiên cứu AI hàng đầu.

Tương lai được phân phối. Khi một công nghệ có tiềm năng rộng lớn như vậy, lịch sử cho thấy nó luôn hoạt động tốt hơn và nhanh hơn bất kỳ ai mong đợi.

2.3 Lý luận phi tập trung

Hiện tại, phần lớn sức mạnh tính toán trong AI đều tập trung vào việc đào tạo các mô hình quy mô lớn. Đang có sự cạnh tranh giữa các phòng thí nghiệm trí tuệ nhân tạo hàng đầu để xem ai có thể phát triển các mô hình cơ bản tốt nhất và cuối cùng đạt được AGI.

Nhưng đây là quan điểm của tôi: Trong vài năm tới, tính toán tập trung vào đào tạo này sẽ chuyển sang suy luận. Khi AI ngày càng được tích hợp vào các ứng dụng chúng ta sử dụng hàng ngày—từ chăm sóc sức khỏe đến giải trí—lượng tài nguyên máy tính cần thiết để hỗ trợ suy luận sẽ rất đáng kinh ngạc.

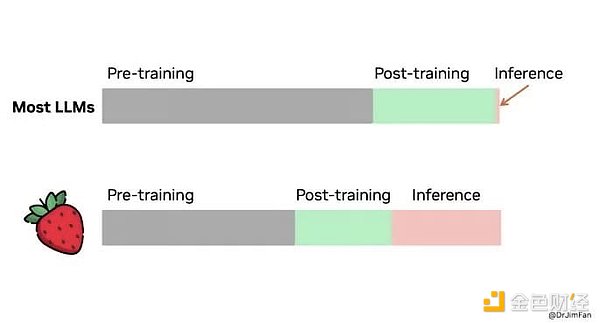

Đây không chỉ là suy đoán. Mở rộng tính toán theo thời gian suy luận là từ thông dụng mới nhất trong lĩnh vực trí tuệ nhân tạo. OpenAI gần đây đã phát hành phiên bản xem trước/mini của mẫu 01 mới nhất (tên mã: Strawberry), đây có phải là một sự thay đổi lớn? Cần có thời gian để suy nghĩ, trước tiên hãy tự hỏi bản thân xem bạn nên thực hiện những bước nào để trả lời câu hỏi này, sau đó tiến hành từng bước một.

Mô hình này được thiết kế cho nhiệm vụ phức tạp hơn đòi hỏi phải lập kế hoạch lượng lớn , chẳng hạn như trò chơi ô chữ và các vấn đề đòi hỏi suy luận sâu hơn. Bạn sẽ nhận thấy rằng nó chậm hơn, mất nhiều thời gian hơn để tạo ra phản hồi, nhưng kết quả lại sâu sắc và nhiều sắc thái hơn. Nó cũng đắt hơn nhiều khi chạy (đắt hơn 25 lần so với GPT-4).

Sự thay đổi trọng tâm rất rõ ràng: Bước nhảy vọt tiếp theo về hiệu suất AI sẽ không chỉ đến từ việc đào tạo các mô hình lớn hơn mà còn đến từ mở rộng các ứng dụng tính toán trong quá trình suy luận.

Nếu bạn muốn biết thêm, một số bài báo nghiên cứu cho thấy:

Mở rộng tính toán suy luận thông qua việc lấy mẫu lặp lại có thể mang lại những cải tiến lớn cho nhiều nhiệm vụ khác nhau.

Ngoài ra còn có một định luật hàm mũ mở rộng cho lý luận.

Sau khi đào tạo các mô hình mạnh mẽ, nhiệm vụ suy luận của chúng—những gì mô hình làm—có thể được chuyển phi tập trung. Điều này có ý nghĩa bởi vì:

Suy luận đòi hỏi ít nguồn lực hơn nhiều so với đào tạo. Sau khi đào tạo, mô hình có thể được nén và tối ưu hóa bằng các kỹ thuật như lượng tử hóa, cắt tỉa hoặc chưng cất. Chúng thậm chí có thể được chia nhỏ để chạy trên các thiết bị tiêu dùng hàng ngày. Bạn không cần GPU cao cấp để hỗ trợ suy luận.

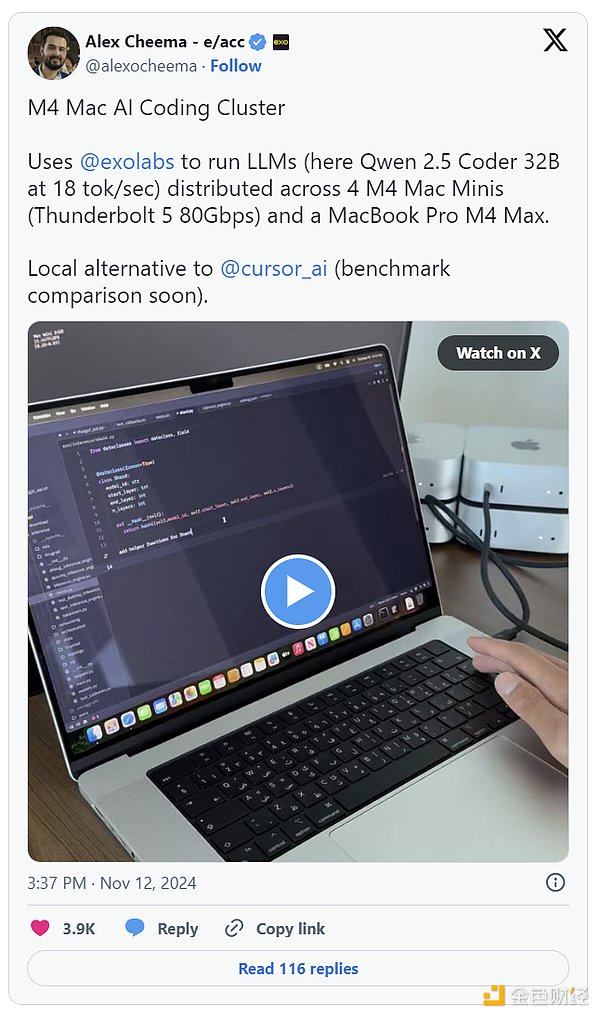

Điều này đã xảy ra rồi. Exo Labs đã tìm ra phương pháp chạy các mẫu Llama3 tham số 450B trên phần cứng cấp độ người tiêu dùng như MacBook và Mac Minis. Phân phối suy luận trên nhiều thiết bị để xử lý khối lượng công việc quy mô lớn một cách hiệu quả và tiết kiệm chi phí.

Trải nghiệm người dùng tốt hơn. Việc chạy tính toán gần hơn với người dùng giúp giảm độ trễ, điều này rất quan trọng đối với các ứng dụng thời gian thực như chơi game, AR hoặc ô tô tự lái. Mỗi mili giây đều có giá trị.

Hãy coi suy luận phi tập trung như một CDN (mạng phân phối nội dung) cho AI: thay vì kết nối với máy chủ gần đó để phục vụ trang web một cách nhanh chóng, suy luận phi tập trung tận dụng sức mạnh tính toán cục bộ để đưa ra phản hồi AI trong thời gian kỷ lục. Bằng cách sử dụng suy luận phi tập trung, các ứng dụng AI trở nên hiệu quả, phản hồi nhanh và đáng tin cậy hơn.

Xu hướng là rõ ràng. Chip M4 Pro mới của Apple cạnh tranh với RTX 3070 Ti của Nvidia, sản phẩm cho đến gần đây vẫn là lĩnh vực của những game thủ khó tính. Phần cứng của chúng tôi ngày càng có khả năng xử lý khối lượng công việc AI nâng cao.

Giá trị gia tăng của tiền điện tử

Phi tập trung thành công, phải có khích lệ kinh tế hấp dẫn. Nút trong mạng cần được bù đắp cho sự đóng góp tỷ lệ băm của chúng. Hệ thống phải đảm bảo rằng phần thưởng được phân phối công bằng và hiệu quả. Sự đa dạng về địa lý là cần thiết để giảm độ trễ trong nhiệm vụ suy luận và cải thiện khả năng chịu lỗi.

Cách tốt nhất để xây dựng một mạng lưới phi tập trung là gì? Tiền điện tử.

Token cung cấp một cơ chế mạnh mẽ để điều phối lợi ích của người tham gia, đảm bảo mọi người đều hướng tới cùng một mục tiêu: mở rộng mạng lưới và tăng giá trị token.

Token cũng đẩy nhanh tăng trưởng của mạng. Chúng giúp giải quyết vấn đề con gà và quả trứng kinh điển đã cản trở sự phát triển của hầu hết các mạng bằng cách khen thưởng những người chấp nhận sớm và thúc đẩy sự tương tác ngay từ ngày đầu tiên.

Sự thành công của Bitcoin và Ethereum chứng minh điều này - chúng đã tích lũy được nguồn tỷ lệ băm lớn nhất hành tinh.

Mạng suy luận phi tập trung sẽ là mạng tiếp theo. Do tính đa dạng về mặt địa lý, chúng làm giảm độ trễ, tăng khả năng chịu lỗi và đưa AI đến gần hơn với người dùng. Khích lệ bằng crypto , chúng sẽ mở rộng nhanh hơn và tốt hơn các mạng truyền thống.

(Còn tiếp, mời các bạn theo dõi)