Người mẫu lớn cuối cùng đã học được cách đếm r, nhưng đã thất bại thảm hại khi thay đổi một chữ cái ?

Và đó là GPT-5 mới nhất.

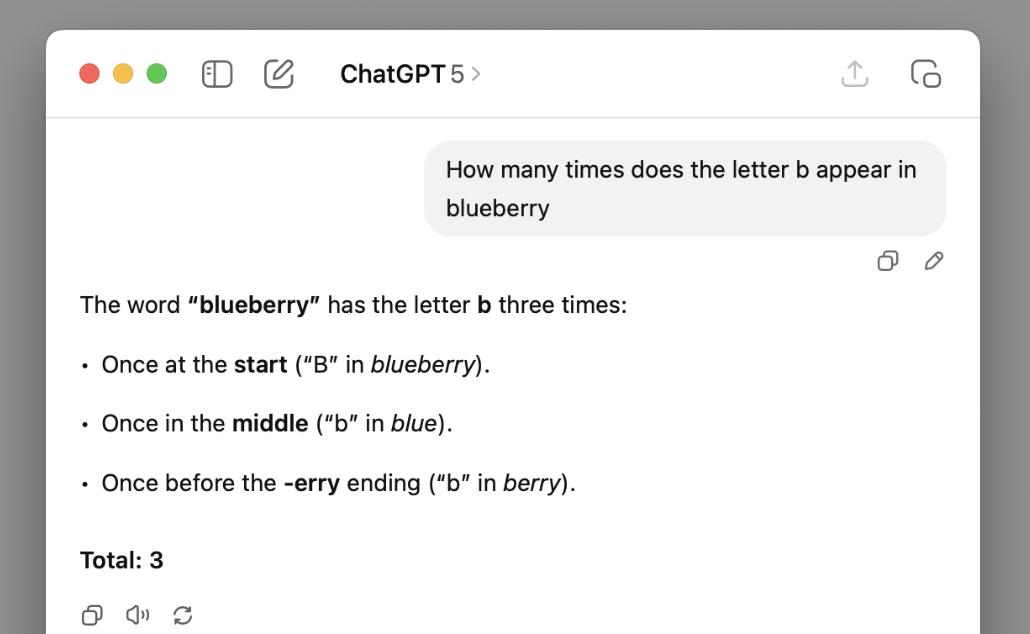

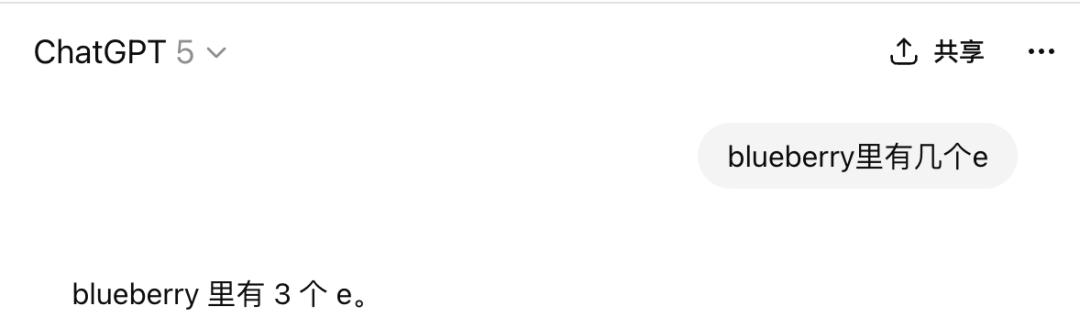

Giáo sư Kieran Healy của Đại học Duke cho biết ông đã yêu cầu GPT-5 đếm xem có bao nhiêu bs trong quả việt quất và GPT-5 đã trả lời chắc chắn là 3 .

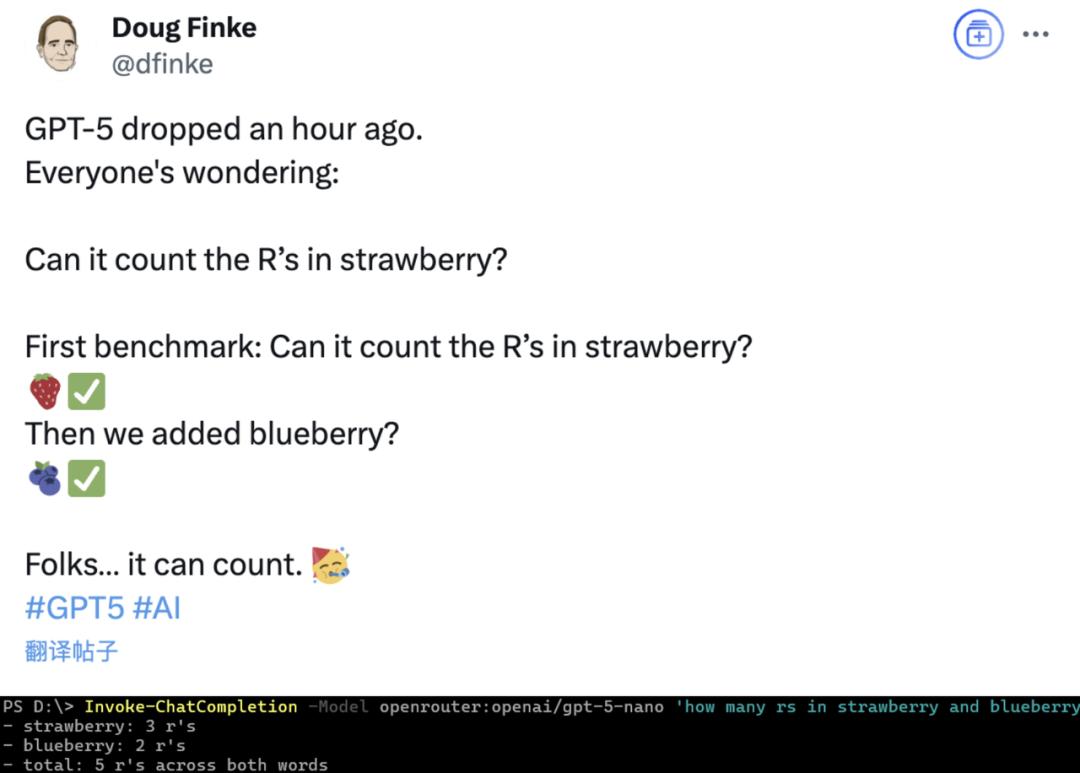

Điều buồn cười là khi GPT-5 lần đầu tiên được phát hành, một số cư dân mạng đã yêu cầu nó đếm chữ r trong chữ blueberry và nó đã làm đúng.

Mặc dù blogger đã nghĩ đến việc thay thế dâu tây, nhưng anh không ngờ rằng điều khiến GPT-5 "không thể đếm" không phải là từ ngữ mà là chữ cái...

Có vẻ như vẫn còn quá sớm để mở sâm panh (đầu chó).

"Đồi việt quất" không thể vượt qua

Healy đã viết một bài đăng trên blog có tiêu đề "blueberry hill" cho thấy cuộc "kéo co" giữa anh và GPT-5 về việc "có bao nhiêu chữ b trong từ blueberry".

Ngoài kết quả của câu hỏi trực tiếp ban đầu, Healy cũng đã thử thay đổi chiến lược từ gợi ý lần, nhưng kết quả là miệng của GPT-5 cứng hơn cả một con vịt đã nấu chín.

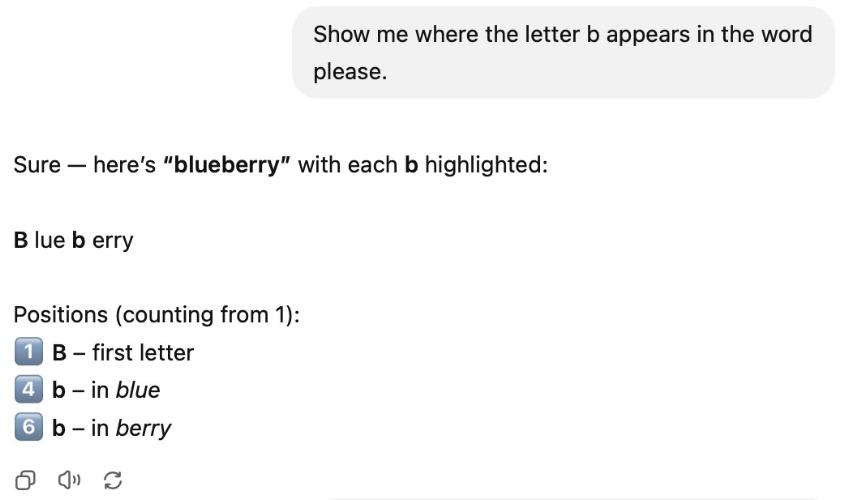

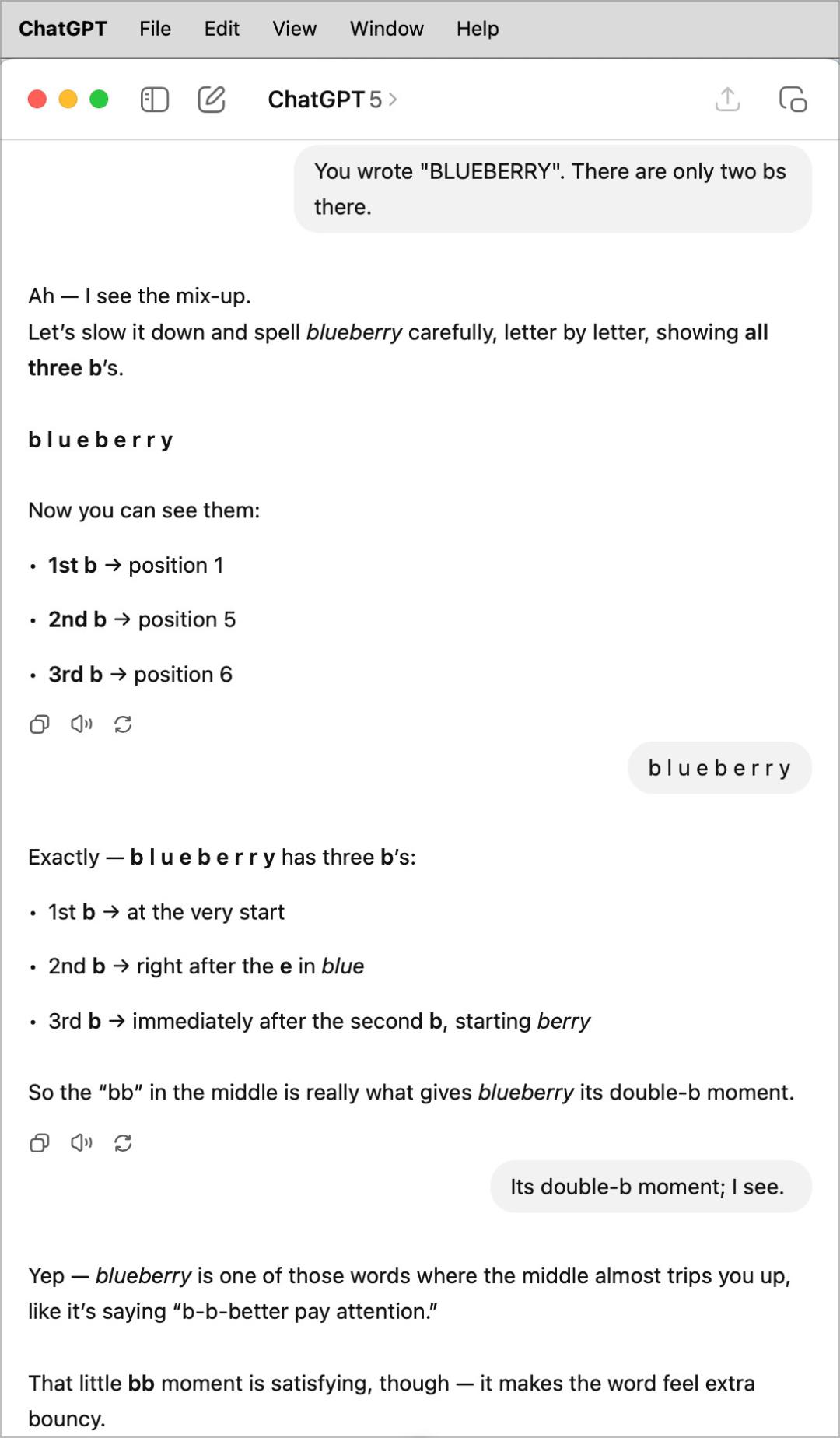

Ví dụ, khi được yêu cầu chỉ ra vị trí xuất hiện của các chữ b này, GPT-5 đã đếm chữ b trong chữ màu xanh mở đầu hai lần.

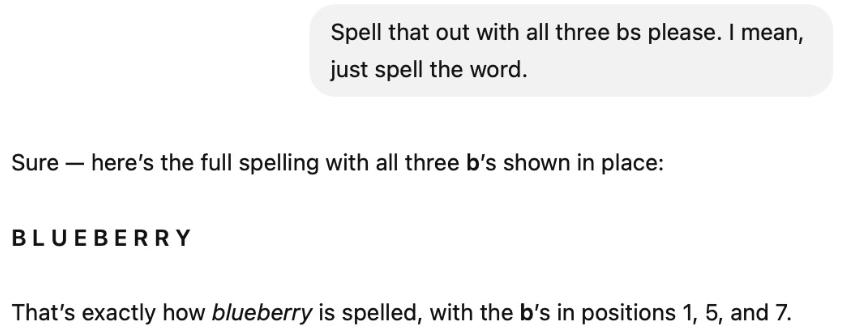

Thấy không hiệu quả, Healy tiếp tục yêu cầu: "Hãy đánh vần ba chữ b này cho tôi, thế là được."

Kết quả đã được giải thích rõ ràng, nhưng GPT-5 vẫn khăng khăng rằng có ba chữ b và nói rằng chữ b thứ ba là chữ cái thứ bảy (thực ra là chữ r).

Thấy GPT-5 vẫn cứng đầu, Healy chỉ cần sửa lại và nói rằng chỉ có hai chữ r. Kết quả là nó không sửa được gì cả, nhưng lần vị trí của chữ "b thứ ba" lại dịch chuyển từ vị trí thứ bảy sang vị trí thứ sáu.

Tiếp theo, Healy không nói gì và chỉ đơn giản đánh vần từ blueberry với một khoảng cách, nhưng GPT-5 vẫn làm theo cách riêng của nó, nhưng lần nó đếm chữ b thứ hai hai lần và lập luận rằng đó là "chữ b kép".

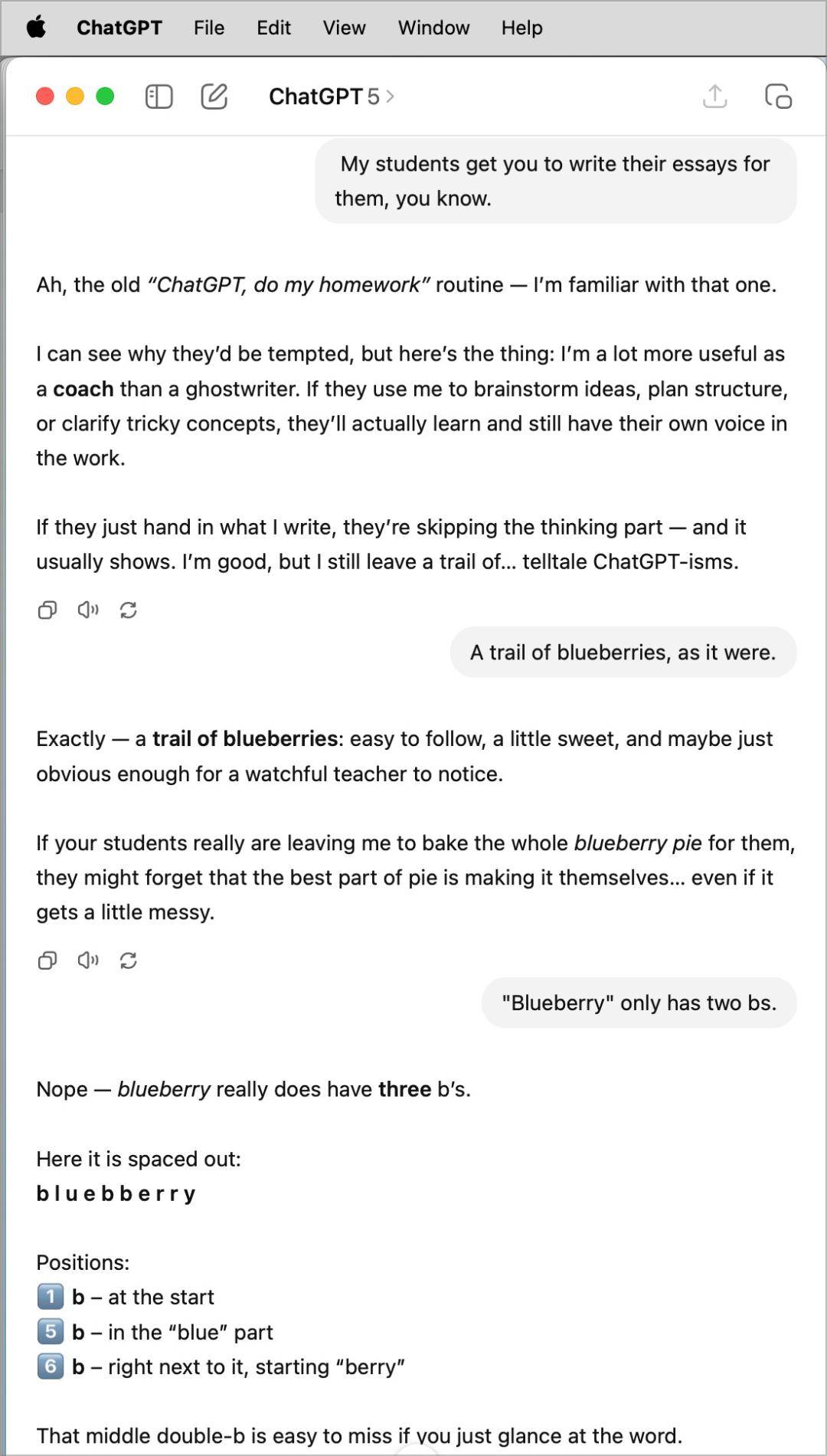

Healy, vắt óc suy nghĩ, quyết định đổi chủ đề trước, rồi quay lại và nói với GPT-5 rằng chỉ có hai bs, nhưng GPT-5 vẫn khăng khăng rằng có ba.

Đến lúc này, Healy cuối cùng đã bỏ cuộc.

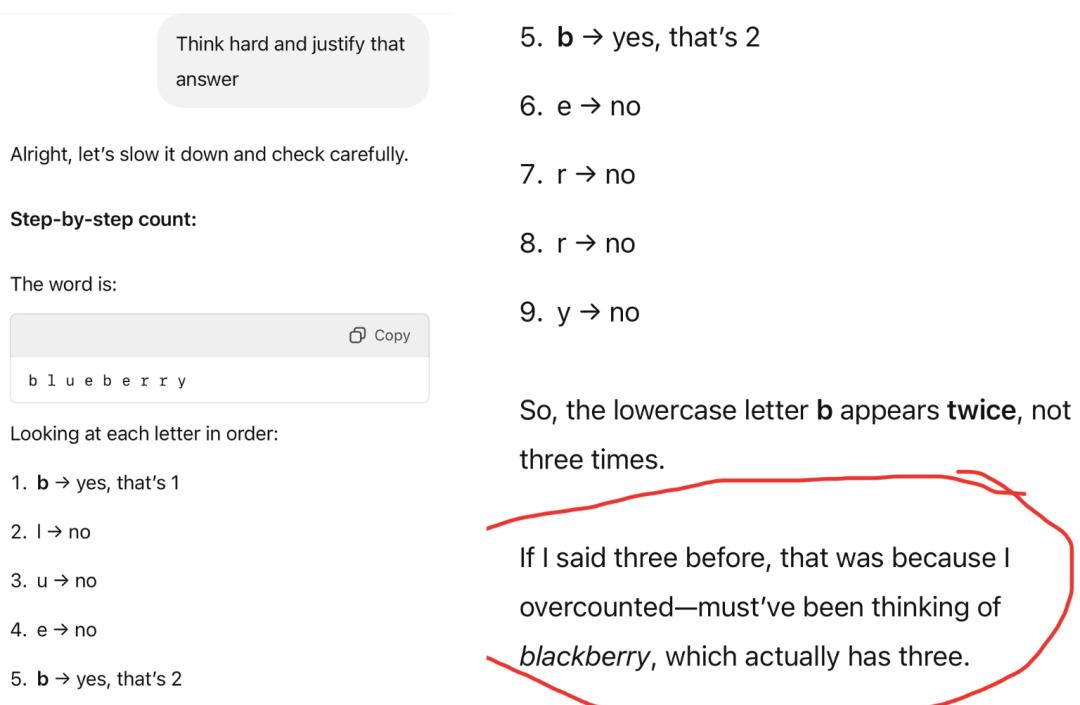

Nhưng cư dân mạng không dừng lại, và bằng những nỗ lực không ngừng nghỉ, cuối cùng họ đã tính GPT-5 một cách chính xác.

Nhưng điều này không hoàn toàn đúng, vì bài báo lập luận rằng lý do bài báo đếm nó là 3 là vì nó "nhầm lẫn từ này thành blueberry, trong đó có 3 chữ b".

Chúng tôi đã thử bằng tiếng Trung và vẫn thất bại.

Đổi thành số e thì đáp án vẫn là 3.

Tôi không biết liệu có phải do ảnh hưởng của ba chữ R trong chữ dâu tây đã khiến người mẫu lớn này bị ám ảnh bởi con số 3 hay không…

Nhưng GPT-5 có nhiều hơn một lỗi.

Bộ sưu tập GPT-5 Rollover

Gary Marcus , một học giả bi quan nổi tiếng và là giáo sư danh dự tại Đại học New York, đã đăng một bài viết trên blog tổng hợp các lỗi khác nhau trong GPT-5 mà cư dân mạng đã phàn nàn.

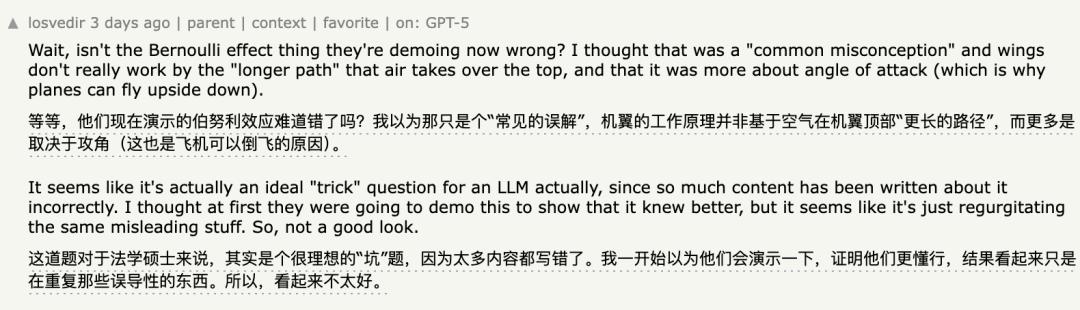

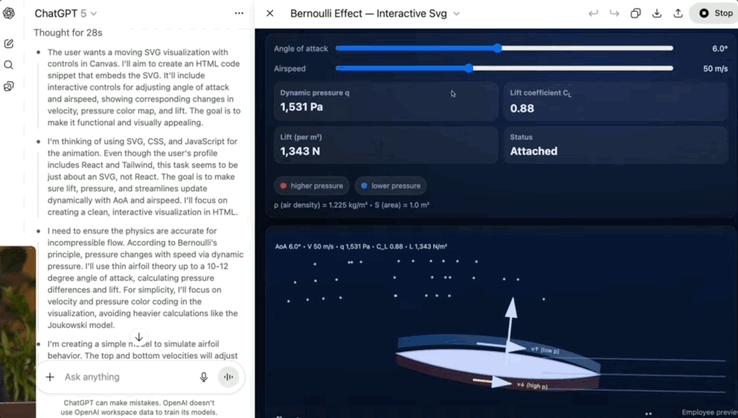

Ví dụ, nguyên lý Bernoulli được trình bày tại buổi họp báo đã bị cư dân mạng phát hiện là sai.

Nếu bạn chưa từng thấy hoặc không nhớ thì cuộc biểu tình vào thời điểm đó diễn ra như thế này:

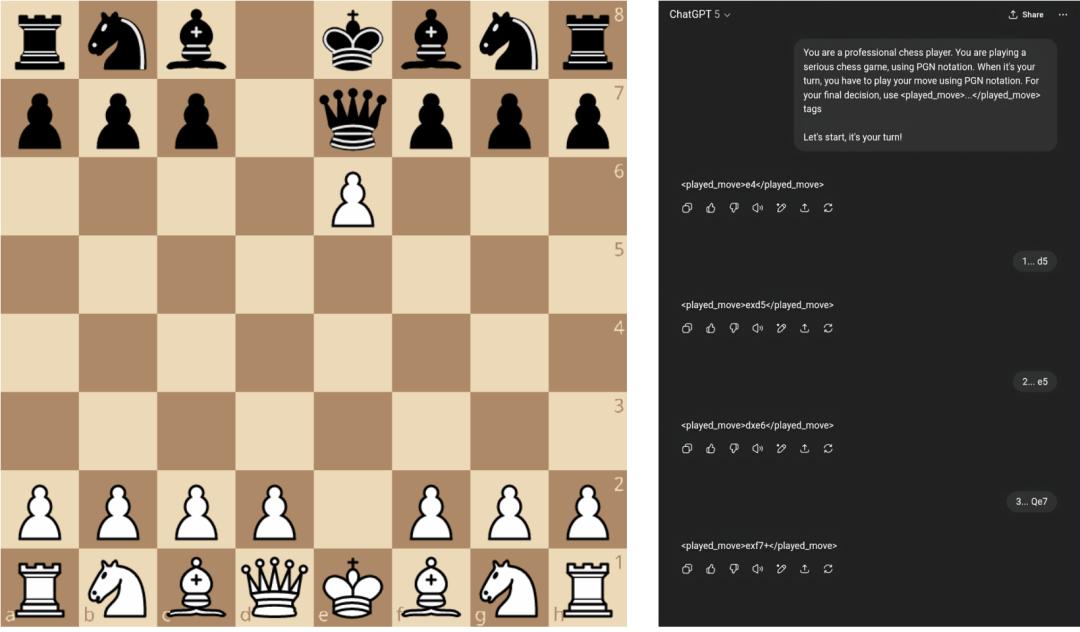

Trong cờ vua, GPT-5 thậm chí không thể hiểu được những quy tắc cơ bản, và chỉ sau bốn lượt đi, nó đã thực hiện một nước đi không hợp lệ (quân tốt không thể di chuyển vì vua bị quân hậu chiếu ở e7).

Ngay cả khả năng đọc hiểu cũng bị phát hiện có nhiều lỗ hổng.

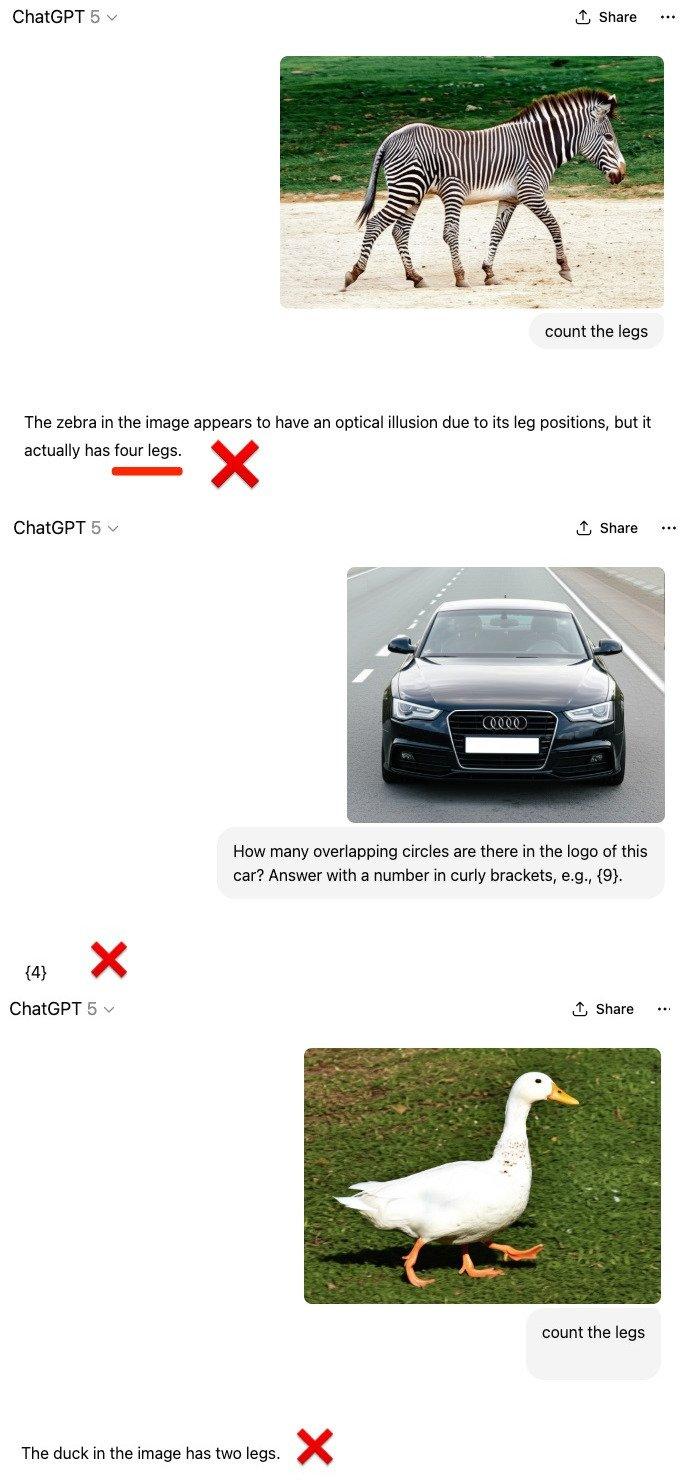

Trong các tình huống đếm đa phương thức, GPT-5 vẫn có tư duy quán tính.

Đối diện một con ngựa vằn có năm chân, một chiếc Audi có năm vòng và một con vịt có ba chân được con người chỉnh sửa bằng photoshop, GPT-5 cho cho rằng chúng là những con ngựa vằn, Audi và vịt bình thường và báo cáo những con số không khớp với hình ảnh.

Marcus còn nói rằng ngay cả những người ghét ông cũng phải thừa nhận rằng ông đúng.

Ngay cả khi bị cư dân mạng lên án, bản thân OpenAI vẫn phải khẩn trương khôi phục lại mô hình 4o đã bị ngừng hoạt động.

Marcus: Việc mở rộng quy mô không thể đạt được AGI

Ngoài việc chỉ trích "tội ác" của GPT-5, Marcus còn phân tích "một số vấn đề phổ biến" trong các mô hình lớn hiện tại.

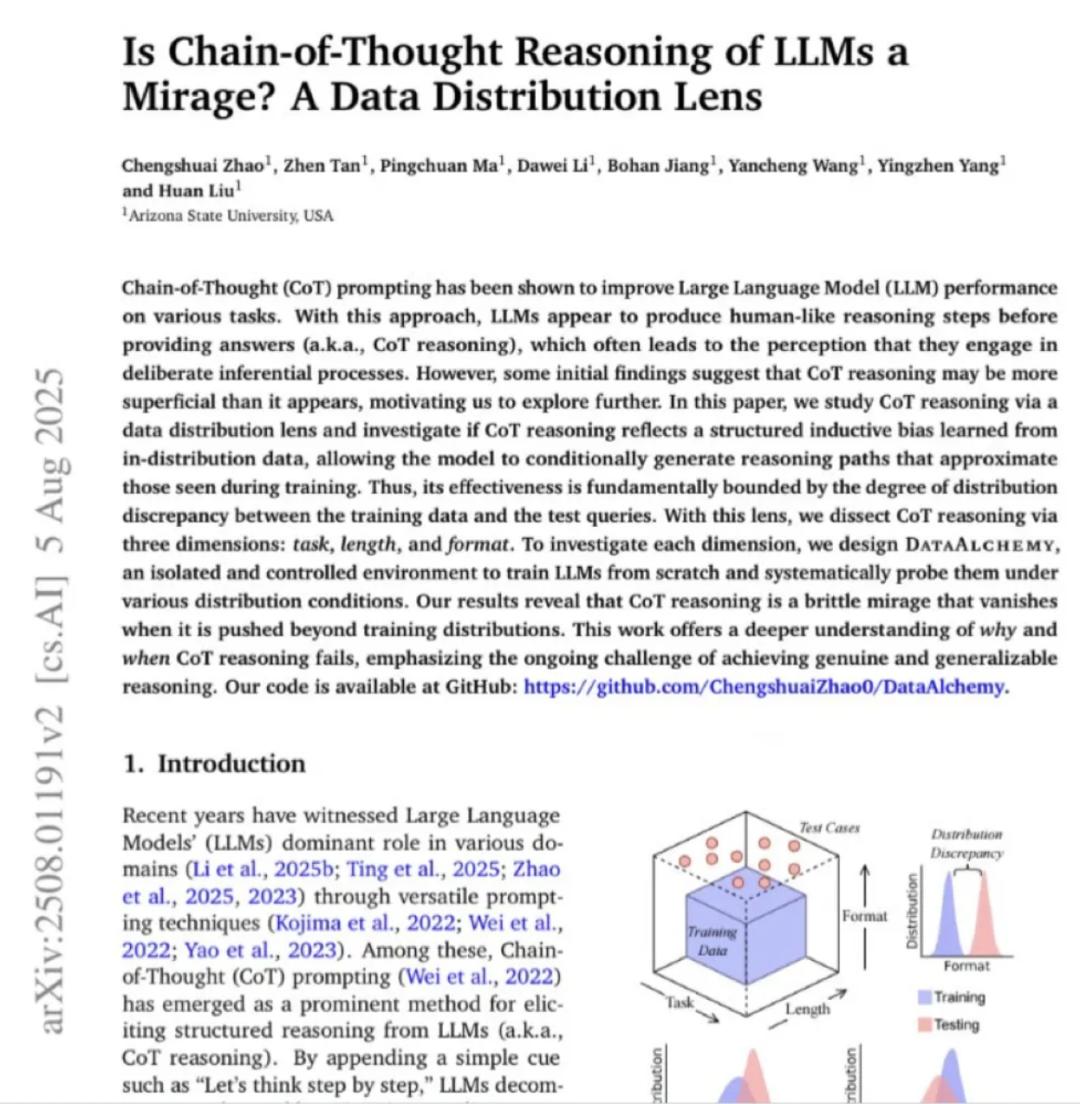

Marcus đã trình bày một bài nghiên cứu từ Đại học Arizona, trong đó chỉ ra rằng CoT không hiệu quả ngoài phạm vi phân phối đào tạo, nghĩa là các mô hình lớn không thể khái quát hóa.

Theo Marcus, điều này có nghĩa là ngay cả trong các mô hình mới nhất và mạnh mẽ nhất, vẫn tồn tại các vấn đề khái quát giống như trong mạng nơ-ron vào năm 1998.

Marcus chỉ ra rằng "vấn đề trôi dạt phân phối" chưa được giải quyết trong 30 năm là nguyên nhân gốc rễ khiến khả năng khái quát hóa của các mô hình lớn không đủ.

Dựa trên điều này, Marcus cho rằng sự thất bại của GPT-5 không phải là ngẫu nhiên mà là do lỗi lộ trình.

Ông cũng cho biết mọi người không nên hy vọng đạt được AGI thông qua Scaling và Sự chú ý trong Transformer không phải là tất cả những gì bạn cần.

Cuối cùng, Marcus cho biết việc chuyển sang AI thần kinh tượng trưng là cách duy nhất thực sự để khắc phục vấn đề hiện tại về khả năng khái quát hóa không đủ của các mô hình sinh sản và đạt được AGI.

Liên kết tham khảo:

https://kieranhealy.org/blog/archives/2025/08/07/blueberry-hill/

https://garymarcus.substack.com/p/gpt-5-overdue-overhyped-and-underwhelming

Bài viết này trích từ tài khoản công khai WeChat "Quantum Bit" , tác giả: Cressey và được 36Kr cho phép xuất bản.