GPT-5 đã chính thức được phát hành. Mặc dù đứng đầu bộ thử nghiệm, phản hồi của người dùng vẫn còn nhiều ý kiến trái chiều, với nhiều người dùng muốn giữ lại GPT-4o. OpenAI đặt mục tiêu bổ sung khả năng định tuyến mô hình để đáp ứng nhu cầu của nhiều người dùng khác nhau với các mô hình khác nhau và chi phí tỷ lệ băm khác nhau.

Dựa trên trải nghiệm hiện tại, những nỗ lực của OpenAI nhằm đạt được một "mô hình thống nhất" vẫn còn rất xa vời. GPT-5 thiếu những đột phá đáng kể về khả năng mô hình hoặc chuyển đổi mô hình; thay vào đó, OpenAI đang tập trung nhiều hơn vào đổi mới sản phẩm. GPT-5 là một mô hình có ít hiện vật hơn, dễ sử dụng hơn và khả năng giúp người dùng giải quyết các vấn đề cụ thể hơn. Tuy nhiên, nó thiếu các khả năng mới và không thể giải quyết hoàn toàn bất kỳ sai sót nào về cấu trúc của các mô hình lớn. Gần đây, truyền thông nước ngoài đưa tin rằng DeepSeek đang sử dụng chip nội địa để huấn luyện mô hình mới nhất của mình, nhưng ngày phát hành vẫn chưa chắc chắn. Việc phát hành GPT-5 cho thấy các mô hình lớn có thể đang gặp phải trở ngại. Đối mặt với "bức tường năng lực Transformer" này, OpenAI đã chọn cách tối đa hóa các khả năng hiện có và theo đuổi câu chuyện "siêu ứng dụng" của mình một cách trọn vẹn nhất. Trong khi đó, khi áp lực cạnh tranh để đạt được giới hạn cuối cùng của mô hình giảm bớt, DeepSeek đang bắt tay vào một nhiệm vụ đạt được khả năng tự cung tự cấp.

OpenAI, công ty quyết tâm sử dụng AGI để đưa xã hội loài người đến trạng thái "cực kỳ thịnh vượng", đang dần tiến xa hơn trên con đường trở thành siêu ứng dụng, với doanh thu và định giá tăng vọt; trong khi DeepSeek, công ty hy vọng khám phá giới hạn trên của khả năng AI và xây dựng hệ sinh thái mã nguồn mở để thúc đẩy khả năng tiếp cận công nghệ, có thể cần phải giải quyết các vấn đề khác nhau.

Có lẽ nhiều năm sau, khi mọi người nhìn lại dòng thời gian phát triển của ngành công nghiệp mô hình lớn, họ sẽ thấy có nhiều dòng giao nhau với bản phát hành DeepSeek R1 và GPT-4o, và phân kỳ sau GPT-5.

01 GPT-5, vốn thống trị bảng xếp hạng hiệu suất nhưng không đạt được kỳ vọng, đang đẩy nhanh quá trình sản xuất

Thị trường đã dự đoán một sự thay đổi mô hình, một khoảnh khắc sẽ định nghĩa lại tương tác giữa người và máy tính. Tuy nhiên , kết quả lại giống như một nâng cấp thông thường hơn. Mô hình của nó có nhiều tham số hơn, được huấn luyện trên dữ liệu mở rộng hơn và đạt điểm cao hơn trong một số bài kiểm tra, nhưng trí tuệ cốt lõi của nó lại không thể hiện những tiến bộ mang tính cách mạng. Giáo sư danh dự Gary Marcus của Đại học New York đã tóm tắt hiệu suất của GPT-5 trong ba từ: "quá hạn, được thổi phồng quá mức và không mấy ấn tượng".

Phân tích của ông chỉ ra rằng GPT-5 vẫn chưa khắc phục được những nhược điểm cố hữu của các mô hình ngôn ngữ lớn. Đôi khi nó vẫn bịa đặt sự thật, một hiện tượng được gọi là "ảo giác". Nó cũng tiếp tục mắc lỗi khi đối diện nhiệm vụ đòi hỏi suy luận logic nhiều bước. Hiệu suất đa phương thức trong việc cung cấp hiểu biết về thế giới thực cũng chưa được cải thiện đáng kể.

Những vấn đề này đã tồn tại trong kỷ nguyên GPT-4, và ngành công nghiệp đã hy vọng GPT-5 sẽ cung cấp giải pháp. Tuy nhiên, OpenAI đã chọn vá và tối ưu hóa khuôn khổ hiện có, sau đó phát triển dựa trên khả năng này để cung cấp một công cụ mô hình tốt hơn, dễ sử dụng hơn và được sản xuất hàng loạt.

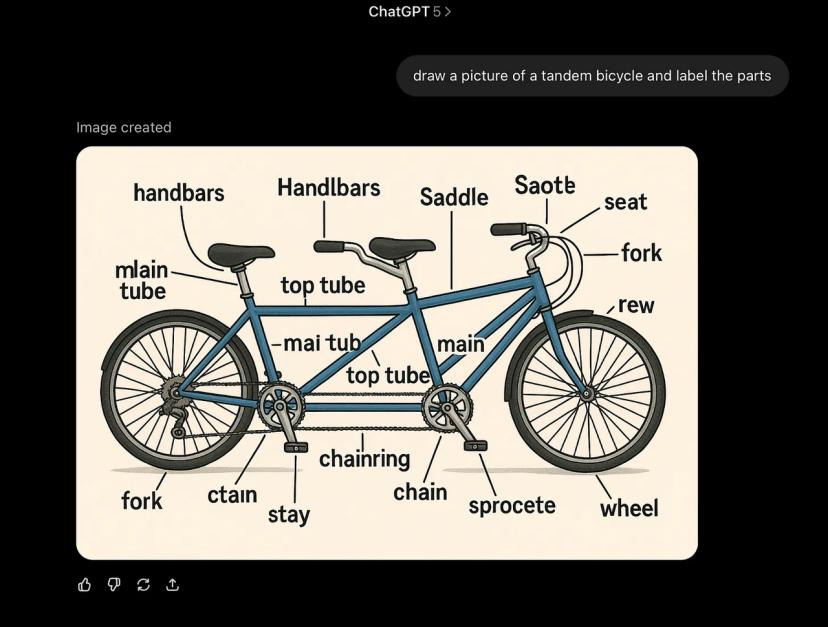

Nếu sự trì trệ của trí tuệ cốt lõi là điều mà các chuyên gia kỹ thuật và người dùng độ sâu cảm thấy, thì sự tiến bộ hạn chế của nó trong khả năng đa phương thức đã khiến những người đam mê công nghệ thất vọng. Trước khi GPT-5 ra mắt, đã có một sự đồng thuận chung rằng chiến trường quyết định cho thế hệ trí tuệ nhân tạo tiếp theo sẽ là đa phương thức. Mọi người tưởng tượng rằng GPT-5 sẽ có thể tiếp nhận, hiểu và tích hợp thông tin một cách liền mạch từ nhiều kênh như văn bản, hình ảnh, âm thanh và video, giống như con người. Tuy nhiên, hiệu suất thực tế của GPT-5 trong tương tác đa phương thức lại giống như một GPT-4V được tối ưu hóa. Nó có thể hoàn thành chính xác nhiệm vụ mô tả, chẳng hạn như nhận dạng đối tượng trong ảnh, nhưng khi nhiệm vụ chuyển sang hiểu, khả năng của nó mới trở nên rõ ràng.

OpenAI từ lâu đã là một chuẩn mực trong ngành, tiên phong trong việc tích hợp thuật toán Transformer với ngôn ngữ, mở ra kỷ nguyên của các mô hình lớn với ChatGPT, và tích hợp học tăng cường một cách tự nhiên vào quy trình huấn luyện các mô hình lớn, phá vỡ giới hạn về khả năng suy luận của mô hình quy mô lớn. Tuy nhiên, sau khi GPT-5 ra mắt, bên cạnh hiệu suất "không đạt kỳ vọng", những tính năng thu hút sự chú ý dường như lại là những thay đổi ở cấp độ sản phẩm.

OpenAI hy vọng có thể sử dụng chức năng "định tuyến mô hình" để ngăn người dùng lựa chọn giữa nhiều mô hình, hạ thấp ngưỡng sử dụng cho người dùng mới và hợp lý hóa việc phân bổ tỷ lệ băm, cho phép OpenAI cung cấp các dịch vụ chất lượng cao hơn cho nhiều người dùng hơn với tài nguyên tỷ lệ băm hạn chế.

Theo OpenAI, mặc dù GPT-5 đã giảm đáng kể ảo giác của mô hình, nhưng hiệu suất xử lý các bài toán cơ bản và khả năng hiểu biết về thế giới thực của nó vẫn chưa đạt yêu cầu, với nhiều lỗi rõ ràng vẫn còn tồn tại. Hơn nữa, có lẽ do việc sử dụng nội dung liên quan đến năng suất trong dữ liệu huấn luyện ngày càng tăng, trí tuệ cảm xúc của nó đã giảm đáng kể, khiến người dùng trò chuyện thông thường phải hủy theo dõi GPT-4o bằng cách hủy theo dõi họ.

GPT-5 cho thấy "đường thẳng" của OpenAI trong những đột phá về năng lực mô hình quy mô lớn, gần như gián tiếp báo hiệu sự xuất hiện của "bức tường năng lực mô hình quy mô lớn", hoặc ít nhất là một sự chững lại tạm thời trong các đột phá về mô hình quy mô lớn. Liệu năng lực mô hình trong tương lai có thể quay trở lại "cuộc đua mù quáng" từ GPT-3 lên GPT-4o hay không phụ thuộc vào những đột phá và đổi mới của các nhà nghiên cứu trong các công nghệ nền tảng.

Ilya, cựu nhà khoa học trưởng của OpenAI, đã từng tóm tắt xu hướng phát triển của công nghệ AI trong một cuộc phỏng vấn có tựa đề "Tại sao dự đoán mã thông báo tiếp theo là đủ cho AGI" vào cuối năm 2023, điều này dường như đã phần nào dự đoán được sự xuất hiện của thời điểm này.

“Các nhà nghiên cứu và dự án khác nhau sẽ có những hướng đi khác nhau trong một khoảng thời gian. Sau đó, khi mọi người nhận thấy một công nghệ nào đó hiệu quả, nghiên cứu sẽ nhanh chóng hội tụ theo hướng đó, và rồi nó có thể trở lại trạng thái trăm hoa đua nở như trước.”

02 Liệu Lương Văn Phong có nắm bắt được cơ hội để tự chủ sản xuất mô hình quy mô lớn trong nước hay không?

Nếu bức tường công nghệ Transformer thực sự đã xuất hiện, chúng ta có thể kỳ vọng gì vào DeepSeek? Nhìn lại lịch sử phát hành sản phẩm của DeepSeek, mỗi bản phát hành lớn đều giải quyết một vấn đề quan trọng trong công nghệ mô hình lớn theo mốc thời gian riêng của nó.

Sê-Ri DeepSeek-V2 ra mắt vào tháng 5 năm 2024 đã cách mạng hóa các vấn đề về hiệu quả của xử lý ngữ cảnh dài, tiên phong trong cơ chế chú ý tiềm ẩn đa đầu (MLA), hỗ trợ xử lý tới 128 nghìn mã thông báo và đồng thời gây ra cuộc chiến về giá giữa các công ty AI lớn của Trung Quốc với mức giá API cực thấp (2 nhân dân tệ cho một triệu mã thông báo), cải thiện đáng kể khả năng chi trả và tiềm năng triển khai thực tế của các mô hình lớn.

DeepSeek-V3, được phát hành vào tháng 12 năm 2024, ra mắt với kiến trúc MoE 671B tham số, giải quyết điểm yếu về tốc độ suy luận bằng cách đạt được khả năng tăng tốc gấp 3 lần lên 60 token mỗi giây. Hiệu suất của nó đạt mức tương đương với GPT-4o trong khi vẫn duy trì hiệu quả sử dụng tài nguyên, gần như thu hẹp khoảng cách hiệu suất giữa các mô hình nguồn mã nguồn mở và nguồn đóng.

Vào tháng 1 năm 2025, DeepSeek-R1 tập trung vào việc cải thiện khả năng suy luận, sánh ngang hoặc vượt qua mô hình o1 của OpenAI trong nhiệm vụ AIME và MATH, với chi phí thấp hơn nhiều so với tất cả các mô hình tại thời điểm đó. Nó đã đứng đầu App Store Hoa Kỳ thông qua ứng dụng, giải quyết vấn đề rào cản tiếp cận AI cao cấp và thúc đẩy sự phổ biến và dân chủ hóa AI mã nguồn mở toàn cầu.

Sau khi V3 và R1 giúp DeepSeek trở nên cực kỳ phổ biến, công ty này dường như đã chuyển mình từ một công ty khởi nghiệp về định lượng và nổi tiếng với các mô hình lớn thành một công ty công nghệ đảm nhiệm nhiều nhiệm vụ hơn.

Theo báo chí nước ngoài, DeepSeek hiện đang chuyển đổi việc đào tạo các mô hình quy mô lớn tiên tiến nhất của mình sang chip sản xuất trong nước. Con đường sản xuất các mô hình quy mô lớn trong nước khó khăn hơn nhiều so với tưởng tượng. Tuy nhiên, dưới tác động của nhiều yếu tố, bao gồm cả tình hình địa chính trị bất ổn, nếu các công ty AI Trung Quốc không thể thoát khỏi sự phụ thuộc vào GPU Nvidia, họ sẽ phải đối mặt với một "thanh gươm Damocles" treo lơ lửng trên đầu.

Trong khi đó, việc OpenAI phát hành GPT-5 báo hiệu sự chậm lại tạm thời trong quá trình phát triển công nghệ mô hình quy mô lớn, tập trung vào Transformer. Điều này báo hiệu cho tất cả các công ty công nghệ, bao gồm cả DeepSeek, rằng họ có thể tự tin theo đuổi các lĩnh vực khác ngoài nhiệm vụ chính là liên tục cải thiện hiệu suất mô hình.

Việc sản xuất trong nước các mô hình lớn hiệu suất cao, tiên tiến, từ huấn luyện đến suy luận, cũng khó khăn như việc phát triển một quả bom nguyên tử mới, ngay cả đối với một công ty AI hàng đầu đã chuyển đổi việc phát triển mô hình quy mô lớn từ một "quả bom nguyên tử" đơn giản thành một quả trứng trà. Những thách thức kỹ thuật cần thiết để vượt qua quá trình này có thể lớn hơn nhiều so với những thách thức phải đối mặt khi huấn luyện tất cả các mô hình đã phát hành trước đây của DeepSeek cộng lại.

Thứ nhất, vẫn còn một khoảng cách thế hệ giữa hiệu năng của GPU sản xuất trong nước và GPU card đơn của NVIDIA. Mặc dù GPU nội địa đã thu hẹp được khoảng cách này nhờ công nghệ kết nối dày đặc hơn, nhưng việc cạnh tranh với "cụm 100.000 card" của NVIDIA được sử dụng trong các mô hình quy mô lớn tại Thung lũng Silicon, việc sử dụng GPU sản xuất trong nước để đào tạo các mô hình tiên tiến đối diện những thách thức kỹ thuật đáng kinh ngạc.

Việc phát triển mô hình quy mô lớn dựa trên các framework mã nguồn mở như PyTorch và TensorFlow, vốn ban đầu được tối ưu hóa cho phần cứng quốc tế phổ biến. Nếu DeepSeek muốn bản địa hóa, nó sẽ phải di chuyển toàn bộ ngăn xếp phần mềm sang phần cứng nội địa, đồng nghĩa với việc phải viết lại hoặc sửa đổi lượng lớn mã nguồn để tương thích với các kiến trúc điện toán nội địa. So với các framework mã nguồn mở phổ biến và hệ sinh thái CUDA đã được phát triển trong nhiều năm, một ngăn xếp phần mềm nội địa được xây dựng lại sẽ cực kỳ khó khăn để đạt được hiệu suất và độ ổn định của các giải pháp phổ biến đã được phát triển trong gần một thập kỷ.

Tuy nhiên, nếu DeepSeek có thể tiếp tục hợp tác chặt chẽ với các nhà sản xuất phần cứng trong nước, giống như DeepSeek đã làm với việc phát triển các mô hình lớn, bắt đầu từ con số 0 và từng bước tiến lên vị trí hàng đầu trong ngành, thì sẽ có hy vọng loại bỏ hoàn toàn thanh gươm Damocles treo lơ lửng trên đầu.

DeepSeek tiếp tục khám phá và cải thiện hiệu quả của việc đào tạo và suy luận mô hình quy mô lớn và đã đạt được những kết quả đáng chú ý.

Vào cuối tháng 7 năm nay, bài báo "Native Sparse Attention: Hardware-Aligned and Natively Trainable Sparse Attention" do đội ngũ DeepSeek và Đại học Bắc Kinh cùng các tổ chức khác công bố, với Liang Wenfeng là tác giả liên hệ, đã giành được Giải thưởng Bài báo hay nhất ACL 2025.

https://arxiv.org/abs/2502.11089

Bài báo này, lần đầu tiên, tập trung ít hơn vào lý luận lý thuyết và toàn bộ quá trình đào tạo, duy trì hiệu suất mô hình và cải thiện hiệu quả đào tạo, đồng thời tăng tốc độ suy luận lên đến 11 lần. Việc giành Giải thưởng Bài báo Xuất sắc nhất tại hội nghị xử lý ngôn ngữ tự nhiên hàng đầu, ACL, chứng tỏ sự công nhận của ngành công nghiệp đối với giá trị của công nghệ này.

Sự sẵn lòng công khai những đổi mới như vậy, vốn đóng vai trò then chốt trong cạnh tranh thương mại, cũng phản ánh quyết tâm và khả năng liên tục thúc đẩy phổ biến công nghệ mô hình quy mô lớn của DeepSeek.

Chúng ta hãy cùng chờ xem mô hình DeepSeek mới tích hợp nhiều tính năng hơn như "sự chú ý thưa thớt gốc" sẽ mang lại bất ngờ gì cho ngành công nghiệp về mặt năng lực và hiệu quả, cũng như khả năng thúc đẩy quá trình bản địa hóa nghiên cứu và phát triển mô hình quy mô lớn đến đâu.

Bài viết này được trích từ tài khoản công khai WeChat "Facing AI" (ID: faceaibang) , tác giả: Hurun Miaozheng và được 36Kr cấp phép xuất bản.