随着对 AI 代理的投资不断增加,这预示着一个比工业革命更具变革性的广泛自动化的未来。与所有技术创新一样,AI 代理在开发过程中也将面临挑战。负责任的使用和持续改进至关重要,以最大限度地实现 AI 代理的潜力。

BeInCrypto 在香港共识会议上采访了 DWF Labs 的管理合伙人 Andrey Grachev,了解 AI 代理面临的主要大众化挑战,以及广泛使用的可能情况。

传统技术领域、Web3 AI 的采用

在这一时刻,人工智能(AI)的采用很快就会成为不可避免。包括 Meta、亚马逊、Alphabet 和微软在内的科技巨头已经宣布,到 2025 年将在 AI 和数据中心上投资最多 3200 亿美元。

美国总统特朗普在就职首周宣布了一项新的私营合资企业 Stargate,重点是开发 AI 数据中心。这个合资企业包括 OpenAI、软银和甲骨文,计划在全美建设最多 20 个大型 AI 数据中心。

初期投资估计为 1000 亿美元,根据扩张计划,到 2029 年可能达到 5000 亿美元。

Web3 项目也在进行类似的 AI 投资。12 月,DWF Labs 推出了一只 2000 万美元的 AI 代理基金,以加速自主 AI 技术创新。

本月初,支持 NEAR 协议的 NEAR 基金会也宣布了一只 2000 万美元的基金,用于扩展基于 NEAR 技术构建的完全自主和可验证的代理开发。

"历史表明,所有可自动化的事物都将被自动化。确实,一些商业和日常生活流程将被 AI 代理取代。" – Andrey Grachev, DWF Labs 管理合伙人

然而,随着 AI 开发的加速,其滥用的可能性也越来越令人担忧。

AI 代理的滥用

在 Web3 中,AI 代理已经快速成为主流。它们提供从市场分析到自主加密货币交易的各种功能。

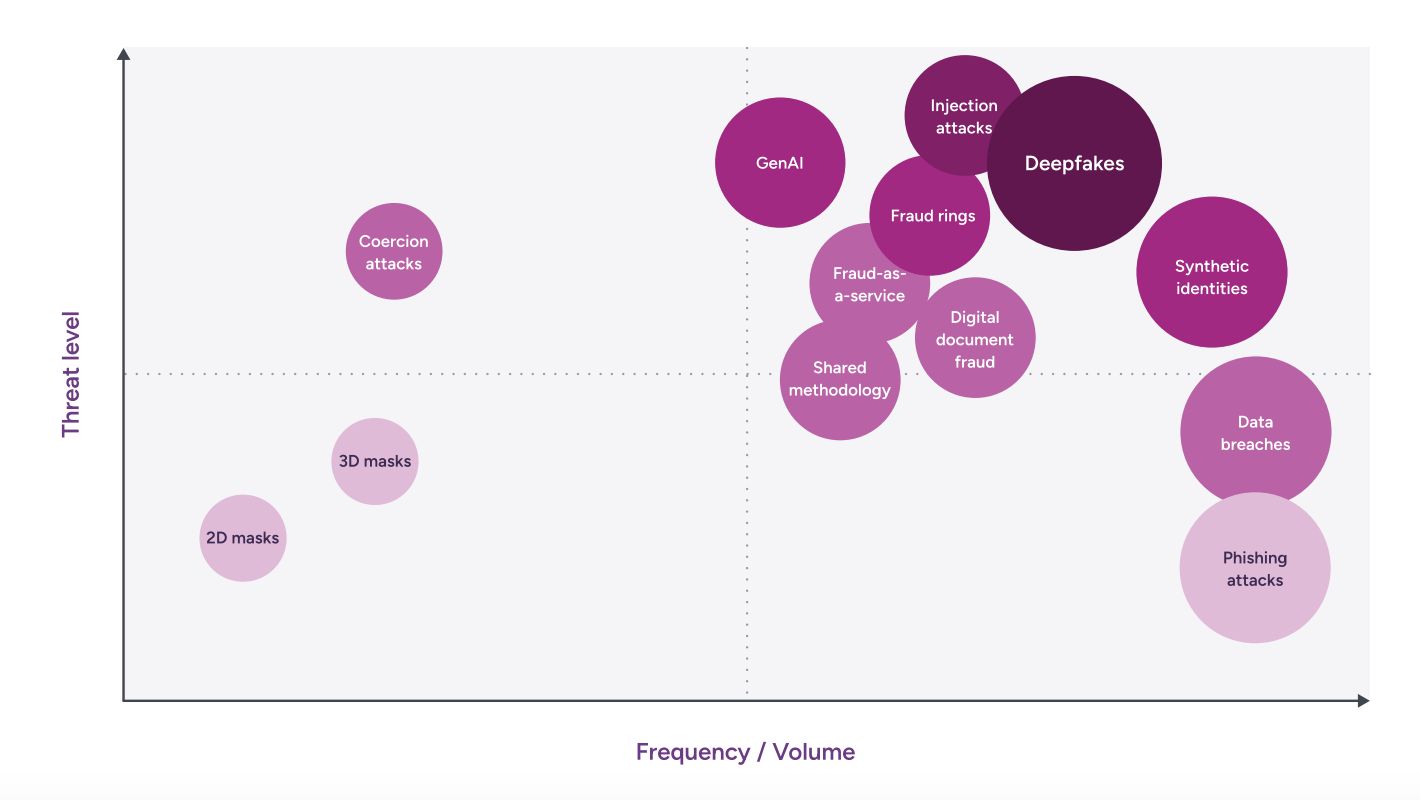

但是,它们不断增加的集成带来了重要的挑战。恶意行为者对 AI 的滥用是一个主要担忧,从简单的网络钓鱼活动到复杂的勒索软件攻击都在其列。

从 2022 年底开始,生成式 AI 的广泛可用性彻底改变了内容创作,并吸引了试图滥用这项技术的恶意行为者。这种计算能力的民主化提高了对手的能力,并可能降低较不复杂的威胁行为者的进入门槛。

根据 Entrust 的报告,由 AI 工具推动的数字文档伪造已超过实体伪造,到 2024 年将增加 244%。同时,深度造假占所有生物识别欺诈的 40%。

"它已经被用于欺诈。用于在视频通话中错误地表现人们和错误地表现他们的声音。" – Andrey Grachev, DWF Labs 管理合伙人

这些滥用案例已经成为新闻头条。本月初,一名来自香港跨国公司的金融员工被一名使用深度造假技术的骗子骗取了 2500 万美元。

该员工相信他与包括公司首席财务官在内的同事进行了视频通话。尽管最初有所犹豫,但由于其他参与者看起来和听起来都很真实,该员工最终还是按照报告进行了支付。后来证实,所有与会者都是深度造假操纵。

从早期采用到主流接受

Grachev 认为这种恶意使用是不可避免的。他指出,技术发展通常伴随着初期错误,但随着技术成熟,这些错误会减少。Grachev 用万维网和比特币的早期阶段作为两个例子来证明他的观点。

"我们必须记住,互联网起源于色情网站。这就像第一个比特币起源于毒品交易商一样,之后得到了改善。" – Andrey Grachev, DWF Labs 管理合伙人

多份报告支持 Grachev 的观点。成人娱乐行业在互联网的早期采用和发展中发挥了重要作用。除了提供消费者基础之外,它还开拓了 VCR、视频流媒体、虚拟现实和各种通信技术。

色情业充当了一个入门工具。历史上,成人娱乐行业一直主导着新技术的消费者采用。

特别是当它成功满足受众需求时,创新的早期采用和应用通常会导致更广泛的主流采用。

"开始是出于娱乐,但娱乐让很多人加入进来。然后你可以在此基础上建立一些东西。" – Andrey Grachev, DWF Labs 管理合伙人

随着时间的推移,也建立了一些安全措施来限制成人娱乐的频率和可访问性。尽管如此,它仍然是当今互联网提供的众多服务之一。

比特币,从暗网到创新

比特币的发展与互联网的早期使用案例非常相似。比特币的早期采用与暗网市场和非法活动,如毒品交易、欺诈和洗钱密切相关。比特币的匿名性和全球资金转账的便利性对罪犯很有吸引力。

尽管在犯罪活动中持续使用,但比特币也找到了许多合法的应用。支撑加密货币的区块链技术为现实世界的问题提供了解决方案,并扰乱了传统金融体系。

加密货币和区块链应用程序仍处于非常早期的行业阶段,但将继续发展。根据Garchev的说法,AI技术的渐进采用也会发生同样的情况。他表示,我们必须通过犯错来学习并相应调整。

"我们必须记住,欺诈首先发生,然后人们才开始考虑如何预防它。当然会发生,这是正常的过程,也是学习曲线。"Grachev说。

但是,知道这种情况将来会发生,也引发了关于谁应该承担责任的问题。

责任问题

当代理人的行为造成损害时,确定责任是一个复杂的法律和道德问题。不可避免地会提出如何追究AI责任的问题。

AI系统的复杂性使确定责任变得困难。AI的"黑箱"特性、不可预测的行为以及持续学习能力,使得通常适用于确定过错的一般概念难以适用。

此外,多方参与AI的开发和部署,也使责任评估变得复杂,难以确定AI故障的责任方。

责任可能在于制造商存在设计或生产缺陷、软件开发者存在代码问题,或用户未遵循指南、未安装更新或未维护安全性。

"我认为这一切都太新了,我们必须从中学习。如果需要,我们应该能够停止某些AI代理。但从我的角度来看,如果没有恶意创造它们,那么就没有人应该承担责任。因为你真的在处理一些全新的东西。"Grachev告诉BeInCrypto。

但是,他表示,这种情况必须谨慎管理,以免影响持续创新。

"如果我们谴责这些企业家,人们会害怕,创新就会死亡。但如果它以错误的方式运作,最终它仍将运作。我们必须学会停下来,学习,改进,然后重新学习。"Grachev补充说。

但在更极端的情况下,这种界限变得非常模糊。

采用负责任的AI,解决信任问题

在讨论人工智能的未来时,一个普遍的担忧是AI代理可能会变得比人类更强大。

"有很多电影讲述这个问题。如果谈及警察、政府控制或军队在战争中使用自动化,这是一个巨大的恐惧。某些事物可能会自动化到足以伤害人类的程度。"Grachev说。

对于这种情况是否可能发生,Grachev表示在理论上是可能的。尽管如此,他承认无法预知未来会发生什么。

但这种情况代表了人类与人工智能之间根本的信任问题。Grachev说,解决这个问题的最佳方法是让人类接触到AI实际上可以提供帮助的用例。

"AI可能很难让人们相信。所以我们应该从简单的事情开始。当你解释AI代理是可信的时,信任并不会自动形成。人们需要习惯使用它。例如,如果谈论加密货币,你可以在Pump.fun上发布一个meme,但为什么不用语音消息发布呢?使用AI代理发送'请发布这个和那个'的语音消息,它就会发布。下一步就是相信代理做出更重要的决定。"他说。

最终,通向广泛采用AI的道路,必将标志着惊人的进步和意料之外的挑战。

在这个不断发展的领域,平衡创新和负责任的实施,对于塑造AI为全人类带来利益的未来至关重要。