软体开发人员对人工智慧工具的热情就像孩子们发现糖果一样,但他们对成果的信任程度却与政客的承诺差不多。

Google云端周三发布的 2025 年 DORA 报告显示,目前 90% 的开发人员在日常工作中使用人工智慧,比去年增加了 14% 。

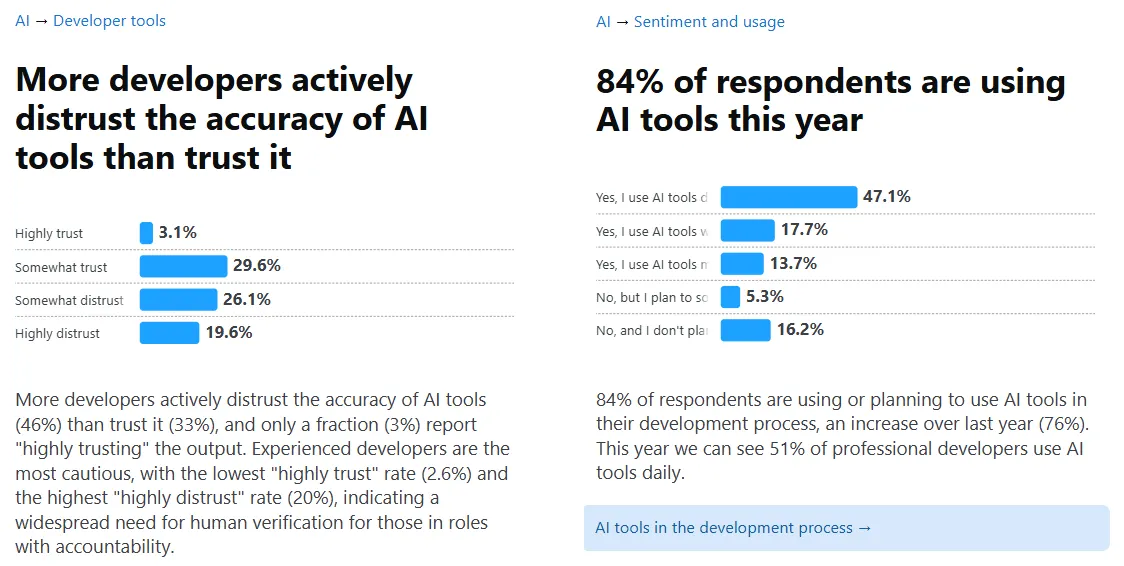

报告也发现,只有 24% 的受访者真正信任这些工具所产生的资讯。

这项年度研究调查了全球近 5,000 名技术专业人士,描绘了一个试图快速发展而不破坏现状的行业图景。

开发人员每天平均花费两小时与人工智慧助理合作,将其融入从程式码产生到安全审查等各个环节。然而,其中 30% 的专业人士对人工智慧的输出「有点信任」或「完全不信任」。

负责谷歌编码工具(包括Gemini Code Assist)的瑞安·萨尔瓦 (Ryan Salva) 告诉 CNN:“如果你是谷歌的工程师,那么使用人工智慧作为日常工作的一部分是不可避免的。”

该公司自己的指标显示,Google目前超过四分之一的新代码来自人工智慧系统,执行长 Sundar Pichai 声称整个工程团队的生产力提高了 10%。

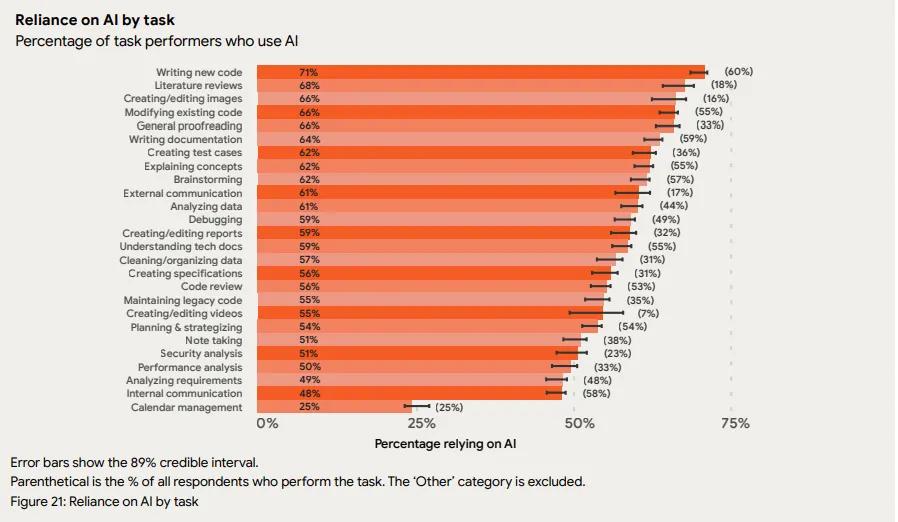

开发人员主要使用 AI 来编写和修改新程式码。其他用例包括调试、审查和维护遗留程式码,以及用于解释概念或编写文件等更具教育意义的用途。

尽管缺乏信任,但超过 80% 的受访开发人员表示人工智慧提高了他们的工作效率,而 59% 的开发人员表示程式码品质有所提高。

然而,事情变得奇怪了:65%的受访者表示自己严重依赖这些工具,尽管他们并不完全信任它们。

在该群体中,37% 的人表示依赖程度为“中度”,20% 的人表示依赖程度为“严重”,8% 的人承认依赖程度为“很大”。

这种信任-生产力悖论与 Stack Overflow 2025 年调查的结果一致,尽管当年的采用率高达 84%,但对人工智慧准确性的不信任在短短一年内就从 31% 上升到了 46% 。

开发人员将人工智慧视为才华横溢但不可靠的同事——对于集思广益和繁重的工作很有用,但一切都需要仔细检查。

DORA:推动人工智慧原生工作

谷歌的回应不仅仅是记录这一趋势。

周二,该公司公布了其 DORA 人工智慧能力模型,该模型是一个框架,确定了七种旨在帮助组织利用人工智慧价值而不承担风险的实践。

该模型提倡以用户为中心的设计、清晰的沟通协议以及谷歌所称的「小批量工作流程」——本质上是为了避免无人监督的人工智慧运作。

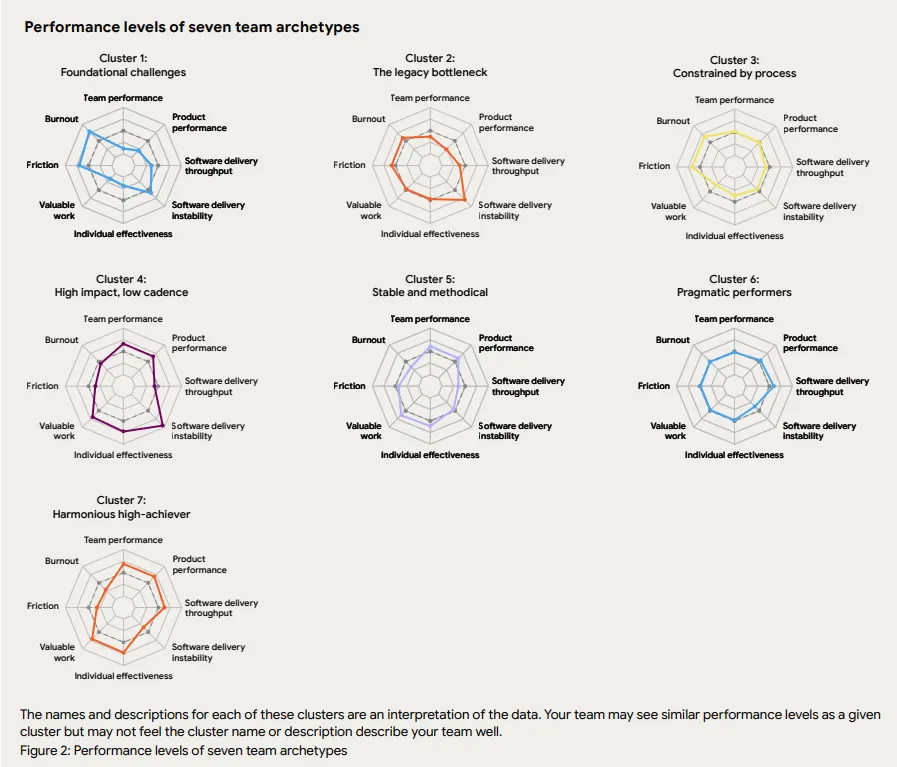

报告还介绍了各种团队原型,从「和谐的高成就者」到陷入「遗留瓶颈」的群体。

这些概况源自于对不同组织处理AI整合方式的分析。拥有强大现有流程的团队发现AI放大了他们的优势。而碎片化的组织则发现AI暴露了他们工作流程中的所有弱点。

完整的《人工智慧辅助软体开发现况》报告和配套的 DORA 人工智慧功能模型文件可透过 Google Cloud 的研究入口网站取得。

这些材料包括针对希望更积极主动采用人工智慧技术的团队的规范指导——假设有人足够信任他们并愿意实施这些技术。