0G Labs 的定位并非另一个人工智能区块链。它正在构建一个去中心化的人工智能操作系统,将存储、数据可用性、计算和结算统一到一个集成的堆栈中。

0G 的核心创新在于基础设施设计而非模型。通过优化存储以实现快速读取、将数据可用性与存储证明相结合,以及实现可验证计算,0G 直接针对阻碍链上人工智能应用的物理限制。

0G的长期成功与其说是取决于技术上的雄心壮志,不如说是取决于执行力。真正的AI工作负载、持续的使用以及安全的去中心化运营必须快速增长,才能证明其集成架构和代币经济的合理性。

人工智能暴露出的基础设施差距

多年来,加密网络一直专注于一项明确的任务:安全地转移价值、结算交易、维护账本的一致性和可靠性。正因如此,大多数第一层区块链都针对交易进行了优化,而非大规模数据处理或繁重的计算。

人工智能很快就改变了这种平衡。

现代人工智能不仅仅在于更智能的模型,它还由海量数据流驱动。训练通常需要从千兆字节到拍字节级别的数据集。推理过程会提取大量的上下文信息,并生成连续的日志。人工智能体并非生成一个结果就停止运行,而是持续运行,不断生成状态、内存和交互数据流。

真正的问题不在于区块链能否存储数据,而在于从成本和性能角度来看,在链上以人工智能规模存储和读取数据一直都不现实。

存储成为第一个瓶颈

第一个限制出现在存储层。

在传统区块链上,链上存储成本极其高昂。即使是专为去中心化存储而构建的网络,也常常为了持久性而牺牲速度。它们中的许多网络在冷归档方面表现出色,但在应用程序需要频繁快速读取数据时却显得力不从心。

人工智能工作负载有所不同。它们具有活跃性、持续性和对延迟高度敏感的特点。

当数据检索速度变慢时,整个人工智能工作流程就会失去价值。

数据可用性无法跟上人工智能规模的发展速度。

与此同时,数据可用性很快达到极限。

大多数模块化数据处理系统都是为Rollup交易数据而设计的,其吞吐量通常以兆字节/秒 (MB/s) 为单位。人工智能数据流的规模则完全不同。一旦数据处理层成为瓶颈,就会限制其上构建的所有内容。

人工智能输出缺乏验证

另一个关键问题来自验证环节。

大多数人工智能系统仍然像黑箱一样运行。用户无法证明哪个模型产生了输出结果,也无法验证使用了哪些数据,更无法确认任务是否已完整、正确地执行。在金融、治理或自动化执行等高价值领域,这种缺乏证明的情况是不可接受的。

鉴于这些限制,0G Labs 直言不讳地指出:人工智能和 Web3 的融合不会通过改进界面来实现,而只能通过围绕数据、带宽和可验证计算重建基础设施来实现。

为什么 0G 将自己定义为 dAIOS

在人工智能的语境下,许多项目自称为“人工智能链”。有些专注于GPU交易市场,有些则提供模型托管服务。0G则另辟蹊径,将自身定义为去中心化人工智能操作系统(dAIOS)。

这一定义反映的是一种结构性决策,而非市场营销选择。

从区块链思维到操作系统思维

传统操作系统管理本地资源。它调度 CPU 时间、分配内存、控制磁盘访问。最重要的是,它提供稳定的接口,使开发人员无需处理硬件的复杂性。

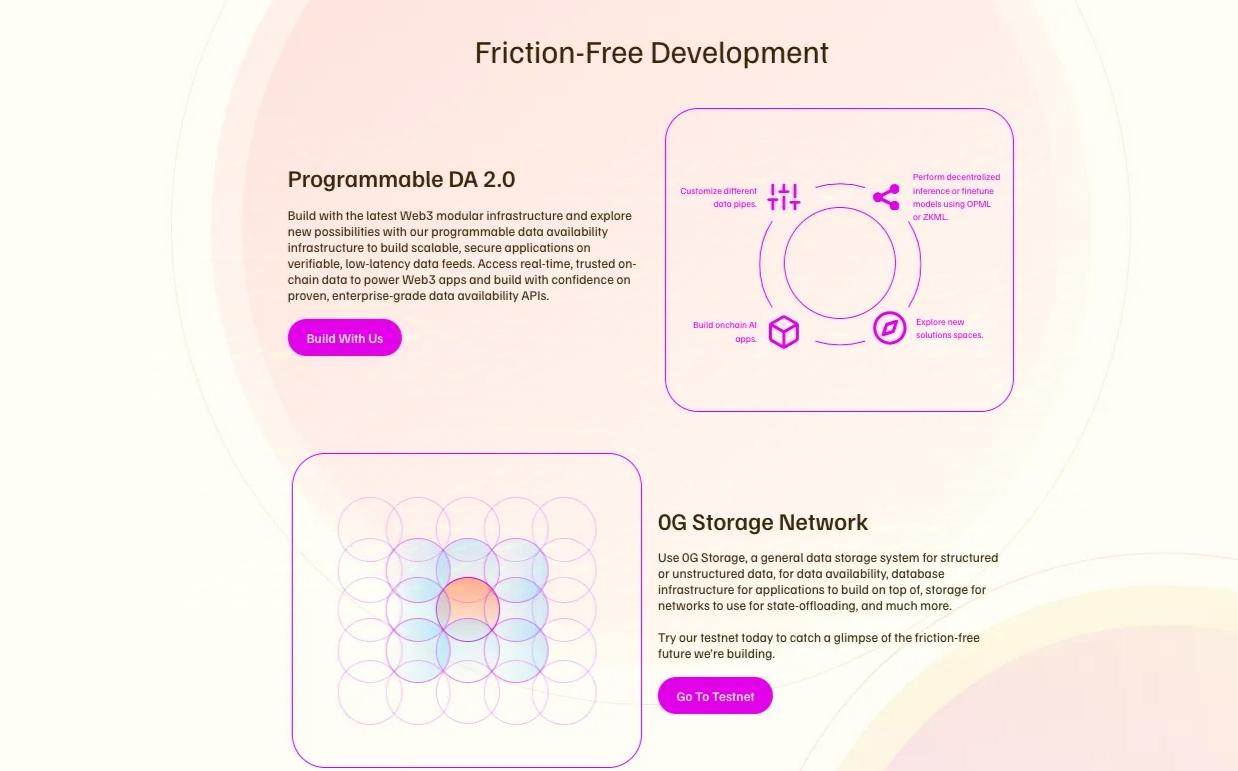

0G认为,人工智能经济需要一个类似的分布式层。在这种环境下,资源不再局限于单台机器,而是包括全球存储、带宽、计算能力和共识机制。

开发人员不需要将独立的存储网络、数据架构层、计算市场和结算链组合在一起,而需要一个像统一系统一样运行的堆栈。

dAIOS背后的承诺

基于这一理念,0G 将存储、数据可用性、计算和结算视为单一平台中协调运作的各个部分。这一选择塑造了整个架构。

这还具有更广泛的意义。在Web 2时代,人工智能变得高度集中化。模型和数据由少数几家公司控制。访问权限受到限制,审计也很少见。0G试图将人工智能推向更加开放、更像实用工具的模式。

在这种愿景下,数据归贡献者所有。模型可以公开存储和追踪。计算过程可以得到验证。访问权限由市场定价,而不是由单一平台控制。

这项计划雄心勃勃,但也充满风险。如果成功,0G 将成为众多人工智能应用的基础层。如果失败,它可能会变成一个复杂但需求不足的系统。

堆栈内部:0G 是如何构建的

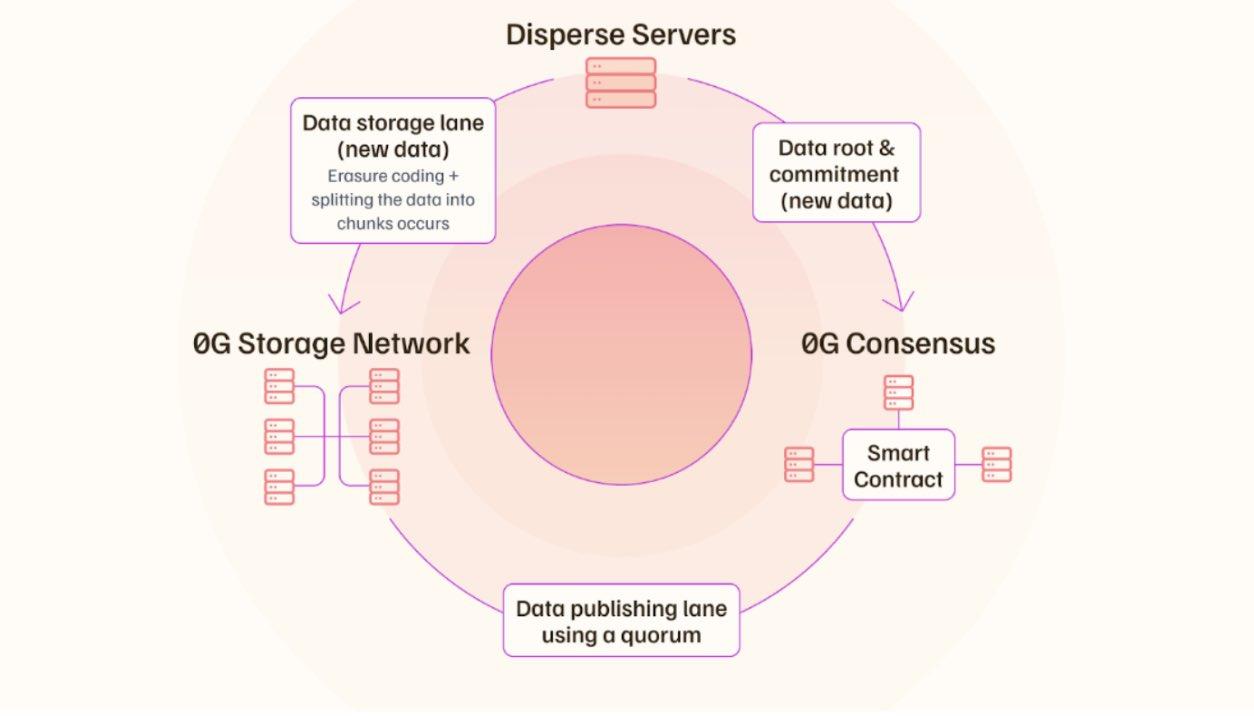

要了解 0G,了解数据在系统中的传输方式会有所帮助。

0G链作为协调层

0G Chain 作为协调和结算层,基于 CometBFT 构建,专注于高吞吐量和快速最终确认。同时,它与 EVM 保持兼容。

这种设计降低了开发者的门槛。现有的工具和智能合约可以几乎无缝地迁移。虽然这一层并非最具颠覆性的创新,但它却是维系整个系统运转的关键。

针对人工智能工作负载重新设计的存储

真正的区别体现在 0G 存储上。

大多数去中心化存储系统优先考虑长期持久性,因此通常会牺牲读取性能。而人工智能工作负载则恰恰相反,训练和推理依赖于快速且频繁的读取。

0G 存储采用双通道结构。一条通道承载哈希值、元数据和存储发生的证明,针对共识进行了优化。另一条通道处理大型文件,并允许数据在存储节点之间直接传输,而不会使链过载。

为了支持这种设计,0G引入了随机访问证明(Proof of Random Access,简称PoRA)。网络会随机向存储节点发出挑战,要求它们在短时间内返回小的数据片段。快速响应会获得奖励,而缓慢响应则会受到惩罚。这促使运营商采用高性能存储,而不是冷归档。

数据可用性与存储集成

在数据可用性层,0G 遵循与大多数 DA 网络不同的模型。

数据不再需要DA节点下载和传播完整的数据块,而是直接写入存储层。DA层专注于验证可用性证明和签名。因此,原本占用大量带宽的过程变成了验证任务。

如果这种方法能够大规模应用,它将显著提高系统的性能上限。人工智能规模的数据流不再受限于为Rollup事务构建的数据处理层。存储和数据处理将作为一个紧密集成的系统运行,而不是两个独立的组件。

可验证的计算和对齐节点

在计算方面,0G 通过去中心化市场将 GPU 供应与 AI 需求连接起来。然而,其重点不仅限于硬件租赁。该系统旨在验证任务是否正确执行。

0G 强调加密验证和使用可信执行环境,以降低出现错误结果或数据泄露的风险。

此外,AI对齐节点扮演着独特的角色。这些节点不生成模块,而是监控模型行为和输出模式,以检测异常或潜在的篡改行为。它们的目的是在系统层面引入持续的监控。

代币设计与市场现实

如此复杂的系统需要强有力的激励机制。验证节点、存储节点和计算服务提供商必须长时间保持在线并快速响应。

通货膨胀模型和代币角色

0G 采用类似于以太坊或Solana等网络的初始供应量和长期通胀机制。该代币用于支付交易费用、存储费用、节点奖励和参与治理。

从工程角度来看,这种设计有利于长期安全。从市场角度来看,它引入了一些重要的考量因素。

解封和融资压力

关键因素之一是解锁时间表。团队分配、早期支持者和节点相关分配会随着时间的推移增加供应量。除非在主要解锁窗口之前出现实际需求增长,否则这将造成供应压力。

另一个因素是包含代币购买承诺的融资结构。对于基金会而言,这提供了长期的资金稳定性。但对于二级市场而言,如果频繁使用,则可能导致持续的股权稀释预期。

核心不确定性

最重要的风险不是竞争,而是运营执行。

高吞吐量系统通常依赖于先进的硬件和数据中心。在早期阶段,这可能会带来一些不易察觉的中心化风险。如果关键服务严重依赖大型云服务提供商,则该系统会继承 Web2 式的信任假设。

过去的事件表明,即使规程保持不变,操作上的缺陷也会迅速损害人们的信心。

长期赌注

归根结底,0G 押注的是长期的变革。

如果人工智能代理成为数字交互的主流形式,对快速、低成本且可验证的数据和计算的需求将持续增长。在这种情况下,dAIOS 堆栈可能会演变为真正的平台层。

如果未来到来得更慢,或者开发者更喜欢可以轻松替换的模块化工具,那么 0G 必须证明深度集成能够带来足够的价值,以证明这种权衡是合理的。

这是一场目标明确但竞争激烈的竞赛。最终结果并非取决于承诺,而是取决于长期的持续使用和实际工作负载。

〈 0G 实验室与构建去中心化 AI 操作系统的竞赛〉 本文文章初步发布于《 CoinRank 》。