这项研究由MigaLabs完成。

执行摘要

本报告对以太坊在Fusaka硬分叉及后续仅包含Blob参数(BPO)更新后的blob吞吐量和网络稳定性进行了实证分析。该研究考察了长达数月的观察期内的blob分布模式、丢失槽相关性以及整体网络健康状况。

主要调查结果引发了重大担忧:

- 容量利用率不足:网络未达到目标数据块数量(14)。自 BPO1 以来,中位数实际上有所下降,而高数据块数量(16+)仍然极其罕见。

- 高斑点计数时的漏检率升高:16 个以上斑点时的漏检率在 0.77% 到 1.79% 之间,是 0-14 个斑点时的基线漏检率(~0.50%)的两倍多。

- 建议:在高数据块计数下的丢失率恢复正常,并且当前容量有明显需求之前,不应考虑进一步的 BPO 更新。

事件时间线

| 事件 | 日期 | 描述 |

|---|---|---|

| 数据收集开始 | 2025年10月1日 | 基线测量期开始 |

| 福萨卡硬叉 | 2025年12月3日 | Fusaka 发生硬分叉,没有 blob 参数变化 |

| BPO 最新动态#1 | 2025年12月9日 | 目标斑点数量从 6 个增加到 12 个,最大值从 9 个增加到 15 个。 |

| BPO 最新动态#2 | 2026年1月7日 | 目标斑点数量从 12 个增加到 14 个,最大值从 15 个增加到 21 个。 |

分析

每个插槽的斑点分布

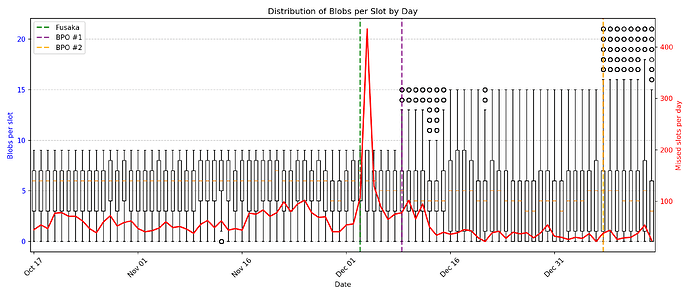

在整个观测期间,我们记录了每个观测时段内斑点数量的随时间变化情况,以及相应的缺失观测时段数据。图 1 以箱线图的形式展示了每个观测时段内斑点数量的每日分布情况,并在次坐标轴(90 天)上叠加了缺失观测时段的斑点数量。

图 1:箱线图显示了每个时隙的每日数据块分布(左轴)和每日丢失时隙数(右轴)。垂直虚线表示协议升级事件。

数据显示了一些值得注意的现象:

目标容量未达标:尽管提高了数据块限制,但网络容量仍未达到新的目标容量。自 BPO1 以来,数据块数量的中位数实际上有所下降,从每个时隙 6 个数据块降至每个时隙 4 个数据块。高数据块数量(16 个以上)极其罕见,在观察到的超过 75 万个时隙中,每次仅出现 165 至 259 次。

产能扩张与需求脱节:业务流程外包(BPO)的不断升级虽然提升了理论产能,但实际利用率并未相应提高。这引发了人们对进一步扩充产能必要性的质疑,因为目前的产能极限远未达到。

错过时段相关性分析

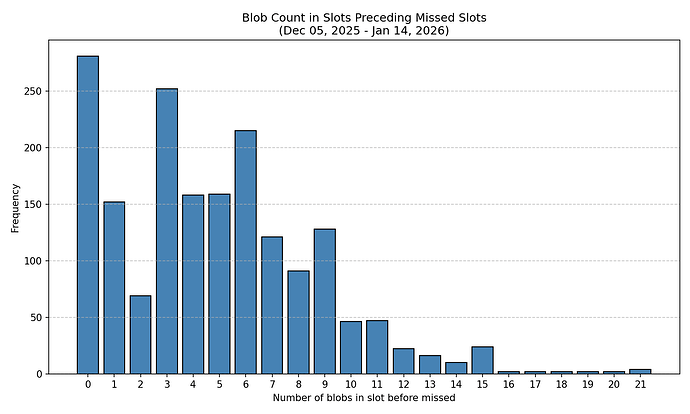

为了探究区块数量与后续缺失区块之间的潜在相关性,我们分析了自Fusaka硬分叉(40天)以来,不同区块数量区块之后缺失区块的频率。由于Fusaka硬分叉后的头两天缺失区块数量异常,因此我们排除了这两天的数据。

图 2:按前一个槽位中的 blob 数量分类的丢失块的绝对计数。

图 2 中的原始数据显示,在数据块数量为零或极少的时隙之后,丢块的发生率较高。然而,由于网络中数据块数量的分布并不均匀,因此需要对这一观察结果进行归一化处理。

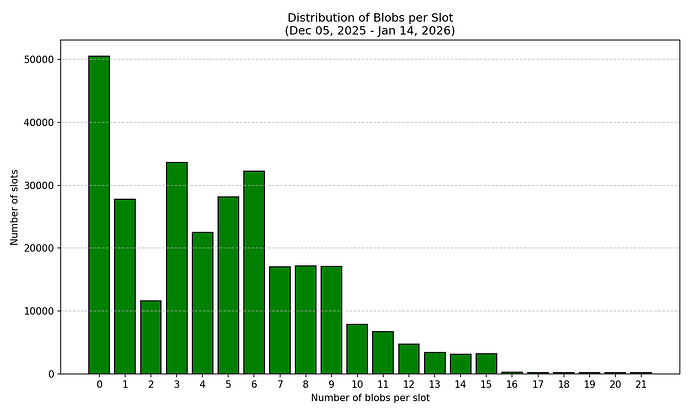

图 3:所有观察到的槽位中斑点计数的分布,表明不同斑点计数的频率不均匀。

为了准确评估漏检概率,我们使用以下公式计算了归一化漏检率:

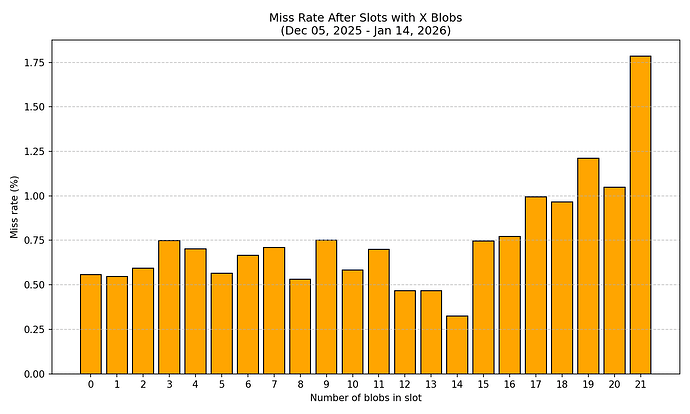

Missed blocks after slots with X blobsMiss Rate ( X ) = ——————————————————————————————————————————— × 100 Total slots with X blobs图 4:给定数量的块之后,丢失块的概率。

标准化分析揭示了一些令人担忧的模式:

- 基线漏检率(0-15 个斑点) :在不同斑点数量下,漏检率在 0.32% 到 1.03% 之间,平均值约为 0.5%。

- 当数据块数量超过 16 个时,丢包率显著升高:丢包率急剧上升,范围从 0.77% 到 1.79%。当数据块数量达到 21 个时,丢包率高达 1.79%,是数据块数量较少时平均丢包率(约 0.5%)的三倍多。这表明,在处理大量数据块时,网络可靠性出现了令人担忧的下降。

按斑点数量划分的连续错过槽位(10 个以上斑点)

| 斑点计数 | 总槽位数 | 错过的比赛 | 漏诊率(%) |

|---|---|---|---|

| 10 | 7880 | 46 | 0.58 |

| 11 | 6723 | 47 | 0.70 |

| 12 | 4717 | 22 | 0.47 |

| 13 | 3431 | 16 | 0.47 |

| 14 | 3088 | 10 | 0.32 |

| 15 | 3213 | 24 | 0.75 |

| 16 | 259 | 2 | 0.77 |

| 17 | 201 | 2 | 1.00 |

| 18 | 207 | 2 | 0.97 |

| 19 | 165 | 2 | 1.21 |

| 20 | 191 | 2 | 1.05 |

| 21 | 224 | 4 | 1.79 |

统计学考量

高 blob 数量(16+)的数据集仍然有限,每个 blob 数量的样本量仅为 165 至 259 个槽位,而低 blob 数量的样本量则高达数万个槽位。然而,所有高 blob 数量(16-21)的缺失率均持续偏高,这一现象令人担忧。即使样本量有限,趋势依然清晰:更高的 blob 数量与更高的缺失率相关。如果随着需求的增加,这些偏高的缺失率持续存在或进一步恶化,网络稳定性可能会受到严重威胁。

结论

容量未得到充分利用:网络尚未达到新的目标容量。自 BPO1 以来,中位数据块数量有所下降,高数据块数量(16+)仍然极其罕见。没有证据表明存在足以证明进一步增加容量的需求压力。

高数据块数量下的丢失率令人担忧:包含 16 个或更多数据块的槽位丢失率高达 0.77% 至 1.79%,相比 12 至 14 个数据块时观察到的 0.32% 至 0.47% 的基线水平,显著升高。这种现象表明网络基础设施难以可靠地处理高数据块数量。

网络不稳定风险:如果需求增加,高数据块数量变得更加普遍,当前较高的丢包率可能会加剧并威胁网络稳定性。数据显示,该网络尚未做好在高数据块数量下持续运行的准备。

在系统稳定之前,不再进行任何 BPO 更新:在以下情况发生之前,不应考虑进一步增加 blob 容量:

- 当斑点数量较高(16个以上)时,漏检率会恢复到基线水平(约0.5%或以下)。

- 已有证据表明,市场需求能够充分利用现有产能。

需要持续监控:在进行任何更改之前,应观察网络在当前容量限制下的运行情况。过早提升容量会增加网络崩溃的风险,因为如果底层基础设施无法可靠地支持,L2 协议可能会开始使用扩展后的容量。

方法论

本研究由 MigaLabs 使用此代码进行。