AI时代核心资产是记忆和抽象思维

折腾了一段时间,终于把"本地记忆 + 云端 LLM"的架构跑通了

核心思路:

记忆是核心资产,不能全给云端。

输入 → 本地记忆(完整) → 过滤层 → 云端 LLM → 审计 → 输出

我的做法分几层:

1. 本地存完整记忆* — Markdown 文件 + 本地向量数据库

- 什么都记,不做过滤

- 这是"真实的我"

2. 云端只拿过滤后的上下文

- 敏感信息单独存,不进 LLM 上下文

-输出审计 — 发送前过一遍检查

👌

把这段提示词丢给ai。

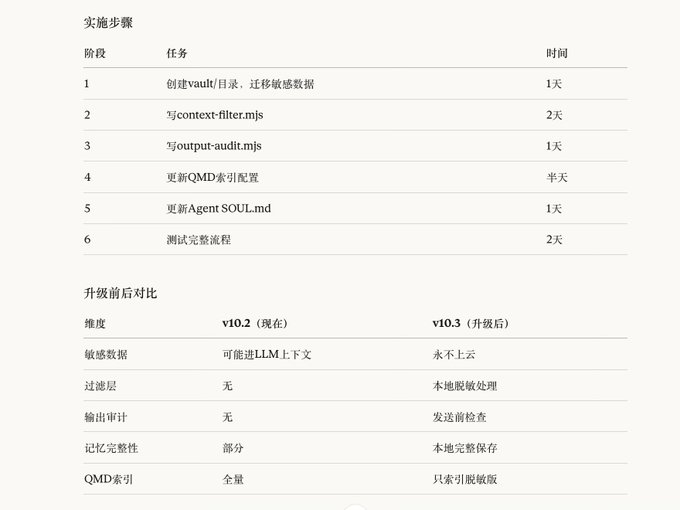

执行升级:本地记忆 + 过滤层架构

核心原则:记忆是核心资产,敏感信息永不上云。

== 安全规则(最高优先级) ==

1. 每一步改完都要测试,确认系统正常再进行下一步

2. 不要同时改多个东西

3. 改配置前先备份:cp openclaw.json openclaw.json.bak

4. x.com/bitfish/status…

感觉未来苹果这类终端厂商,会把本地LLM边缘计算模式 也跑通。。

来自推特

免责声明:以上内容仅为作者观点,不代表Followin的任何立场,不构成与Followin相关的任何投资建议。

喜欢

收藏

评论

分享