整理:有新

6 月 2 日晚,英偉達 CEO 黃仁勳在臺北 ComputeX 2024 大會上展示了英偉達在加速計算和生成式 AI 領域的最新成果,還描繪了未來計算和機器人技術的發展藍圖。

這場演講涵蓋了從 AI 基礎技術到未來機器人和生成式 AI 在各個行業的應用,全面展示了英偉達在推動計算技術變革方面的卓越成就。

黃仁勳表示,英偉達位於計算機圖形、模擬和 AI 的交匯處,這是英偉達的靈魂。今天展示給我們的一切都是模擬的,它是數學、科學、計算機科學、令人驚歎的計算機架構的結合。這些都不是動畫,而是自制的,英偉達把它全部融入了 Omniverse 虛擬世界。

加速計算與 AI

黃仁勳表示,我們所看到的一切的基礎是兩項基本技術,加速計算和在 Omniverse 內部運行的 AI,這兩股計算的基本力量,將重新塑造計算機行業。計算機行業已有 60 年的歷史。在很多方面,今天所做的一切都是在 1964 年黃仁勳出生後一年發明的。

IBM System 360 引入了中央處理單元、通用計算、通過操作系統實現硬件和軟件的分離、多任務處理、IO 子系統、DMA 以及今天使用的各種技術。架構兼容性、向後兼容性、系列兼容性,所有今天對計算機瞭解的東西,大部分在 1964 年就已經描述出來了。當然,PC 革命使計算民主化,把它放在了每個人的手中和家中。

2007 年,iPhone 引入了移動計算,把計算機放進了我們的口袋。從那時起,一切都在連接並隨時運行通過移動雲。這 60 年來,我們只見證了兩三次,確實不多,其實就兩三次,主要的技術變革,計算的兩三次構造轉變,而我們即將再次見證這一切的發生。

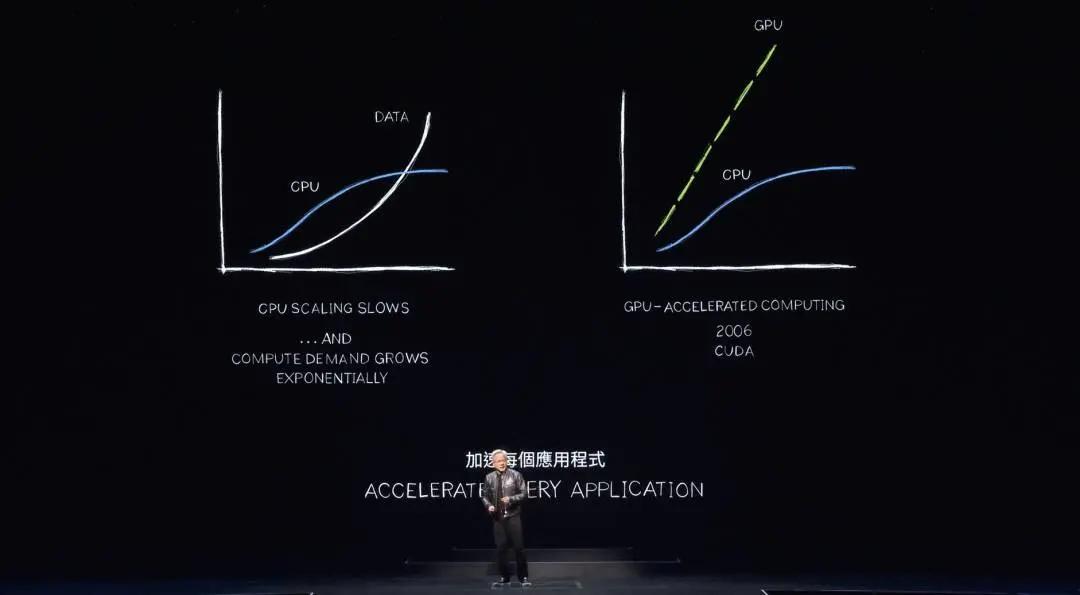

有兩件基本的事情正在發生。首先是處理器,即計算機行業運行的引擎,中央處理單元的性能提升顯著放緩。然而,我們需要進行的計算量仍然在迅速增長,呈指數級增長。如果處理需求,數據需要處理的量繼續指數級增長但性能沒有,計算通貨膨脹將會發生。事實上,現在就看到了這一點。全球數據中心使用的電力量正在大幅增長。計算成本也在增長。我們正在經歷計算通貨膨脹。

當然,這種情況不能繼續下去。數據量將繼續以指數級增長,而 CPU 性能提升將永遠不會恢復。我們有更好的方法。近二十年來,英偉達一直在研究加速計算。CUDA 增強了 CPU,卸載並加速了專用處理器可以更好完成的工作。事實上,性能非常出色,現在很明顯,隨著 CPU 性能提升放緩並最終顯著停止,應該加速一切。

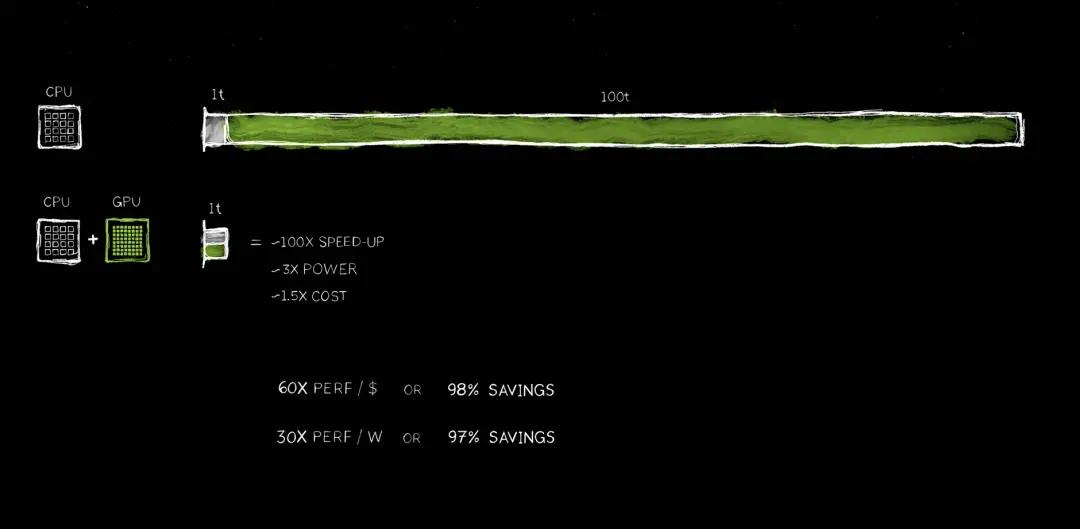

黃仁勳預測,所有需要大量處理的應用程序都會被加速,當然每個數據中心在不久的將來都會被加速。現在加速計算是非常合理的。如果你看看一個應用程序,這裡 100t 代表 100 單位時間,它可能是 100 秒,也可能是 100 小時。在很多情況下,如你所知,現在正在研究運行 100 天的 AI 應用程序。

1T 代碼是指需要順序處理的代碼,其中單線程 CPU 是非常關鍵的。操作系統控制邏輯非常重要,需要一條指令接著一條指令地執行。然而,有很多算法,比如計算機圖形處理,可以完全並行操作。計算機圖形處理、圖像處理、物理模擬、組合優化、圖處理、數據庫處理,當然還有深度學習中非常著名的線性代數,這些算法都非常適合通過並行處理來加速。

因此,發明了一種架構,通過在 CPU 上添加 GPU 來實現。專用處理器可以將耗時很長的任務加速到極快的速度。因為這兩個處理器可以並肩工作,它們都是自主的,獨立的,可以將原本需要 100 個時間單位的任務加速到 1 個時間單位,速度的提升是難以置信的,效果非常顯著,速度提升了 100 倍,但功耗只增加了大約三倍,成本只增加了約 50%。在 PC 行業一直這樣做,英偉達在 1000 美元 PC 上加一個 500 美元 GeForce GPU,性能會大幅提升。英偉達在數據中心也這樣做,一個價值十億美元的數據中心,加上 5 億美元的 GPU,突然間它就變成了一個 AI 工廠,這種情況正在全球各地發生。

節省的成本非常驚人。每花一美元就能獲得 60 倍的性能提升,速度提升了 100 倍,而功耗只增加了三倍,成本只增加了 1.5 倍。這種節省是難以置信的。節省的成本可以用美元來衡量。

很明顯,許多公司在雲端處理數據上花費了數億美元。如果這些過程被加速,不難想象可以節省數億美元。這是因為在通用計算上已經經歷了很長時間的通貨膨脹。

現在終於決定加速計算,有大量被捕獲的損失可以現在回收,許多被保留的浪費可以從系統中釋放出來。這將轉化為金錢的節省和能源的節省,這也是為什麼黃仁勳常說「買得越多,省得越多」。

黃仁勳還表示,加速計算確實帶來了非凡的成果,但它並不容易。為什麼它能省這麼多錢,但這麼長時間以來人們卻沒有這樣做呢?原因是因為這非常難。沒有一種軟件可以通過 C 編譯器運行,突然間應用程序就快了 100 倍。這甚至不合邏輯。如果可以做到這一點,他們早就改造 CPU 了。

事實上,必須重寫軟件,這是最難的部分。軟件必須完全重寫,以便能夠重新表達在 CPU 上編寫的算法,使其能夠被加速、卸載並行運行。這種計算機科學的練習極其困難。

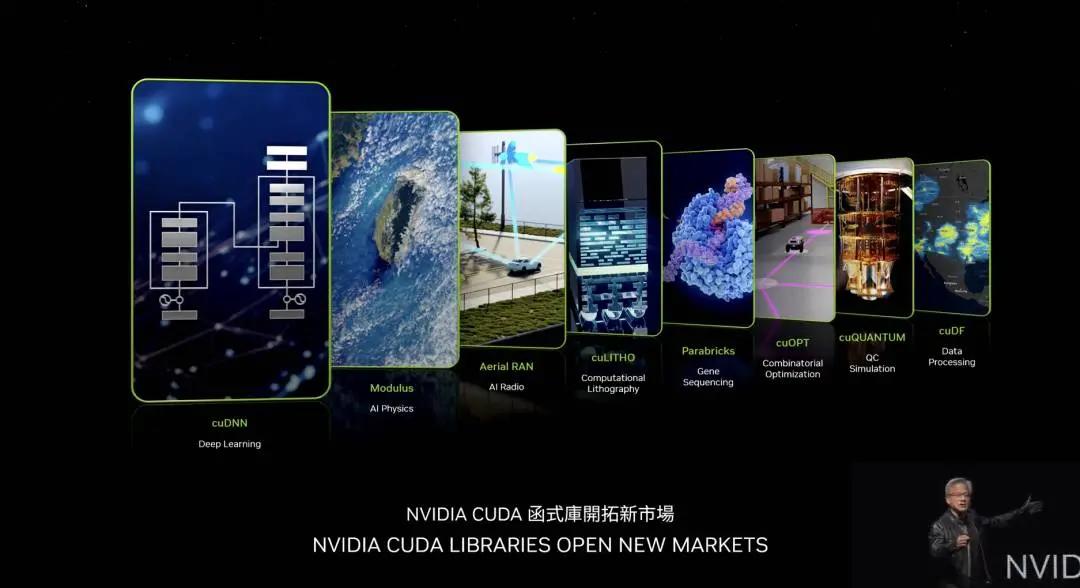

黃仁勳表示,在過去 20 年裡,英偉達讓全世界變得更容易。當然,非常著名 cuDNN,即處理神經網絡的深度學習庫。英偉達有一個 AI 物理庫,可以用於流體動力學和許多其他應用中,神經網絡必須遵守物理定律。英偉達有一個叫 Arial Ran 新的偉大庫,它是一個 CUDA 加速 5G 無線電,能夠像定義世界網絡互聯網一樣定義和加速電信網絡。加速的能力使我們能夠將所有的電信轉變為與雲計算平臺相同類型的平臺。

cuLITHO 是一個計算光刻平臺,能夠處理芯片製造中最計算密集的部分——製作掩膜。臺積電正在使用 cuLITHO 進行生產,節省了大量的能源和金錢。臺積電的目標是加速他們的堆棧,以便為進一步的算法和更深入、更窄的晶體管的計算做好準備。Parabricks 是英偉達基因測序庫,它是世界上吞吐量最高的基因測序庫。cuOpt 是一個用於組合優化、路線規劃優化的令人難以置信的庫,用於解決旅行商問題,非常複雜。

科學家們普遍認為需要量子計算機來解決這個問題。英偉達創造了一個在加速計算上運行的算法,運行速度極快,創下了 23 項世界紀錄。cuQuantum 是一個量子計算機的模擬系統。如果你想設計一個量子計算機,你需要一個模擬器。如果你想設計量子算法,你需要一個量子模擬器。如果量子計算機不存在,你如何設計這些量子計算機,創建這些量子算法呢?你使用今天世界上最快的計算機,當然就是 NVIDIA CUDA。在上面,英偉達有一個模擬器,可以模擬量子計算機。它被全世界數十萬研究人員使用,並集成到所有領先的量子計算框架中,廣泛用於科學超級計算中心。

cuDF 是一個令人難以置信的數據處理庫。數據處理消耗了今天雲端支出的絕大部分,所有這些都應該被加速。cuDF 加速了世界上使用的主要庫,比如 Spark,許多公司可能都在使用 Spark,Pandas,一個新的叫做 Polars 的庫,當然還有 NetworkX,一個圖處理數據庫庫。這些只是一些例子,還有很多其他的。

黃仁勳表示,英偉達必須創建這些庫,以便讓生態系統能夠利用加速計算。如果英偉達沒有創建 cuDNN,光有 CUDA 是不可能讓全世界的深度學習科學家使用的,因為 CUDA、TensorFlow 和 PyTorch 中使用的算法之間的距離太遠了。這幾乎像是在沒有 OpenGL 情況下做計算機圖形處理,或者沒有 SQL 的情況下進行數據處理。這些特定領域的庫是英偉達的珍寶,總共有 350 個庫。正是這些庫使英偉達能夠打開如此多的市場。

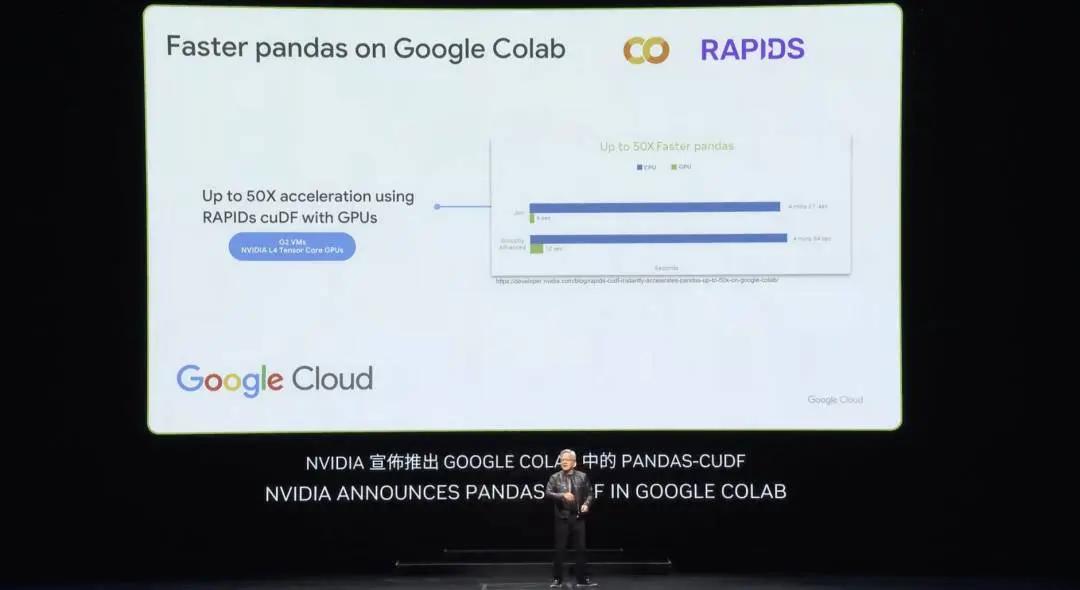

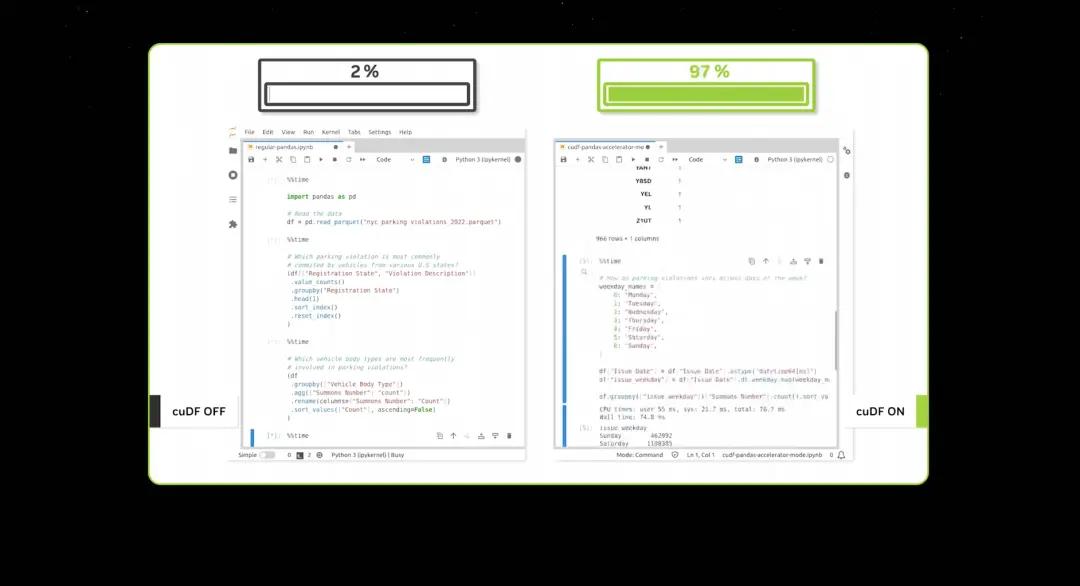

上週,Google 宣佈在雲端加速 Pandas,這是世界上最流行的數據科學庫。你們中的許多人可能已經在使用 Pandas,它被全球 1000 萬數據科學家使用,每月下載 1.7 億次。它是數據科學家的電子表格。現在,只需點擊一下,你就可以在 Google 雲數據中心平臺 Colab 中使用由 cuDF 加速 Pandas,加速效果真的非常驚人。

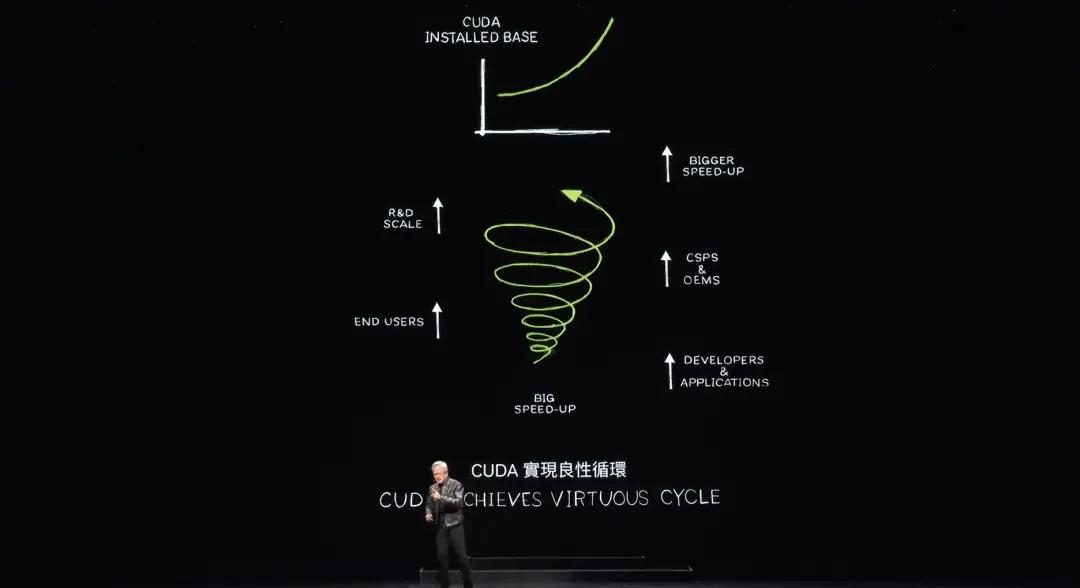

當你將數據處理加速到如此快的速度時,演示確實不會花很長時間。現在 CUDA 已經達到了人們所說的臨界點,但它甚至更好。CUDA 現在已經實現了一個良性循環。

這種情況很少發生。如果你看看歷史上所有計算架構的平臺。以微處理器 CPU 為例,它已經存在了 60 年,並且在這個層面上沒有發生變化。這種計算方式,加速計算已經存在,創建一個新平臺極其困難,因為這是一個先有雞還是先有蛋的問題。

如果沒有開發人員使用你的平臺,那麼當然也就不會有用戶。但是如果沒有用戶,就沒有安裝基礎。如果沒有安裝基礎,開發人員就不會對它感興趣。開發人員希望為大型安裝基礎編寫軟件,但大型安裝基礎需要大量應用程序來吸引用戶創建安裝基礎。

這種先有雞還是先有蛋的問題很少被打破。而英偉達花了 20 年的時間,一個領域的庫接著一個領域的庫,一個加速庫接著一個加速庫,現在有 500 萬開發人員在全球範圍內使用英偉達的平臺。

英偉達服務於每一個行業,從醫療保健、金融服務、計算機行業、汽車行業,幾乎所有主要行業,幾乎所有科學領域,因為英偉達的架構有這麼多客戶,OEM 廠商和雲服務提供商對構建英偉達的系統感興趣。像臺灣這裡的系統製造商這樣的優秀系統製造商對構建英偉達的系統感興趣,這使得市場上有更多的系統可供選擇,這當然為我們創造了更大的機會,使我們能夠擴大規模,研發規模,從而進一步加速應用。

每次加速應用,計算成本就會下降。100 倍加速轉化為 97%、96%、98% 節省。因此,當我們從 100 倍加速到 200 倍加速,再到 1000 倍加速時,計算的邊際成本繼續下降。

英偉達相信,通過大幅降低計算成本,市場、開發人員、科學家、發明家將繼續發現越來越多的算法,這些算法消耗越來越多的計算資源,最終會發生質的飛躍,計算的邊際成本如此之低,以至於一種新的計算使用方式出現了。

事實上,這正是現在看到的情況。多年來,英偉達在過去 10 年裡將某種特定算法的邊際計算成本降低了百萬倍。因此,現在訓練包含整個互聯網數據的 LLM 是非常合理和常識的,沒有人會懷疑。這個想法,即你可以創建一個能夠處理如此多數據的計算機來編寫自己的軟件。AI 的出現是因為完全相信,如果讓計算變得越來越便宜,總會有人找到一個偉大的用途。

如今,CUDA 已經實現了良性循環。安裝基礎在增長,計算成本在下降,這導致更多的開發人員提出更多的想法,從而推動更多的需求。現在我們正處在一個非常重要的起點。

黃仁勳接著提到了地球 2 的想法,將創建地球的數字孿生體,通過模擬地球,可以更好地預測未來,從而更好地避免災害,更好地理解氣候變化的影響,以便更好地適應。

研究人員在 2012 年發現了 CUDA,那是英偉達與 AI 第一次接觸,這是一個非常重要的日子。有幸與科學家合作,使深度學習成為可能。

AlexNet 取得了巨大的計算機視覺突破。但更重要的是,退一步理解深度學習的背景、基礎以及其長期影響和潛力。英偉達意識到這項技術具有巨大的擴展潛力。一種幾十年前發明和發現的算法,突然之間,因為更多的數據、更大的網絡以及非常重要的更多計算資源,深度學習實現了人類算法無法實現的成就。

現在想象一下,如果進一步擴展架構,更大的網絡、更多的數據和更多的計算資源,可能會實現什麼。2012 年之後,英偉達改變了 GPU 的架構,增加了 Tensor 核心。英偉達發明了 NVLink,那是 10 年前的事了,CUDA,然後是 TensorRT、NCCL,收購了 Mellanox、TensorRT-ML、Triton 推理服務器,所有這些都整合在一臺全新的計算機上。沒有人理解,沒有人要求,沒有人理解它的意義。

事實上,黃仁勳確信沒有人想買它,英偉達在 GTC 上宣佈了它,OpenAI,一個位於舊金山的小公司,請求英偉達為他們提供一臺。

2016 年,黃仁勳向 OpenAI 交付了第一臺 DGX,世界上第一臺 AI 超級計算機。之後,繼續擴展,從一臺 AI 超級計算機,一臺 AI 設備,擴展到大型超級計算機,甚至更大。

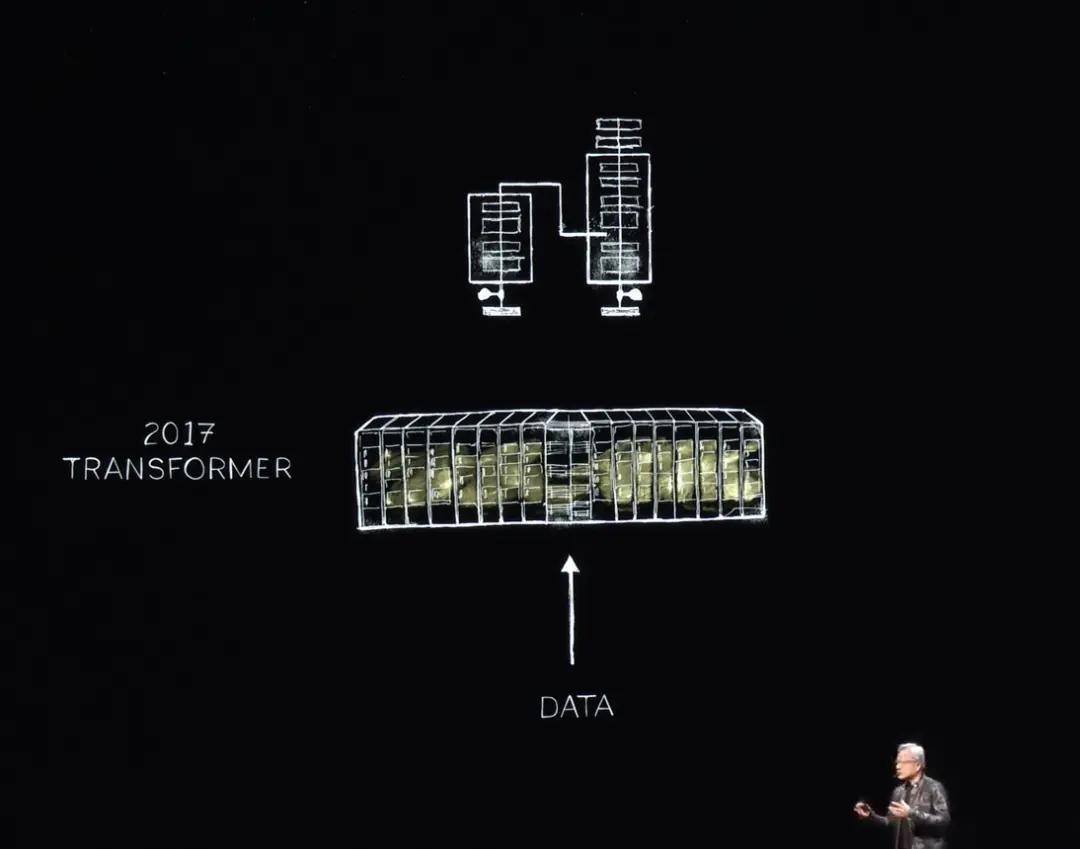

到 2017 年,世界發現了 Transformer,使能夠訓練大量數據,識別和學習長期序列模式。現在,英偉達可以訓練這些 LLM,理解並在自然語言理解方面取得突破。繼續前進,建造了更大的系統。

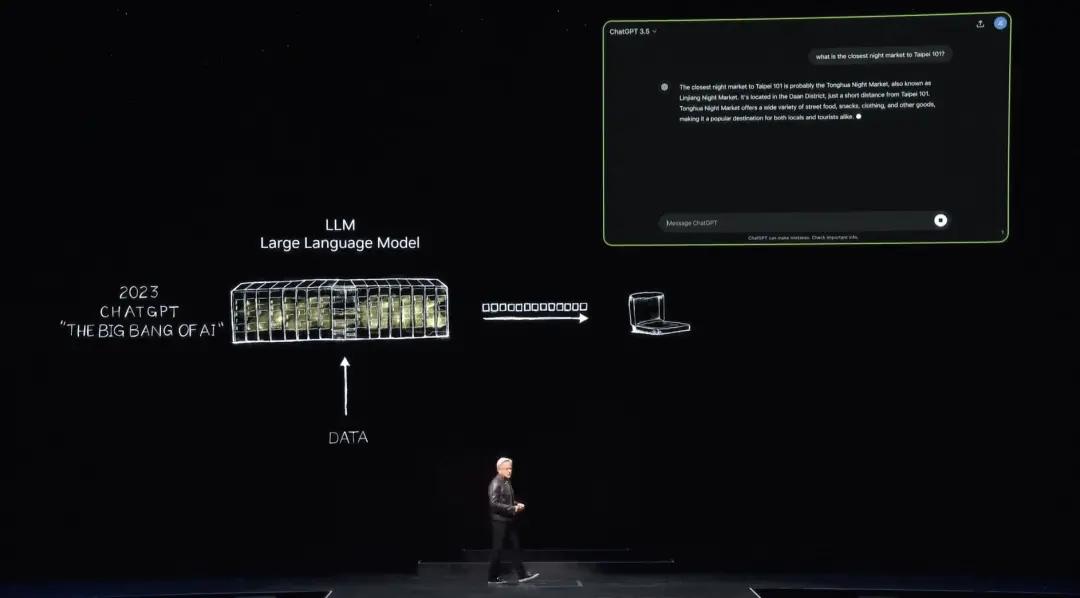

然後在 2022 年 11 月,使用成千上萬英偉達 GPU 和非常大的 AI 超級計算機進行訓練,OpenAI 發佈了 ChatGPT,五天內用戶達到一百萬,兩個月內達到一億,成為歷史上增長最快的應用。

在 ChatGPT 向世界展示之前,AI 一直是關於感知,自然語言理解、計算機視覺、語音識別。這一切都是關於感知和檢測的。這是第一次,世界解決了生成式 AI,逐個生成 token,而這些 token 是單詞。當然,有些 token 現在可以是圖像、圖表、表格、歌曲、單詞、語音、視頻。這些 token 可以是任何你能理解其意義的東西,它們可以是化學品的 token ,蛋白質的 token ,基因的 token 。你們之前在地球 2 項目中看到的,生成的是天氣的 token 。

我們可以理解,我們可以學習物理。如果你能學習物理,你可以教 AI 模型物理。AI 模型可以學習物理的意義,然後可以生成物理。我們將其縮小到 1 公里,不是通過過濾,而是生成。所以我們可以用這種方法生成幾乎任何有價值的 token 。我們可以為汽車生成方向盤控制,為機器人手臂生成動作。我們可以學習的一切,現在都可以生成。

AI 工廠

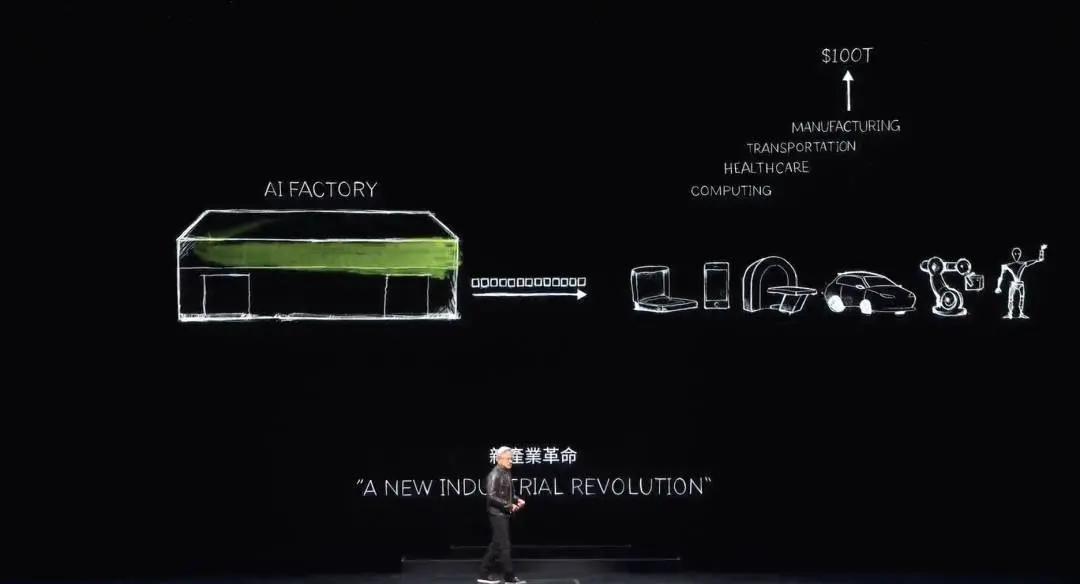

我們現在已經進入了生成式 AI 時代。但是,真正重要的是,這臺最初作為超級計算機的計算機現在已經演變成了一個數據中心,它只生成一種東西,那就是 token ,它是一個 AI 工廠,這家 AI 工廠正在生成、創造和生產一種極具價值的新商品。

19 世紀 90 年代末,尼古拉·特斯拉發明了交流發電機,而英偉達發明了 AI 生成器。交流發電機生成電子,英偉達 AI 生成器生成 token,這兩種東西在市場上都有巨大的機會,在幾乎每個行業中都是完全可以替代的,這也是為什麼這是一次新的工業革命。

英偉達現在有一個新的工廠,為每個行業生產一種新的商品,這種商品具有非凡的價值。這種方法具有高度的可擴展性,並且這種方法的可重複性也非常高。

注意到每天都有這麼多不同的生成式 AI 模型被髮明出來。每個行業現在都在湧入。第一次,價值 3 萬億美元 IT 行業,正在創造一些可以直接服務於 100 萬億美元產業的東西。不再只是信息存儲或數據處理的工具,而是一個為每個行業生成智能的工廠。這將成為一個製造業產業,但不是計算機制造業,而是使用計算機進行製造業。

這在歷史上從未發生過。加速計算帶來了 AI,帶來了生成式 AI,現在帶來了工業革命。對行業的影響也非常顯著,可以為許多行業創造一種新商品,一種新的產品,稱之為 token ,但對我們自己的行業的影響也非常深遠。

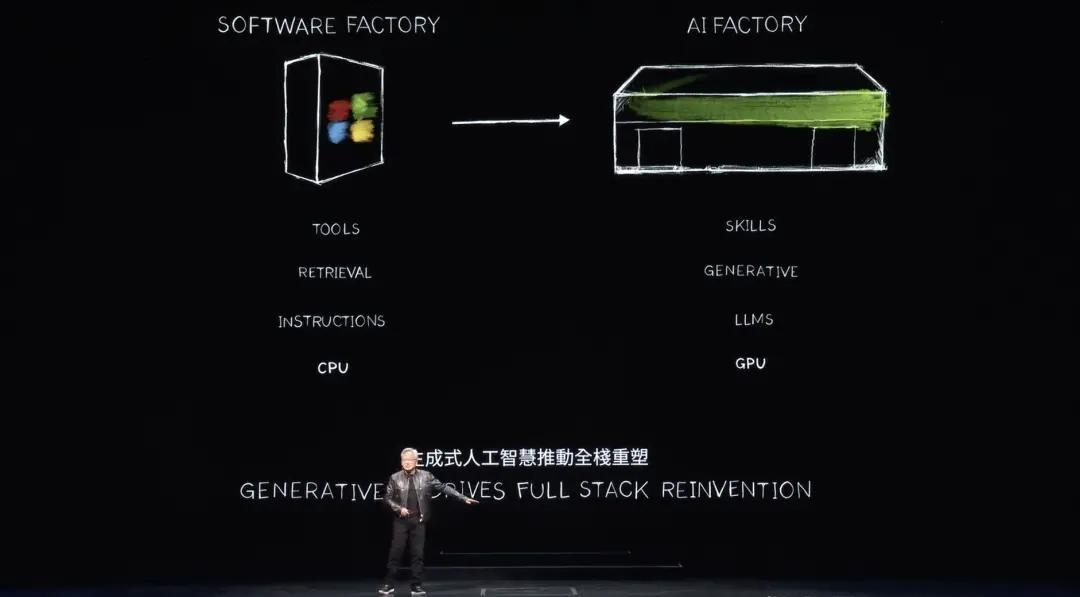

60 年來,計算的每一層都發生了變化,從 CPU 通用計算到加速 GPU 計算,計算機需要指令。現在計算機處理 LLM,AI 模型。而過去的計算模型是基於檢索的。幾乎每次你觸摸手機時,都會為你檢索一些預錄文本、圖像或視頻,並基於推薦系統重新組合並呈現給你。

黃仁勳表示,未來計算機將盡可能多地生成數據,只檢索必要的信息。原因是生成的數據需要更少的能量去獲取信息。生成的數據也更具上下文相關性。它將編碼知識,理解你。你不再是讓計算機獲取信息或文件,而是讓它直接回答你的問題。計算機將不再是我們使用的工具,而是生成技能,執行任務。

NIMs,英偉達推理微服務

而不是一個生產軟件的行業,這在 90 年代初是一個革命性的想法。記得微軟創造的軟件包裝的想法革命化了 PC 行業。沒有包裝軟件,我們會用 PC 做什麼?它驅動了這個行業,現在英偉達有一個新的工廠,一個新的計算機。我們將在其上運行一種新的軟件,稱之為 NIMs,英偉達推理微服務。

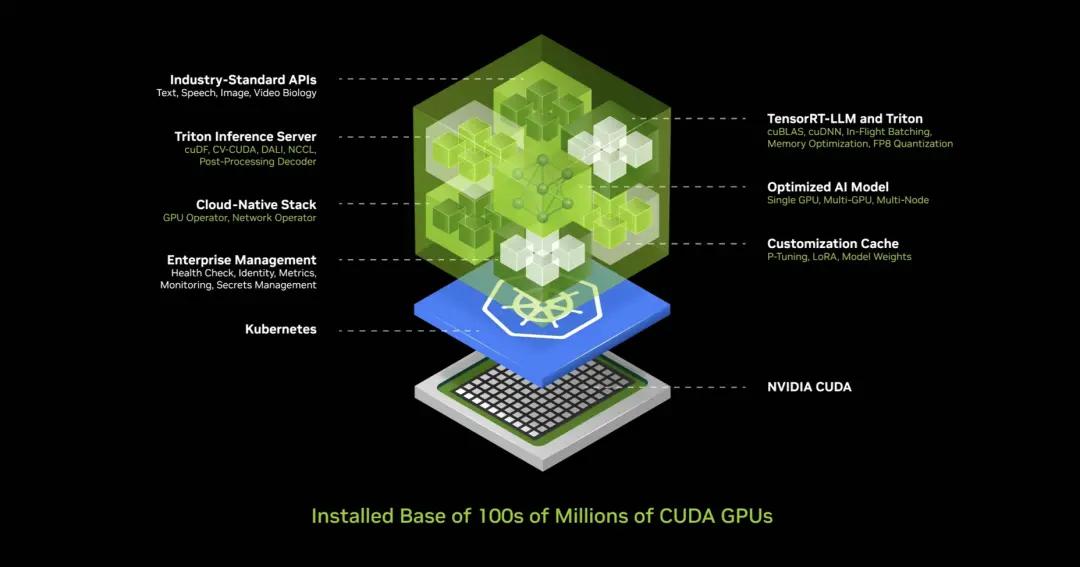

NIM 在這個工廠內部運行,這個 NIM 是一個預訓練模型,它是一個 AI。這個 AI 本身非常複雜,但運行 AI 的計算堆棧是極其複雜的。當你使用 ChatGPT 時,其背後的堆棧是大量的軟件。其背後的提示符是大量的軟件,極其複雜,因為模型龐大,有數十億到數萬億的參數。它不僅在一臺計算機上運行,而是在多臺計算機上運行。它必須在多個 GPU 之間分配工作負載,使用張量並行、流水線並行、數據並行、各種並行性、專家並行性等各種並行性,在多個 GPU 之間分配工作負載,儘可能快速地處理它。

因為如果你在一個工廠裡運行,你的吞吐量直接與收入相關。你的吞吐量直接與服務質量相關,你的吞吐量直接與能使用你服務的人數相關。

我們現在處於一個數據中心吞吐量利用率至關重要的世界。在過去這很重要,但沒有現在重要。在過去這很重要,但人們不測量它。今天,每一個參數都被測量,啟動時間、運行時間、利用率、吞吐量、空閒時間等,因為這是一個工廠。當某物是一個工廠時,其操作直接與公司的財務表現相關,這對大多數公司來說極其複雜。

所以英偉達做了什麼?英偉達創建了這個 AI 盒子,這個容器裡裝滿了大量的軟件,這個容器內部包括 CUDA、cuDNN、TensorRT、Triton 推理服務。它是雲原生的,可以在 Kubernetes 環境中自動擴展,它有管理服務和鉤子,可以監控你的 AI。它有通用 API,標準 API,你可以與這個盒子聊天。下載這個 NIM,可以與它聊天,只要你的計算機上有 CUDA,它現在當然是無處不在的。它在每一個雲中可用,來自每一個計算機制造商。它在數億臺 PC 上可用,所有的軟件都整合在一起,400 個依賴項都整合在一個裡面。

英偉達測試了這個 NIM,每一個預訓練模型都在整個安裝基礎上測試,所有不同版本的 Pascal、Ampere 和 Hopper,以及各種不同的版本。我甚至忘記了一些名字。令人難以置信的發明,這是我最喜歡的之一。

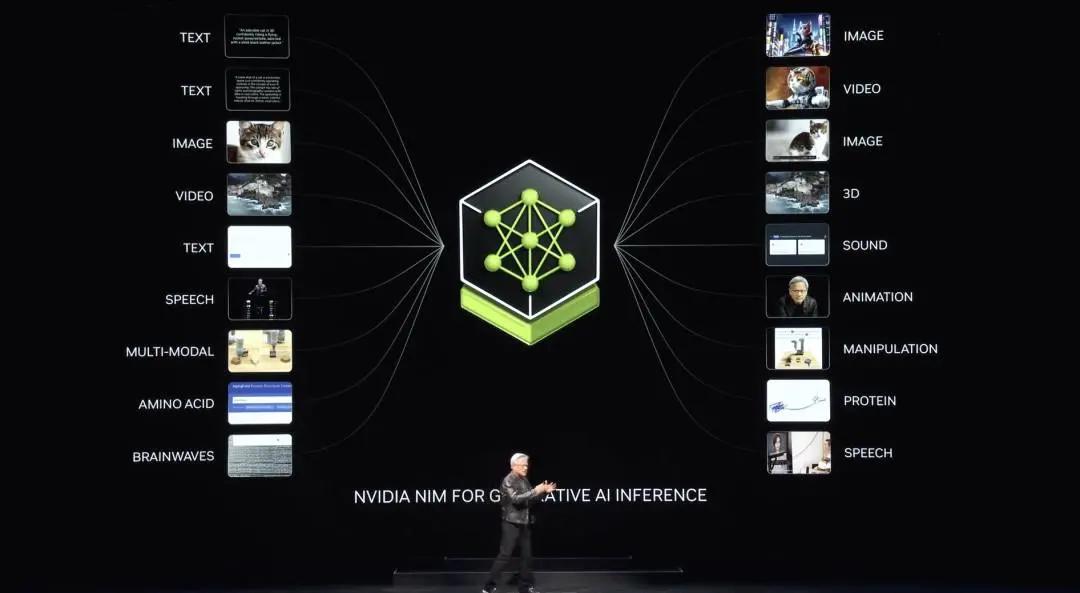

黃仁勳表示,英偉達有所有這些不同版本,無論是基於語言的還是基於視覺的,還是基於圖像的,或者用於醫療保健、數字生物學的版本,有數字人類的版本,只需訪問 ai.nvidia.com。

黃仁勳還表示,今天英偉達剛剛在 HuggingFace 上發佈了完全優化的 Llama3 NIM,它在那裡可以供你嘗試,你甚至可以帶走它。它免費提供給你。你可以在雲中運行它,在任何雲中運行。你可以下載這個容器,將其放入你自己的數據中心,並可以使其可用於你的客戶。

英偉達有各種不同領域的版本,物理學,一些用於語義檢索,稱為 RAGs,視覺語言,各種不同的語言。你使用它們的方法是將這些微服務連接到大型應用程序中。

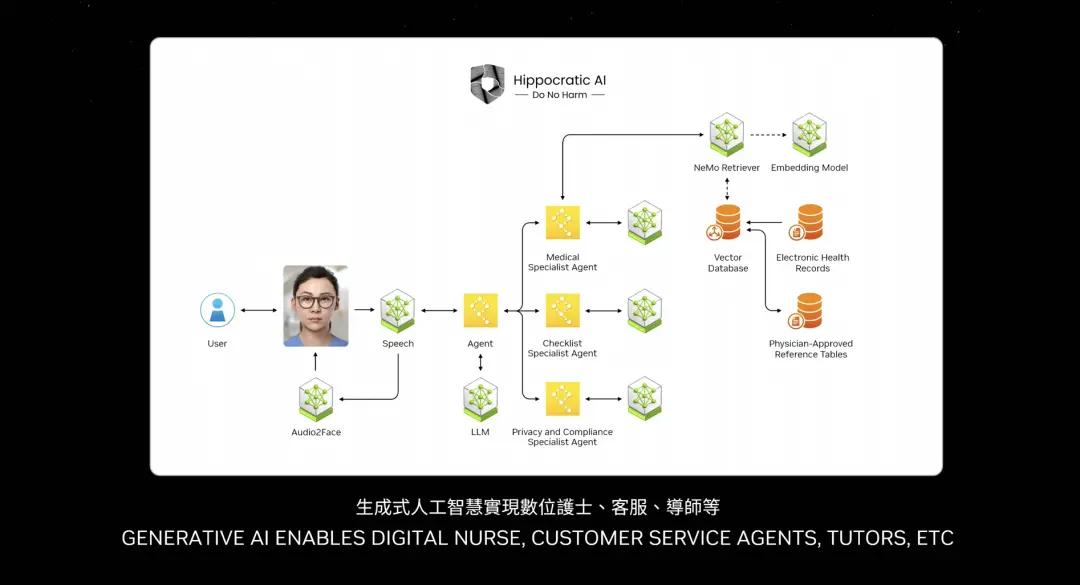

未來最重要的應用之一當然是客戶服務。幾乎每個行業都需要 Agent。這代表了數萬億美元的客戶服務。護士在某些方面也是客戶服務 Agent,一些非處方或非診斷性的護士基本上是零售業的客戶服務,快速服務食品、金融服務、保險業。數以千萬計的客戶服務現在可以通過語言模型和 AI 增強。因此你看到的這些盒子基本上就是 NIMs。

一些 NIM 是推理 Agent,給出任務,確定任務,分解成計劃。一些 NIM 檢索信息。一些 NIM 可能會進行搜索。一些 NIM 可能會使用工具,比如黃仁勳之前提到的 cuOpt。它可以使用在 SAP 上運行的工具。因此它必須學習一種叫做 ABAP 的特定語言。也許一些 NIM 必須進行 SQL 查詢。因此,所有這些 NIM 都是專家,現在被組裝成一個團隊。

所以發生了什麼變化?應用層發生了變化。過去用指令編寫的應用程序,現在是組裝 AI 團隊的應用程序。很少有人知道如何編寫程序,但幾乎每個人都知道如何分解問題並組裝團隊。我相信未來每家公司都會有大量 NIM 集合。你會下載你想要的專家,將它們連接成一個團隊,你甚至不必確切知道如何連接它們。你只需將任務交給一個 Agent,一個 NIM,讓它確定如何分配任務。那個團隊領導 Agent 將會分解任務並分配給各個團隊成員。團隊成員會執行任務,將結果返回給團隊領導,團隊領導會對結果進行推理並將信息呈現給你,就像人類一樣,這是不久的未來,應用的未來形態。

當然,可以通過文本提示和語音提示與這些大型 AI 服務互動。然而,有許多應用程序希望與人類形式互動。英偉達稱之為數字人類,並一直在研究數字人類技術。

黃仁勳繼續介紹,數字人類有可能成為與你互動的偉大 Agent,使互動更加引人入勝,更有同情心。當然,我們必須跨越這個巨大的現實鴻溝,使數字人類顯得更加自然。想象一下未來,計算機能夠像人類一樣與我們互動。這就是數字人類的驚人現實。數字人類將徹底改變從客戶服務到廣告和遊戲的各個行業。數字人類的可能性是無窮無盡的。

使用你當前廚房的掃描數據。通過你的手機,它們將成為 AI 室內設計師,幫助生成美麗的照片級建議,並提供材料和傢俱的來源。

英偉達已經為你生成了幾種設計選項可供選擇。它們還將成為 AI 客戶服務 Agent,使互動更加生動和個性化,或數字醫療工作者,檢查病人,提供及時和個性化的護理,它們甚至會成為 AI 品牌大使,設定下一波市場營銷和廣告趨勢。

生成式 AI 和計算機圖形學的新突破讓數字人類能夠以類似人類的方式看見、理解和與我們互動。從我所看到的情況來看,你似乎是在某種錄音或製作設置中。數字人類的基礎是建立在多語言語音識別和合成、以及能夠理解和生成對話的 LLM 模型上的 AI 模型。

這些 AI 連接到另一個生成式 AI,以動態地動畫化一個逼真的 3D 面部網格。最後,AI 模型重現逼真的外觀,實現實時路徑跟蹤的次表面散射,模擬光線如何穿透皮膚、散射並在不同點出射,使皮膚具有柔和和半透明的外觀。

Nvidia Ace 是一套數字人類技術,打包成易於部署的完全優化的微服務或 NIMs。開發者可以將 Ace NIMs 集成到他們現有的框架、引擎和數字人類體驗中,Nematons SLM 和 LLM NIMs 理解我們的意圖並協調其他模型。

Riva Speech Nims 用於交互式語音和翻譯,Audio to Face 和 Gesture NIMs 用於面部和身體動畫,Omniverse RTX 與 DLSS 用於皮膚和頭髮的神經渲染。

相當令人難以置信。這些 Ace 可以在雲端運行,也可以在 PC 上運行,在所有 RTX GPU 中都包括了張量核心 GPU,所以英偉達已經在出貨 AI GPU,為這一天做準備。原因很簡單,為了創建一個新的計算平臺,首先需要一個安裝基礎。

最終,應用程序會出現。如果不創建安裝基礎,應用程序怎麼會出現呢?所以如果你建造它,他們可能不會來。但如果你不建造它,他們就不能來。因此,英偉達在每一個 RTX GPU 中安裝了張量核心處理器。現在英偉達在全球有 1 億臺 GeForce RTX AI PC,並且英偉達正在出貨 200 臺。

在本次 Computex,英偉達展示了四款新的令人驚歎的筆記本電腦。它們都能夠運行 AI。未來的筆記本電腦、PC 將成為一個 AI。它將不斷在後臺幫助你、協助你。PC 還將運行由 AI 增強的應用程序。

當然,你所有的照片編輯、寫作工具、你使用的一切工具都將由 AI 增強。你的 PC 還將託管帶有數字人類的 AI 應用程序。因此,AI 將在不同的方式中表現出來並被用於 PC 中。PC 將成為非常重要的 AI 平臺。

那麼我們從這裡往哪裡走?我之前談到了數據中心的擴展。每次擴展時,我們都會發現一個新的飛躍。當從 DGX 擴展到大型 AI 超級計算機時,英偉達使 Transformer 能夠在非常大的數據集上進行訓練。一開始,數據是人工監督的,需要人工標註來訓練 AI。不幸的是,人類標註的數據是有限的。

Transformer 使得無監督學習成為可能。現在,Transformer 只需查看大量的數據、視頻或圖像,它就能通過研究大量的數據自己找到模式和關係。

下一代 AI 需要基於物理。今天的大多數 AI 不瞭解物理定律,它們沒有紮根於物理世界。為了生成圖像、視頻和 3D 圖形以及許多物理現象,我們需要基於物理並瞭解物理定律的 AI。你可以通過視頻學習來實現這一點,這是一種來源。

另一種方法是合成數據、模擬數據,另一種方法是讓計算機相互學習。這實際上與 AlphaGo 自我對弈沒有什麼不同,通過相同能力的對弈,經過很長時間,它們會變得更加聰明。你將開始看到這種類型的 AI 出現。

如果 AI 數據是合成生成的,並使用強化學習,數據生成的速度將繼續提高。每次數據生成增長,需要提供的計算量也需要增長。

我們即將進入一個階段,AI 可以學習物理定律,並紮根於物理世界的數據中。因此,英偉達預計模型將繼續增長,我們需要更大的 GPU。

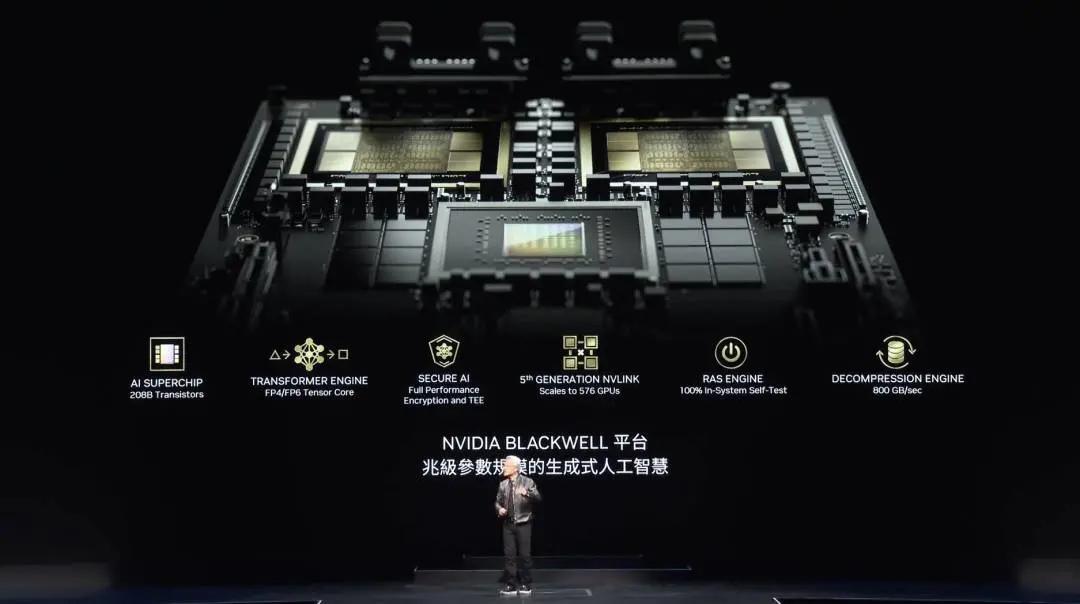

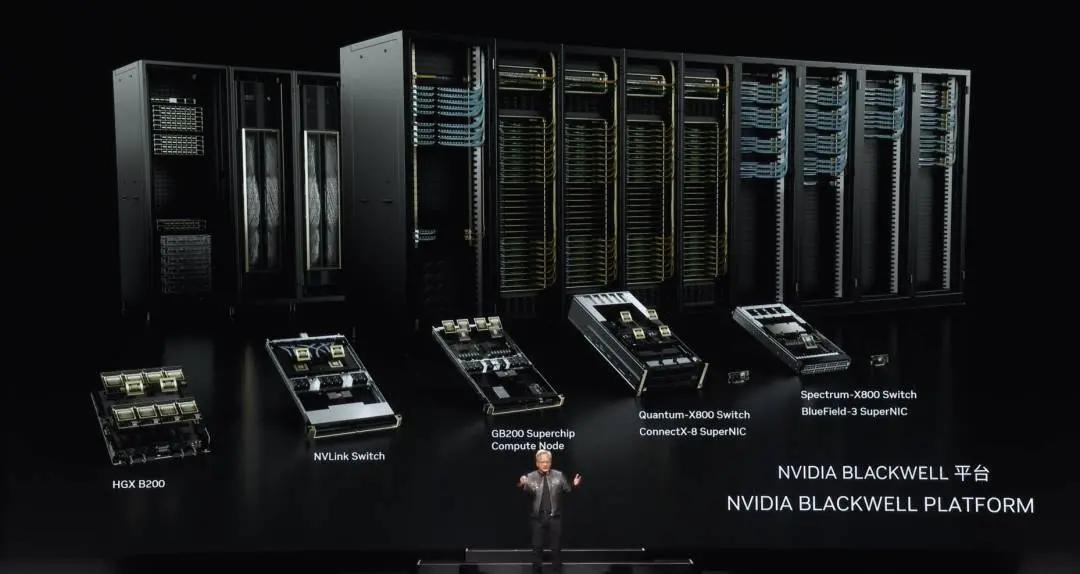

Blackwell

Blackwell 是為這一代設計的,擁有幾項非常重要的技術。首先是芯片的大小。英偉達在臺積電製造了最大的芯片,並將兩個芯片通過每秒 10TB 的連接連接在一起,世界上最先進的 SerDes 將這兩個芯片連接在一起。然後英偉達將兩個芯片放在一個計算節點上,通過 Grace CPU 連接。

Grace CPU 可以用於多種用途。在訓練情況下,可以用於快速檢查點和重啟。在推理和生成情況下,可以用於存儲上下文記憶,使 AI 瞭解你想要進行的對話的上下文,這是英偉達的第二代 Transformer 引擎,允許根據計算層所需的精度和範圍動態調整精度。

這是第二代具有安全 AI 的 GPU,可以要求服務提供商保護 AI 免受盜竊或篡改。這是第五代 NVLink,允許將多個 GPU 連接在一起,我會稍後詳細介紹。

這是英偉達的第一代具有可靠性和可用性引擎的 GPU。這個 RAS 系統允許測試每個晶體管、觸發器、片上內存、片外內存,以便現場確定某個芯片是否故障。擁有 1 萬個 GPU 的超級計算機的平均故障間隔時間是以小時計算的。擁有 10 萬個 GPU 的超級計算機的平均故障間隔時間是以分鐘計算的。

因此,如果不發明技術來提高可靠性,超級計算機長時間運行並訓練幾個月的模型幾乎是不可能的。可靠性會提高正常運行時間,從而直接影響成本。最後是解壓引擎,數據處理是必須做的最重要的事情之一。英偉達添加了一個數據壓縮引擎和解壓引擎,使英偉達夠從存儲中提取數據的速度提高 20 倍,比今天可能的速度更快。

Blackwell 正在生產中,擁有大量的技術,可以看到每一個 Blackwell 芯片,兩個連接在一起。你看到這是世界上最大的芯片。然後將兩個芯片通過每秒 10TB 連接在一起,性能是驚人的。

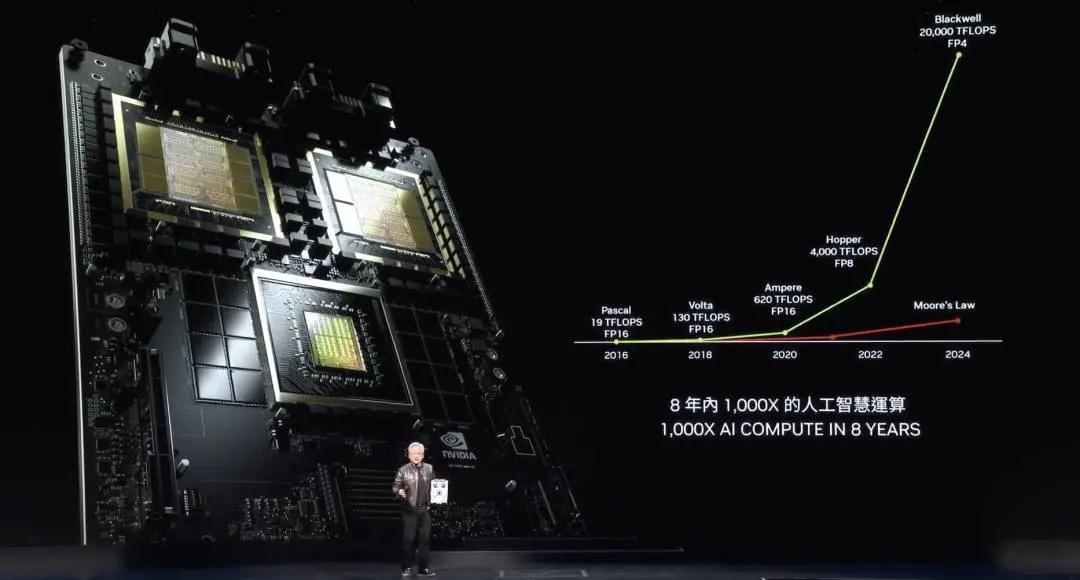

英偉達的每一代計算的浮點運算能力增加了 1000 倍。摩爾定律在八年內增長大約 40~60 倍。而在過去的八年裡,摩爾定律的增長速度大大減慢。即使在摩爾定律最好的時候,也無法與 Blackwell 性能相比。

計算量是驚人的。每次提高計算能力,成本就會下降。英偉達已經通過增加計算能力,將訓練 GPT-4 能量需求從 1000 GWh 降低到 3 GWh。Pascal 需要 1000 GWh 的能量。1000 GWh 意味著需要一個 GW 數據中心。世界上沒有一個 GW 的數據中心,但如果你有一個 GW 數據中心,它需要一個月。如果你有一個 100 MW 數據中心,需要大約一年。因此,沒有人會建造這樣的設施。

這就是為什麼在八年前,像 ChatGPT 這樣的 LLM 是不可能的。通過提高性能,隨著能效的提高,英偉達現在將 Blackwell 的能量需求從 1000 GWh 降低到 3 GWh,這是一個令人難以置信的進步。如果是 1 萬個 GPU,例如,需要幾天,可能需要 10 天左右。在短短八年內取得的進展是驚人的。

這部分是關於推理和生成 token 的。生成一個 GPT-4 token 需要兩個燈泡運行兩天。生成一個單詞大約需要三個 token 。因此,Pascal 生成 GPT-4 並與你進行 ChatGPT 體驗所需的能量幾乎是不可能的。但是現在每個 token 只使用 0.4 焦耳,並且可以以極低的能量生成 token 。

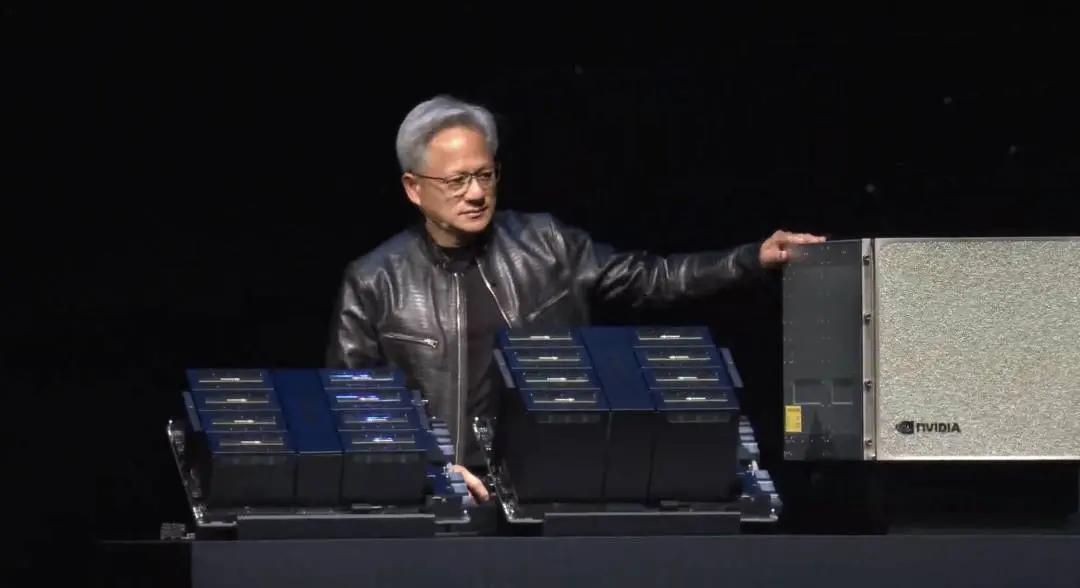

Blackwell 是一個巨大的飛躍。即便如此,它還不夠大。因此必須建造更大的機器。因此英偉達建造的方法叫做 DGX。

這是一個 DGX Blackwell,這是空氣冷卻的,內部有 8 個 GPU。看看這些 GPU 上的散熱片的大小,大約 15 千瓦,完全是空氣冷卻的。這一版本支持 x86,並進入了英偉達一直在發貨的 Hoppers 基礎設施,英偉達有一個新的系統,稱之為 MGX,意為模塊化系統。

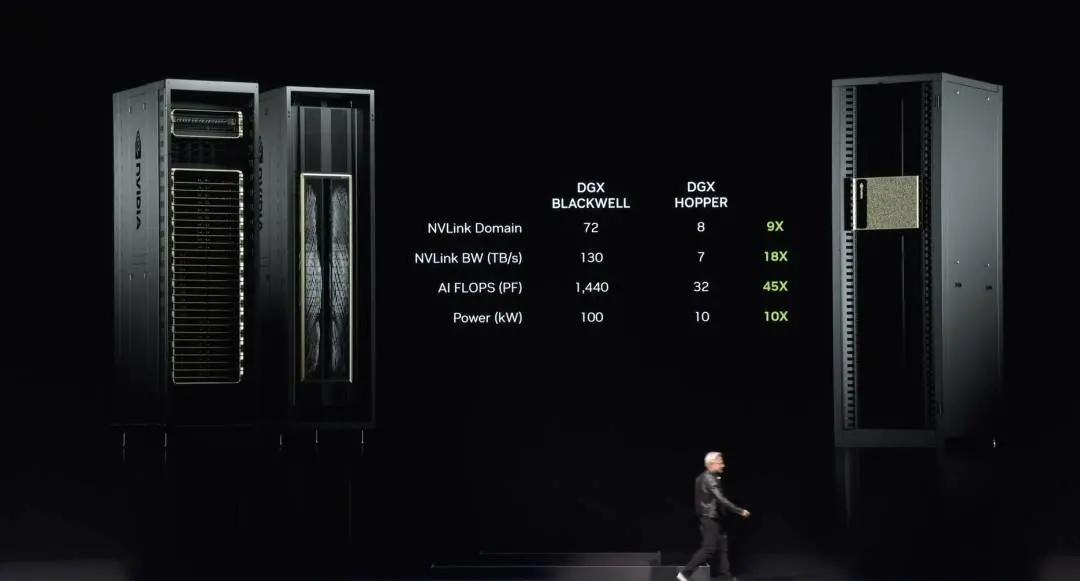

兩塊 Blackwell 板子,一個節點有四個 Blackwell 芯片。這些 Blackwell 芯片是液冷的,72 個 GPU 通過新的 NVLink 連接在一起。這是第 5 代 NVLink 交換機,NVLink 交換機本身就是一個技術奇蹟,這是世界上最先進的交換機,數據速率驚人,這些交換機將每一個 Blackwell 連接在一起,因此有一個巨大的 72 個 GPU 的 Blackwell。

這樣做的好處是,在一個域中,一個 GPU 域現在看起來像一個 GPU,這個 GPU 有 72 個,而上一代是 8 個。因此增加了九倍的帶寬。AI 浮點運算性能增加了 18 倍,提高了 45 倍。而功耗僅增加了 10 倍,這是 100 千瓦,而那是 10 千瓦。這是一個。

當然,你總是可以將更多這些連接在一起,我稍後會展示如何做到這一點。但奇蹟在於這個芯片,這個 NVLink 芯片。人們開始意識到這個 NVLink 芯片的重要性,因為它連接了所有這些不同 GPU。因為 LLM 非常龐大,不能僅僅放在一個 GPU 上,也不能僅僅放在一個節點上。它需要整個 GPU 機架,比如我剛剛站在旁邊的新 DGX,它可以容納數萬億參數的 LLM。

NVLink 交換機本身就是一個技術奇蹟,擁有 500 億個晶體管,74 個端口,每個端口 400Gbps,橫截帶寬 7.2Tbps。但重要的是它在交換機內有數學運算能力,這在深度學習中非常重要,可以在芯片上進行歸約運算。所以這就是現在的 DGX。

黃仁勳表示,許多人問,有人對英偉達的工作產生了困惑,為什麼英偉達通過製造 GPU 變得如此龐大。因此有人認為這就是 GPU 的樣子。

現在這是一個 GPU,這是世界上最先進的 GPU 之一,但這是一個遊戲 GPU。你和我知道這就是 GP 的樣子。這是一個 GPU,女士們先生們,DGX GPU。你知道這個 GPU 的背面是 NVLink 主幹。NVLink 主幹有 5000 根線,兩英里長,它將兩個 GPU 連接在一起,這是一個電氣、機械奇蹟。收發器使能夠在銅線上驅動整個長度,能夠在一個機架中節省 20 千瓦的功耗。

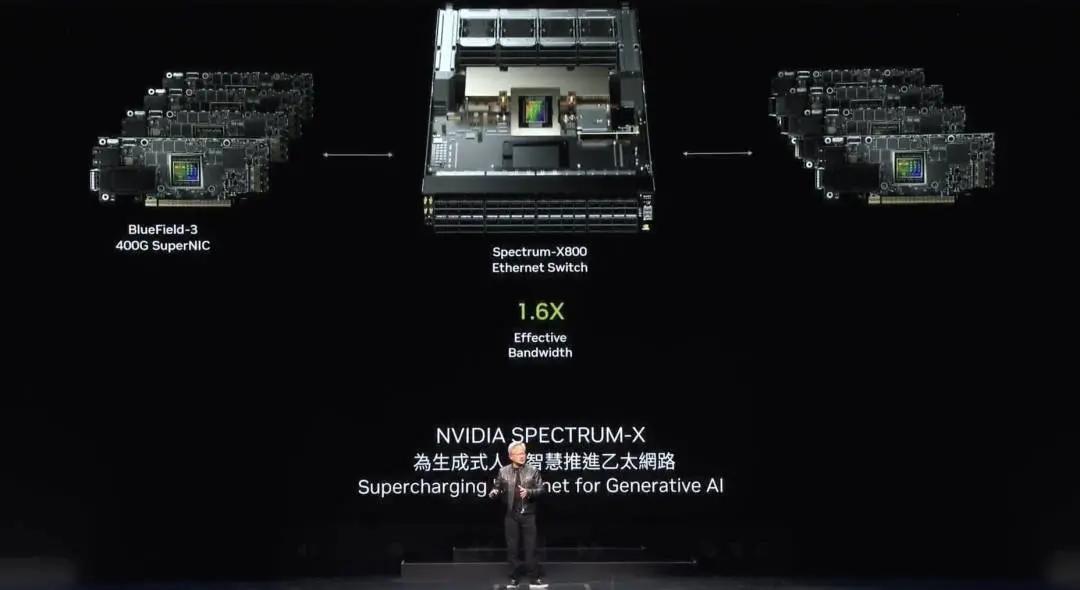

黃仁勳表示,有兩種類型的網絡。InfiniBand 在全球超級計算和 AI 工廠中被廣泛使用,增長速度驚人。然而,不是每個數據中心都能處理 InfiniBand,因為他們已經在其生態系統中投資了太多 Ethernet,並且管理 InfiniBand 交換機和網絡需要一些專業知識。

因此英偉達將 InfiniBand 能力帶到了 Ethernet 架構,這是非常困難的。原因很簡單。Ethernet 是為高平均吞吐量設計的,因為每個節點,每臺計算機都連接到互聯網上的不同人,大多數通信是數據中心與互聯網另一端的人進行的。

然而,深度學習和 AI 工廠,GPU 主要是相互通信的。它們彼此通信,因為它們在收集部分產品,然後進行歸約並重新分發。部分產品的收集、歸約和重新分發。這種流量是非常突發的,重要的不是平均吞吐量,而是最後一個到達的。因此英偉達創建了幾項技術,創建了端到端架構,使網絡接口卡和交換機可以通信,並應用了四種不同的技術來實現這一點。首先,英偉達擁有世界上最先進的 RDMA,現在能夠在 Ethernet 上進行網絡級 RDMA,這是非常了不起的。

第二,英偉達有擁塞控制。交換機一直在進行快速遙測,當 GPU 或網絡接口卡發送太多信息時,可以告訴它們退後,以免造成熱點。

第三,自適應路由。Ethernet 需要按順序傳輸和接收。英偉達看到擁塞或未使用的端口,不論順序如何,將發送到可用端口,BlueField 在另一端重新排序,以確保順序正確,自適應路由非常強大。

最後,噪聲隔離。數據中心總是有多個模型在訓練或其他事情在進行,它們的噪聲和流量可能相互干擾並導致抖動。因此,當一個訓練模型的噪聲導致最後一個到達的時間過晚時,整體訓練速度會顯著降低。

記住,你已經建造了一個價值 50 億美元或 30 億美元的數據中心,用於訓練。如果網絡利用率降低 40%,導致訓練時間延長 20%,50 億美元的數據中心實際上相當於一個 60 億美元的數據中心。因此成本影響非常大。使用 Spectrum X 的 Ethernet 允許大幅提高性能,而網絡基本上是免費的。

英偉達有一整條 Ethernet 產品線。這是 Spectrum X800,速度為每秒 51.2Tbps,256 個端口。接下來的是 512 個端口,明年推出,稱為 Spectrum X800 Ultra,再接下來是 X16。重要的理念是 X800 設計用於成千上萬個 GPU,X800 Ultra 設計用於數十萬個 GPU,X16 設計用於數百萬個 GPU,數百萬 GPU 數據中心時代即將到來。

未來幾乎你與互聯網或計算機的每一次互動都會在某個地方運行一個生成式 AI。這個生成式 AI 與你合作,與你互動,生成視頻、圖像或文本,甚至是一個數字人類。你幾乎一直在與計算機互動,總有一個生成式 AI 連接著,部分在本地,部分在你的設備上,大部分可能在雲端。這些生成式 AI 還會進行大量推理能力,不是一次性的回答,而是通過多次迭代改進答案的質量。所以未來生成的內容量將是驚人的。

Blackwell 當然是英偉達平臺的第一代,在世界認識到生成式 AI 時代來臨之際發佈。正當世界意識到 AI 工廠的重要性,正值這一新工業革命的開始。英偉達得到了幾乎所有 OEM、計算機制造商、雲服務提供商、GPU 雲、主權雲,甚至電信公司的支持。Blackwell 的成功、採用和熱情真是難以置信。我想感謝大家。

黃仁勳繼續比哦啊是,在這個驚人的增長期間,英偉達要確保繼續提高性能,繼續降低訓練成本和推理成本,並繼續擴展 AI 能力,使每家公司都能接受。英偉達推動性能的提升,成本的下降越大。Hopper 平臺當然是歷史上最成功的數據中心處理器,這真的是一個不可思議的成功故事。

然而,Blackwell 已經到來,每一個平臺,如你所見,都包含了幾樣東西。你有 CPU,有 GPU,有 NVLink,有網絡接口,還有連接所有 GPU 的 NVLink 交換機,儘可能大規模的域。無論能做什麼,英偉達都將其連接到大規模、非常高速的交換機。

每一代產品,你會發現不僅僅是 GPU,而是整個平臺。構建整個平臺。將整個平臺集成到一個 AI 工廠超級計算機中。然而,再將其分解並提供給世界。這樣做的原因是因為你們所有人都可以創建有趣和創新的配置,並適應不同的數據中心和不同的客戶需求,有些用於邊緣計算,有些用於電信。所有不同的創新都是可能的,如果將系統開放,並使你們能夠創新。因此英偉達設計了集成的,但將其分解提供給客戶,以便可以創建模塊化系統。

Blackwell 平臺已經到來,英偉達的基本理念非常簡單:每年構建整個數據中心,分解並以零件形式銷售,將一切推向技術的極限,無論是臺積電的工藝技術、封裝技術、內存技術、SerDes 技術、光學技術,一切都被推向極限。之後,確保所有軟件都能在整個安裝基礎上運行。

軟件慣性是計算機中最重要的事情之一。當計算機向後兼容,並與所有已創建的軟件架構兼容時,你進入市場的速度會快得多。因此,當能夠利用已經創建的整個軟件安裝基礎時,速度是驚人的。

黃仁勳表示,Blackwell 已經到來,明年是 Blackwell Ultra,就像有 H100 和 H200,你們可能會看到一些令人興奮的新一代 Blackwell Ultra,推動極限。我提到的下一代 Spectrum 交換機,這是第一次實現這種飛躍,下一代平臺叫做 Ruben,再一年後將有 Ruben Ultra 平臺。

展示的所有這些芯片都在全速開發中,100% 的開發。這是英偉達一年的節奏,所有 100% 架構兼容,英偉達正在構建的所有豐富的軟件。

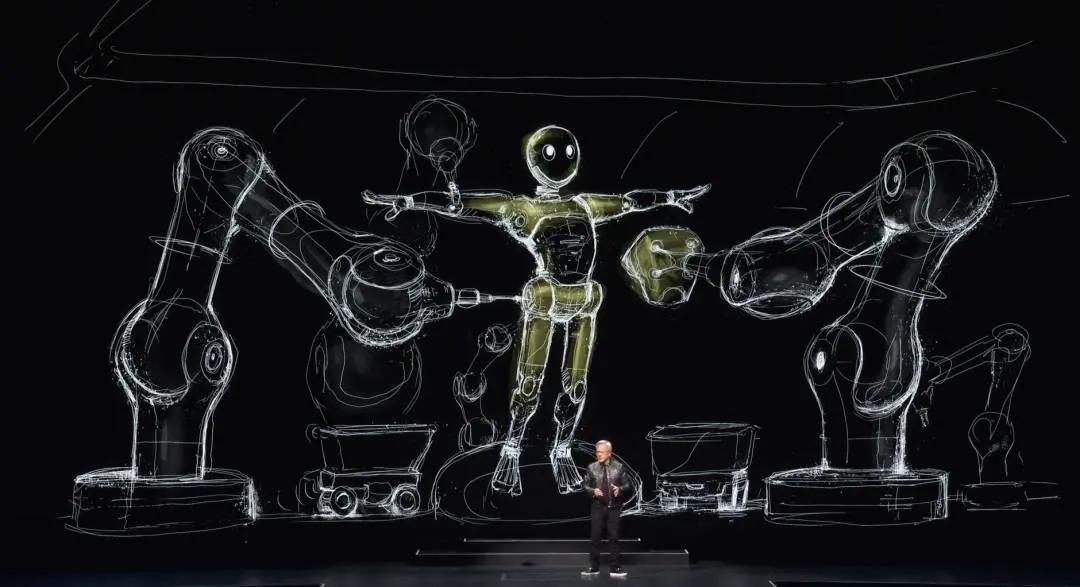

AI 機器人

讓我談談接下來會發生什麼,下一波 AI 是物理 AI,瞭解物理定律,能夠在我們中間工作。因此,它們必須理解世界模型,理解如何解釋世界,如何感知世界。它們當然還需要出色的認知能力,以便理解我們的問題並執行任務。

機器人是一個更廣泛的概念。當然,當我說機器人時,通常指的是人形機器人,但這並不完全正確。一切都將是機器人。所有的工廠將是機器人化的,工廠將協調機器人,這些機器人將製造機器人產品,機器人相互協作,製造機器人產品。為了實現這一點,需要一些突破。

接下來,黃仁勳展示了一段視頻,視頻中提到:

機器人時代已經到來。一天內,所有移動的東西都將是自主的。世界各地的研究人員和公司正在開發由物理 AI 驅動的機器人,這些 AI 模型能夠理解指令,並在現實世界中自主執行復雜任務。多模態 LLM 是突破,使機器人能夠學習、感知和理解周圍的世界,並規劃它們的行動。

通過人類演示,機器人現在可以學習所需的技能,使用粗大和精細的運動技能與世界互動。推進機器人技術的一個關鍵技術是強化學習。就像 LLM 需要 RLHF 來學習特定技能一樣,生成物理 AI 可以使用物理反饋在模擬世界中學習技能。這些模擬環境是機器人通過在遵循物理定律的虛擬世界中執行動作來學習決策的地方。在這些機器人健身房中,機器人可以安全快速地學習執行復雜和動態的任務,通過數百萬次試驗和錯誤行為來提高技能。

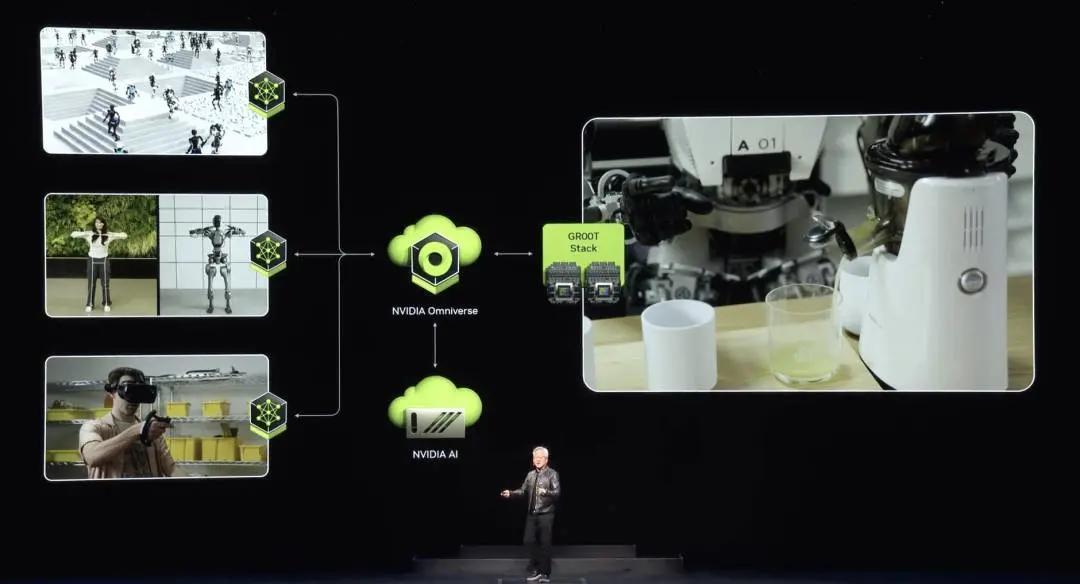

英偉達構建了 Nvidia Omniverse 作為物理 AI 的操作系統。Omniverse 是一個虛擬世界模擬開發平臺,結合了實時物理渲染、物理模擬和生成式 AI 技術。在 Omniverse 中,機器人學習如何成為機器人。它們學習如何自主精確地操控物體,比如抓取和處理物體,或自主導航環境,找到最佳路徑,同時避免障礙和危險。在 Omniverse 中學習最大限度地減少模擬與現實的差距,並最大限度地轉移所學行為。

構建具有生成物理 AI 的機器人需要三臺計算機:Nvidia AI 超級計算機來訓練模型,Nvidia Jetson Orin 和下一代 Jetson Thor 機器人超級計算機來運行模型,以及 Nvidia Omniverse,機器人可以在模擬世界中學習和改進技能。構建了開發人員和公司所需的平臺、加速庫和 AI 模型,並允許他們使用最適合的堆棧。下一波 AI 已經到來。由物理 AI 驅動的機器人將徹底改變各個行業。

黃仁勳提到,這不是未來,這正在發生。英偉達將通過幾種方式服務市場。首先,英偉達將為每種類型的機器人系統創建平臺,一個用於機器人工廠和倉庫,一個用於操縱物體的機器人,一個用於移動的機器人,一個用於人形機器人。因此,每個機器人平臺就像英偉達做的幾乎所有事情一樣,都是計算機、加速庫和預訓練模型。計算機、加速庫、預訓練模型。在 Omniverse 中測試、訓練和集成所有東西,正如視頻所說,機器人在這裡學習如何成為機器人。

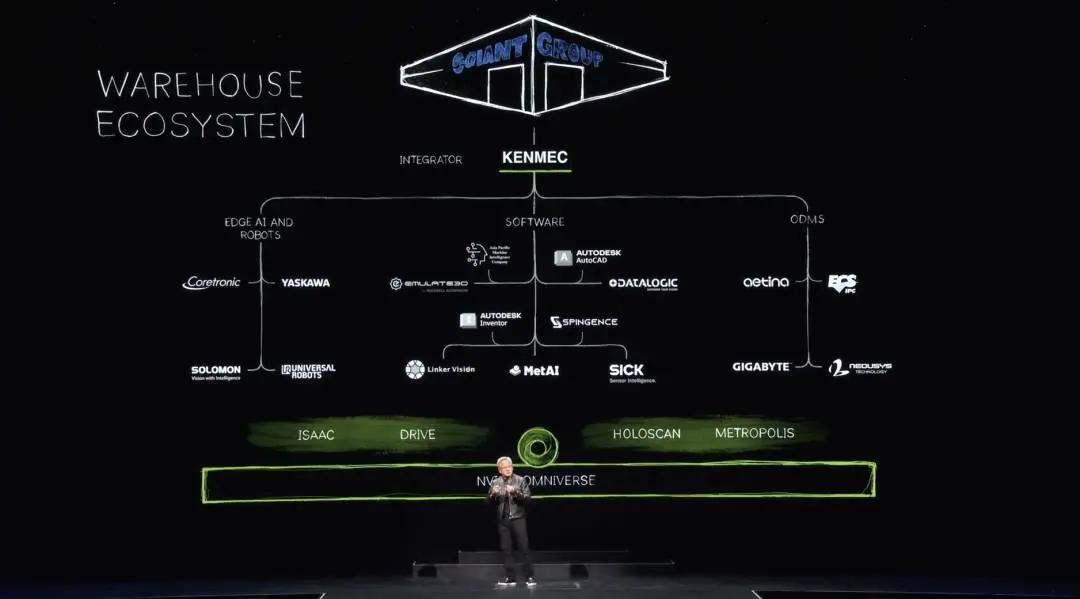

當然,機器人倉庫的生態系統非常複雜。建造現代倉庫需要很多公司、很多工具、很多技術,倉庫正日益自動化。有一天,它們將完全自動化。因此,在每個生態系統中,都有連接到軟件行業的 SDK 和 API,連接到邊緣 AI 行業和公司的 SDK 和 API,以及為 Odms 設計的 PLC 和機器人系統的系統集成。這些最終由集成商集成,構建給客戶的倉庫。這裡有一個例子,Kenmac 為 Giant 集團構建的機器人倉庫。

黃仁勳繼續表示,工廠有一個完全不同的生態系統,富士康正在建造一些世界上最先進的工廠。它們的生態系統再次包括邊緣計算機和機器人,設計工廠的軟件、工作流程、編程機器人以及協調數字工廠和 AI 工廠的 PLC 計算機。英偉達有連接到每個生態系統的 SDK,這在整個臺灣都在發生。

富士康正在為其工廠建造數字孿生體。臺達正在為其工廠建造數字孿生體。順便說一下,一半是真實的,一半是數字的,一半是 Omniverse。和碩正在為其機器人工廠建造數字孿生體,廣達正在為其機器人工廠建造數字孿生體。

黃仁勳繼續演示了一段視頻,視頻中提到:

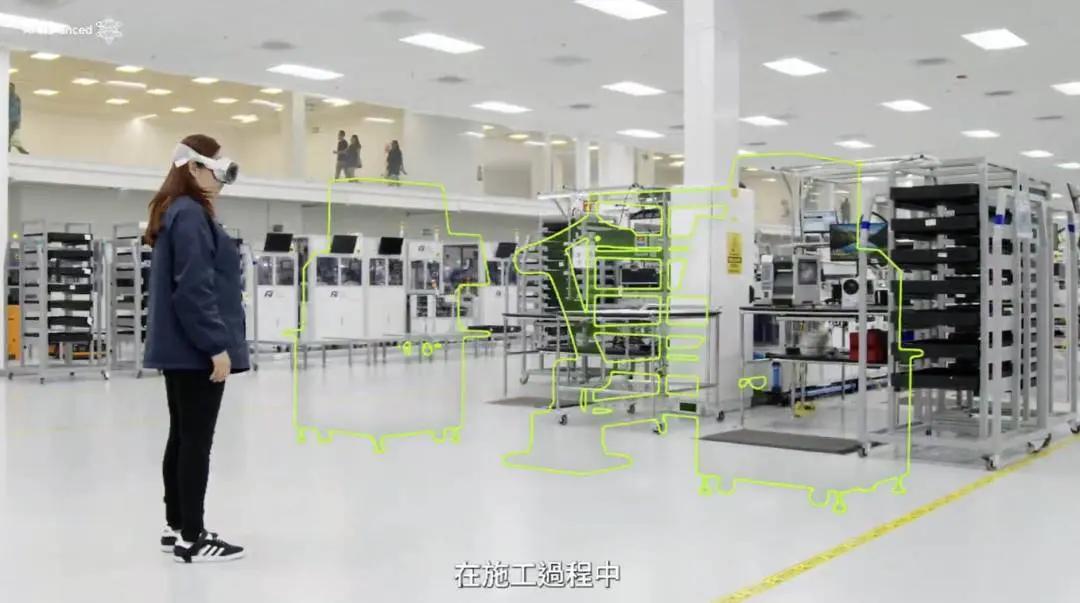

隨著世界將傳統數據中心現代化為生成式 AI 工廠,對 Nvidia 加速計算的需求正在飆升。富士康,世界上最大的電子製造商,正準備通過 Nvidia Omniverse 和 AI 建造機器人工廠來滿足這一需求。工廠規劃人員使用 Omniverse 將來自西門子 Team Center X 和 Autodesk Revit 等領先行業應用程序的設施和設備數據集成到數字孿生體中。

在數字孿生體中,他們優化了地板佈局和生產線配置,並定位了最佳相機位置,以使用 Nvidia Metropolis 支持的視覺 AI 監控未來的操作。虛擬集成節省了規劃人員在建設期間巨大的物理變更訂單成本。富士康團隊使用數字孿生體作為準確設備佈局的真實來源進行溝通和驗證。

Omniverse 數字孿生體也是機器人健身房,富士康開發人員在這裡為機器人感知和操作訓練和測試 Nvidia Isaac AI 應用程序,以及用於傳感器融合的 Metropolis AI 應用程序。

黃仁勳繼續表示,在 Omniverse 中,富士康模擬了兩個機器人 AI,在將運行時部署到裝配線上的 Jetson 計算機之前。他們模擬了 Isaac Manipulator 庫和用於自動光學檢測的 AI 模型,以進行物體識別、缺陷檢測和軌跡規劃。他們還模擬了 Isaac Perceptor 驅動的 Ferrobot AMRS,這些機器人通過 3D 映射和重建感知和移動他們的環境。通過 Omniverse,富士康建立了運行在 Nvidia Isaac 上的機器人工廠,這些機器人建造了 Nvidia AI 超級計算機,反過來訓練富士康的機器人。

一個機器人工廠設計了三臺計算機。首先在 Nvidia AI 上訓練 AI,然後在 PLC 系統上運行機器人以協調工廠操作,最後在 Omniverse 中模擬一切。機器人手臂和機器人 AMRS 也是如此,三臺計算機系統的區別在於兩個 Omniverse 將結合在一起,共享一個虛擬空間。當它們共享一個虛擬空間時,機器人手臂將進入機器人工廠。再次強調,三臺計算機,提供計算機、加速層和預訓練 AI 模型。

英偉達將 Nvidia Manipulator 和 Nvidia Omniverse 與世界領先的工業自動化軟件和系統公司西門子連接起來。這真的是一個非常棒的合作,他們正在世界各地的工廠中工作。

Semantic Pick AI 現在集成了 Isaac Manipulator,Semantic Pick AI 運行並操作 ABB、Kuka、安川、Fanuc、Universal Robotics 和 Techman。因此,西門子是一個絕佳的整合。

黃仁勳繼續演示了一段視頻,視頻中提到:

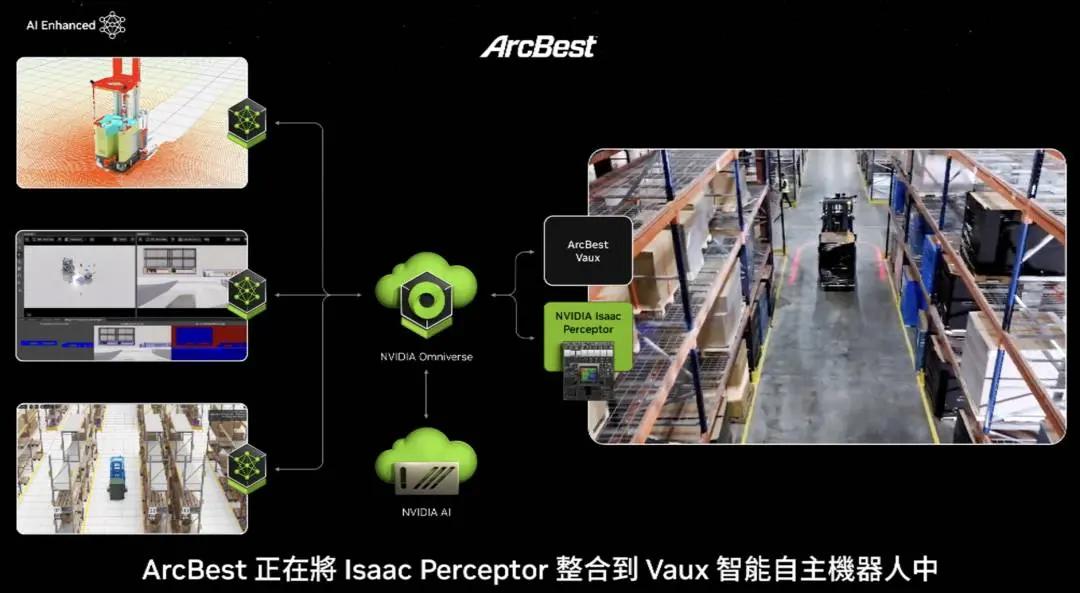

Arcbest 正在將 Isaac Perceptor 集成到 Fox 智能自主機器人中,以增強物體識別和人體動作跟蹤及材料處理。比亞迪電子正在將 Isaac Manipulator 和 Perceptor 集成到他們的 AI 機器人中,以提高全球客戶的製造效率。Ideal Works 正在將 Isaac Perceptor 集成到他們的 iOS 軟件中,用於工廠物流中的 AI 機器人。

Gideon 正在將 Isaac Perceptor 集成到托盤 AI 驅動的叉車中,以推進 AI 驅動的物流。Argo Robotics 正在採用 Isaac Perceptor 用於高級視覺 AMRS 的感知引擎。Solomon 正在他們的 Acupic 3D 軟件中使用 Isaac Manipulator AI 模型進行工業操作。Techman Robot 正在將 Isaac Sim 和 Manipulator 集成到 TM Flow 中,以加速自動光學檢測。Teradine Robotics 正在將 Isaac Manipulator 集成到 Polyscope X 用於協作機器人,並將 Isaac Perceptor 集成到 MiR AMRS 中。

Vention 正在將 Isaac Manipulator 集成到 Machine Logic 中,用於 AI 操作機器人。機器人技術已經到來,物理 AI 已經到來。

黃仁勳繼續介紹,這不是科幻小說,它正在整個臺灣被廣泛應用,真的非常令人興奮。這是工廠,裡面的機器人,當然所有產品也將是機器人化的。

有兩種非常高產量的機器人產品。一種當然是自動駕駛汽車或具有高度自動駕駛能力的汽車。英偉達再次構建了整個堆棧。

明年,英偉達將與梅賽德斯車隊一起投入生產。之後,在 2026 年,將是 JLR 車隊。英偉達向世界提供整個堆棧。然而,你可以選擇英偉達堆棧中的任何部分,任何層,就像整個 Drive 堆棧是開放的。

下一個將由機器人工廠內的機器人制造的高產量機器人產品可能是人形機器人。近年來在認知能力和世界理解能力方面取得了巨大進展,這要歸功於基礎模型和英偉達正在開發的技術。

黃仁勳表示,他對這一領域非常興奮,因為顯然,最容易適應世界的機器人是人形機器人,因為我們為自己建造了這個世界,還可以通過演示和視頻提供大量的訓練數據,遠遠超過其他類型的機器人。因此,英偉達將在這一領域看到很多進展。

下一波 AI。臺灣不僅製造帶鍵盤的計算機,還製造用於口袋的計算機、用於數據中心的計算機。在未來,你們將製造會走動的計算機和四處滾動的計算機。這些都是計算機。事實證明,構建這些計算機的技術與今天你們已經構建的所有其他計算機的技術非常相似,這將是一個非常非凡的旅程。