編譯:深潮TechFlow

Curve Finance的創始人@newmichwill最近在推文中表示,加密貨幣的主要目的在於DeFi(去中心化金融),而AI(人工智能)根本不需要加密貨幣。雖然我同意DeFi是加密領域的重要組成部分,但我並不認同AI不需要加密貨幣的觀點。

隨著AI代理(AI agents)的興起,許多代理通常會附帶一個代幣,這讓人們誤以為加密貨幣與AI的交集僅僅是這些AI代理。而另一個被忽視的重要話題是“去中心化AI”,這與AI模型本身的訓練息息相關。

我對某些敘事的不滿在於,大多數用戶會盲目地認為某事物在流行時就一定重要且有用,甚至更糟的是,他們認為這些敘事的唯一目標就是儘可能地榨取價值(換句話說,就是賺錢)。

在討論去中心化AI時,我們首先應該問自己:為什麼AI需要去中心化?以及這會帶來哪些後果?

事實證明,去中心化的理念幾乎總是不可避免地與“激勵機制的對齊”這一概念聯繫在一起。

在AI領域,有許多根本性的問題可以通過加密技術來解決,更有一些機制不僅能解決現有問題,還能為AI增加更多的可信度。

那麼,為什麼AI需要加密貨幣呢?

1. 高昂的計算成本限制了參與和創新

無論幸運與否,大型AI模型需要大量的計算資源,這自然限制了許多潛在用戶的參與。大多數情況下,AI模型需要海量的數據資源以及實際的計算能力,而這些對於單個個體來說幾乎難以承擔。

這一問題在開源開發中尤為突出。貢獻者不僅需要投入時間來訓練模型,還必須投入計算資源,這使得開源開發效率低下。

確實,個體可以投入大量資源來運行AI模型,就像用戶可以為運行自己區塊鏈節點分配計算資源一樣。

然而,這並不能從根本上解決問題,因為算力仍不足以完成相關任務。

獨立開發者或研究人員無法參與諸如LLaMA這類大型AI模型的開發,僅僅因為他們無法承擔訓練模型所需的計算成本:需要成千上萬的GPU、數據中心以及額外的基礎設施。

以下是一些規模感知的數據:

→ 埃隆·馬斯克(Elon Musk)表示,最新的Grok 3模型使用了10萬塊Nvidia H100 GPU進行訓練。

→ 每塊芯片的價值約為3萬美元。

→ 用於訓練Grok 3的AI芯片總成本約為30億美元。

這一問題在某種程度上類似於初創企業的建設過程,個體可能擁有時間、技術能力和執行計劃,但一開始卻缺乏足夠的資源來實現願景。

正如@dbarabander所指出的,傳統的開源軟件項目只需要貢獻者捐贈時間,而開源AI項目則需要時間和大量資源,例如算力和數據。

僅僅依靠善意和志願者的努力不足以激勵足夠多的個人或團體提供這些高昂的資源。額外的激勵機制是驅動參與的必要條件。

2. 加密技術是實現激勵對齊的最佳工具

所謂激勵對齊(Incentive Alignment),是指通過制定規則,鼓勵參與者在為系統做出貢獻的同時,也能獲得自身利益。

加密技術在幫助不同系統實現激勵對齊方面有無數成功案例,而最顯著的例子之一就是去中心化物理基礎設施網絡(DePIN)行業,它與這一理念完美契合。

例如,@helium和 @rendernetwork這樣的項目通過分佈式的節點和GPU網絡實現了激勵對齊,成為了典範。

那麼,為什麼我們不能將這一模式應用到AI領域,使其生態系統更加開放和可訪問呢?

事實證明,我們是可以的。

推動Web3和加密技術發展的核心在於“所有權”。

你擁有自己的數據,你擁有自己的激勵機制,甚至當你持有某些代幣時,你也擁有了網絡的一部分。賦予資源提供者所有權,可以激勵他們將自己的資產提供給項目,期待從網絡的成功中獲得回報。

為了讓AI更加普及,加密技術是最優解。開發者可以在項目之間自由共享模型設計,而計算和數據提供者則可以通過提供資源換取所有權份額(激勵)。

3. 激勵對齊與可驗證性密切相關

如果我們設想一個具備適當激勵對齊的去中心化AI系統,它應該繼承經典區塊鏈機制的一些特性:

網絡效應(Network Effects)。

較低的初始要求,節點可以通過未來的收益獲得回報。

懲罰機制(Slashing Mechanisms),對惡意行為者進行處罰。

尤其是對於懲罰機制,我們需要可驗證性。如果無法驗證誰是惡意行為者,就無法對其進行懲罰,這將使系統極易被作弊者利用,尤其是在跨團隊協作的情況下。

在去中心化AI系統中,可驗證性至關重要,因為我們沒有一個集中的信任點。相反,我們追求的是一個無需信任但可驗證的系統。以下是可能需要可驗證性的多個組件:

基準測試階段(Benchmark Phase):系統在某些指標(如x、y、z)上優於其他系統。

推理階段(Inference Phase):系統運行是否正確,即AI的“思考”階段。

訓練階段(Training Phase):系統是否被正確訓練或調整。

數據階段(Data Phase):系統是否正確收集數據。

目前有數百個團隊在@eigenlayer上構建項目,但我最近注意到,AI的關注度比以往更高,我也在思考這是否與其最初的再質押(Restaking)願景相符。

任何希望實現激勵對齊的AI系統都必須是可驗證的。

在這種情況下,懲罰機制等同於可驗證性:如果一個去中心化系統能夠對惡意行為者進行懲罰,就意味著它能夠識別並驗證這些惡意行為的存在。

如果系統是可驗證的,那麼AI就可以利用加密技術接入全球的計算和數據資源,從而打造更大、更強的模型。因為更多的資源(計算+數據)通常會帶來更好的模型(至少在當前的技術世界中是如此)。

@hyperbolic_labs 已經展示了協作計算資源的潛力。任何用戶都可以租用GPU,用於訓練比他們在家中能夠運行的更加複雜的AI模型,而且成本更低。

如何讓AI驗證既高效又可驗證?

有人可能會說,現在有許多雲解決方案可以租用GPU,這已經解決了計算資源的問題。

然而,像AWS或Google Cloud這樣的雲解決方案高度集中化,並且採用所謂的“候補名單策略”(Waitlist Strategy),人為製造高需求的假象,從而抬高價格。這種現象在該領域的寡頭壟斷格局中尤為常見。

實際上,有大量GPU資源閒置在數據中心、礦場,甚至個人手中,這些資源本可以用於AI模型訓練的計算貢獻,但卻被浪費了。

你可能聽說過@getgrass_io,它允許用戶將未使用的帶寬出售給企業,從而避免帶寬資源的浪費,並獲得一定的獎勵。

我並不是說計算資源是無限的,但任何系統都可以通過優化來實現雙贏:一方面,為需要更多資源進行AI模型訓練的人提供更開放的市場;另一方面,讓貢獻這些資源的人獲得相應的回報。

Hyperbolic團隊開發了一個開放的GPU市場。在這裡,用戶可以租用GPU用於AI模型訓練,節省高達75%的成本,而GPU提供者則可以將閒置資源貨幣化,獲得收益。

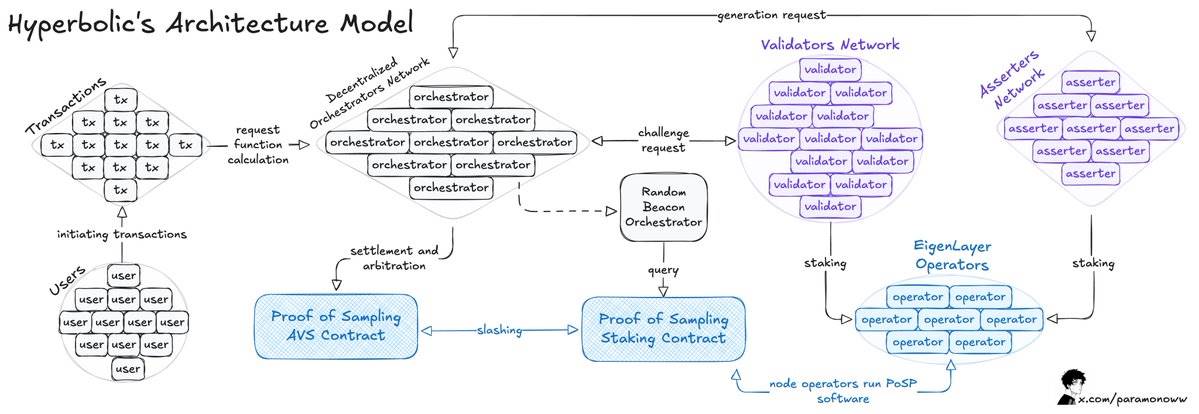

以下是其工作方式的概述:

Hyperbolic通過將連接的GPU組織成集群和節點,使計算能力能夠根據需求進行擴展。

該架構模型的核心是“採樣證明”(Proof of Sampling)模型,其特點是將交易進行採樣處理:通過隨機選擇和驗證交易,減少了工作負載和計算需求。

主要問題出現在AI的推理(Inference)過程中,在網絡上運行的每次推理都需要被驗證,且最好能避免其他機制帶來的顯著計算開銷。

正如我之前所說,如果某件事情可以被驗證,那麼如果驗證結果表明該行為違反規則,就必須對其進行懲罰(Slashing)。

當Hyperbolic採用AVS(Adaptive Verification System,自適應驗證系統)模型時,它為系統增加了更多的可驗證性。在這一模型中,驗證者是隨機選出的,用於驗證輸出結果,從而使系統實現激勵對齊——在這種機制下,不誠實的行為是無利可圖的。

要訓練一個AI模型並使其更完善,主要需要兩個資源:計算能力和數據。租用計算能力是一個解決方案,但我們仍然需要從某處獲取數據,並且需要多樣化的數據以避免模型可能的偏見。

為AI驗證來自不同來源的數據

數據越多,模型越好;但問題在於,你通常需要多樣化的數據。這是AI模型面臨的一個主要挑戰。

數據協議已經存在了幾十年。無論數據是公開的還是私有的,數據經紀人都會以某種方式收集這些數據,可能會付費,也可能不會,然後將其出售以獲取利潤。

我們在為AI模型獲取合適數據時面臨的問題包括:單點故障、審查制度,以及缺乏一種無需信任的方式來提供真實可靠的數據以“餵養”AI模型。

那麼,誰需要這樣的數據?

首先,是AI研究人員和開發者,他們希望通過真實且適當的輸入來訓練和推理他們的模型。

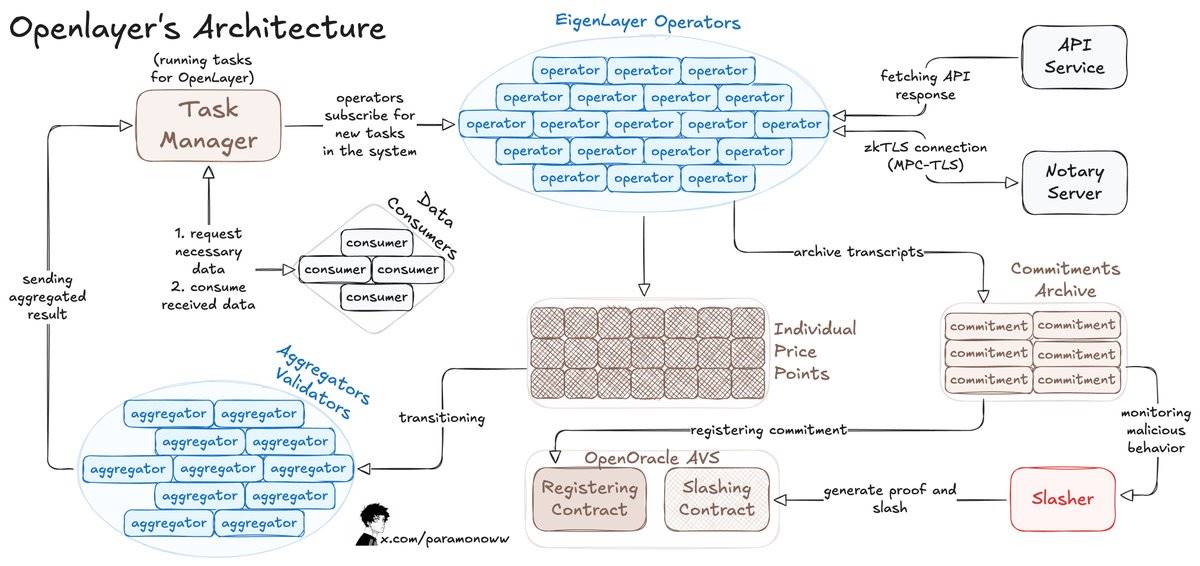

例如,OpenLayer允許任何人無需許可地向系統或AI模型添加數據流,並且系統可以以一種可驗證的方式記錄每一條可用的數據。

OpenLayer還使用了zkTLS(零知識傳輸層安全協議),這一點在我之前的文章中有詳細描述。該協議確保操作員報告的數據確實是他們從來源獲得的(可驗證性)。

這是OpenLayer的工作原理:

數據消費者向OpenLayer的智能合約發佈數據請求,並通過合約(鏈上或鏈下)使用類似主要數據預言機的API檢索結果。

操作員通過EigenLayer註冊,以保障OpenLayer AVS的質押資產,並運行AVS軟件。

操作員訂閱任務,處理並提交數據到OpenLayer,同時將原始響應和證明存儲在去中心化存儲中。

對於可變結果,聚合器(特殊的操作員)會對輸出進行標準化處理。

開發者可以向任何網站請求最新數據,並將其接入網絡。如果你正在開發AI相關項目,你可以獲得可靠的實時數據。

在我們探討了AI計算過程和獲取可驗證數據的方式之後,接下來需要關注的是AI模型的兩大核心部分:計算本身及其驗證。

AI計算必須通過驗證才能確保正確性

在理想情況下,節點必須證明其計算貢獻,以確保系統的正常運行。

而在最糟糕的情況下,節點可能會虛假聲稱提供了計算能力,但實際上並未做任何實際工作。

要求節點證明其貢獻,可以確保只有合法的參與者被認可,從而避免惡意行為。這種機制與傳統的工作量證明(Proof of Work)非常相似,不同之處在於節點執行的工作類型。

即使我們為系統加入了適當的激勵對齊機制,如果節點無法無需許可地證明其完成了某些工作,它們可能會獲得與實際貢獻不符的獎勵,甚至可能導致獎勵分配不公。

如果網絡無法評估計算貢獻,就可能導致某些節點被分配超出其能力的任務,而其他節點則處於閒置狀態,最終引發效率低下或系統故障。

通過證明計算貢獻,網絡可以使用標準化指標(例如FLOPS,每秒浮點運算次數)量化每個節點的努力。這種方式能夠根據實際完成的工作分配獎勵,而不是僅僅依據節點是否存在於網絡中。

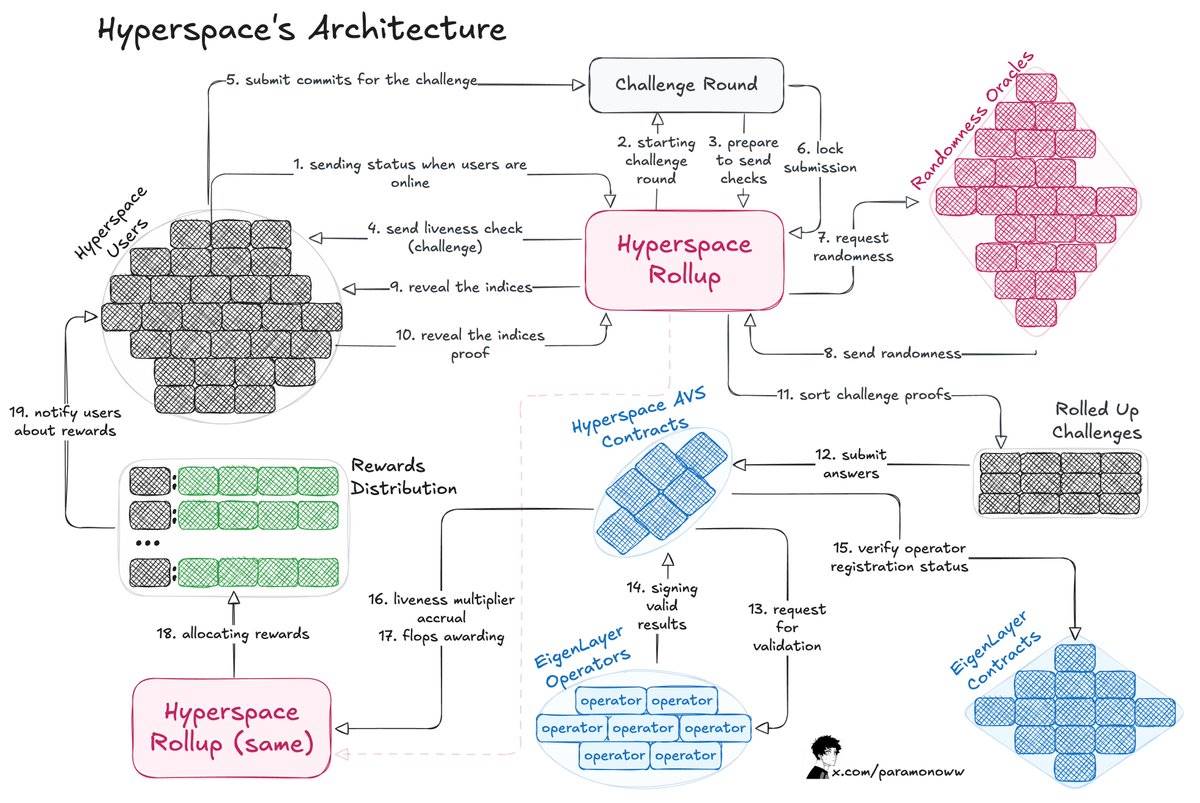

來自@HyperspaceAI的團隊開發了一種“FLOPS證明”(Proof-of-FLOPS)系統,使節點可以租賃未使用的計算能力。作為交換,他們會獲得“flops”積分,這些積分將作為網絡的通用貨幣。

該架構的工作原理如下:

流程從向用戶發出挑戰開始,用戶通過提交對挑戰的承諾來回應。

Hyperspace Rollup管理流程,確保提交的安全性並從預言機獲取隨機數。

用戶公開索引,挑戰流程完成。

操作員檢查響應,並將有效結果通知Hyperspace AVS合約,隨後通過EigenLayer合約確認這些結果。

計算活躍度乘數(Liveness Multipliers),並向用戶授予flops積分。

證明計算貢獻提供了每個節點能力的清晰圖景,因此係統可以智能地分配任務——將複雜的AI計算任務分配給高性能節點,而將較輕的任務分配給能力較低的節點。

最有趣的部分是如何讓這一系統具備可驗證性,從而任何人都可以證明完成工作的正確性。Hyperspace的AVS系統持續發送挑戰、隨機數請求,並執行多層驗證流程,正如上文所述的架構圖所示。

操作員可以放心參與系統,因為結果經過驗證且獎勵分配公平。如果結果不正確,惡意行為者將毫無疑問地受到懲罰(Slashing)。

驗證AI計算結果有許多重要原因:

鼓勵節點加入並貢獻資源。

按努力程度公平分配獎勵。

確保貢獻直接支持特定的AI模型。

根據節點的驗證能力有效分配任務。

AI的去中心化與可驗證性

正如@yb_effect所指出的,“去中心化”(Decentralized)和“分佈式”(Distributed)是完全不同的概念。分佈式僅指硬件分佈在不同位置,但仍然存在一箇中心化的連接點。

而去中心化意味著沒有單一的主節點,訓練過程能夠處理故障,這與當今大多數區塊鏈的運行方式類似。

如果AI網絡要實現真正的去中心化,需要採用多種解決方案,但可以確定的是,我們需要對幾乎所有內容進行驗證。

如果你想構建一個AI模型或智能體,你需要確保每個組件以及每個依賴項都經過驗證。

推理、訓練、數據、預言機——所有這些都可以被驗證,從而不僅為AI系統引入與激勵兼容的加密獎勵,還能使系統更加公平和高效。