為什麼需要一個開放的機器人時代

在未來 5–8 年,地球上的機器人數量將突破 10 億臺,這是它們從“單機演示”走向“社會分工”的拐點。機器人將不僅只是流水線上的機械臂,而是能夠感知、理解、決策並與人類協作的“同事、老師和夥伴”。

近年來,機器人硬件像肌肉一樣迅猛增長,它們擁有更靈巧的手、更穩的步態和更豐富的傳感。但真正的瓶頸不在於金屬與電機,而在於如何讓它們具備共享與協作的心智:

各廠商的軟件互不兼容,機器人之間無法共享技能與智能;

決策邏輯被封閉系統鎖住,外界無法驗證或優化;

中心化的控制架構意味著創新速度受限,信任成本高。

這種割裂導致機器人產業難以把 AI 的模型進步轉化為可複製的生產力:機器人的單機 Demo 層出不窮,但缺少跨設備遷移、可驗證決策和標準化協作,進而難以規模化。而 OpenMind 要解決的,正是這“最後一公里”。我們的目標不是造一臺更會跳舞的機器人,而是為全球海量異構機器人提供統一的軟件地基與協作標準:

讓機器人具備理解語境和彼此學習的能力;

讓開發者在開源、模塊化的架構上快速搭建應用;

讓人和機器在去中心化的規則下安全協作與結算。

一句話,OpenMind 正在構建機器人的通用操作系統,讓機器人不僅可以感知和行動,還可以通過去中心化協同,在任意環境下安全且規模化的合作。

誰在押注這條路:20M 融資與全球陣容

目前,OpenMind 已完成 2000 萬美元(Seed + Series A)融資,由 Pantera Capital領投,投資陣容涵蓋全球頂尖的科技與資本力量:

西方的技術與資本生態:Ribbit、Coinbase Ventures、DCG、Lightspeed Faction、Anagram、Pi Network Ventures、Topology、Primitive Ventures 和 Amber Group 等,他們長期深耕加密與 AI 基礎設施,押注“智能體經濟與機器互聯網”的底層範式;

東方的產業能量:紅杉中國等深耕機器人供應鏈與製造體系,理解“把一臺機器做出來並規模化交付”的全部難度與門檻;

與此同時,OpenMind 也與 KraneShares 等傳統資本市場參與方保持緊密交流,共同探索將“機器人 + 智能體”的長期價值納入金融結構化產品的通路,以此實現幣股雙向貫通。2025 年 6 月,KraneShares 推出全球人形與具身智能指數 ETF(KOID)時,選用了由 OpenMind 與 RoboStore 聯合定製的人形機器人 “Iris” 在納斯達克敲響開市鍾,這也是交易所歷史上首次由人形機器人完成這一儀式。

正如 Pantera Capital 合夥人 Nihal Maunder 所說:

“如果我們希望智能機器在開放環境中運行,就需要一個開放的智能網絡。OpenMind 正在為機器人做的事,就像 Linux 之於軟件、以太坊之於區塊鏈。”

團隊與顧問:從實驗室到產線

OpenMind 的創始人 Jan Liphardt 為斯坦福大學副教授、前伯克利教授,長期研究數據與分佈式系統,在學界與工程側均有深耕。他主張推進開源複用、以可審計、可追溯的機制替代黑箱、用跨學科方法整合AI、機器人和密碼學。

OpenMind 的核心團隊來自OKX Ventures、Oxford Robotics Institute、Palantir、Databricks、Perplexity等機構,覆蓋機器人控制、感知與導航、多模態與 LLM 調度、分佈式系統與鏈上協議等關鍵環節。同時,一支由學術界與產業界專家組成的顧問團隊(如 Stanford 機器人負責人 Steve Cousins、牛津區塊鏈中心 Bill Roscoe、Imperial College 安全 AI 教授 Alessio Lomuscio)也為機器人的“安全、合規、可靠”提供保障。

OpenMind 的解法:兩層架構,一套秩序

OpenMind 構建了一套可複用的基礎設施,讓機器人能跨設備、跨廠商、甚至跨國界協作與信息互通:

設備側:提供面向實體機器人的 AI 原生操作系統 OM1,把從感知到執行的全鏈路連成閉環,讓不同形態的機器都能理解環境並完成任務;

網絡側:構建去中心化協作網絡 FABRIC,提供身份、任務分配與通信機制,確保機器人在協作時能識別彼此、分配任務、共享狀態。

這一套“操作系統+網絡層”的組合,讓機器人們不僅能各自行動,更能在一個統一的協作網絡中互相配合、對齊流程、一起完成某個複雜任務。

OM1:面向實體世界的 AI 原生操作系統

就像手機需要 iOS 或 Android 來運行應用,機器人同樣需要一個操作系統來運行 AI 模型、處理傳感器數據、做出推理決策並執行動作。

OM1便為此而生,它是一個面向現實世界機器人的 AI 原生操作系統,讓它們能夠感知、理解、規劃並在各種環境中完成任務。與傳統、封閉的機器人控制系統不同,OM1 是開源、模塊化、硬件無關(hardware-agnostic)的,它可以運行人形、四足、輪式、機械臂等多種形態上。

四個核心環節:從感知到執行

OM1 把機器人智能拆解為四個通用步驟:Perception(感知) → Memory(記憶) → Planning(規劃) → Action(執行)。這套流程被 OM1 完整模塊化,並通過統一的數據語言打通,實現可組合、可替換、可驗證的智能能力構建。

OM1 的架構

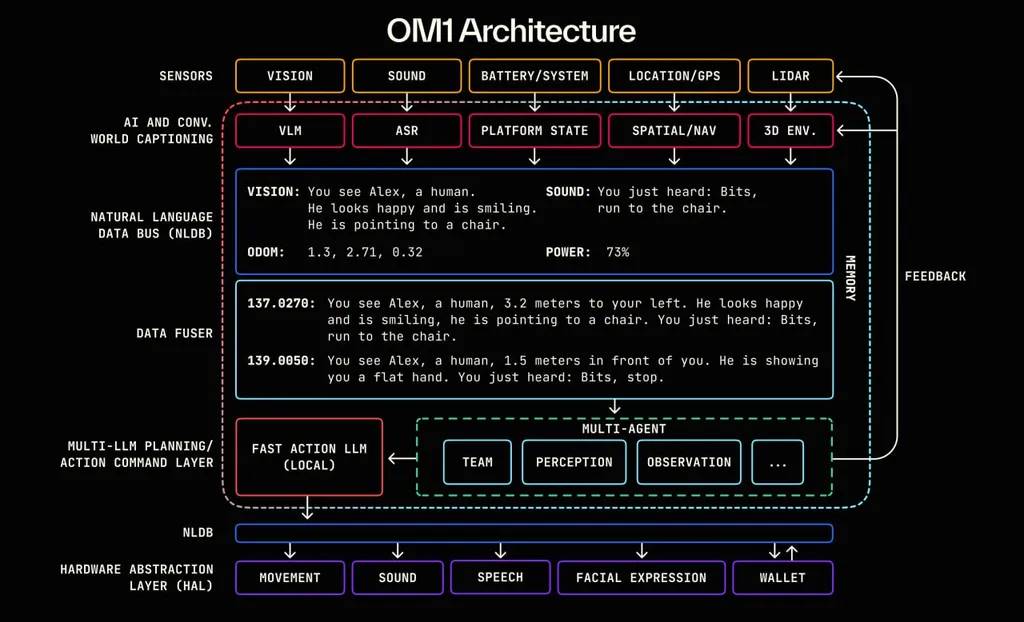

具體到架構,OM1 的七層鏈路如下:

Sensor Layer(傳感器層)收集信息:攝像頭、LIDAR、麥克風、電池狀態、GPS 等多模態進行感知輸入。

AI + World Captioning Layer(世界理解層)翻譯信息:多模態模型將視覺、語音、狀態轉為自然語言描述(如“你看到一個人在揮手”)。

Natural Language Data Bus(自然語言總線)傳遞信息:所有感知被轉成帶時間戳的語言片段,在不同模塊間傳遞。

Data Fuser(情境融合層)組合信息:整合多源輸入,生成用於決策的完整語境(prompt)。

Multi-AI Planning/Decision Layer(多智能體規劃層)生成決策:多個 LLM 讀取語境,結合鏈上規則生成行動計劃。

NLDB 下行通道:將決策結果通過語言中間層傳遞給硬件執行系統。

Hardware Abstraction Layer(硬件抽象層)做出行動:將語言指令轉為底層控制命令,驅動硬件執行(移動、語音播報、交易等)。

快速上手,廣泛落地

為了讓一個想法能儘快落地成機器人執行的任務,OM1 內置了這些工具:

快速新增技能:用自然語言和大模型,就能在數小時內給機器人添加新行為,而非幾個月的硬編碼。

多模態組合:輕鬆融合 LiDAR、視覺、聲音等感知,讓開發者不必自己寫複雜的傳感器融合邏輯。

預配置大模型接口:內置 GPT-4o、DeepSeek、VLMs 等語言/視覺模型,支持語音交互。

廣泛的軟硬件兼容:支持 ROS2、Cyclone DDS 等主流協議,與現有機器人中間件無縫銜接。無論是 Unitree G1 人形、Go2 四足,還是 Turtlebot、機械臂,都能直接接入。

對接 FABRIC:OM1 原生支持身份、任務協調和鏈上支付,讓機器人不僅能單機完成任務,還能參與全球協作網絡。

目前,OM1 已落地於多個真實場景:

Frenchie(Unitree Go2 四足機器狗):在 USS Hornet 國防技術展示 2024 中完成複雜場地任務。

Iris(Unitree G1 人形機器人):在 EthDenver 2025 Coinbase 展臺進行現場人機交互演示,並計劃通過 RoboStore 的教育項目進入全美高校課程。

FABRIC:去中心化的人機協作網絡

即便有了強大的大腦,如果機器人彼此之間無法安全、可信地協作,依舊只能各自為戰。現實中,不同廠商的機器人往往自建系統、各自為政,技能和數據無法共享;跨品牌甚至跨國協作則更加缺乏可信身份與標準規則。於是,一些難題出現了:

身份與位置證明:機器人怎麼證明自己是誰、在哪、在做什麼?

技能與數據共享:如何授權機器人共享數據、調用技能?

定義控制權:如何設定技能使用的頻率、範圍與數據回傳的條件?

FABRIC就是為解決這些問題而設計的。它是 OpenMind 打造的去中心化人機協作網絡,為機器人與智能系統提供身份、任務、通信與結算的統一基礎設施。你可以把它理解為:

像 GPS 一樣,讓機器人知道彼此在哪、是否接近、是否適合協作;

像 VPN 一樣,讓機器人們安全直連,不需要公網 IP 和複雜網絡設置;

像任務調度系統一樣,自動發佈、接收並記錄任務執行全過程。

核心應用場景

FABRIC 已可適配多種實用場景,包括但不限於:

遠程操控與監控:從任何地方安全控制機器人,無需專用網絡。

Robot-as-a-Service 市場:像打車一樣調用機器人,完成清潔、巡檢、配送等工作。

眾包地圖與數據採集:車隊或機器人實時上傳路況、障礙物、環境變化,生成可共享的高精地圖。

按需掃描/測繪:臨時調用附近機器人,完成 3D 建模、建築測繪或保險場景下的證據採集。

FABRIC 讓“誰在做事、在哪裡、完成了什麼”都可被驗證與追溯,也讓技能調用與任務執行有清晰的邊界。

長遠來看,FABRIC 將會成為機器智能的 App Store:技能可被全球授權調用,調用產生的數據反哺模型,推動協作網絡持續進化。

Web3 正在把“開放”寫進機器社會

現實中,機器人行業正在加速集中,少數平臺掌握硬件、算法和網絡,外部創新被擋在門外。而去中心化的意義就在於,無論機器人由誰製造、運行在哪個國家,都能在一個開放的網絡中合作、交換技能、結算報酬,而不必依附某個單一平臺。

OpenMind 用鏈上基礎設施,把協作規則、技能訪問權限、報酬分配方式寫成公開、可驗證、可改進的“網絡秩序”

可驗證身份:每臺機器人和每位操作員都會在鏈上註冊獨一無二的身份(ERC-7777 標準),硬件特徵、職責範圍、權限級別都透明可查。

公開分配任務:任務不是在封閉黑箱中分派,而是在公共規則下發布、競價、匹配;所有的協作過程會生成帶時間與位置的加密證明,上鍊存證。

自動結算與分潤:任務完成後,分潤、保險、押金的釋放或扣除將自動執行,任何參與方都能實時驗證結果。

技能自由流通:新技能可通過鏈上合約設置調用次數、適用設備等,既保護知識產權,也讓技能在全球範圍內自由流通。

這是一個所有參與者都能使用、監督和改進的協作秩序。對 Web3 用戶而言,這意味著機器人經濟從誕生之初就具備抗壟斷、可組合、可驗證的基因——這不僅是一個賽道機會,更是一次將“開放”刻進機器社會底層的機會。

讓具身智能走出孤島

無論是在醫院巡視病房,在學校學習新技能,還是在城市街區完成巡檢與建模,機器人都在逐漸走出“展臺演示”,成為人類日常分工的穩定組成部分。它們 24H 運作,遵守規則,有記憶且有技能,並能與人和其他機器自然協作。

要讓這些場景真正規模化落地,背後需要的不僅是更聰明的機器,還要有一套讓它們彼此可信、互通、協作的基礎秩序。OpenMind 已經用 OM1 和 FABRIC 在這條路上鋪下了第一批“路基”:前者讓機器人真正理解世界並自主行動,後者讓這些能力在全球網絡中流通。接下來,就是把這條路延伸到更多城市和網絡中,讓機器成為社會網絡中可依賴的長期夥伴。

OpenMind 的路線很明確:

短期:完成 OM1 核心功能原型和 FABRIC MVP,上線鏈上身份與基礎協作能力;

中期:在教育、家庭、企業中落地 OM1 和 FABRIC,連接早期節點、聚集開發者社區;

長期:把 OM1和 FABRIC 打造成全球標準,讓任何機器都可以像接入互聯網一樣接入這個開放的機器協作網絡,並形成可持續運行的全球機器經濟。

在 Web2 時代,機器人多被鎖定在單一廠商的封閉系統中,功能和數據無法跨平臺流動;而在 OpenMind 構建的世界中,它們是開放網絡的平等節點:能自由加入、學習、協作和結算,並與人類共同構成可信互聯的全球機器社會。OpenMind 提供的,正是讓這種轉變可規模化的能強大能力。