編者注:《Attention Is All You Need》論文發表於 2017 年,截止目前被引用超 11 萬次,它不僅是當今以 ChatGPT 為代表的大模型技術起源之一,其中介紹的 Transformer 架構和注意力機制也被廣泛用在了 Sora、AlphaFold 等眾多或將改變世界的 AI 技術之中。

「Attention Is All You Need」,這篇研究論文徹底改變了現代人工智能(AI)的未來。在這篇文章裡,我將深入探討 Transformer 模型和 AI 的未來。

2017 年 6 月 12 日,八位谷歌工程師發表了一篇名為「Attention Is All You Need」的研究論文,這篇論文討論了一種改變現代 AI 未來的神經網絡架構。

而就在剛剛過去的 2024 年 3 月 21 日的 GTC 大會,英偉達創始人黃仁勳與那 8 位 Google 工程師進行了一次小組討論,並感謝他們引入了 Transformer 架構,使現代 AI 成為可能,令人驚訝的是,NEAR 的創始人居然也在這份 8 人名單之中。

什麼是 Transformer?

Transformer 是一種神經網絡。

什麼是神經網絡?它受人類大腦結構和功能的啟發,通過大量的人工神經元互相連接進行信息處理,但卻並不是人類大腦的完全複製品。

簡單理解的話,人腦就如同亞馬遜雨林,擁有許多不同的區域,以及連接這些區域的眾多通路。而神經元就好比這些通路間的連接器,它們可以向雨林的任何部分發送和接收信號,因此連接就是通路本身,負責聯通兩個不同的腦部區域。

這讓我們的大腦擁有非常強大的學習能力,它可以快速學習、識別模式並提供準確的輸出結果。而像 Transformer 這樣的神經網絡試圖實現與人類大腦相同的學習能力,只不過它們目前的技術水平還達不到人類大腦的 1%。

近年來,Transformer 在生成式 AI 方面取得了令人矚目的進步。回顧現代人工智能的演變歷程,我們可以看到早期的人工智能主要是像 Siri 以及其他一些語音 / 識別應用程序。

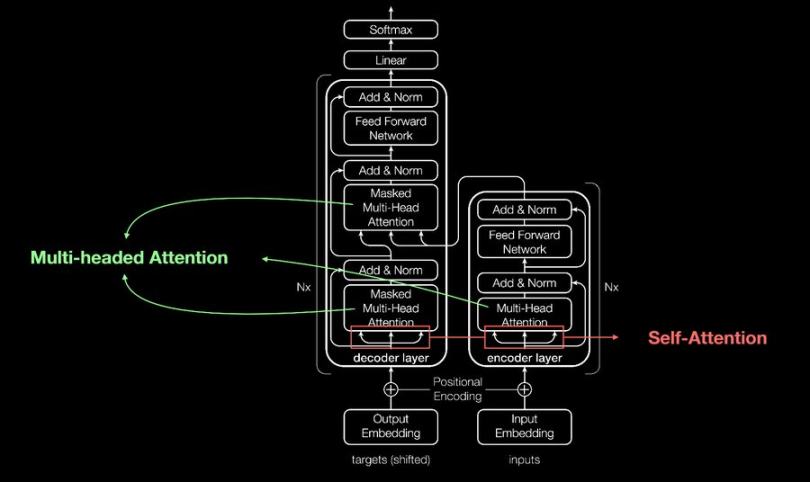

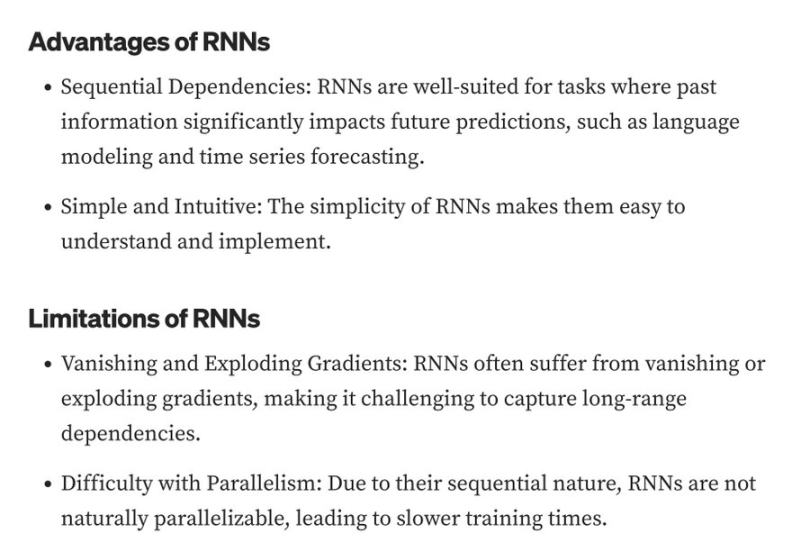

這些應用程序都使用循環神經網絡(RNN)構建。RNNs 存在一些限制,而這些限制已經被 Transformers 所解決並改進——Transformers 引入了自注意力機制,使它們能夠同時分析任一序列的所有部分,從而捕捉長距離依賴關係和上下文內容。

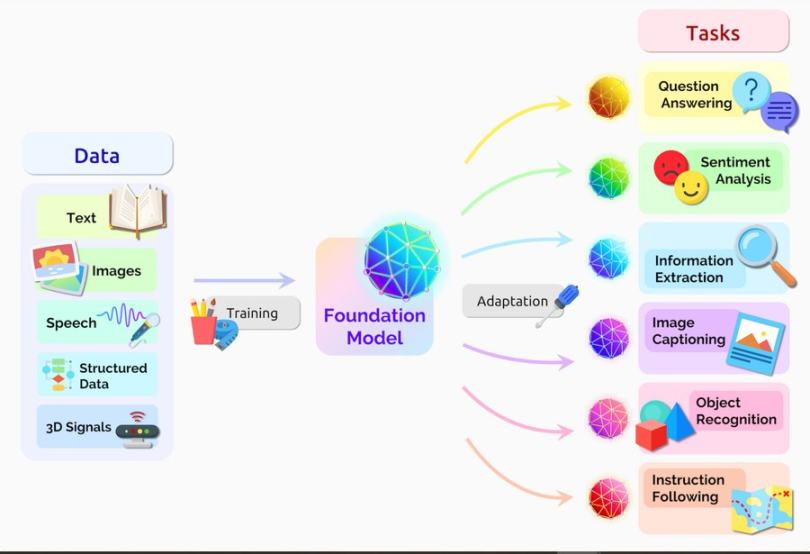

對於 Transformer 的創新週期來說,我們仍處於非常早期階段。Transformer 有幾種不同的衍生版本,例如 XLNet、BERT 和 GPT。

而 GPT 是其中最知名的一種,但它在事件預測方面仍然能力有限。

當大型語言模型(LLM)能夠根據過去數據和模式預測事件時,這將標誌著現代 AI 的下一個重大飛躍階段,並且也將加速我們實現通用人工智能(AGI)的步伐。

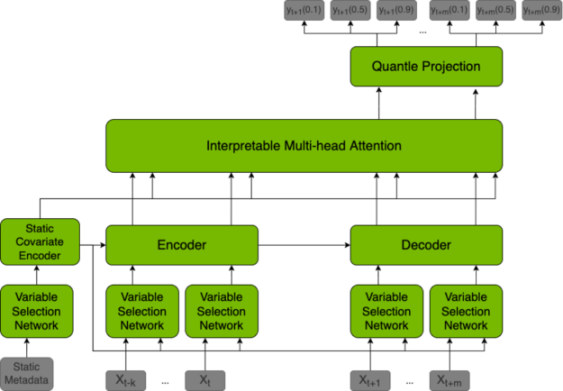

為了實現這種預測能力,大型語言模型(LLM)需要採用時間融合轉換器(TFT),它是一種基於不同數據集預測未來值的模型,還能夠解釋其做出的預測。

TFT 除了用於預測之外,還可以用於區塊鏈領域。通過在模型中定義特定規則,TFT 可以自動執行以下操作:有效管理共識過程、提高出塊速度、獎勵誠實驗證者、懲罰惡意驗證者。

區塊鏈網絡本質上可以為具有較高聲譽分數的驗證者提供更多的區塊獎勵,這可以基於他們的投票歷史、區塊提案歷史、Slash 歷史、Staking 金額、活躍度和其他一些參數來建立。

公鏈的共識機制本質上是驗證者之間的一種博弈,需要超過三分之二的驗證者就誰來創建下一個區塊達成一致。在這個過程中,可能會出現許多分歧和爭論,這也是以太坊等公鏈網絡效率低下的一個因素。

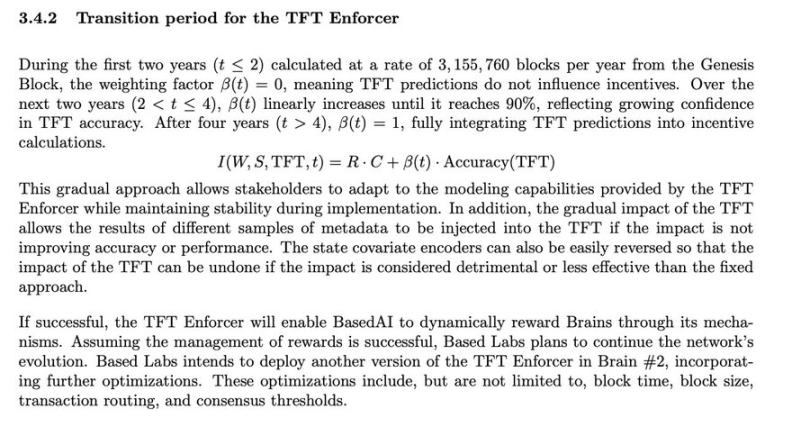

TFT 可以作為一種共識機制,通過提升出塊時間並根據區塊生產信譽獎勵驗證者,從而提高效率。譬如將 TFT 模型應用於共識過程的 BasedAI,就是將利用該模型在驗證者和網絡參與者之間分配代幣發行量。

BasedAI 還提出利用 FHE 技術,讓開發者可以在其名為「Brains」的去中心化 AI 基礎設施上託管隱私保護的大型語言模型(Zk-LLMs),通過將 FHE 技術集成到大型語言模型中,可以做到在用戶選擇啟用個性化 AI 服務時,保護他們的隱私數據。

當人們確信數據會受到加密保護並且完全隱私的前提下,願意貢獻數據的時候,或許我們就將實現通用人工智能(AGI)的突破,這一空白正在由專注於隱私的技術填補,例如 nillionnetwork Blind Computation 、零知識機器學習(ZkML)和同態加密(FHE)技術。

然而,所有這些注重隱私保護的技術都需要大量的計算資源,這使得它們還處於應用的早期階段。