2월 18일 베이징 시간, 엘런 머스크와 xAI 팀이 Grok3의 최신 버전을 공식 출시했습니다.

이번 발표회 전부터 관련 정보를 공개하고 머스크 본인이 24/7 쉼 없이 예열 홍보를 하면서, 전 세계적으로 Grok3에 대한 기대감이 전례 없이 높아졌습니다. 일주일 전 머스크는 라이브 방송에서 DeepSeek R1을 언급하며 "xAI가 더 뛰어난 AI 모델을 곧 출시할 것"이라고 자신감 있게 말했습니다.

현장 데모 결과를 보면 Grok3가 수학, 과학, 프로그래밍 벤치마크에서 기존 주류 모델을 이미 뛰어넘었고, 머스크는 Grok3를 향후 SpaceX 화성 탐사 계산에 사용할 것이며 "3년 내 노벨상급 돌파를 이룰 것"이라고 주장했습니다.

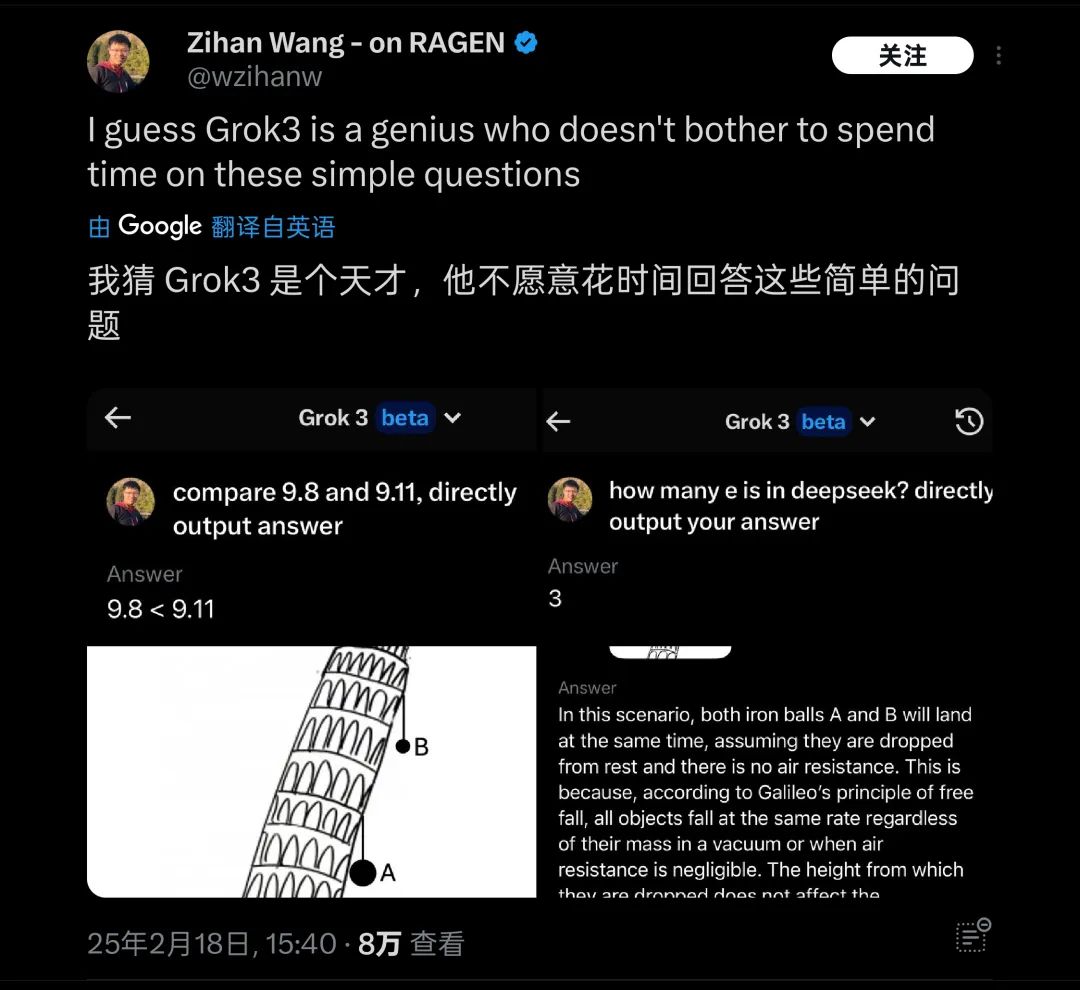

하지만 이는 현재 머스크의 일방적인 주장일 뿐입니다. 필자는 출시 후 최신 베타 버전 Grok3를 테스트했고, 대형 모델을 괴롭히는 고전적인 문제를 제기했습니다: "9.11과 9.9 중 어느 것이 더 큰가요?"

안타깝게도 어떤 수식이나 표시 없이, 현재 가장 지적이라고 자부하는 Grok3도 이 문제를 정확히 답변하지 못했습니다.

Grok3가 이 문제의 의미를 정확히 파악하지 못했습니다 | 출처: 极客公园

이 테스트 결과가 공개된 후 곧바로 많은 사람들의 관심을 끌었고, 해외에서도 "피사의 사탑 위 두 공이 어느 것이 먼저 떨어지는가" 등 기초 물리/수학 문제로 Grok3를 시험했는데, 여전히 대응하지 못하는 것으로 드러났습니다. 이에 "천재도 단순한 질문에 대답하기 싫어한다"는 비아냥을 받았습니다.

Grok3가 실제 테스트에서 많은 상식 문제에 실패했습니다 | 출처: X

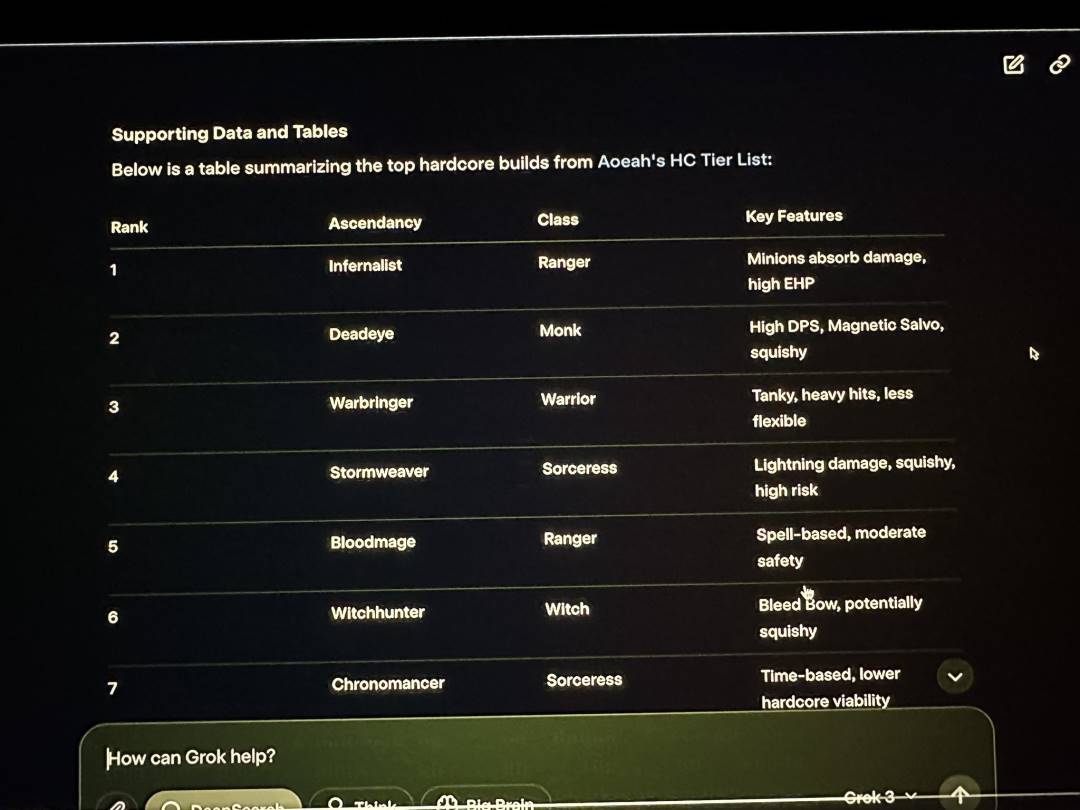

네티즌들이 자발적으로 테스트한 기초 지식 문제 외에도, xAI 발표회 생방송에서 머스크가 Grok3로 자신이 자주 플레이한다는 Path of Exile 2의 직업과 승화 효과를 분석했지만, Grok3가 제공한 대부분의 답변이 잘못되었습니다. 생방송에서 머스크는 이 명백한 문제를 발견하지 못했습니다.

Grok3가 생방송에서도 많은 데이터 오류를 보였습니다 | 출처: X

이 실수는 해외 네티즌들이 다시 한번 머스크가 게임을 "대리 플레이"한다고 비난할 수 있는 증거가 되었고, 동시에 Grok3의 실제 적용 가능성에 대한 의문을 다시 제기했습니다.

이런 "천재"의 경우, 실제 능력이 어떻든 화성 탐사 임무와 같은 극도로 복잡한 응용 분야에 사용되려면 신뢰성에 큰 의문이 제기될 것입니다.

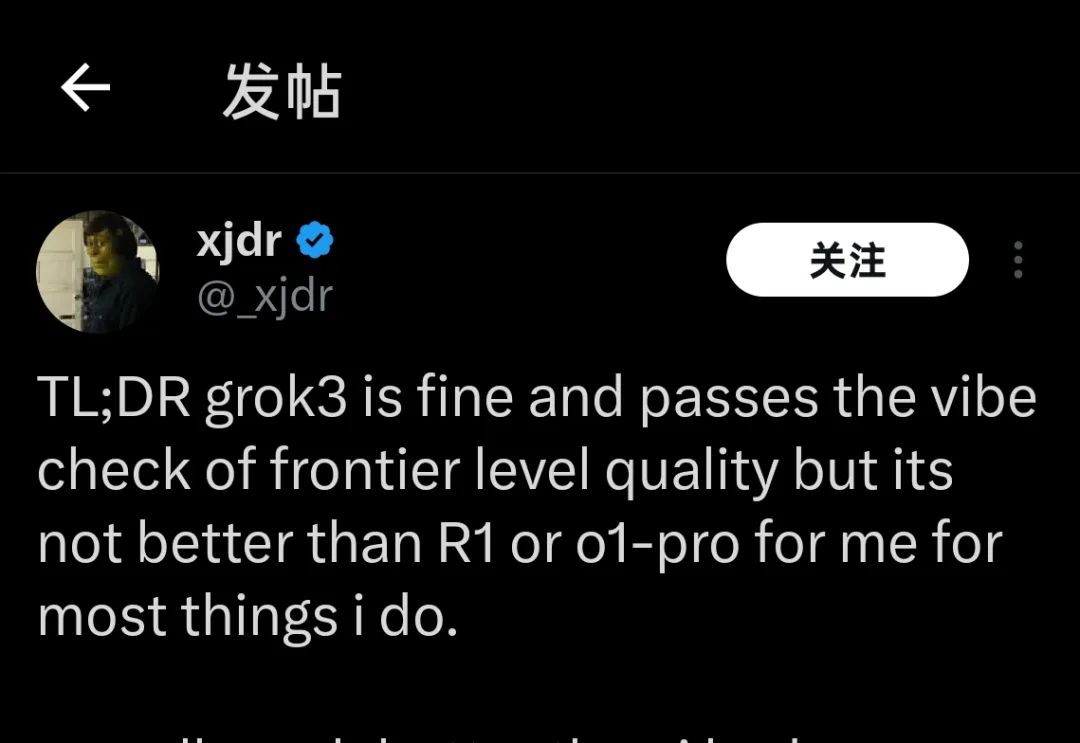

현재 몇 주 전 Grok3 테스트 자격을 얻었거나 어제 막 몇 시간 사용해본 모델 능력 테스터들은 Grok3의 현재 성능에 대해 동일한 결론을 내리고 있습니다:

"Grok3는 좋지만 R1이나 o1-Pro보다 나은 것은 아니다"

"Grok3는 좋지만 R1이나 o1-Pro보다 나은 것은 아니다" | 출처: X

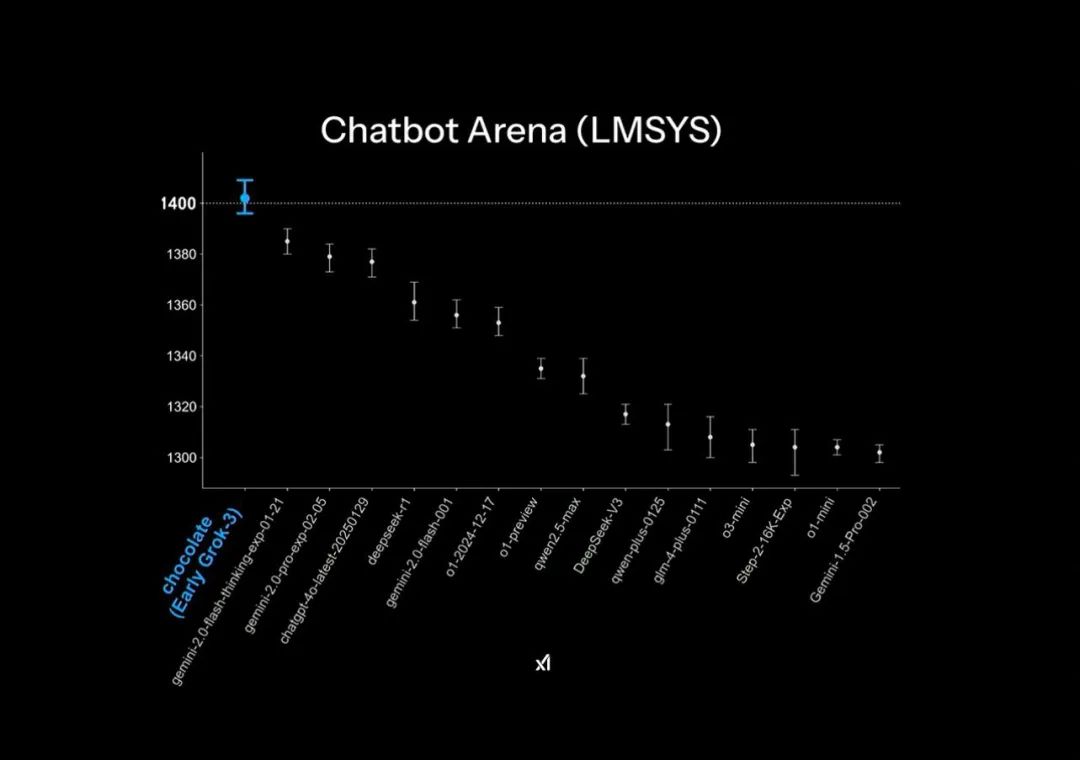

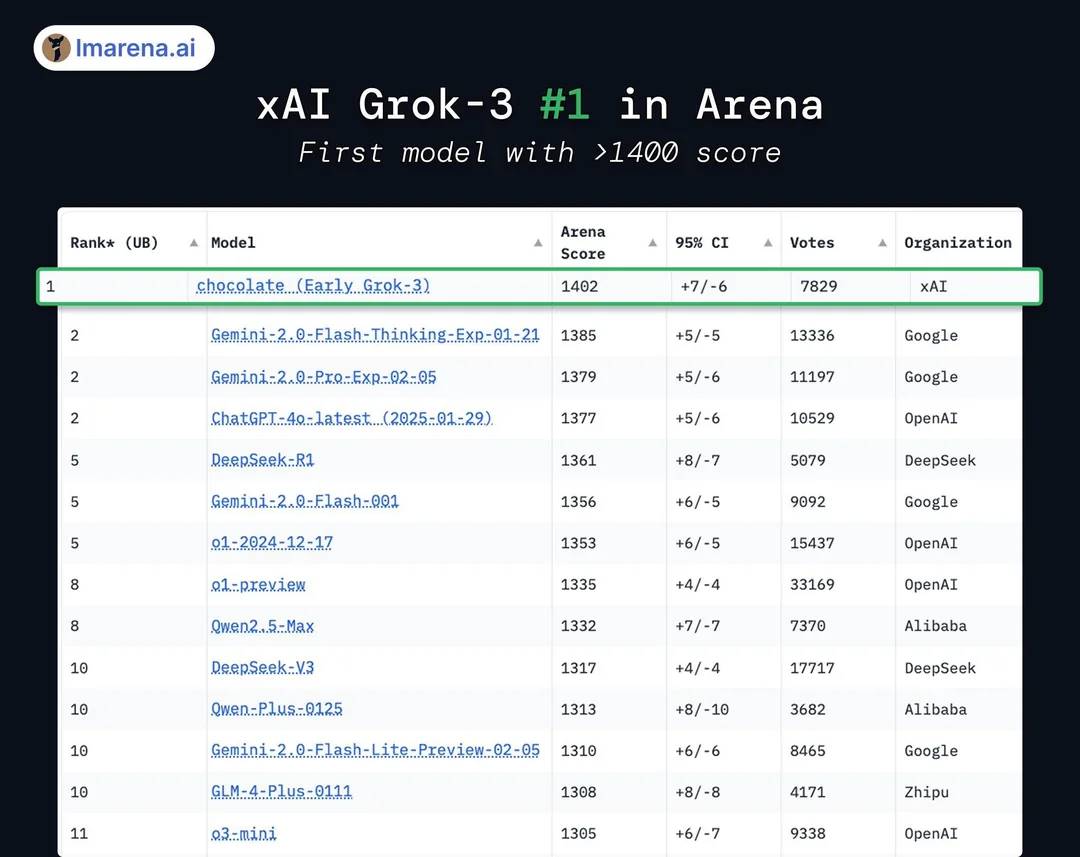

Grok3의 공식 PPT에서는 대형 모델 경쟁 Chatbot Arena에서 "압도적으로 선두"를 달리고 있지만, 이는 일부 작은 그래픽 기법을 사용한 것입니다: 순위표의 세로축에 1400-1300점 구간만 표시해 원래 1% 수준의 테스트 결과 차이가 PPT에서는 매우 두드러지게 보이도록 했습니다.

공식 발표 PPT의 "압도적 선두" 효과 | 출처: X

실제 모델 벤치마크 결과, Grok3는 DeepSeek R1과 GPT4.0에 불과 1-2%의 차이만 보였습니다: 이는 많은 사용자들이 실제 테스트에서 "뚜렷한 차이가 없다"고 느낀 것과 일치합니다.

실제로 Grok3는 후발주자보다 1%-2%만 높았습니다 | 출처: X

또한 점수 면에서 Grok3가 현재 공개 테스트된 모든 모델을 넘어섰지만, 이를 인정하는 사람은 많지 않습니다: 결국 xAI는 Grok2 시대부터 이 순위표에서 "점수 조작"을 해왔고, 순위표가 답변 길이와 스타일에 대한 가중치 조정으로 점수를 크게 낮추자 "높은 점수 낮은 능력"이라는 비판을 받아왔기 때문입니다.

순위표 "점수 조작"이든 그래픽 설계의 "작은 기술"이든, 이는 xAI와 머스크 본인이 모델 능력의 "압도적 선두"라는 점에 집착하고 있음을 보여줍니다.

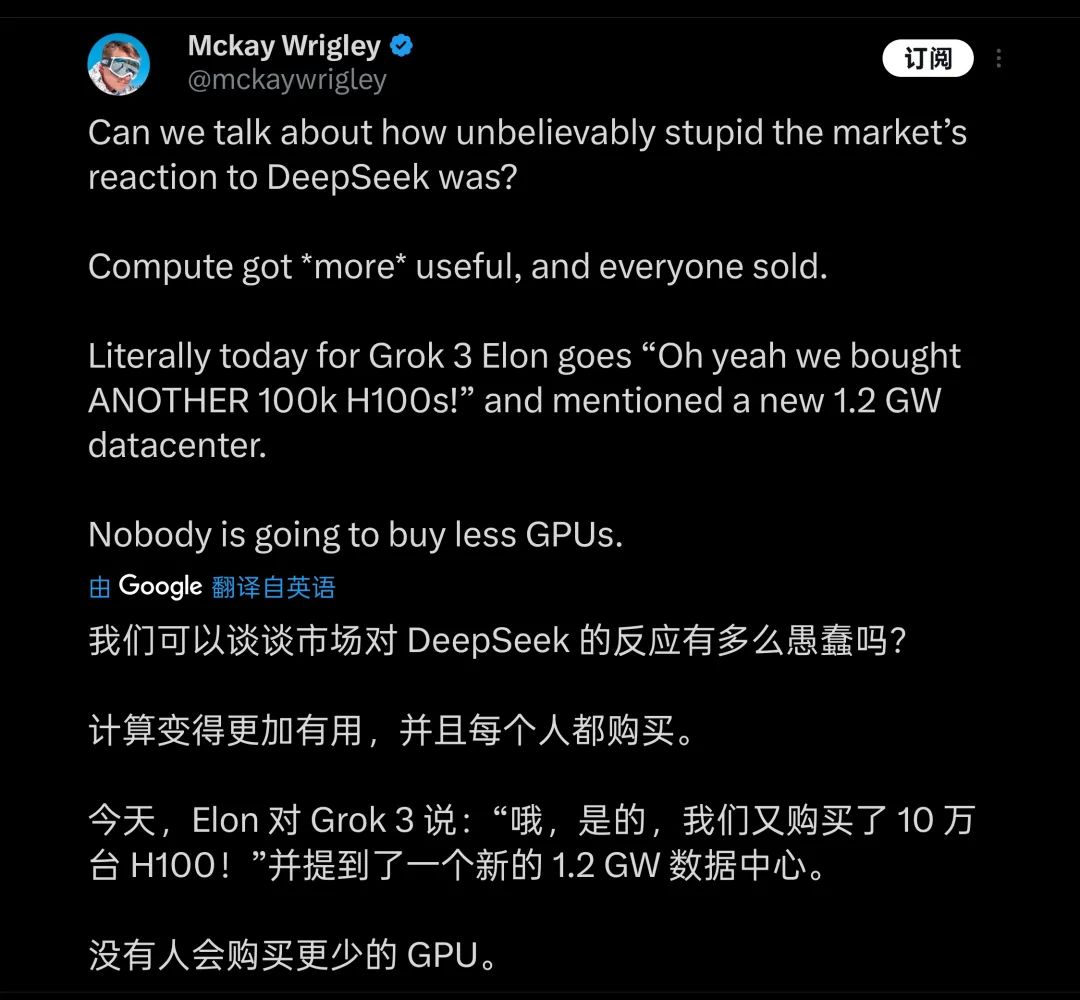

이런 차이를 위해 머스크가 지불한 대가는 엄청납니다: 발표회에서 머스크는 거의 자랑하듯이 20만 장의 H100(머스크는 "10만 장 이상"이라고 말했습니다) 을 사용해 Grok3를 학습했고, 총 학습 시간은 2억 시간에 달한다고 밝혔습니다. 이에 일부 사람들은 GPU 산업에 또 다른 큰 호재가 될 것이라고 보고, DeepSeek가 산업에 가져온 충격은 "어리석다"고 생각합니다.

많은 사람들이 연산력 쌓기가 모델 학습의 미래가 될 것이라고 생각합니다 | 출처: X

하지만 실제로 네티즌들이 2000장의 H800으로 2개월 동안 학습한 DeepSeek V3와 비교해보니, Grok3의 실제 학습 연산력 소모가 V3의 263배라는 것이 밝혀졌습니다. 그런데 DeepSeek V3와 Grok3의 1402점 차이는 100점도 되지 않습니다.

이런 데이터가 공개된 후 많은 사람들이 빠르게 깨달았습니다. Grok3가 "세계 최강"에 오른 배경에는 모델이 커질수록 성능이 강해진다는 논리가 명확히 나타나는 한계점이 있습니다.

심지어 "높은 점수 낮은 능력"의 Grok2도 X(Twitter) 플랫폼 내 방대한 고품질 1차 데이터를 바탕으로 했습니다. 그런데 Grok3 학습에 이르러 xAI도 OpenAI가 현재 겪고 있는 "천장"—양질의 학습 데이터 부족—에 직면했고, 모델 능력의 한계점이 빠르게 드러났습니다.

이런 사실을 가장 먼저 인식하고 가장 깊이 이해한 사람은 Grok3 개발팀과 머스크일 것입니다. 따라서 머스크는 소셜미디어에서 현재 사용자가 경험하는 버전은 "테스트 버전에 불과하다", "완성된 버전은 향후 몇 개월 내 출시될 것"이라고 계속 말하고 있습니다. 머스크 본인은 Grok3 제품 매니저가 되어 사용자들에게 직접 댓글로 문제점을 제안하라고 권유하고 있습니다.

그는 아마도 지구상 팬 수가 가장 많은 제품 매니저일 것입니다 | 출처: X

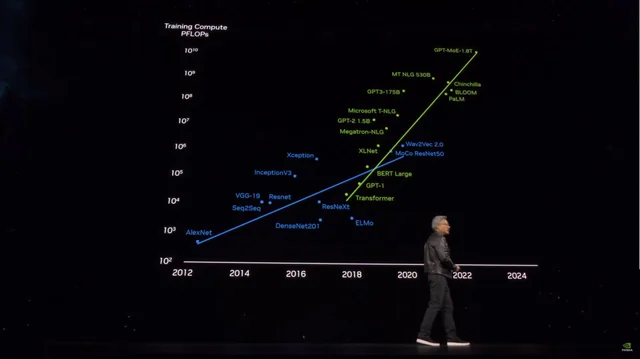

하지만 하루도 지나지 않아 Grok3의 성능이 "거대 모델 학습"에 의지하는 후발주자들에게 경종을 울렸습니다: 마이크로소프트가 공개한 정보에 따르면 OpenAI GPT4의 매개변수 규모가 1.8조 개로, GPT3 대비 10배 이상 증가했고, 소문의 GPT4.5는 매개변수 규모가 더 클 것으로 전해집니다.

모델 매개변수 규모가 급증하면서 학습 비용도 폭등하고 있습니다 | 출처: X

Grok3의 사례를 보면, GPT4.5와 더 많은 "돈을 태워" 매개변수 규모로 더 나은 모델 성능을 얻으려는 선수들은 이제 눈앞에 다가온 한계점을 어떻게 극복할지 고민해야 할 것입니다.

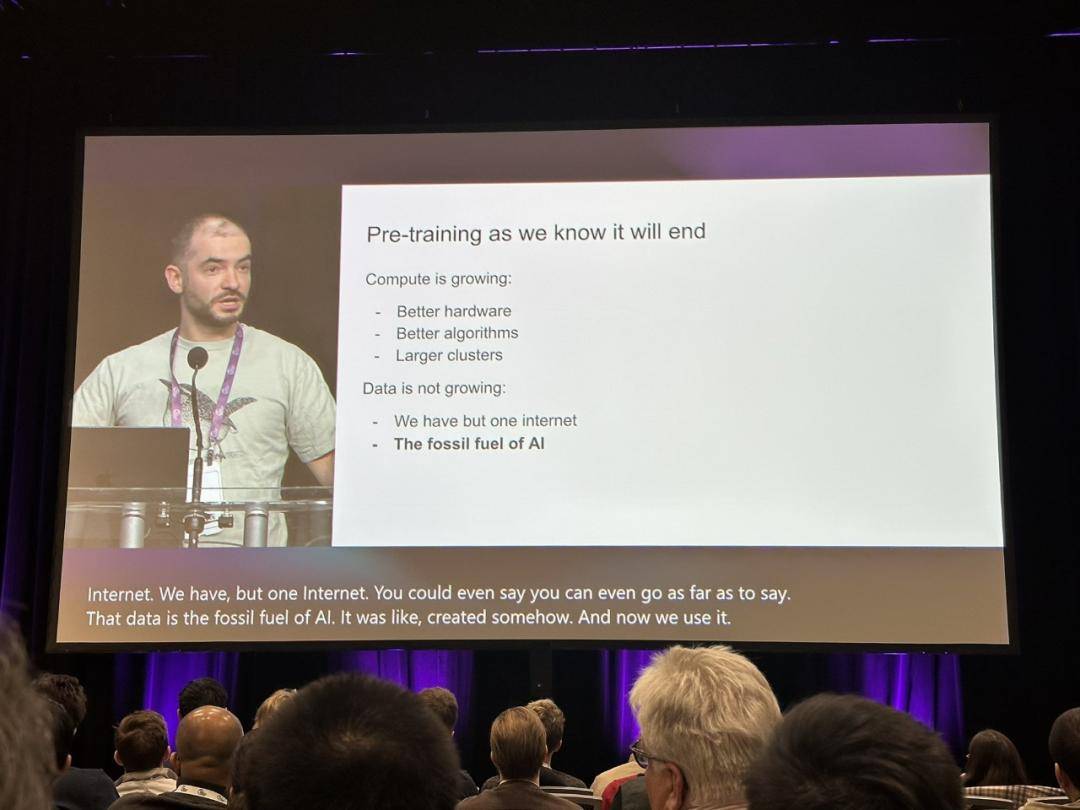

이 시점에서 OpenAI의 전 최고 과학자 Ilya Sutskever가 지난해 12월 "우리가 알고 있는 사전 학습은 끝날 것"이라고 말한 의견이 다시 주목받고 있으며, 업계가 대형 모델 학습의 진정한 돌파구를 찾고자 노력하고 있습니다.

Ilya의 견해가 업계에 경종을 울리고 있습니다 | 출처: X

당시 Ilya는 새로운 데이터가 고갈되면서 모델이 더 이상 데이터 확보로 성능을 높이기 어려운 상황을 정확히 예견했고, 이를 화석 연료 소비에 비유하며 "사람이 생성한 인터넷 콘텐츠도 유한한 자원과 같다"고 표현했습니다.

在 Sutskever 预测中,预训练模型之后的下一代模型将会有「真正的自主性」。同时将具备「类似人脑」的推理能力。

与如今预训练模型主要依赖的内容匹配(基于模型此前学习的内容)不同,未来的 AI 系统将能够以类似于人脑「思维」的方式,来逐步学习并建立起解决问题的方法论。

人类对某一个学科做到基本的精通,只需要基本专业书籍即可实现,但 AI 大模型却需要学习数以百万计的数据才能实现最基础的入门效果,甚至当你换了个问法之后,这些基础的问题也无法正确理解,模型在真正的智能上并没有得到提升:文章开头提到的那些基础但 Grok3 仍然无法正确回答的问题,就是这种现象的直观体现。

但在「力大飞砖」之外,Grok3 如果真的能向行业揭示「预训练模型即将走到尽头」这个事实,那它对行业仍然称得上有着重要的启发意义。

或许,在 Grok3 的狂潮逐渐褪去之后,我们也能看到,更多类似李飞飞「在特定数据集的基础上 50 美元微调出高性能模型」的案例出现。并在这些探索中,最终找到真正通向 AGI 的道路。