이 기사는 기계로 번역되었습니다

원문 표시

다음은 한국어 번역입니다:

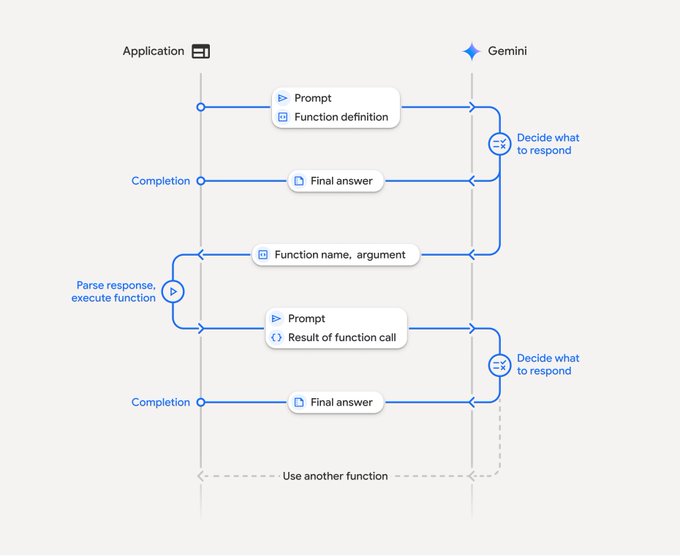

에이전트 개발의 핵심 기술인 tool-call에 대해 말하고 싶습니다. 많은 사람들이 알고 있을 것이라 생각했지만, 회사에서 강의하는 동안 실제로는 모르는 사람들이 많다는 것을 발견했습니다. function_calling이든 MCP 호출이든 명시적 및 암시적 두 가지 방식이 있습니다.

1️⃣암시적 호출: 현대적인 자동 도구 실행

최근의 LLM은 자동 도구 호출 기능을 내장하고 있습니다. 예를 들어 (automatic_function_calling 플래그를 통해 이 기능을 제어할 수 있습니다). 공식 문서와 예시가 대부분 암시적 호출에 중점을 두고 있어, 최근 2개월 동안 MCP 개발을 시작한 경우 아마도 계속 암시적 모드를 사용했을 것입니다.

암시적 모드에서는 전체 도구 호출 프로세스가 개발자에게 블랙박스입니다. LLM이 자동으로 도구 호출 필요성을 판단하고, 적절한 도구와 매개변수를 선택하며, 도구를 자동으로 실행하고 결과를 통합합니다. 개발자는 단순히 도구 목록을 제공하면 최종 자연어 답변을 직접 얻을 수 있습니다.

암시적 방식은 더 새로운 기술이며 미래의 트렌드입니다. 대규모 모델의 능력이 진화함에 따라 이 방식이 주류가 될 것입니다.

똑똑한 학생들은 이미 예상했겠지만, 찬사 후에는 전환점이 옵니다. 맞습니다. 암시적 방식에는 현재로서는 피하기 어려운 단점이 있습니다.

马东锡 NLP

@dongxi_nlp

07-15

Kimi K2 的一大亮点,是将文本任务里基于 token 的处理思路,成功迁移到 Agentic 场景中的 tool-call 级别:在 Agentic 任务中,tool call 就相当于“行动 token”。

什么意思呢?解释如下:

在文本任务中:

CoT 是一串 token

而在Agentic 场景中:

CoT 是一段 tool-call 序列,即planning

3️⃣명시적 호출: 정밀한 제어를 갖춘 수동 구문 분석 모드

반대로, 명시적 호출 모드에서는 개발자가 도구 호출의 각 단계를 수동으로 처리해야 합니다. 시스템 프롬프트에서 LLM에 도구 호출 요청의 형식을 지정하는 방법을 지정한 다음, LLM 응답에서 도구 호출 지침을 수동으로 구문 분석하고, 해당 도구를 실행한 후, 결과를 최종 응답에 통합해야 합니다.

이는 MCP를 호출하는 오래된 방식(비록 전통적으로 사용된 지 반 년 정도밖에 되지 않았지만)이며, 암시적 호출은 LLM이 이 부분만 처리합니다.

그러나 실제 개발에 사용되는 명시적 호출은 완전히 오래된 것은 아닙니다.

4️⃣ 반자동 백필 디스플레이 호출

메서드 이름은 제가 임의로 선택합니다. 구체적인 방법은 매우 간단합니다. 사용자 쿼리에 대한 LLM 도구 목록을 MCP 클라이언트에 제공하고, 도구 자체를 호출하지 않고 호출할 도구의 이름을 반환하도록 요청해야 합니다.

다음으로, 클라이언트가 MCP 서버를 수동으로 호출하도록 해야 합니다. 이 데이터는 일반 API에서 반환된 형식화된 JSON 데이터일 가능성이 높으므로, 이 데이터와 LLM 응답을 캡슐화하여 반환할 수 있습니다.

이 방법은 여러 차례의 LLM 대화가 필요하기 때문에 널리 적용되지 않으며, 단일 대화보다 훨씬 더 번거롭습니다. 동시에, MCP 호스트는 모든 것을 관리하는 완전한 범용 채팅 클라이언트가 아닌 것이 좋습니다. 이는 고정 서비스에 더 적합합니다.

하지만 원시 데이터를 사용하면 데이터를 완전히 자유롭게 처리할 수 있고, 데이터 처리 및 UI 표시 코드에서 이전 서비스의 부분을 직접 재사용할 수 있다는 장점이 있습니다. 이 방법은 자동 도구 호출 기능이 없는 LLM과 호환됩니다. 제가 이끄는 저희 회사의 새로운 서비스에서도 이 방법을 도입했는데, 반응이 좋습니다.

다른 방법이 있을까요? 여러분의 경험을 듣고 싶습니다.

@dotey @chaowxyz @hylarucoder @yihong0618 @pangyusio

Substack 버전: open.substack.com/pub/web3rove...…

퀘일리:

quaily.com/cryptonerdcn/p/disc...…

@lyricwai @QuailyQuaily

다양한 오해에 대한 몇 가지 대응:

CryptoNerdCn

@cryptonerdcn

07-16

其实何止大模型输入需要在上下文里提供足够的信息呢,人类也是需要的。昨天我因为在这贴里忘了付上公司讲课时分享的前半段,就被几位质疑,又是觉得我在说“LLM有执行能力”,又是“我还以为是什么行业突破,没想到是细枝末节”😂 x.com/cryptonerdcn/s…

Twitter에서

면책조항: 상기 내용은 작자의 개인적인 의견입니다. 따라서 이는 Followin의 입장과 무관하며 Followin과 관련된 어떠한 투자 제안도 구성하지 않습니다.

라이크

즐겨찾기에 추가

코멘트

공유