1849년 캘리포니아에서 금이 발견되었다는 소식이 퍼지면서 골드러시가 시작되었습니다. 이 새로운 땅에는 동해안 출신, 유럽 대륙 출신, 그리고 미국으로 건너온 중국인 이민자 1세대 등 셀 수 없이 많은 사람들이 이곳을 처음에는 '황금산'이라고 불렀고, 나중에는 '황금산'이라고도 불렀다. 골든 마운틴". "샌프란시스코".

하지만 어찌 되었든 이 새로운 땅에 온 금광꾼들에게는 식량, 의복, 주택, 교통수단이 필요했고, 물론 가장 중요한 것은 금 채굴 장비인 삽이었습니다. “일꾼이 일을 잘하려면 먼저 연장을 갈어야 한다”는 말이 있듯이, 사람들은 금을 더 효율적으로 사려고 삽 장수들에게 미친 듯이 몰려들기 시작했고, 그들의 부도 함께 가져갔습니다.

100여년 후, 샌프란시스코에서 멀지 않은 남쪽에서 실리콘밸리의 두 회사가 새로운 골드러시를 시작했습니다. OpenAI는 AI 시대에 최초로 '금광'을 발견했고, Nvidia는 최초의 '삽'이 되었습니다. 파는 사람." 과거와 마찬가지로 수많은 사람들과 기업들이 이 새로운 뜨거운 땅에 쏟아져 들어오기 시작했고, 새로운 시대의 '삽'을 들고 금을 캐기 시작했습니다.

차이점은 과거에는 삽에 대한 기술적 한계가 거의 없었지만 오늘날에는 Nvidia의 GPU가 모든 사람의 선택이라는 점입니다. 올해 초부터 ByteDance만 해도 A100 및 H800 가속기 카드 100,000개를 포함하여 Nvidia에 10억 달러 이상의 GPU를 주문했습니다. Baidu, Google, Tesla , Amazon, Microsoft... 이들 대기업은 올해 Nvidia에 최소 수만 개의 GPU를 주문했습니다.

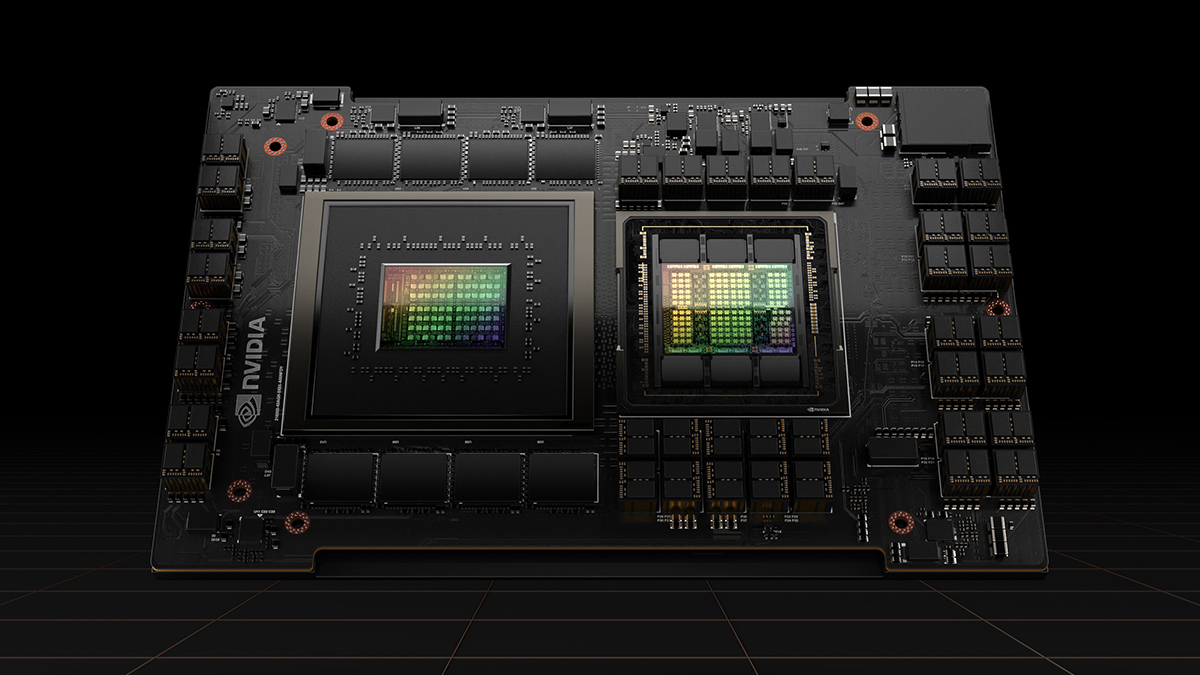

H100 GPU, 사진/NVIDIA

하지만 아직 충분하지 않습니다. Megvii Technology CEO Yin Qi는 3월 말 Caixin과의 인터뷰에서 중국에서는 대형 모델 훈련에 사용할 수 있는 A100이 약 40,000대에 불과하다고 말했습니다. AI 열풍이 계속되면서 엔비디아의 이전 세대 하이엔드 GPU A100의 거세 버전인 A800은 한때 중국에서 10만 위안을 돌파하기도 했습니다.

6월 비공개 회의에서 OpenAI CEO인 Sam Altman은 GPU의 심각한 부족으로 인해 ChatGPT 최적화에 대한 많은 작업이 연기되었다고 다시 한 번 밝혔습니다. 기술 컨설팅 회사인 TrendForce의 계산에 따르면 OpenAI는 ChatGPT의 지속적인 최적화 및 상용화를 지원하기 위해 약 30,000개의 A100이 필요합니다.

올해 1월 ChatGPT가 새로 발생한 것을 감안하더라도 AI 해시레이트 부족이 거의 반년 동안 지속되었는데, 이들 대기업은 왜 여전히 GPU와 해시레이트 부족합니까?

ChatGPT 사용자에게 그래픽 카드가 부족합니까? 빠진 것은 NVIDIA입니다

광고 슬로건을 빌리자면 모든 GPU가 NVIDIA인 것은 아닙니다. GPU 부족은 본질적으로 Nvidia의 고급 GPU 부족입니다. AI 대형 모델 훈련의 경우 NVIDIA A100 또는 H100 GPU를 선택하거나 작년 금지 이후 NVIDIA가 특별히 출시한 A800 및 H800의 축소된 구성 버전을 선택할 수 있습니다.

AI의 활용에는 훈련(training)과 추론(inference)이라는 두 가지 링크가 있는데, 전자는 모델을 만드는 것으로 이해될 수 있고, 후자는 모델을 사용하는 것으로 이해될 수 있다. 대규모 AI 모델의 사전 훈련 및 미세 조정, 특히 사전 훈련 프로세스는 해시레이트 , 특히 단일 GPU가 제공하는 성능과 여러 카드 간의 데이터 전송 기능을 대량 소비합니다. 그러나 오늘날에는 대형 모델 사전 훈련 컴퓨팅 효율성을 제공할 수 있는 AI 칩이 있습니다(넓은 의미에서 AI 칩은 AI용 칩만을 의미함).

나는 별로 말할 수 없고 아주 조금만 말할 수 있다.

대형 모델의 매우 중요한 특징은 최소 수천억 개의 매개변수가 있어 학습을 위해 엄청난 양의 해시레이트 필요하다는 것입니다. 여러 GPU 간의 데이터 전송 및 동기화로 인해 일부 GPU 해시레이트 유휴 상태가 되므로 더 높을수록 단일 GPU의 성능, 숫자가 작을수록 GPU 활용 효율성이 높아지고 해당 비용은 낮아집니다.

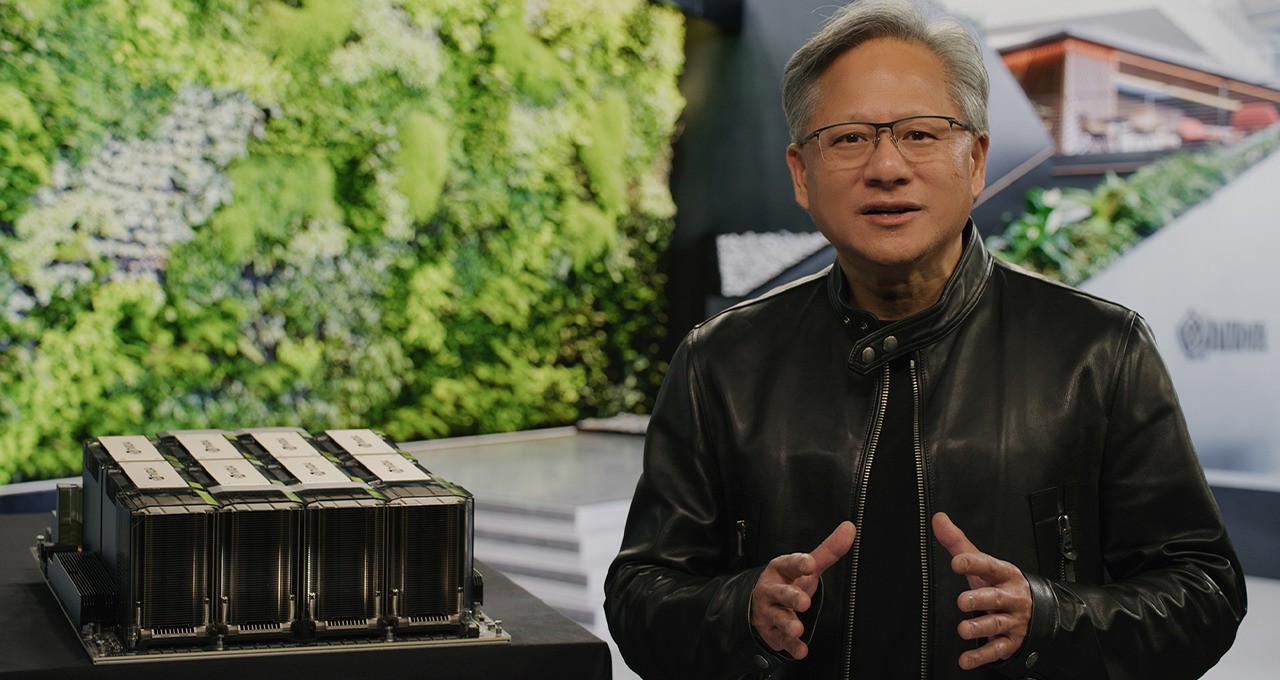

NVIDIA DGX H100 AI 슈퍼컴퓨터, 사진/NVIDIA

2020년부터 Nvidia가 출시한 A100과 H100은 단일 카드의 높은 해시레이트 과 높은 대역폭의 장점을 동시에 갖고 있습니다. A100의 FP32 해시레이트 19.5 TFLOPS(초당 수조 부동 소수점 연산)에 도달하고, H100은 134 TFLOPS에 달합니다.

동시에 NVLink 및 NVSwitch와 같은 통신 프로토콜 기술에 대한 투자는 Nvidia가 더 깊은 해자를 구축하는 데 도움이 되었습니다. H100에서 4세대 NVLink는 PCIe 5.0 대역폭의 7배인 900GB/s의 총 대역폭으로 최대 18개의 NVLink 링크를 지원할 수 있습니다.

중국 시장을 겨냥한 A800과 H800의 해시레이트 거의 변함이 없다. 규제 표준을 피하기 위해 대역폭이 각각 1/4과 1/2 정도 줄어들었기 때문이다. Bloomberg에 따르면 H800은 동일한 AI 작업에 대해 H100보다 10% -30% 더 많은 시간이 소요됩니다.

하지만 그럼에도 불구하고 A800과 H800의 컴퓨팅 효율성은 여전히 다른 GPU 및 AI 칩보다 뛰어납니다. AI 추론 시장에서는 주요 클라우드컴퓨팅 기업과 다른 GPU 기업들이 자체 개발한 AI 칩을 비롯해 일정 점유율 점유할 수 있는 '백 송이의 꽃을 피우자'는 상상이 나오는 이유다. 더 높은 성능을 요구하는 AI 트레이닝 시장, 오직 엔비디아 "공룡기업"

H800은 대역폭, 사진/NVIDIA를 "절단"합니다.

물론, "공룡기업" 뒤에 있는 소프트웨어 생태계는 NVIDIA의 핵심 기술 해자이기도 합니다. 이를 언급하는 기사가 많지만, 가장 중요한 것은 NVIDIA가 2007년에 출시하고 고수한 CUDA 통합 컴퓨팅 플랫폼입니다. 오늘날 AI 세계의 인프라가 되었으며 대부분의 AI 개발자들은 모바일 애플리케이션 개발자를 위한 Android 및 iOS와 마찬가지로 모두 CUDA를 기반으로 개발되었습니다.

그러나 Nvidia도 자사의 고급 GPU가 매우 인기가 있다는 것을 이해하고 있는 것은 당연합니다.Spring Festival 이후 Nvidia가 글로벌 시장의 강력한 수요를 충족하기 위해 추가 웨이퍼 파운드리 주문을 추가하고 있다는 보도가 많이 있었습니다. 지난 몇 달 동안 파운드리 주문을 크게 늘릴 수 있었지만 결국 생산 능력은 TSMC의 가장 발전된 3nm 공정이 아닙니다.

그러나 문제는 바로 주조 공정에 있다.

엔비디아의 하이엔드 GPU는 TSMC와 떼려야 뗄 수 없다

우리 모두 알고 있듯이 가전 제품의 침체와 지속적인 재고 정리로 인해 주요 웨이퍼 파운드리의 생산 능력 가동률이 전반적으로 감소했지만 TSMC의 고급 프로세스는 예외입니다.

ChatGPT로 촉발된 AI 열풍으로 인해 TSMC의 7nm 공정을 기반으로 한 A100과 4nm H100의 추가 주문이 긴급히 이뤄지고 있으며, 이 중 TSMC의 5/4nm 생산 라인은 거의 꽉 찼습니다. 공급망 소식통도 엔비디아가 TSMC에 SHR(가장 긴급 처리 수준) 주문을 대량 1년 동안 계속 유입할 것으로 예측하고 있다.

즉, TSMC의 생산능력이 엔비디아의 강력한 수요를 단기적으로 감당하기에는 부족하다는 것이다. 일부 분석가들이 A100 및 H100 GPU 는 리스크 통제나 비용 절감의 관점에서 볼 때 항상 공급이 부족하기 때문에 TSMC 외부 파운드리를 위해 삼성 또는 인텔을 찾아야 한다고 믿는 것은 당연합니다.

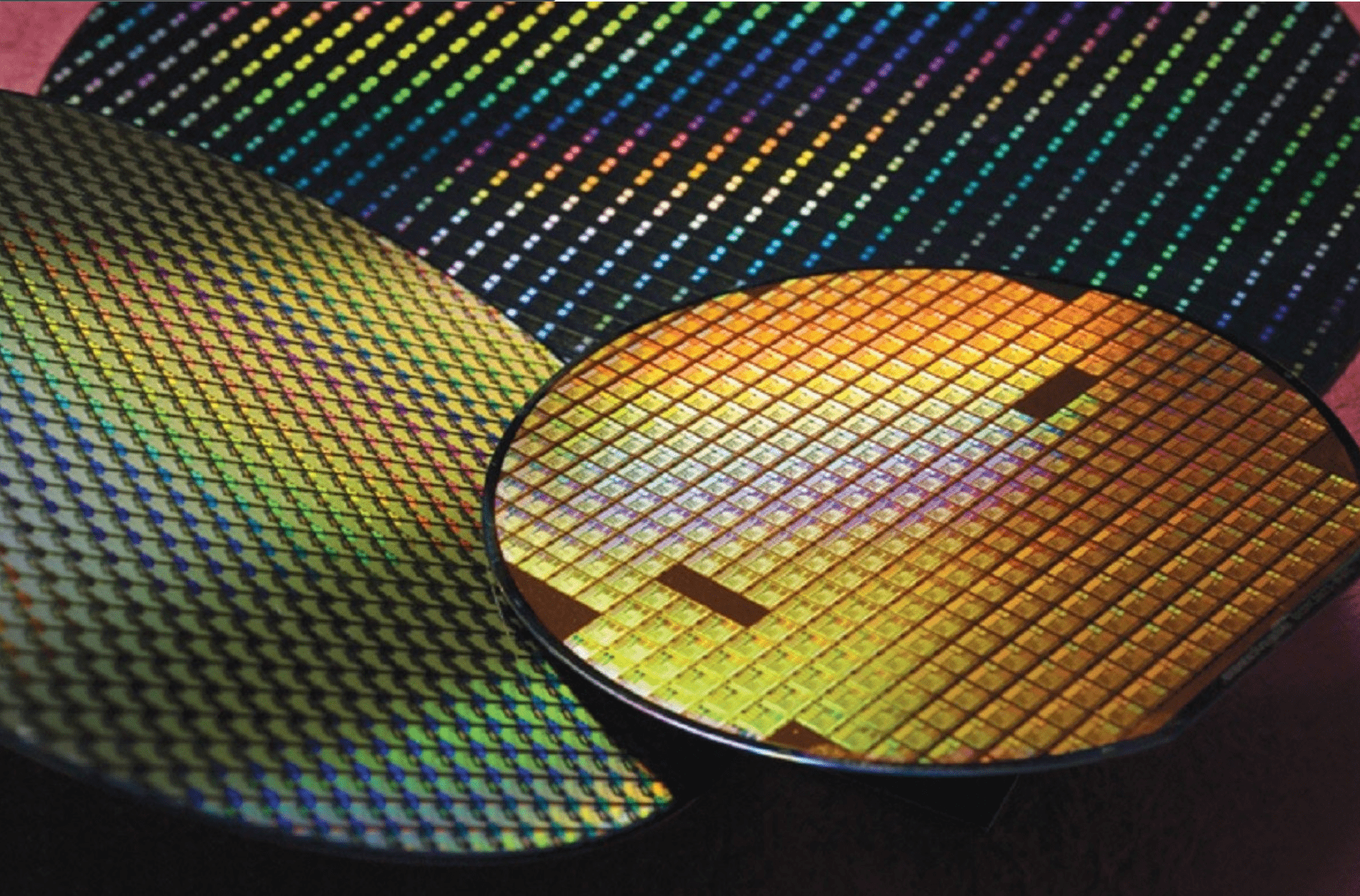

반도체 실리콘 웨이퍼에 칩 제조, 사진/TSMC

그러나 Nvidia는 적어도 단기적으로는 전혀 모르고 TSMC를 떠날 방법도 없는 것으로 나타났습니다. Sam Altman이 Nvidia GPU가 충분하지 않다고 불평하기 직전에 Nvidia 창립자이자 CEO인 Jensen Huang은 COMPUTEX에서 Nvidia의 차세대 칩은 여전히 TSMC에서 제조될 것이라고 말했습니다.

핵심 기술적 이유는 V100, A100부터 H100까지 NVIDIA의 고급 가속기 카드가 모두 TSMC의 CoWoS 고급 패키징 기술을 사용하여 높은 해시레이트 AI의 맥락에서 칩 저장 및 계산의 통합을 해결한다는 것입니다. CoWoS 고급 패키징의 핵심 기술은 TSMC 없이는 작동하지 않습니다.

TSMC는 2012년 독자적인 CoWoS 첨단 패키징 기술을 출시해 웨이퍼 파운드리부터 단말기 패키징까지 원스톱 서비스를 실현했으며, Nvidia, Apple 등 주요 칩 제조업체를 고객으로 두고 모든 하이엔드 제품에 이를 채택하고 있습니다. Nvidia의 긴급한 요구 사항을 충족하기 위해 TSMC는 일부 아웃소싱 방법도 채택했지만 여기에는 CoWoS 프로세스가 포함되지 않으며 TSMC는 여전히 가장 가치 있는 고급 패키징 부품에 집중하고 있습니다.

노무라증권 추정에 따르면 TSMC의 CoWoS 연간 생산능력은 2022년 말까지 약 7만~8만장, 2023년 말까지 14만~15만장까지 늘어날 것으로 예상된다. 2020년까지 웨이퍼 20만장에 도전할 것으로 예상된다. 2024년 말.

그러나 멀리 있는 물로는 근처의 화재를 해결할 수 없습니다. TSMC의 첨단 CoWoS 패키징 생산 능력은 심각한 공급 부족에 직면해 있습니다. 작년에 비해 TSMC의 CoWoS 주문이 두 배로 늘어났습니다. 올해는 Google과 AMD의 수요가 똑같이 강합니다. Nvidia조차도 Huang Renxun과 TSMC 창립자 Zhang Zhongmou와의 개인적인 관계를 통해 더 높은 우선순위를 위해 더욱 노력해야 합니다.

TSMC, 사진/

마지막에 쓰세요

지난 몇 년 동안 전염병과 지정학적 변화로 인해 샌드칩을 기반으로 한 첨단 기술이 매우 중요하다는 것을 모두가 깨달았습니다. ChatGPT 이후 AI는 다시 한번 전 세계의 주목을 받았고, 인공지능과 가속화된 해시레이트 에 대한 열망으로 수많은 칩 주문도 들어왔습니다.

하이엔드 GPU의 설계 및 제조에는 장기간의 R&D 투자와 축적이 필요하며, 극복할 수 없는 하드웨어 및 소프트웨어 장벽 대면 해야 합니다. 이는 또한 이번 "해시레이트 향연"에서 Nvidia와 TSMC가 얻을 수 있다는 사실로 이어집니다. 대부분의 케이크와 말할 권리.

오늘날의 생성 AI에 관심이 있든, 이미지 인식에 초점을 맞춘 딥 러닝의 마지막 물결에 관심이 있든, 중국 기업이 AI 소프트웨어 역량을 따라잡는 속도는 모두에게 분명합니다. 그러나 중국 기업이 AI 방향으로 전환하기 위해 막대한 돈을 지출할 때 하위 수준 하드웨어에는 거의 집중하지 않습니다.

그러나 AI 가속 뒤에는 가장 중요한 GPU 4개 중 2개가 이미 중국에서 제한되어 있으며, 나머지 2개의 거세된 A800과 H800은 중국 기업의 추격 속도를 늦출 뿐만 아니라 제한의 리스크 제거할 수 없습니다. 대형 모델로 경쟁하기보다는 중국 기업들이 낮은 수준에서 경쟁하는 모습을 지켜볼 필요가 있을 것 같습니다.

이 기사는 " Lei Technology "에서 발췌되었으며 승인을 받아 36Kr에 의해 게시되었습니다.