Tổ chức: mới

Vào tối ngày 2 tháng 6, Giám đốc điều hành NVIDIA Jen-Hsun Huang đã trình diễn những thành tựu mới nhất của NVIDIA trong lĩnh vực điện toán tăng tốc và AI tổng hợp tại hội nghị ComputerX 2024 ở Đài Bắc, đồng thời vạch ra kế hoạch phát triển cho công nghệ điện toán và robot trong tương lai.

Bài phát biểu này đề cập đến mọi thứ, từ các công nghệ AI cơ bản đến robot trong tương lai và các ứng dụng AI tổng quát trong nhiều ngành khác nhau, thể hiện một cách toàn diện những thành tựu nổi bật của NVIDIA trong việc thúc đẩy những thay đổi trong công nghệ điện toán.

Huang Renxun cho rằng NVIDIA nằm ở giao điểm của đồ họa máy tính, mô phỏng và AI, chính là linh hồn của NVIDIA. Mọi thứ được cho chúng ta thấy ngày nay đều là tương tự, đó là sự kết hợp của toán học, khoa học, khoa học máy tính, kiến trúc máy tính tuyệt vời. Đây không phải là hoạt hình mà là đồ tự chế và Nvidia đã tích hợp tất cả chúng vào thế giới ảo Omniverse.

Máy tính tăng tốc và AI

Huang Renxun cho rằng nền tảng của mọi thứ chúng ta thấy là hai công nghệ cơ bản, điện toán tăng tốc và AI chạy bên trong Omniverse. Hai lực lượng điện toán cơ bản này sẽ định hình lại ngành công nghiệp máy tính. Ngành công nghiệp máy tính có lịch sử 60 năm. Theo nhiều cách, mọi thứ chúng ta làm ngày nay đều được phát minh ra một năm sau khi Jensen Huang sinh năm 1964.

IBM System 360 đã giới thiệu các bộ xử lý trung tâm, tính toán đa năng, phân tách phần cứng và phần mềm thông qua hệ điều hành, nhiệm vụ, hệ thống con IO, DMA và nhiều công nghệ được sử dụng ngày nay. Khả năng tương thích về kiến trúc, khả năng tương thích ngược, khả năng tương thích sê-ri , mọi thứ chúng ta biết về máy tính ngày nay hầu hết được mô tả vào năm 1964. Tất nhiên, cuộc cách mạng PC đã dân chủ hóa máy tính, đưa nó đến tay và mọi nhà của mọi người.

Năm 2007, iPhone giới thiệu điện toán di động, đưa máy tính vào túi của chúng ta. Kể từ thời điểm đó, mọi thứ đều được kết nối và chạy mọi lúc thông qua đám mây di động. Trong 60 năm này, chúng ta chỉ chứng kiến hai hoặc ba lần, thực ra không nhiều, hai hoặc ba thay đổi lớn về công nghệ, hai hoặc ba sự thay đổi mang tính kiến tạo trong điện toán, và chúng ta sắp chứng kiến tất cả những điều đó xảy ra lần nữa.

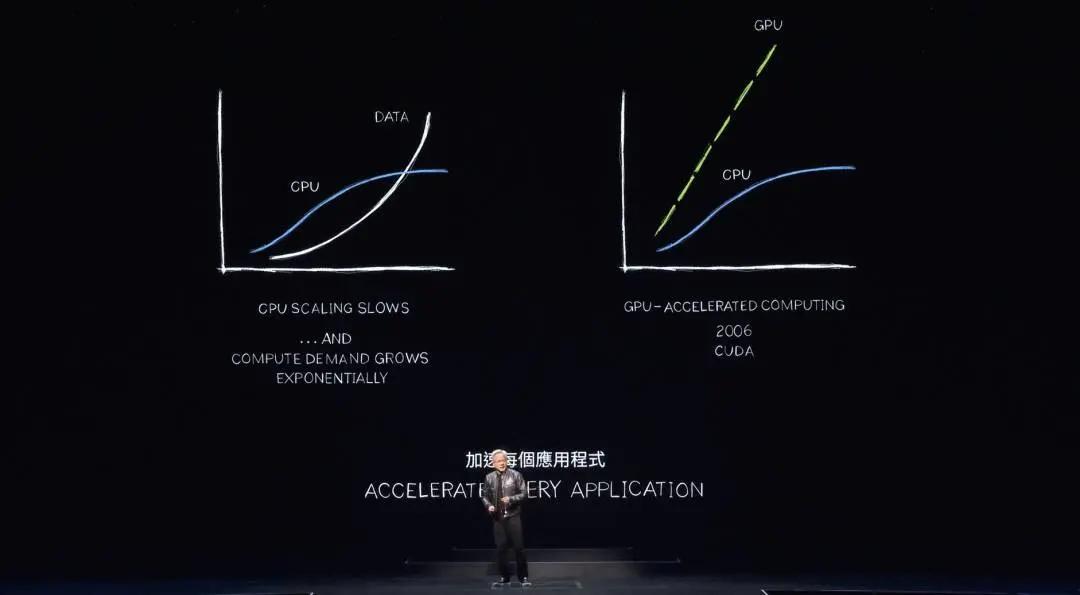

Hai điều cơ bản đang xảy ra. Đầu tiên là những cải tiến về hiệu suất trong bộ xử lý, đơn vị xử lý trung tâm điều hành ngành công nghiệp máy tính, đã chậm lại đáng kể. Tuy nhiên, lượng tính toán chúng ta cần thực hiện tăng trưởng tăng trưởng nhanh theo cấp số nhân. Nếu nhu cầu xử lý, lượng dữ liệu cần xử lý tiếp tục tăng trưởng theo cấp số nhân nhưng hiệu suất thì không, lạm phát tính toán sẽ xảy ra. Trên thực tế, chúng ta đang thấy điều này ngay bây giờ. Lượng điện được sử dụng bởi các trung tâm dữ liệu trên khắp thế giới đang tăng trưởng mạnh mẽ. Chi phí tính toán cũng đang tăng trưởng. Chúng ta đang trải qua lạm phát có tính toán.

Tất nhiên, điều này không thể tiếp tục. Khối lượng dữ liệu sẽ tiếp tục tăng trưởng theo cấp số nhân và hiệu suất CPU sẽ không bao giờ quay trở lại. Chúng tôi có một phương pháp tốt hơn. Nvidia đã nghiên cứu điện toán tăng tốc trong gần hai thập kỷ. CUDA tăng cường CPU, giảm tải và tăng tốc công việc mà các bộ xử lý chuyên dụng có thể làm tốt hơn. Trên thực tế, hiệu suất tốt đến mức giờ đây rõ ràng là mọi thứ cần được tăng tốc khi hiệu suất CPU tăng chậm lại và cuối cùng dừng lại đáng kể.

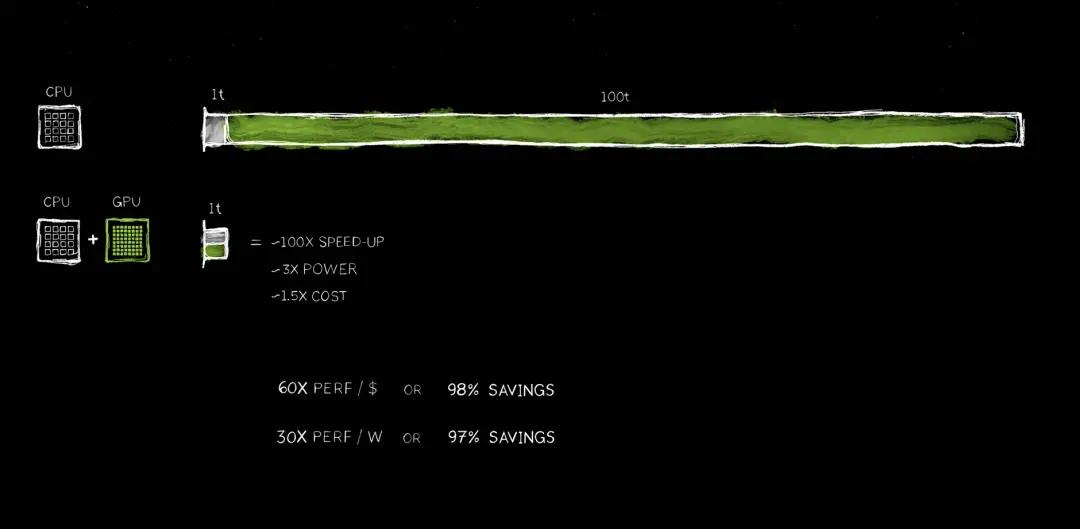

Huang dự đoán rằng tất cả các ứng dụng cần xử lý lượng lớn sẽ được tăng tốc và chắc chắn mọi trung tâm dữ liệu sẽ được tăng tốc trong tương lai gần. Bây giờ việc tăng tốc độ tính toán là hoàn toàn hợp lý. Nếu bạn nhìn vào một ứng dụng, ở đây 100t đại diện cho 100 đơn vị thời gian, có thể là 100 giây, có thể là 100 giờ. Như bạn đã biết, trong nhiều trường hợp, các ứng dụng AI hiện đang được xem xét để chạy trong 100 ngày.

Mã 1T đề cập đến mã yêu cầu xử lý tuần tự, trong đó CPU đơn luồng rất quan trọng. Logic điều khiển của hệ điều hành rất quan trọng và cần được thực thi hết lệnh này đến lệnh khác. Tuy nhiên, có nhiều thuật toán, chẳng hạn như xử lý đồ họa máy tính, có thể hoạt động hoàn toàn song song. Xử lý đồ họa máy tính, xử lý hình ảnh, mô phỏng vật lý, tối ưu hóa tổ hợp, xử lý đồ thị, xử lý cơ sở dữ liệu và tất nhiên là đại số tuyến tính nổi tiếng trong học độ sâu, các thuật toán này đều rất phù hợp để tăng tốc thông qua xử lý song song.

Do đó, một kiến trúc đã được phát minh bằng cách thêm GPU vào CPU. Bộ xử lý chuyên dụng có thể tăng tốc nhiệm vụ chạy dài lên tốc độ cực nhanh. Bởi vì hai bộ xử lý này có thể hoạt động song song, chúng tự chủ và độc lập, đồng thời có thể tăng tốc nhiệm vụ ban đầu mất 100 đơn vị thời gian lên 1 đơn vị thời gian. Tốc độ tăng lên đáng kinh ngạc và hiệu quả là tốc độ tăng gấp 100 lần. , nhưng mức tiêu thụ điện năng chỉ tăng khoảng ba lần và chi phí chỉ tăng khoảng 50%. Điều này đã được thực hiện trong ngành công nghiệp PC. NVIDIA bổ sung GPU GeForce trị giá 500 USD cho PC trị giá 1.000 USD và hiệu suất sẽ được cải thiện rất nhiều. Nvidia cũng thực hiện điều này trong trung tâm dữ liệu. Lấy trung tâm dữ liệu giá hàng tỷ đô la, thêm GPU trị giá 500 triệu đô la, và đột nhiên nó trở thành một nhà máy AI. Điều này đang diễn ra trên toàn thế giới.

Tiết kiệm chi phí thật đáng kinh ngạc. Với mỗi đô la chi tiêu, bạn nhận được hiệu suất gấp 60 lần và tốc độ gấp 100 lần, trong khi chỉ tăng gấp ba lần mức tiêu thụ điện năng và tăng chi phí chỉ 1,5 lần. Khoản tiết kiệm thật đáng kinh ngạc. Việc tiết kiệm chi phí có thể được đo bằng đô la.

Rõ ràng là nhiều công ty đang chi hàng trăm triệu đô la để xử lý dữ liệu trên đám mây. Nếu những quá trình này được đẩy nhanh, không khó để tưởng tượng sẽ tiết kiệm được hàng trăm triệu đô la. Điều này là do điện toán có mục đích chung đã trải qua lạm phát trong một thời gian dài.

Bây giờ cuối cùng đã quyết định tăng tốc độ tính toán, có lượng lớn tổn thất thu được hiện có thể được phục hồi và rất nhiều chất thải được giữ lại có thể được thải ra khỏi hệ thống. Điều này sẽ chuyển thành tiết kiệm tiền và tiết kiệm năng lượng, đó là lý do tại sao Jen-Hsun Huang thường nói "mua càng nhiều, càng tiết kiệm".

Huang Renxun cũng cho rằng tính toán tăng tốc mang lại kết quả phi thường nhưng không hề dễ dàng. Tại sao tiết kiệm được nhiều tiền như vậy nhưng lâu nay người ta lại không làm? Lý do là vì nó rất khó. Không có phần mềm nào có thể chạy qua trình biên dịch C và đột nhiên ứng dụng này nhanh hơn 100 lần. Nó thậm chí không hợp lý. Nếu họ có thể làm được điều này thì họ đã tân trang lại CPU.

Việc phải viết lại phần mềm là phần khó nhất. Phần mềm phải được viết lại hoàn toàn để có thể diễn đạt lại các thuật toán được viết trên CPU để chúng có thể được tăng tốc, giảm tải và chạy song song. Bài tập về khoa học máy tính này cực kỳ khó.

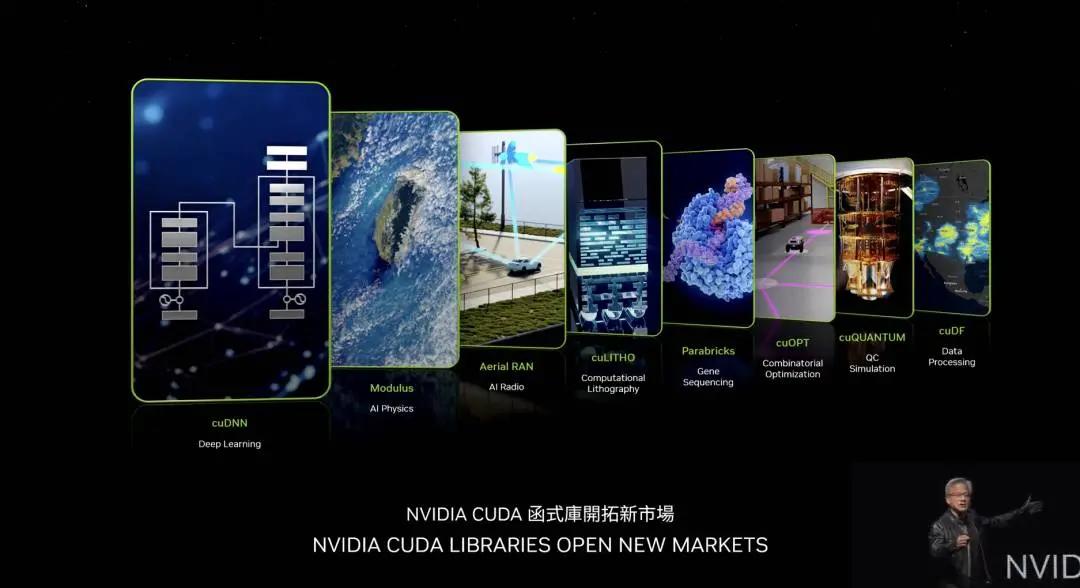

Huang Renxun cho biết trong 20 năm qua, NVIDIA đã khiến thế giới trở nên dễ dàng hơn. Tất nhiên, cuDNN rất nổi tiếng là một thư viện độ sâu learning xử lý các mạng lưới thần kinh. Nvidia có thư viện vật lý AI có thể được sử dụng trong động lực chất lỏng và nhiều ứng dụng khác trong đó mạng lưới thần kinh phải tuân theo các định luật vật lý. Nvidia có một thư viện mới tuyệt vời tên là Arial Ran, đây là một đài phát thanh 5G được tăng tốc CUDA có khả năng xác định và tăng tốc các mạng viễn thông giống như cách mà mạng thế giới, Internet, được xác định. Khả năng tăng tốc cho phép chúng tôi chuyển đổi tất cả viễn thông thành cùng loại nền tảng với nền tảng điện toán đám mây.

cuLITHO là một nền tảng in thạch bản tính toán có khả năng xử lý phần tính toán chuyên sâu nhất trong sản xuất chip – tạo ra mặt nạ. TSMC đang sử dụng cuLITHO để sản xuất, tiết kiệm lượng lớn năng lượng và tiền bạc. TSMC đặt mục tiêu tăng tốc ngăn xếp của họ để chuẩn bị cho các thuật toán và tính toán tiếp theo trên các bóng bán dẫn sâu hơn, hẹp hơn. Parabricks là thư viện giải trình tự gen của NVIDIA, là thư viện giải trình tự gen có thông lượng cao nhất trên thế giới. cuOpt là một thư viện đáng kinh ngạc để tối ưu hóa tổ hợp, tối ưu hóa quy hoạch tuyến đường, giải quyết vấn đề nhân viên bán hàng du lịch rất phức tạp.

Các nhà khoa học thường cho rằng cần có máy tính lượng tử để giải quyết vấn đề này. NVIDIA đã tạo ra một thuật toán chạy trên nền tảng điện toán tăng tốc và chạy cực nhanh, lập 23 kỷ lục thế giới. cuQuantum là một hệ thống mô phỏng máy tính lượng tử. Nếu bạn muốn thiết kế một máy tính lượng tử, bạn cần một trình mô phỏng. Nếu bạn muốn thiết kế các thuật toán lượng tử, bạn cần một trình mô phỏng lượng tử. Nếu máy tính lượng tử không tồn tại, làm thế nào bạn thiết kế những máy tính lượng tử này, tạo ra những thuật toán lượng tử này? Bạn sử dụng chiếc máy tính nhanh nhất thế giới hiện nay, tất nhiên đó là NVIDIA CUDA. Ở trên, Nvidia có một trình giả lập mô phỏng máy tính lượng tử. Nó được hàng trăm nghìn nhà nghiên cứu trên khắp thế giới sử dụng, tích hợp vào tất cả các nền tảng điện toán lượng tử hàng đầu và được sử dụng rộng rãi trong các trung tâm siêu máy tính khoa học.

cuDF là một thư viện xử lý dữ liệu đáng kinh ngạc. Việc xử lý dữ liệu tiêu tốn phần lớn chi tiêu trên đám mây ngày nay, tất cả đều cần được tăng tốc. cuDF tăng tốc các thư viện lớn được sử dụng trên thế giới, chẳng hạn như Spark, thư viện mà nhiều công ty có thể sử dụng, Pandas, thư viện mới có tên Polars, và tất nhiên là NetworkX, thư viện cơ sở dữ liệu xử lý đồ thị. Đây chỉ là một số ví dụ, còn rất nhiều ví dụ khác.

Huang cho biết Nvidia phải tạo ra những thư viện này để cho phép hệ sinh thái tận dụng khả năng tính toán tăng tốc. Nếu NVIDIA không tạo ra cuDNN thì riêng CUDA sẽ không có sẵn cho các nhà khoa học độ sâu learning trên toàn thế giới vì khoảng cách giữa các thuật toán dùng trong CUDA, TensorFlow và PyTorch là quá xa. Nó gần giống như làm đồ họa máy tính mà không có OpenGL hoặc xử lý dữ liệu mà không cần SQL. Các thư viện dành riêng cho miền này là kho báu của NVIDIA, với tổng số 350 thư viện. Chính những thư viện này đã cho phép Nvidia mở ra rất nhiều thị trường.

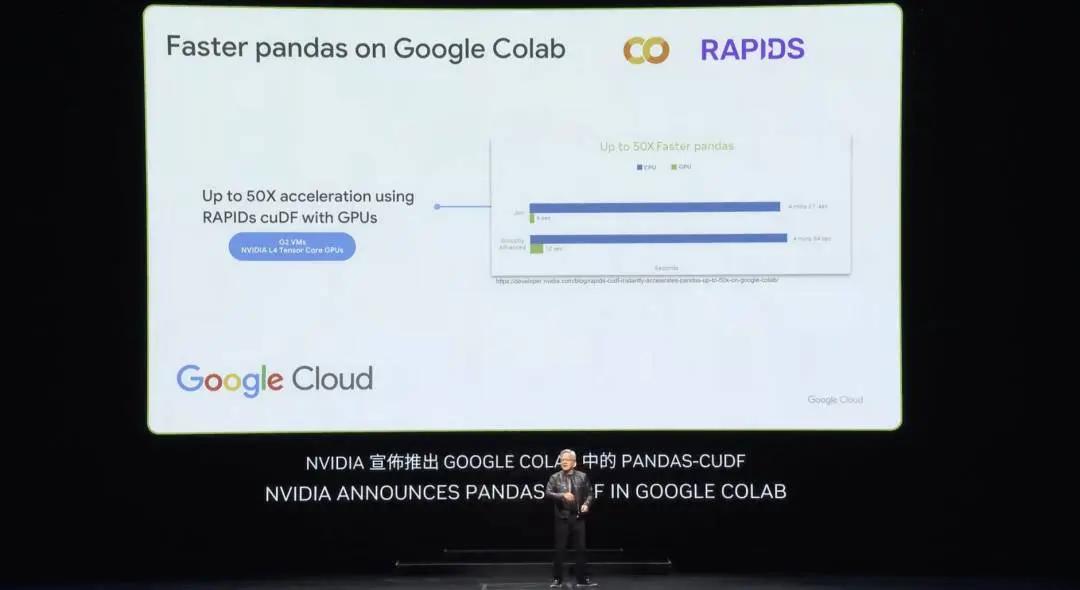

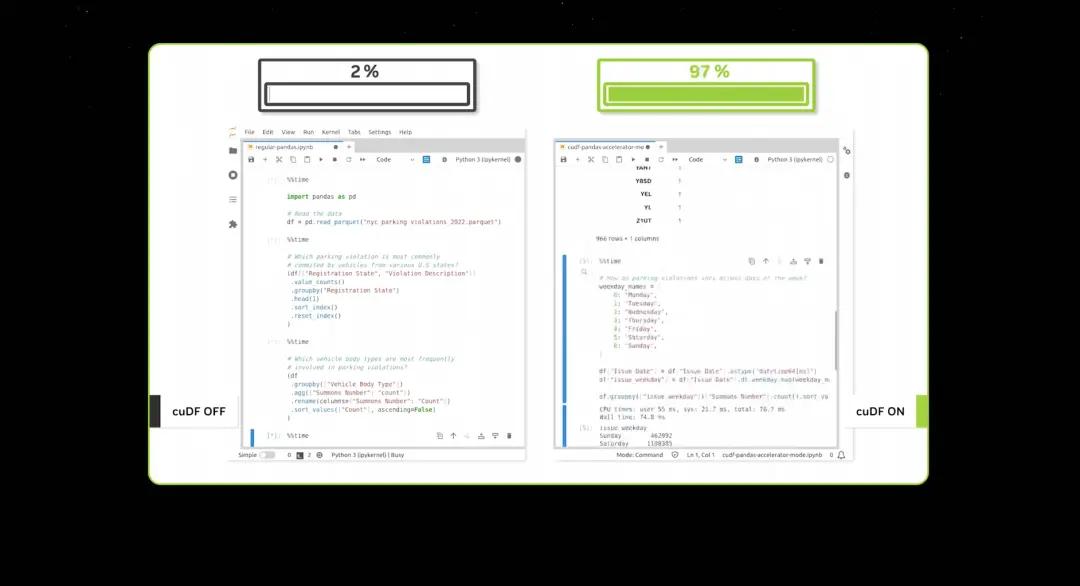

Tuần trước, Google tuyên bố sẽ tăng tốc Pandas, thư viện khoa học dữ liệu phổ biến nhất thế giới, trên đám mây. Nhiều người trong số các bạn có thể đã sử dụng Pandas, ứng dụng được 10 triệu nhà khoa học dữ liệu trên khắp thế giới sử dụng và được tải xuống 170 triệu lần mỗi tháng. Đó là bảng tính của nhà khoa học dữ liệu. Giờ đây, chỉ với một nhấn, bạn có thể sử dụng cuDF để tăng tốc Pandas trong Colab, nền tảng trung tâm dữ liệu đám mây của Google và hiệu ứng tăng tốc thực sự đáng kinh ngạc.

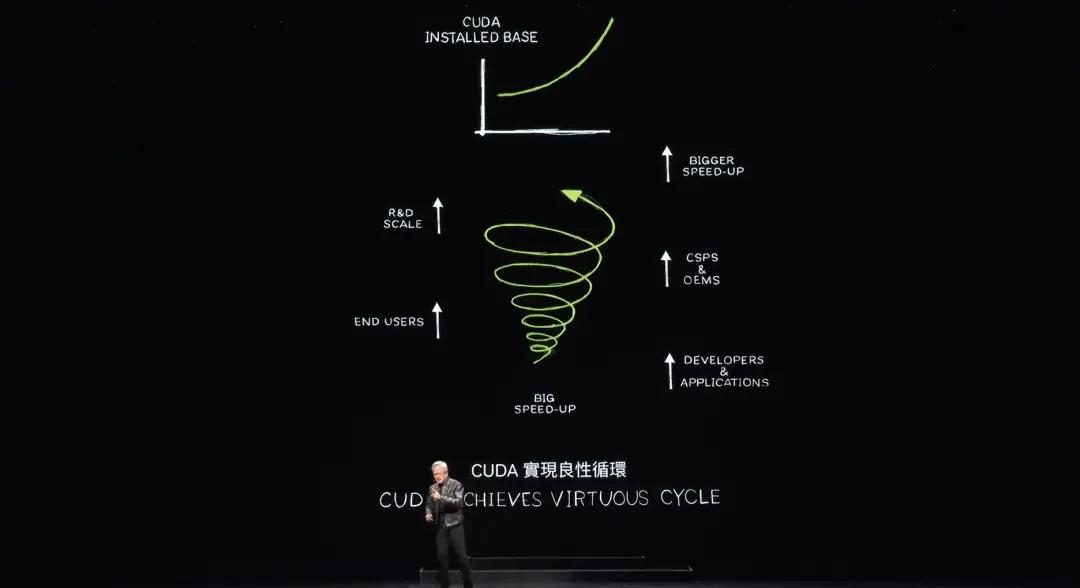

Khi bạn tăng tốc quá trình xử lý dữ liệu quá nhanh, các bản demo thực sự không mất nhiều thời gian. Bây giờ CUDA đã đạt đến điểm mà mọi người gọi là điểm bùng phát, nhưng thậm chí còn tốt hơn nữa. CUDA hiện đã đạt được một chu kỳ đạo đức.

Điều này hiếm khi xảy ra. Nếu bạn nhìn vào nền tảng của tất cả các kiến trúc máy tính trong suốt lịch sử. Lấy CPU vi xử lý làm ví dụ, nó đã tồn tại được 60 năm và không hề thay đổi ở mức độ này. Loại điện toán, điện toán tăng tốc này đã tồn tại và việc tạo ra một nền tảng mới là vô cùng khó khăn vì đó là vấn đề con gà và quả trứng.

Nếu không có nhà phát triển nào sử dụng nền tảng của bạn thì tất nhiên sẽ không có người dùng. Nhưng không có người dùng thì không có cơ sở cài đặt. Nếu không có cơ sở cài đặt, các nhà phát triển sẽ không quan tâm đến nó. Các nhà phát triển muốn viết phần mềm cho cơ sở cài đặt lớn, nhưng cơ sở cài đặt lớn đòi hỏi lượng lớn ứng dụng để thu hút người dùng tạo cơ sở cài đặt.

Câu hỏi con gà và quả trứng này hiếm khi bị phá vỡ. NVIDIA đã dành 20 năm để xây dựng các thư viện trong lĩnh vực này đến lĩnh vực khác và hết thư viện tăng tốc này đến thư viện tăng tốc khác. Hiện có 5 triệu nhà phát triển đang sử dụng nền tảng của NVIDIA trên toàn thế giới.

NVIDIA phục vụ mọi ngành, từ chăm sóc sức khỏe, dịch vụ tài chính, công nghiệp máy tính, công nghiệp ô tô, đến hầu hết mọi ngành công nghiệp chính, hầu hết mọi lĩnh vực khoa học và vì kiến trúc của NVIDIA có rất nhiều khách hàng nên các OEM và nhà cung cấp dịch vụ đám mây đều quan tâm đến việc xây dựng Hệ thống của NVIDIA. Những nhà xây dựng hệ thống giỏi như ở Đài Loan quan tâm đến việc xây dựng hệ thống của Nvidia, điều này giúp có nhiều hệ thống hơn trên thị trường để lựa chọn, điều này tất nhiên tạo ra nhiều cơ hội hơn cho chúng tôi để có thể mở rộng quy mô R&D, từ đó tăng tốc hơn nữa. ứng dụng.

Lần bạn tăng tốc một ứng dụng, chi phí tính toán sẽ giảm giảm. Tăng tốc 100 lần tương ứng với mức tiết kiệm 97%, 96%, 98%. Vì vậy, khi chúng ta tăng tốc từ tăng tốc 100 lần lên tăng tốc 200 lần lên tăng tốc 1000 lần, chi phí tính toán cận biên tiếp tục giảm.

NVIDIA tin rằng bằng cách giảm đáng kể chi phí điện toán, thị trường, nhà phát triển, nhà khoa học và nhà phát minh sẽ tiếp tục khám phá ra ngày càng nhiều thuật toán tiêu thụ ngày càng nhiều tài nguyên máy tính và cuối cùng sẽ có bước nhảy vọt về chất trong chi phí biên của điện toán. thấp rằng một cách sử dụng máy tính mới đã xuất hiện.

Trên thực tế, đây chính xác là những gì đang xảy ra hiện nay. Trong những năm qua, NVIDIA đã giảm chi phí tính toán cận biên của một thuật toán nhất định xuống hàng triệu lần trong 10 năm qua. Vì vậy, việc đào tạo một LLM chứa toàn bộ dữ liệu Internet hiện nay là rất hợp lý và thông thường, không ai có thể nghi ngờ về điều đó. Ý tưởng là bạn có thể tạo ra một chiếc máy tính có khả năng xử lý nhiều dữ liệu đến mức bạn có thể viết phần mềm của riêng mình. AI xuất hiện với niềm tin hoàn toàn rằng nếu bạn làm cho máy tính ngày càng rẻ hơn thì ai đó sẽ tìm thấy công dụng tuyệt vời của nó.

Ngày nay, CUDA đã đạt được một chu kỳ tốt đẹp. Cơ sở được cài đặt ngày tăng trưởng và chi phí điện toán đang giảm, điều này dẫn đến nhiều nhà phát triển nảy ra nhiều ý tưởng hơn, từ đó thúc đẩy nhiều nhu cầu hơn. Bây giờ chúng ta đang ở một điểm khởi đầu rất quan trọng.

Huang tiếp tục đề cập đến ý tưởng về Earth 2, nơi sẽ tạo ra một bản song sinh kỹ thuật số của Trái đất, bằng cách mô phỏng Trái đất, tương lai có thể được dự đoán tốt hơn để tránh thảm họa tốt hơn và có thể hiểu rõ hơn về tác động của biến đổi khí hậu. thích nghi tốt hơn.

Các nhà nghiên cứu đã phát hiện ra CUDA vào năm 2012, đây là lần NVIDIA tiếp xúc với AI. Đây là một ngày rất quan trọng. Thật vinh dự khi được làm việc với các nhà khoa học để biến việc học độ sâu thành hiện thực.

AlexNet đã đạt được bước đột phá lớn về thị giác máy tính. Nhưng quan trọng hơn, điều quan trọng là phải lùi lại và hiểu bối cảnh , nền tảng cũng như tác động lâu dài và tiềm năng của độ sâu learning. NVIDIA nhận ra rằng công nghệ này có tiềm năng mở rộng rất lớn. Một thuật toán được phát minh và khám phá cách đây hàng thập kỷ, đột nhiên, nhờ có nhiều dữ liệu hơn, mạng lớn hơn và quan trọng hơn là nhiều tài nguyên máy tính hơn, độ sâu learning đạt được những điều mà thuật toán của con người không thể làm được.

Bây giờ hãy tưởng tượng điều gì có thể xảy ra nếu mở rộng kiến trúc hơn nữa, với mạng lớn hơn, nhiều dữ liệu hơn và nhiều tài nguyên điện toán hơn. Sau năm 2012, NVIDIA đã thay đổi kiến trúc GPU và bổ sung thêm lõi Tensor. NVIDIA đã phát minh ra NVLink, tức là 10 năm trước, CUDA, rồi TensorRT, NCCL, mua lại máy chủ suy luận Mellanox, TensorRT-ML, Triton, tất cả đều được tích hợp vào một chiếc máy tính hoàn toàn mới. Không ai hiểu nó, không ai hỏi nó, không ai hiểu ý nghĩa của nó.

Trên thực tế, Huang tin chắc rằng không ai muốn mua nó nên Nvidia đã công bố nó tại GTC, và OpenAI, một công ty nhỏ có trụ sở tại San Francisco, đã yêu cầu Nvidia cung cấp cho họ một chiếc.

Năm 2016, Jen-Hsun Huang đã giao DGX đầu tiên, siêu máy tính AI đầu tiên trên thế giới, cho OpenAI. Sau đó, tiếp tục mở rộng, từ siêu máy tính AI, thiết bị AI, mở rộng siêu máy tính cỡ lớn, hoặc thậm chí lớn hơn.

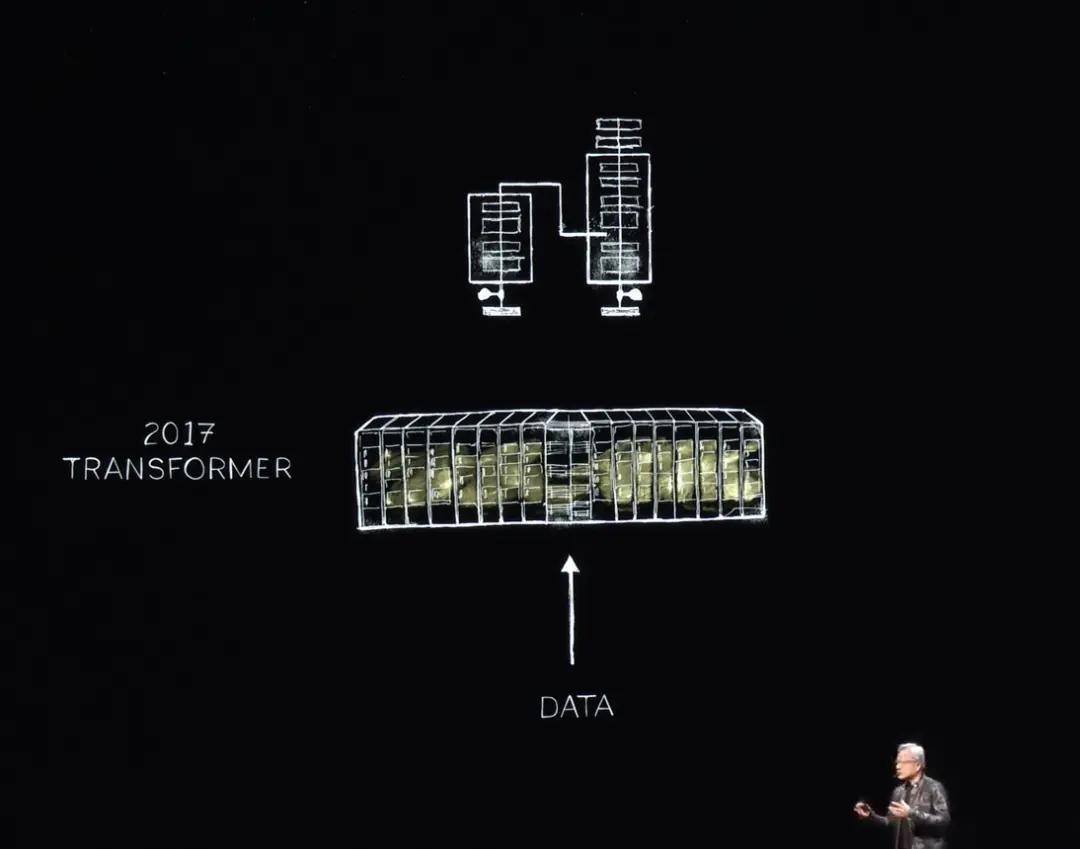

Đến năm 2017, thế giới đã phát hiện ra Transformer, cho phép đào tạo lượng lớn dữ liệu để xác định và tìm hiểu các mẫu trình tự dài hạn. Giờ đây, NVIDIA có thể đào tạo các LLM này để hiểu và đạt được những bước đột phá trong việc hiểu ngôn ngữ tự nhiên. Tiếp tục, các hệ thống lớn hơn đã được xây dựng.

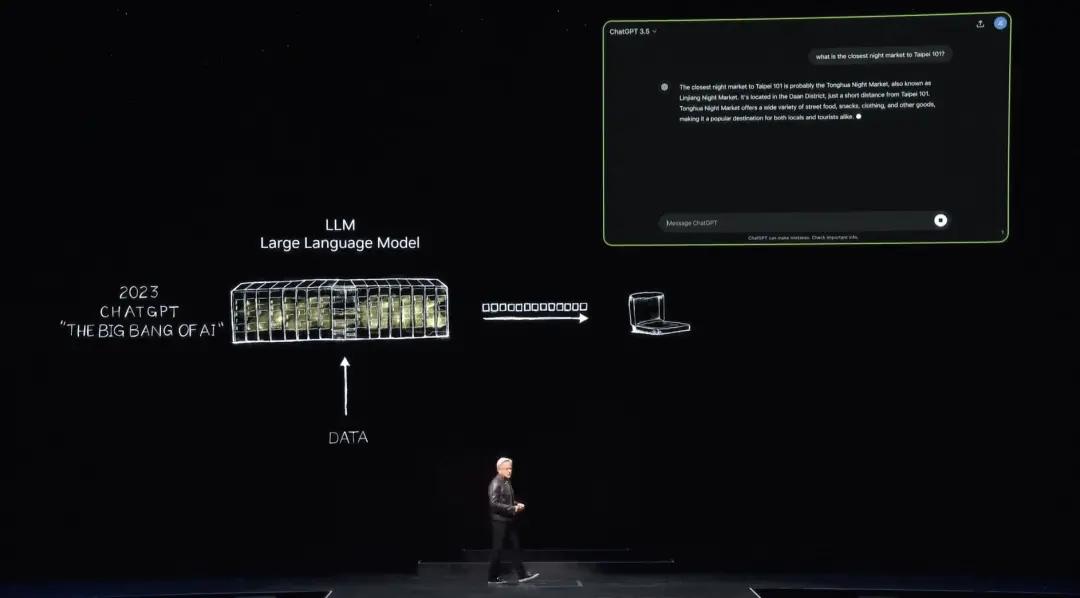

Sau đó vào tháng 11 năm 2022, sử dụng hàng nghìn GPU Nvidia và siêu máy tính AI rất lớn để đào tạo, OpenAI đã phát hành ChatGPT, đạt một triệu người dùng trong vòng 5 ngày và 100 triệu trong vòng hai tháng, trở thành ứng dụng có tăng trưởng lớn nhất trong lịch sử .

Trước khi ChatGPT được tiết lộ với thế giới, AI đã tập trung vào nhận thức, hiểu ngôn ngữ tự nhiên, thị giác máy tính, nhận dạng giọng nói. Đó là tất cả về nhận thức và phát hiện. Đây là lần đầu tiên thế giới giải quyết được vấn đề về AI tạo ra, tạo ra từng mã thông báo và những mã thông báo này là các từ. Tất nhiên, một số mã thông báo giờ đây có thể là hình ảnh, biểu đồ, bảng biểu, bài hát, từ ngữ, giọng nói và video. Những mã thông báo này có thể là bất cứ thứ gì bạn có thể hiểu được ý nghĩa, chúng có thể là mã thông báo hóa học, mã thông báo protein, mã thông báo gen. Những gì bạn thấy trước đây trong dự án Earth 2 là mã thông báo thời tiết đã được tạo.

Chúng ta có thể hiểu, chúng ta có thể học vật lý. Nếu bạn có thể học vật lý, bạn có thể dạy vật lý cho các mô hình AI. Các mô hình AI có thể tìm hiểu ý nghĩa của vật lý và sau đó có thể tạo ra vật lý. Chúng tôi đã thu hẹp nó xuống còn 1 km, không phải bằng cách lọc mà bằng cách tạo. Vì vậy, chúng tôi có thể tạo ra hầu hết mọi mã thông báo có giá trị bằng phương pháp này. Chúng ta có thể tạo ra bộ điều khiển vô lăng cho ô tô và chuyển động cho cánh tay robot. Mọi thứ chúng ta có thể học bây giờ đều có thể được tạo ra.

nhà máy AI

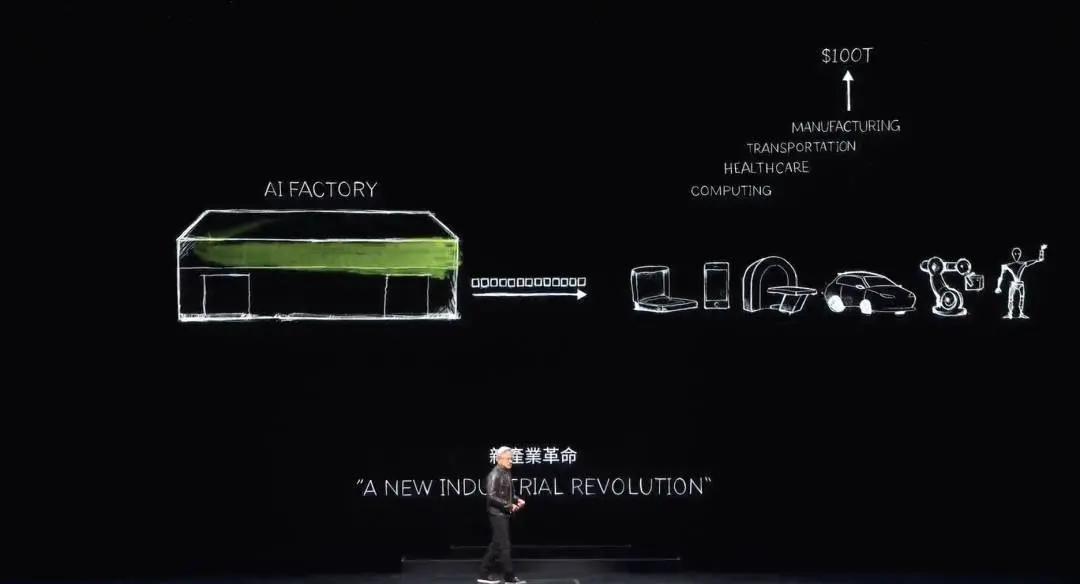

Bây giờ chúng ta đã bước vào kỷ nguyên của AI sáng tạo. Tuy nhiên, điều thực sự quan trọng là chiếc máy tính ban đầu đóng vai trò là siêu máy tính này giờ đã phát triển thành một trung tâm dữ liệu. Nó chỉ tạo ra một thứ duy nhất, đó là một nhà máy AI đang tạo ra, tạo ra và... Sản xuất. một mặt hàng mới có giá trị lớn.

Vào cuối những năm 1890, Nikola Tesla đã phát minh ra máy phát điện và Nvidia đã phát minh ra máy phát điện AI. Máy phát điện tạo ra điện tử và máy phát điện AI của Nvidia tạo ra mã thông báo. Cả hai thứ này đều có cơ hội lớn trên thị trường và hoàn toàn có thể thay thế được trong hầu hết mọi ngành công nghiệp.

Nvidia hiện có một nhà máy mới sản xuất mặt hàng mới cho mọi ngành mang lại giá trị đặc biệt. Phương pháp này có mở rộng cao và phương pháp này cũng có khả năng tái tạo rất cao.

Hãy chú ý xem có rất nhiều mô hình AI tổng hợp khác nhau đang được phát minh mỗi ngày. Bây giờ mọi ngành công nghiệp đều đang nhận được một làn sóng. Lần, ngành CNTT trị giá 3 nghìn tỷ USD đang tạo ra thứ gì đó phục vụ trực tiếp cho ngành công nghiệp trị giá 100 nghìn tỷ USD. Không còn chỉ là công cụ lưu trữ thông tin hay xử lý dữ liệu mà là một nhà máy tạo ra trí tuệ cho mọi ngành công nghiệp. Đây sẽ là một ngành sản xuất, nhưng không phải sản xuất máy tính mà là sản xuất sử dụng máy tính.

Điều này chưa bao giờ xảy ra trong lịch sử. Điện toán tăng tốc đã mang đến AI, mang đến AI có khả năng sáng tạo và giờ đây mang đến cuộc cách mạng công nghiệp. Tác động đến ngành cũng rất đáng kể. Nó có thể tạo ra một mặt hàng mới, một sản phẩm mới gọi là token cho nhiều ngành, nhưng tác động đến ngành của chúng ta cũng rất sâu sắc.

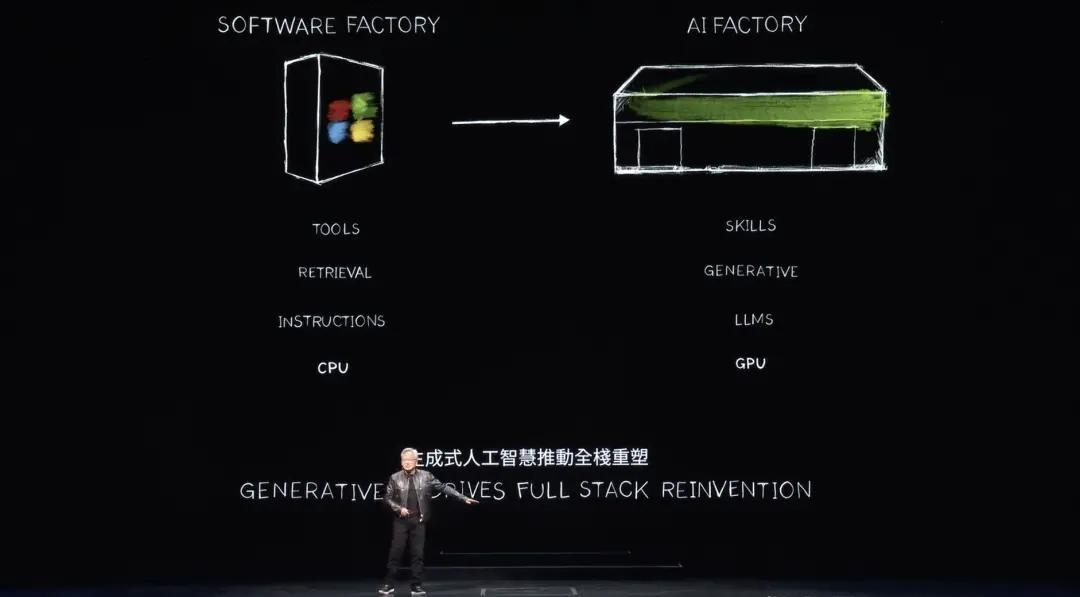

Trong 60 năm qua, mọi lớp điện toán đã thay đổi, từ điện toán đa năng trên CPU đến điện toán tăng tốc trên GPU và máy tính cần có hướng dẫn. Bây giờ máy tính xử lý các mô hình LLM, AI. Trước đây, các mô hình tính toán dựa trên sự truy xuất. Hầu như lần bạn chạm vào điện thoại, một số văn bản, hình ảnh hoặc video được ghi sẵn sẽ được truy xuất cho bạn, tập hợp lại và hiển thị cho bạn dựa trên hệ thống đề xuất.

Huang cho biết trong tương lai, máy tính sẽ tạo ra nhiều dữ liệu nhất có thể và chỉ lấy những thông tin cần thiết. Lý do là dữ liệu được tạo ra cần ít năng lượng hơn để có được thông tin. Dữ liệu được tạo ra cũng theo ngữ cảnh hơn. Nó sẽ mã hóa kiến thức và hiểu bạn. Thay vì yêu cầu máy tính tìm nạp thông tin hoặc tập tin, bạn hãy để nó trả lời trực tiếp câu hỏi của mình. Máy tính sẽ không còn là công cụ chúng ta sử dụng nữa mà thay vào đó là tạo ra các kỹ năng và thực hiện nhiệm vụ.

NIM, vi dịch vụ suy luận NVIDIA

Đây không phải là một ngành công nghiệp sản xuất phần mềm, đây là một ý tưởng mang tính cách mạng vào đầu những năm 1990. Hãy nhớ rằng Microsoft đã tạo ra ý tưởng đóng gói phần mềm đã cách mạng hóa ngành công nghiệp PC. Chúng ta sẽ làm gì với PC nếu không có phần mềm đóng gói? Nó đã thúc đẩy ngành công nghiệp và giờ đây Nvidia có một nhà máy mới, một máy tính mới. Chúng tôi sẽ chạy một loại phần mềm mới bên trên nó có tên là NIM, NVIDIA Inference Microservices.

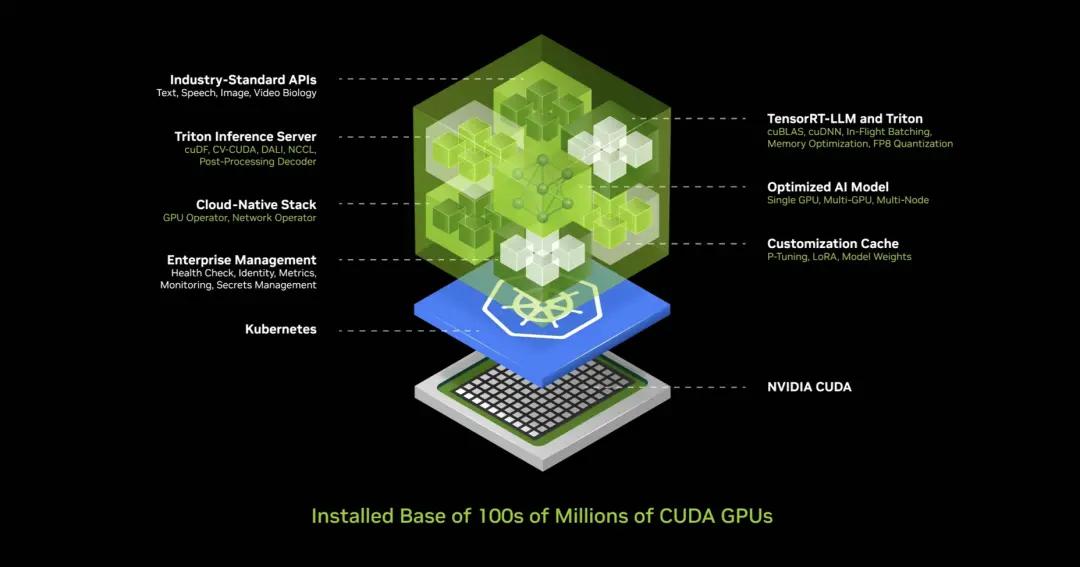

NIM chạy bên trong nhà máy này, NIM này là mô hình được đào tạo trước, nó là AI. Bản thân AI rất phức tạp, nhưng hệ thống tính toán chạy AI lại cực kỳ phức tạp. Khi bạn sử dụng ChatGPT, phía sau nó có lượng lớn phần mềm. Dấu hiệu đằng sau việc này là lượng lớn nhiều phần mềm và cực kỳ phức tạp vì các mô hình rất lớn, với hàng tỷ đến hàng nghìn tỷ tham số. Nó không chỉ chạy trên một máy tính mà còn trên nhiều máy tính. Nó phải phân phối khối lượng công việc giữa nhiều GPU, sử dụng nhiều phương pháp song song khác nhau như song song tensor, song song đường ống, song song dữ liệu, song song khác nhau, song song chuyên gia, v.v. để phân phối khối lượng công việc giữa nhiều GPU nhanh nhất có thể và xử lý nó đúng cách.

Bởi vì nếu bạn đang vận hành trong một nhà máy, sản lượng của bạn có liên quan trực tiếp đến thu nhập. Thông lượng của bạn liên quan trực tiếp đến chất lượng dịch vụ của bạn và thông lượng của bạn liên quan trực tiếp đến số lượng người có thể sử dụng dịch vụ của bạn.

Chúng ta hiện đang ở trong một thế giới mà việc sử dụng thông lượng của trung tâm dữ liệu là rất quan trọng. Điều này trước đây rất quan trọng nhưng không còn nhiều như bây giờ. Trong quá khứ điều này rất quan trọng nhưng người ta lại không đo lường nó. Ngày nay, mọi thông số đều được đo lường, thời gian khởi động, thời gian chạy, mức sử dụng, thông lượng, thời gian nhàn rỗi, v.v., bởi vì đây là một nhà máy. Khi một cái gì đó là một nhà máy, hoạt động của nó gắn liền trực tiếp với hiệu quả tài chính của công ty, điều này cực kỳ phức tạp đối với hầu hết các công ty.

Vậy Nvidia đã làm gì? NVIDIA đã tạo ra hộp AI này, chứa lượng lớn phần mềm. Hộp chứa này bao gồm các dịch vụ suy luận CUDA, cuDNN, TensorRT và Triton. Nó có nguồn gốc từ đám mây, tự động mở rộng trong hoàn cảnh Kubernetes và có các dịch vụ quản lý cũng như các hook để giám sát AI của bạn. Nó có API chung, API tiêu chuẩn và bạn có thể trò chuyện với hộp. Tải xuống NIM này và có thể trò chuyện với nó, miễn là bạn có CUDA trên máy tính của mình, điều này tất nhiên hiện nay rất phổ biến. Nó có sẵn trên mọi đám mây, từ mọi nhà sản xuất máy tính. Nó có sẵn trên hàng trăm triệu PC, với tất cả phần mềm và 400 phần phụ thuộc được tích hợp thành một.

NVIDIA đã thử nghiệm NIM này và mọi mô hình được đào tạo trước đều được thử nghiệm trên toàn bộ bản cài đặt, tất cả các phiên bản khác nhau của Pascal, Ampere và Hopper cũng như nhiều phiên bản khác nhau. Tôi thậm chí còn quên một số tên. Phát minh đáng kinh ngạc, đây là một trong những phát minh yêu thích của tôi.

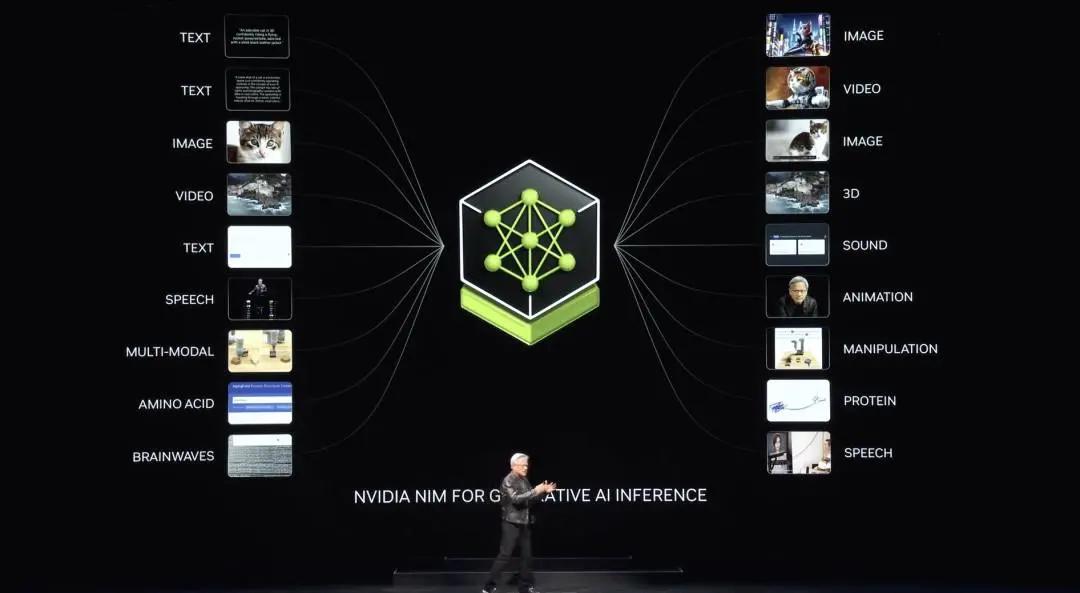

Jensen Huang cho biết Nvidia có tất cả các phiên bản khác nhau, cho dù đó là phiên bản dựa trên ngôn ngữ hay thị giác, dựa trên hình ảnh hay phiên bản dành cho chăm sóc sức khỏe, sinh học kỹ thuật số, đều có phiên bản dành cho con người kỹ thuật số, chỉ cần truy cập ai.nvidia com.

Huang Renxun cũng cho biết hôm nay NVIDIA vừa phát hành Llama3 NIM được tối ưu hóa hoàn toàn trên HuggingFace và nó có sẵn để bạn dùng thử, thậm chí bạn có thể lấy nó đi. Nó được cung cấp miễn phí cho bạn. Bạn có thể chạy nó trên đám mây, trong bất kỳ đám mây nào. Bạn có thể tải xuống vùng chứa này, đặt nó vào trung tâm dữ liệu của riêng bạn và cung cấp cho khách hàng của bạn.

Nvidia có các phiên bản thuộc nhiều lĩnh vực khác nhau, vật lý, một số để truy xuất ngữ nghĩa, được gọi là RAG, ngôn ngữ hình ảnh, tất cả các loại ngôn ngữ khác nhau. Phương pháp bạn sử dụng chúng là kết nối các dịch vụ vi mô này với các ứng dụng lớn hơn.

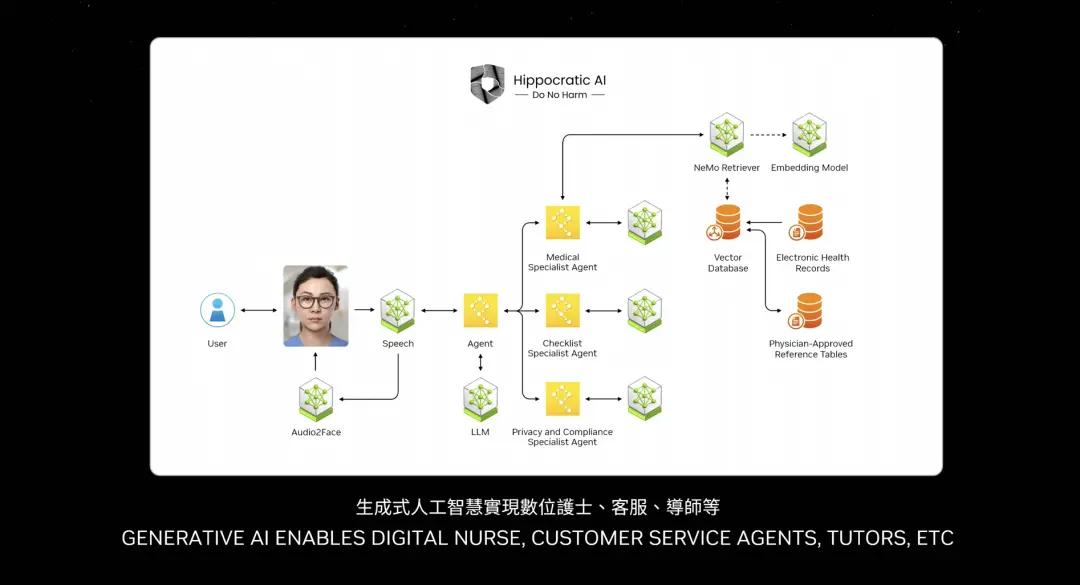

Một trong những ứng dụng quan trọng nhất của tương lai chắc chắn sẽ là dịch vụ khách hàng. Hầu hết mọi ngành công nghiệp đều cần có đại lý. Điều này đại diện cho hàng nghìn tỷ đô la trong dịch vụ khách hàng. Y tá cũng là đại lý dịch vụ khách hàng ở một số khía cạnh. Một số y tá không kê đơn hoặc không chẩn đoán về cơ bản là dịch vụ khách hàng trong ngành bán lẻ, dịch vụ ăn uống nhanh, dịch vụ tài chính và ngành bảo hiểm. Hàng chục triệu dịch vụ khách hàng hiện có thể được nâng cao nhờ các mô hình ngôn ngữ và AI. Vậy những chiếc hộp bạn nhìn thấy này về cơ bản là NIM.

Một số NIM là tác nhân lý luận đưa ra nhiệm vụ, xác định nhiệm vụ và phân tách chúng thành các kế hoạch. Một số NIM truy xuất thông tin. Một số NIM có thể thực hiện tìm kiếm. Một số NIM có thể sử dụng các công cụ, chẳng hạn như cuOpt, mà Jen-Hsun Huang đã đề cập trước đó. Nó có thể sử dụng các công cụ chạy trên SAP. Vì vậy, nó phải học một ngôn ngữ cụ thể gọi là ABAP. Có lẽ một số NIM phải thực hiện các truy vấn SQL. Vì vậy, tất cả các NIM này đều là chuyên gia và hiện đang được tập hợp thành một đội ngũ.

Vậy điều gì đã thay đổi? Lớp ứng dụng đã thay đổi. Các ứng dụng trước đây được viết bằng hướng dẫn giờ đây là ứng dụng tập hợp đội ngũ AI. Rất ít người biết cách viết chương trình, nhưng hầu hết mọi người đều biết cách chia nhỏ một vấn đề và tập hợp đội ngũ. Tôi tin rằng trong tương lai mọi công ty sẽ có lượng lớn. Bạn sẽ tải xuống các chuyên gia mà bạn muốn, kết nối họ thành một đội ngũ và thậm chí bạn không cần phải biết chính xác cách kết nối họ. Bạn chỉ cần giao nhiệm vụ cho một Đại lý, một NIM và để nó quyết định cách phân bổ nhiệm vụ. Người đại diện trưởng đội ngũ sẽ chia nhỏ nhiệm vụ và phân công chúng cho các thành viên khác nhau đội ngũ. Các thành viên đội ngũ sẽ thực hiện nhiệm vụ và trả kết quả cho trưởng đội ngũ, đội ngũ sẽ lý luận về kết quả và trình bày thông tin cho bạn, giống như con người. Đây là tương lai gần, hình dạng của các ứng dụng trong tương lai.

Tất nhiên, bạn có thể tương tác với các dịch vụ AI lớn này thông qua lời nhắc bằng văn bản và lời nhắc bằng giọng nói. Tuy nhiên, có nhiều ứng dụng muốn tương tác với hình dạng con người. Nvidia gọi đó là con người kỹ thuật số và đang nghiên cứu công nghệ con người kỹ thuật số.

Huang Renxun tiếp tục giới thiệu rằng con người kỹ thuật số có tiềm năng trở thành tác nhân tuyệt vời tương tác với bạn, khiến các tương tác trở nên hấp dẫn và nhân ái hơn. Tất nhiên, chúng ta phải thu hẹp khoảng cách thực tế to lớn này để làm cho con người kỹ thuật số trông tự nhiên hơn. Hãy tưởng tượng một tương lai nơi máy tính tương tác với chúng ta giống như cách con người làm. Đây là thực tế đáng kinh ngạc của nhân loại kỹ thuật số. Con người kỹ thuật số sẽ cách mạng hóa các ngành công nghiệp từ dịch vụ khách hàng đến quảng cáo và chơi game. Khả năng của con người kỹ thuật số là vô tận.

Sử dụng dữ liệu quét từ nhà bếp hiện tại của bạn. Thông qua điện thoại của bạn, họ sẽ trở thành nhà thiết kế nội thất AI, giúp đưa ra những gợi ý chân thực đẹp mắt và cung cấp nguồn nguyên liệu, đồ nội thất.

NVIDIA đã tạo ra một số tùy chọn thiết kế để bạn lựa chọn. Họ cũng sẽ trở thành đại lý dịch vụ khách hàng AI, giúp các tương tác trở nên sống động và cá nhân hóa hơn hoặc nhân viên chăm sóc sức khỏe kỹ thuật số, kiểm tra bệnh nhân để cung cấp dịch vụ chăm sóc kịp thời và cá nhân hóa. Họ thậm chí sẽ trở thành đại sứ thương hiệu AI, thiết lập làn sóng tiếp thị và Xu hướng quảng cáo tiếp theo.

Những đột phá mới về AI và đồ họa máy tính cho phép con người kỹ thuật số nhìn, hiểu và tương tác với chúng ta theo những cách giống con người. Từ những gì tôi thấy, có vẻ như bạn đang ở trong một dạng thiết lập ghi âm hoặc tạo ra nào đó. Nền tảng của con người kỹ thuật số là mô hình AI được xây dựng dựa trên nhận dạng và tổng hợp giọng nói đa ngôn ngữ, cũng như mô hình LLM có thể hiểu và tạo ra các cuộc hội thoại.

Những AI này kết nối với một AI tổng hợp khác để tạo hoạt ảnh động cho lưới khuôn mặt 3D thực tế. Cuối cùng, mô hình AI tái tạo hình ảnh chân thực, cho phép tán xạ lần theo đường dẫn theo thời gian thực, mô phỏng cách ánh sáng xuyên qua da, tán xạ và thoát ra ở các điểm khác nhau, mang lại cho da vẻ ngoài mềm mại và trong mờ.

Nvidia Ace là một bộ công nghệ kỹ thuật số dành cho con người được đóng gói thành các vi dịch vụ hoặc NIM được tối ưu hóa hoàn toàn, dễ triển khai. Các nhà phát triển có thể tích hợp Ace NIM vào các khung, công cụ và trải nghiệm con người kỹ thuật số hiện có của họ và Nematons SLM và LLM NIM hiểu ý định của chúng tôi và phối hợp với các mô hình khác.

Riva Speech Nims cho lời nói và dịch thuật tương tác, NIM âm thanh cho khuôn mặt và cử chỉ cho hoạt ảnh khuôn mặt và cơ thể, Omniverse RTX và DLSS để hiển thị thần kinh của da và tóc.

Khá khó tin. Những con Ace này có thể chạy trên đám mây hoặc trên PC và bao gồm GPU lõi tensor trong tất cả các GPU RTX, vì vậy Nvidia đã bán ra GPU AI để chuẩn bị cho ngày này. Lý do rất đơn giản, để tạo ra một nền tảng điện toán mới, trước tiên bạn cần có một nền tảng được cài đặt sẵn.

Cuối cùng, ứng dụng sẽ xuất hiện. Làm thế nào một ứng dụng có thể tồn tại mà không cần tạo cơ sở cài đặt? Vì vậy, nếu bạn xây dựng nó, có thể họ sẽ không đến. Nhưng nếu bạn không xây dựng nó, họ không thể đến được. Do đó, Nvidia cài đặt bộ xử lý Tensor Core trong mọi GPU RTX. Nvidia hiện có 100 triệu PC GeForce RTX AI trên toàn thế giới và Nvidia đang bán ra 200 chiếc.

Tại Lần , NVIDIA đã giới thiệu bốn chiếc máy tính xách tay mới tuyệt vời. Họ đều có khả năng chạy AI. Máy tính xách tay và PC trong tương lai sẽ trở thành AI. Nó sẽ tiếp tục giúp đỡ bạn và hỗ trợ bạn trong nền. PC cũng sẽ chạy các ứng dụng được tăng cường bởi AI.

Tất nhiên, tất cả các công cụ chỉnh sửa ảnh, viết lách, mọi thứ bạn sử dụng sẽ được tăng cường bởi AI. PC của bạn cũng sẽ lưu trữ các ứng dụng AI với con người kỹ thuật số. Do đó, AI sẽ thể hiện theo những cách khác nhau và được sử dụng trong PC. PC sẽ trở thành một nền tảng AI rất quan trọng.

Vì vậy, nơi nào chúng ta đi từ đây? Tôi đã nói về mở rộng trung tâm dữ liệu trước đó. Lần khi mở rộng, chúng tôi khám phá ra một bước nhảy vọt mới. Khi mở rộng từ DGX sang siêu máy tính AI lớn, NVIDIA cho phép Transformer đào tạo trên các tập dữ liệu rất lớn. Ban đầu, dữ liệu được giám sát thủ công và cần có sự chú thích của con người để huấn luyện AI. Thật không may, dữ liệu do con người gắn nhãn bị hạn chế.

Transformer giúp việc học tập không giám sát trở nên khả thi. Giờ đây, Transformer có thể chỉ cần xem xét lượng lớn dữ liệu, video hoặc hình ảnh và nó có thể tự tìm thấy các mẫu và mối quan hệ bằng cách nghiên cứu lượng lớn dữ liệu.

Thế hệ AI tiếp theo cần phải dựa trên vật lý. Hầu hết AI ngày nay không hiểu các định luật vật lý, chúng không bắt nguồn từ thế giới vật chất. Để tạo ra hình ảnh, video và đồ họa 3D cũng như nhiều hiện tượng vật lý, chúng ta cần AI dựa trên vật lý và hiểu các định luật vật lý. Bạn có thể làm điều này thông qua việc học qua video, đây là một nguồn.

Một phương pháp khác là tổng hợp dữ liệu, mô phỏng dữ liệu và một phương pháp khác là để các máy tính học hỏi lẫn nhau. Điều này thực ra không khác gì việc AlphaGo tự chơi bằng cách chơi những trò chơi có cùng khả năng, chúng sẽ trở nên thông minh hơn theo thời gian. Bạn sẽ bắt đầu thấy loại AI này xuất hiện.

Nếu dữ liệu AI được tạo tổng hợp và sử dụng phương pháp học tăng cường, tốc độ tạo dữ liệu sẽ tiếp tục tăng. Lần việc tạo dữ liệu tăng trưởng thì số lượng tính toán cần được cung cấp cũng tăng trưởng.

Chúng ta sắp bước vào giai đoạn mà AI có thể học các định luật vật lý và bắt nguồn từ dữ liệu từ thế giới vật chất. Do đó, Nvidia kỳ vọng rằng các mẫu máy sẽ tiếp tục tăng trưởng và chúng ta sẽ cần GPU lớn hơn.

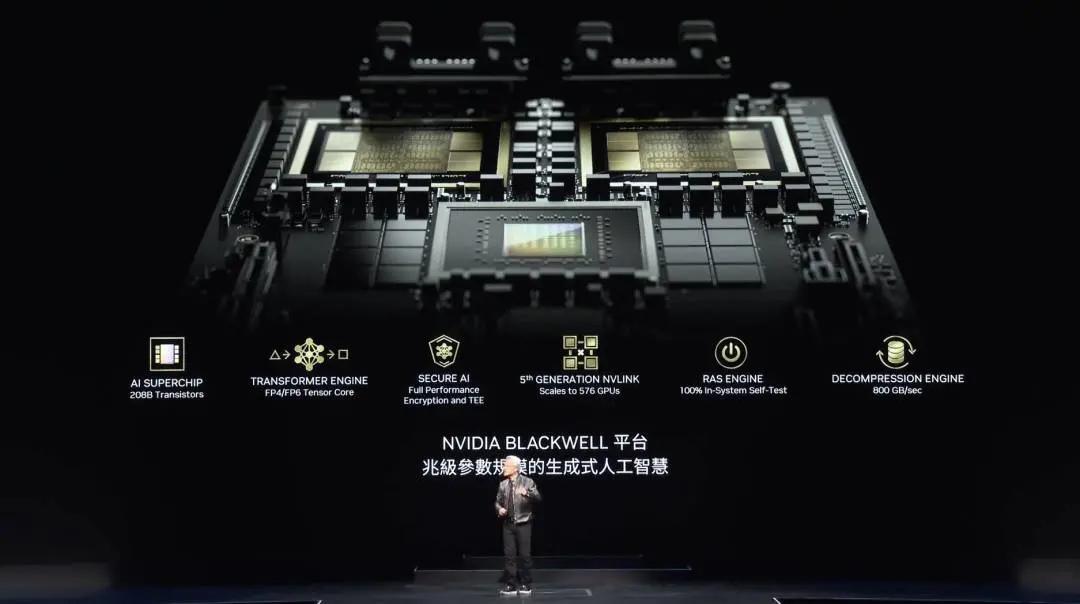

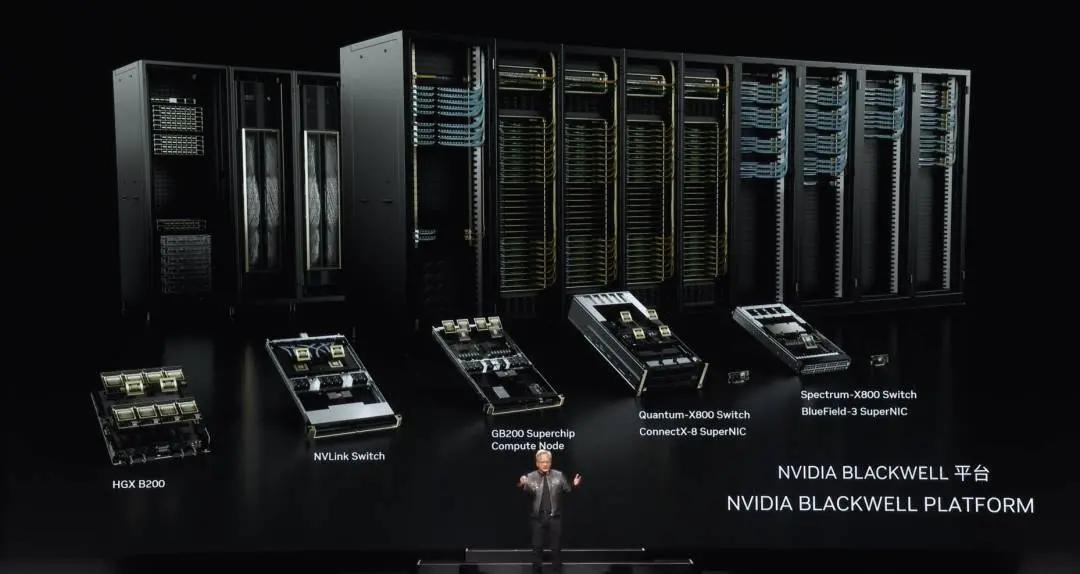

Blackwell

Blackwell được thiết kế cho thế hệ này và có một số công nghệ rất quan trọng. Đầu tiên là kích thước của chip. Nvidia sản xuất chip lớn nhất tại TSMC và kết nối hai chip với nhau bằng kết nối 10TB mỗi giây, SerDes tiên tiến nhất thế giới. Sau đó, Nvidia đặt hai chip vào một nút điện toán và kết nối chúng thông qua CPU Grace.

Grace CPU có thể được sử dụng cho nhiều mục đích. Có thể được sử dụng để kiểm tra nhanh và khởi động lại trong các tình huống luyện tập. Trong cả tình huống lý luận và tạo, nó có thể được sử dụng để lưu trữ bộ nhớ theo ngữ cảnh để AI hiểu được ngữ cảnh của cuộc trò chuyện mà bạn muốn có. Đây là công cụ Transformer thế hệ thứ hai của Nvidia, cho phép điều chỉnh động độ chính xác dựa trên. độ chính xác và phạm vi được yêu cầu bởi lớp tính toán.

Đây là thế hệ GPU thứ hai có AI bảo mật, yêu cầu các nhà cung cấp dịch vụ bảo vệ AI khỏi bị đánh cắp hoặc giả mạo. Đây là thế hệ thứ năm của NVLink, cho phép kết nối nhiều GPU với nhau, tôi sẽ trình bày chi tiết sau.

Đây là GPU thế hệ đầu tiên của Nvidia với công cụ có độ tin cậy và sẵn sàng. Hệ thống RAS này cho phép kiểm tra mọi bóng bán dẫn, flip-flop, bộ nhớ trên chip và bộ nhớ ngoài chip để xác định tại chỗ xem chip có bị lỗi hay không. Thời gian trung bình giữa các lần hỏng hóc đối với siêu máy tính có 10.000 GPU được tính bằng giờ. Thời gian trung bình giữa các lần hỏng hóc đối với siêu máy tính có 100.000 GPU được tính bằng phút.

Vì vậy, gần như không thể chạy siêu máy tính trong thời gian dài và huấn luyện các mô hình trong vài tháng nếu không phát minh ra công nghệ để nâng cao độ tin cậy. Độ tin cậy làm tăng thời gian hoạt động, ảnh hưởng trực tiếp đến chi phí. Cuối cùng là công cụ giải nén, xử lý dữ liệu là một trong những việc quan trọng nhất phải làm. NVIDIA đã bổ sung công cụ nén và giải nén dữ liệu cho phép NVIDIA trích rút dữ liệu từ bộ lưu trữ nhanh hơn 20 lần so với khả năng hiện nay.

Blackwell đang được sản xuất và có lượng lớn công nghệ có thể nhìn thấy mọi con chip Blackwell, hai con chip được kết nối với nhau. Bạn thấy đây là con chip lớn nhất thế giới. Sau đó kết nối hai con chip với nhau với tốc độ 10TB mỗi giây và hiệu suất thật đáng kinh ngạc.

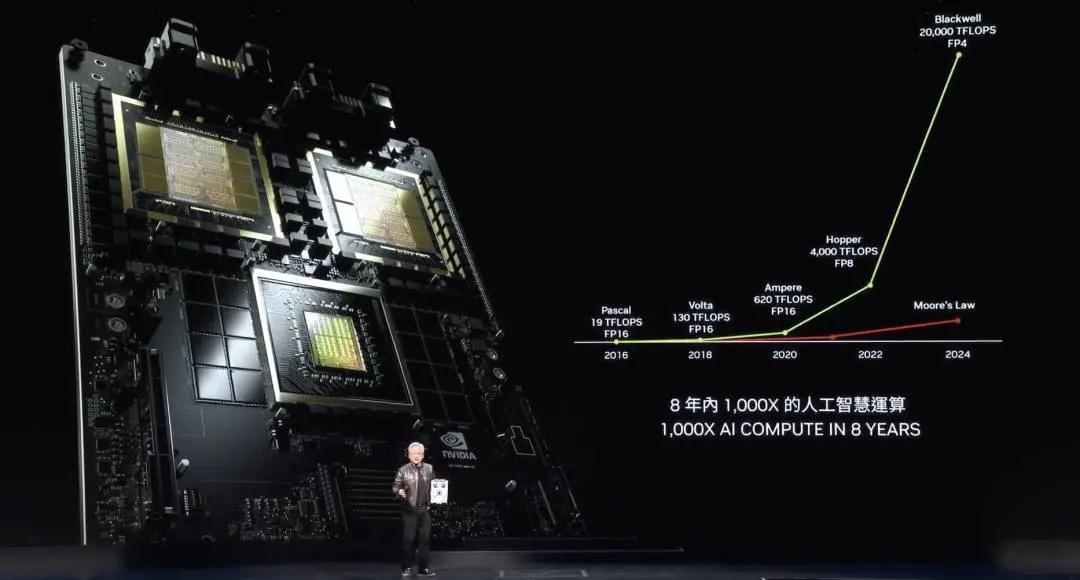

Mỗi thế hệ điện toán NVIDIA sẽ tăng sức mạnh tính toán dấu phẩy động lên gấp 1.000 lần. Định luật Moore tăng trưởng khoảng 40 đến 60 lần trong 8 năm. Và trong tám năm qua, tăng trưởng của Định luật Moore đã chậm lại đáng kể. Ngay cả ở định luật Moore tốt nhất, cũng không thể so sánh được với hiệu suất của Blackwell.

Khối lượng tính toán thật đáng kinh ngạc. Lần bạn tăng sức mạnh tính toán, chi phí sẽ giảm giảm. NVIDIA đã giảm yêu cầu năng lượng để huấn luyện GPT-4 từ 1.000 GWh xuống còn 3 GWh bằng cách tăng sức mạnh tính toán. Pascal cần 1000 GWh năng lượng. 1000 GWh nghĩa là cần có một trung tâm dữ liệu GW. Trên thế giới không có trung tâm dữ liệu GW nhưng nếu có trung tâm dữ liệu GW thì phải mất một tháng. Nếu bạn có một trung tâm dữ liệu 100 MW thì mất khoảng một năm. Vì vậy, không ai sẽ xây dựng một cơ sở như vậy.

Đây là lý do tại sao 8 năm trước, một LLM như ChatGPT là không thể. Bằng cách cải thiện hiệu suất, cùng với việc tăng hiệu quả sử dụng năng lượng, Nvidia hiện đã giảm yêu cầu năng lượng của Blackwell từ 1.000 GWh xuống còn 3 GWh, đây là một sự cải thiện đáng kinh ngạc. Nếu là 10.000 GPU chẳng hạn thì mất vài ngày, có thể khoảng 10 ngày. Những tiến bộ đạt được chỉ trong 8 năm thật đáng kinh ngạc.

Phần này nói về lý luận và tạo ra các token. Việc tạo mã thông báo GPT-4 cần có hai bóng đèn chạy trong hai ngày. Phải mất khoảng ba mã thông báo để tạo ra một từ. Do đó, năng lượng cần thiết để Pascal tạo GPT-4 và có trải nghiệm ChatGPT với bạn là gần như không thể. Nhưng hiện tại, mỗi mã thông báo chỉ sử dụng 0,4 joules và mã thông báo có thể được tạo ra với mức năng lượng cực thấp.

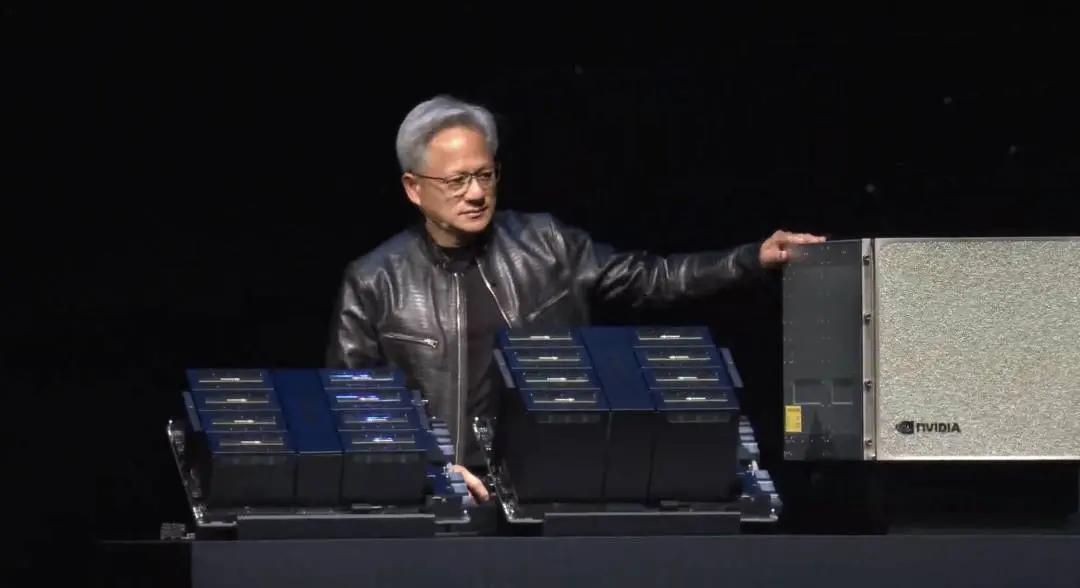

Blackwell là một bước nhảy vọt lớn. Dù sao thì nó cũng chưa đủ lớn. Vì vậy, những cỗ máy lớn hơn phải được chế tạo. Vì vậy phương pháp Nvidia xây dựng nó được gọi là DGX.

Đây là DGX Blackwell, được làm mát bằng không khí và có 8 GPU bên trong. Hãy nhìn kích thước của các tản nhiệt trên những GPU này, nó khoảng 15 kilowatt, làm mát hoàn toàn bằng không khí. Phiên bản này hỗ trợ x86 và đi vào cơ sở hạ tầng Hoppers mà Nvidia đã vận chuyển. Nvidia có một hệ thống mới gọi là MGX, có nghĩa là hệ thống mô-đun.

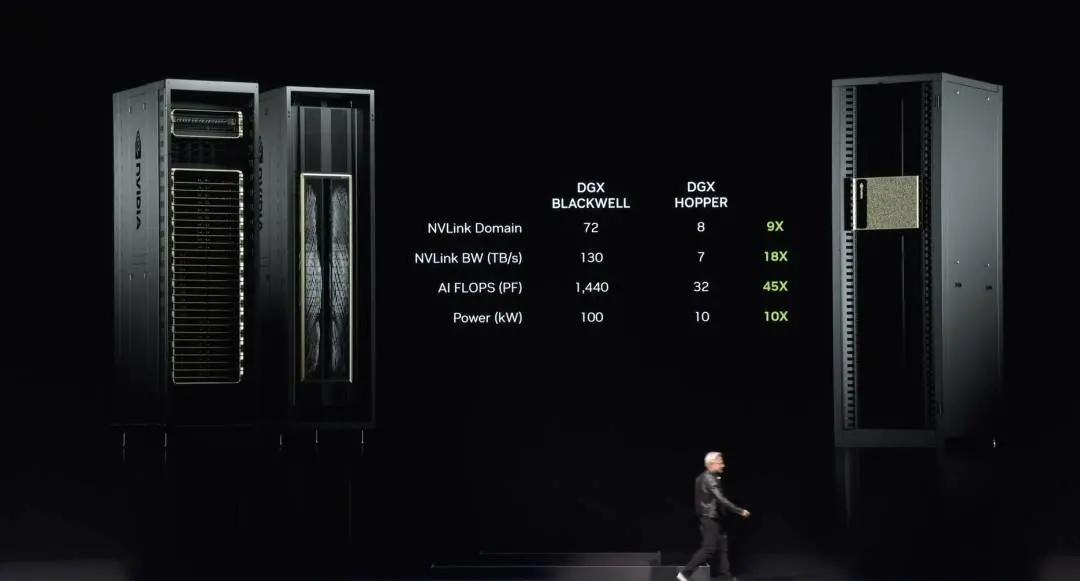

Hai bảng Blackwell, một nút có bốn chip Blackwell. Các chip Blackwell này được làm mát bằng chất lỏng và 72 GPU được kết nối với nhau thông qua NVLink mới. Đây là switch NVLink thế hệ thứ 5, bản thân switch NVLink đã là một tuyệt tác về công nghệ, nó là switch tiên tiến nhất thế giới, tốc độ dữ liệu đáng kinh ngạc, các switch này kết nối mọi Blackwell với nhau nên có 72 GPU Blackwell khổng lồ.

Ưu điểm của việc này là trong một miền, miền GPU giờ đây trông giống như một GPU, có 72 GPU, so với 8 ở thế hệ trước. Do đó băng thông tăng gấp chín lần. Hiệu suất tính toán dấu phẩy động AI đã tăng 18 lần và cải thiện 45 lần. Và mức tiêu thụ điện năng chỉ tăng 10 lần, lần này là 100 kilowatt và lần kia là 10 kilowatt. Đây là một.

Tất nhiên, bạn luôn có thể kết nối nhiều thứ này lại với nhau và tôi sẽ chỉ cho bạn cách thực hiện điều đó sau. Nhưng điều kỳ diệu là con chip này, con chip NVLink này. Mọi người bắt đầu nhận ra con chip NVLink này quan trọng như thế nào vì nó kết nối tất cả các GPU khác nhau này. Vì LLM rất lớn nên không thể đặt nó trên chỉ một GPU, cũng như không thể đặt nó trên chỉ một nút. Nó yêu cầu toàn bộ giá GPU, giống như DGX mới mà tôi vừa đứng cạnh, có thể chứa LLM với hàng nghìn tỷ thông số.

Bản thân bộ chuyển mạch NVLink là một tuyệt tác công nghệ, với 50 tỷ bóng bán dẫn, 74 cổng, tốc độ 400Gbps mỗi cổng và băng thông cắt ngang là 7,2Tbps. Nhưng điều quan trọng là nó có khả năng toán học bên trong switch, điều này rất quan trọng trong độ sâu learning, để thực hiện các thao tác rút gọn trên chip. Vậy bây giờ đây là DGX.

Huang cho biết nhiều người đã hỏi và một số người tỏ ra bối rối về công việc của Nvidia cũng như tại sao Nvidia lại trở nên lớn mạnh như vậy bằng cách sản xuất GPU. Vì vậy, một số người cho rằng GPU trông như thế này.

Bây giờ đây là GPU, đây là một trong những GPU tiên tiến nhất trên thế giới, nhưng đây là GPU chơi game. Bạn và tôi biết GP là như thế này. Đây là GPU, thưa quý vị, GPU DGX. Bạn biết đấy mặt sau của GPU này chính là xương sống NVLink. Đường trục NVLink có 5.000 dây và dài 2 dặm. Nó kết nối hai GPU với nhau và là một tuyệt tác về điện và cơ khí. Bộ thu phát cho phép truyền động dọc theo toàn bộ chiều dài của dây đồng, tiết kiệm 20 kilowatt điện năng tiêu thụ trên một giá đỡ.

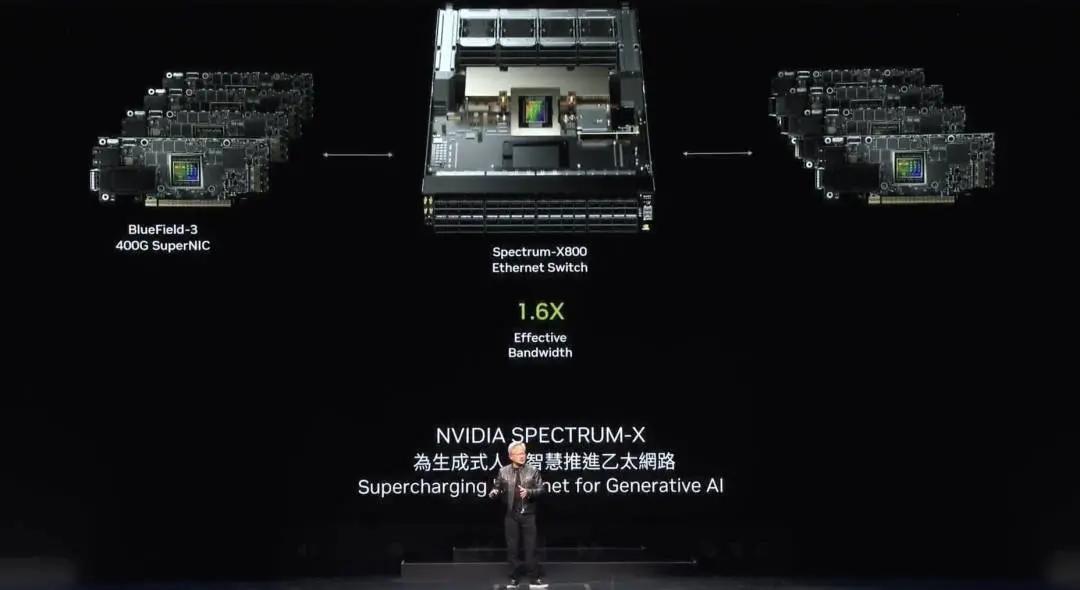

Huang Renxun cho biết có hai loại mạng. InfiniBand được sử dụng rộng rãi trong các nhà máy siêu máy tính và AI trên toàn thế giới và tăng trưởng ở mức đáng báo động. Tuy nhiên, không phải trung tâm dữ liệu nào cũng có thể xử lý InfiniBand vì họ đã đầu tư rất nhiều Ethernet vào hệ sinh thái của mình và việc quản lý các thiết bị chuyển mạch cũng như mạng InfiniBand đòi hỏi một số kiến thức chuyên môn.

Do đó, NVIDIA mang khả năng của InfiniBand vào kiến trúc Ethernet, điều này rất khó khăn. lý do rất đơn giản. Ethernet được thiết kế cho thông lượng trung bình cao vì mỗi nút, mỗi máy tính được kết nối với một người khác trên Internet và hầu hết giao tiếp là giữa trung tâm dữ liệu và người ở phía bên kia của Internet.

Tuy nhiên, độ sâu learning và AI, GPU chủ yếu giao tiếp với nhau. Họ giao tiếp với nhau khi thu thập các bộ phận của sản phẩm, sau đó giảm bớt và phân phối lại chúng. Thu thập, giảm thiểu và phân phối lại các sản phẩm một phần. Loại lưu lượng truy cập này rất bùng nổ và điều quan trọng không phải là lưu lượng trung bình mà là lưu lượng đến cuối cùng. Vì vậy, Nvidia đã tạo ra một số công nghệ, tạo ra kiến trúc đầu cuối cho phép các card giao diện mạng và bộ chuyển mạch giao tiếp, đồng thời áp dụng bốn công nghệ khác nhau để đạt được điều này. Trước hết, Nvidia có RDMA tiên tiến nhất trên thế giới và hiện có thể thực hiện RDMA cấp mạng trên Ethernet, điều này thật đáng kinh ngạc.

Thứ hai, NVIDIA có khả năng kiểm soát tắc nghẽn. Bộ chuyển mạch luôn thực hiện đo từ xa nhanh và khi GPU hoặc card giao diện mạng gửi quá nhiều thông tin, nó có thể yêu cầu chúng dừng lại để tránh tạo điểm nóng.

Thứ ba, định tuyến thích ứng. Ethernet yêu cầu truyền và nhận tuần tự. Các cổng mà Nvidia cho là bị tắc nghẽn hoặc không được sử dụng, bất kể thứ tự, sẽ được gửi đến các cổng có sẵn và BlueField sắp xếp ở đầu bên kia để đảm bảo thứ tự là chính xác.

Cuối cùng là cách ly tiếng ồn. Luôn có nhiều mô hình đào tạo hoặc những thứ khác đang diễn ra trong trung tâm dữ liệu, tiếng ồn và lưu lượng truy cập của chúng có thể ảnh hưởng lẫn nhau và gây ra hiện tượng giật. Do đó, khi tiếng ồn trong mô hình được huấn luyện khiến mô hình cuối cùng đến quá muộn, tốc độ huấn luyện tổng thể sẽ giảm đáng kể.

Hãy nhớ rằng, bạn đã xây dựng một trung tâm dữ liệu giá 5 tỷ USD hoặc 3 tỷ USD cho việc đào tạo. Nếu mức sử dụng mạng giảm 40%, dẫn đến thời gian đào tạo tăng 20%, thì một trung tâm dữ liệu giá 5 tỷ USD thực sự tương đương với một trung tâm dữ liệu giá 6 tỷ USD. Vì vậy, tác động chi phí là rất lớn. Ethernet sử dụng Spectrum X cho phép cải thiện đáng kể hiệu suất trong khi mạng về cơ bản là miễn phí.

NVIDIA có toàn bộ dòng sản phẩm Ethernet. Đây là Spectrum X800, với tốc độ 51,2Tbps mỗi giây và 256 cổng. Tiếp theo là mẫu 512 cổng ra mắt vào năm sau có tên Spectrum X800 Ultra, và sau đó là X16. Khái niệm quan trọng là X800 được thiết kế cho hàng nghìn GPU, X800 Ultra được thiết kế cho hàng trăm nghìn GPU, X16 được thiết kế cho hàng triệu GPU và kỷ nguyên của các trung tâm dữ liệu đa GPU đang đến.

Gần như mọi tương tác bạn có với Internet hoặc máy tính trong tương lai sẽ có một AI tổng hợp chạy ở đâu đó. AI tổng hợp này làm việc với bạn, tương tác với bạn, tạo video, hình ảnh hoặc văn bản hoặc thậm chí là con người kỹ thuật số. Bạn tương tác với máy tính hầu như mọi lúc và luôn có một AI tổng hợp được kết nối, một số cục bộ, một số trên thiết bị của bạn và có thể hầu hết là trên đám mây. Những AI sáng tạo này cũng thực hiện lượng lớn lý do, không đưa ra câu trả lời một lần mà cải thiện chất lượng của câu trả lời qua lần lần lặp lại. Vì vậy, lượng nội dung được tạo ra trong tương lai sẽ rất đáng kinh ngạc.

Tất nhiên, Blackwell là thế hệ nền tảng đầu tiên của Nvidia, được phát hành ngay khi thế giới đang thức dậy trước thời đại AI sáng tạo. Khi thế giới đang nhận ra tầm quan trọng của các nhà máy AI thì đó cũng là lúc bắt đầu cuộc cách mạng công nghiệp mới này. NVIDIA được hầu hết mọi OEM, nhà sản xuất máy tính, nhà cung cấp dịch vụ đám mây, đám mây GPU, đám mây có chủ quyền và thậm chí cả các công ty viễn thông hỗ trợ. Sự thành công, sự áp dụng và sự nhiệt tình tại Blackwell thật đáng kinh ngạc. Tôi muốn cảm ơn tất cả mọi người.

Đúng vậy, trong giai đoạn tăng trưởng đáng kinh ngạc này, NVIDIA muốn đảm bảo rằng họ tiếp tục cải thiện hiệu suất, tiếp tục giảm chi phí đào tạo và chi phí suy luận, đồng thời tiếp tục mở rộng khả năng AI để mọi công ty đều có thể tiếp cận được. Khi NVIDIA thúc đẩy cải tiến hiệu suất thì mức giảm chi phí càng lớn. Nền tảng Hopper chắc chắn là bộ xử lý trung tâm dữ liệu thành công nhất trong lịch sử và nó thực sự là một câu chuyện thành công đáng kinh ngạc.

Tuy nhiên, Blackwell đã xuất hiện và mỗi nền tảng, như bạn có thể thấy, đều chứa đựng một số thứ. Bạn có CPU, bạn có GPU, bạn có NVLink, bạn có giao diện mạng, bạn có bộ chuyển mạch NVLink kết nối tất cả các GPU, miền càng lớn càng tốt. Dù nó có thể làm được gì, Nvidia vẫn kết nối nó với các thiết bị chuyển mạch lớn, tốc độ rất cao.

Với mỗi thế hệ sản phẩm, bạn sẽ thấy không chỉ GPU mà còn toàn bộ nền tảng. Xây dựng toàn bộ nền tảng. Tích hợp toàn bộ nền tảng vào siêu máy tính nhà máy AI. Tuy nhiên, hãy chia nhỏ nó ra và cung cấp nó cho thế giới. Lý do cho điều này là vì tất cả các bạn đều có thể tạo ra các cấu hình thú vị và sáng tạo, đồng thời điều chỉnh chúng cho phù hợp với các trung tâm dữ liệu khác nhau và các nhu cầu khác nhau của khách hàng, một số dành cho điện toán biên và một số dành cho viễn thông. Tất cả những đổi mới khác nhau đều có thể thực hiện được nếu bạn mở hệ thống và cho phép bạn đổi mới. Vì vậy, Nvidia đã thiết kế tích hợp nhưng chia nhỏ nó cho khách hàng để có thể tạo ra các hệ thống mô-đun.

Nền tảng Blackwell đã xuất hiện, và triết lý cơ bản của Nvidia rất đơn giản: hàng năm xây dựng toàn bộ trung tâm dữ liệu, chia nhỏ và bán thành từng phần, đẩy mọi thứ đến giới hạn của công nghệ, cho dù đó là công nghệ xử lý, công nghệ đóng gói, công nghệ bộ nhớ của TSMC , Công nghệ SerDes, Công nghệ quang học, mọi thứ đều bị đẩy đến giới hạn của nó. Sau đó, đảm bảo tất cả phần mềm đều hoạt động trên toàn bộ cơ sở cài đặt.

Quán tính phần mềm là một trong những điều quan trọng nhất trong máy tính. Khi máy tính có khả năng tương thích ngược và tương thích với tất cả các kiến trúc phần mềm đã được tạo ra, bạn sẽ tiếp cận thị trường nhanh hơn nhiều. Vì vậy, khi bạn có thể tận dụng toàn bộ nền tảng phần mềm đã cài đặt đã được tạo, tốc độ sẽ rất đáng kinh ngạc.

Huang Renxun nói rằng Blackwell đã đến và năm tới sẽ là Blackwell Ultra, giống như H100 và H200, bạn có thể thấy một số thế hệ Blackwell Ultra mới thú vị vượt qua các giới hạn. Thế hệ tiếp theo của Spectrum switch mà tôi đã đề cập, đây là lần đầu tiên loại bước nhảy vọt này được thực hiện, nền tảng thế hệ tiếp theo được gọi là Ruben, và trong một năm nữa sẽ có nền tảng Ruben Ultra.

Tất cả các chip được hiển thị đều đang được phát triển hoàn chỉnh, phát triển 100%. Đây là nhịp điệu của năm của NVIDIA, tất cả đều tương thích 100% với kiến trúc, tất cả phần mềm phong phú mà NVIDIA đang xây dựng.

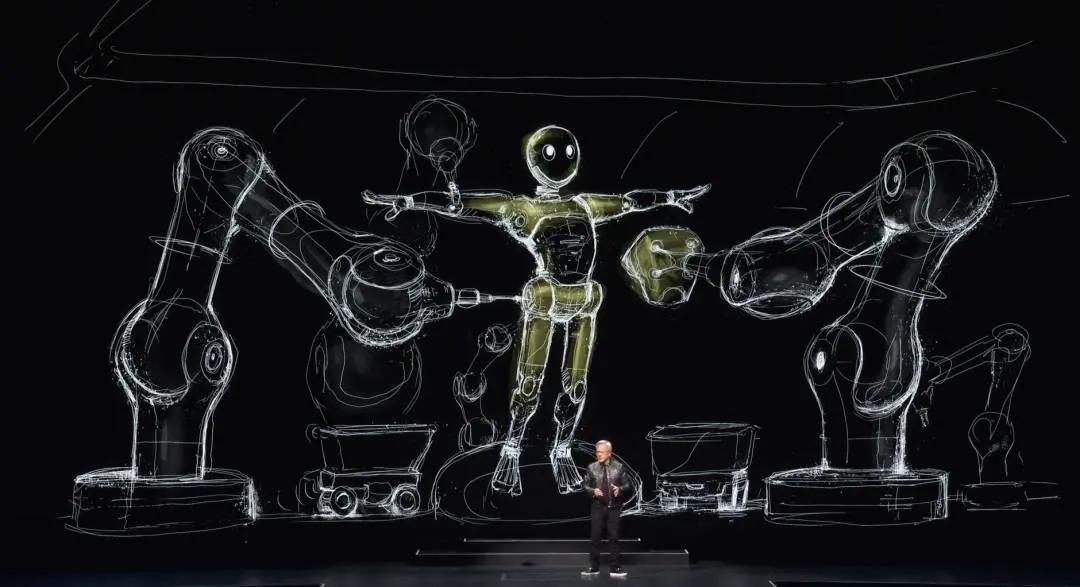

robot trí tuệ nhân tạo

Hãy để tôi nói về những gì sắp xảy ra, làn sóng AI tiếp theo là AI vật lý, hiểu được các định luật vật lý và có thể làm việc giữa chúng ta. Vì vậy, họ phải hiểu mô hình thế giới, cách giải thích thế giới và cách nhận thức thế giới. Chắc chắn chúng cũng đòi hỏi khả năng nhận thức xuất sắc để hiểu được vấn đề của chúng ta và thực hiện nhiệm vụ.

Robot là một khái niệm rộng hơn. Tất nhiên, khi tôi nói robot, tôi thường muốn nói đến robot hình người, nhưng điều đó không hoàn toàn chính xác. Mọi thứ sẽ là robot. Tất cả các nhà máy sẽ là robot, các nhà máy sẽ điều phối robot, những robot này sẽ tạo ra các sản phẩm robot và các robot sẽ c