Ghi chú của biên tập viên: Bài báo "Attention Is All You Need" được xuất bản năm 2017 và đến nay đã được trích dẫn hơn 110.000 lần. Đây không chỉ là một trong những nguồn gốc của công nghệ mô hình lớn tiêu biểu như ChatGPT, mà kiến trúc Transformer và cơ chế chú ý được giới thiệu trong đó cũng đã được sử dụng rộng rãi trong nhiều công nghệ AI có khả năng thay đổi thế giới, chẳng hạn như Sora và AlphaFold.

"Sự chú ý là tất cả những gì bạn cần" - bài nghiên cứu này đã cách mạng hóa tương lai của trí tuệ nhân tạo (AI) hiện đại. Trong bài viết này, tôi sẽ đi sâu vào mô hình Transformer và tương lai của AI.

Vào ngày 12 tháng 6 năm 2017, tám kỹ sư của Google đã công bố một bài nghiên cứu có tiêu đề "Attention Is All You Need" (Sự chú ý là tất cả những gì bạn cần), trong đó thảo luận về kiến trúc mạng thần kinh sẽ thay đổi tương lai của trí tuệ nhân tạo hiện đại.

Tại hội nghị GTC ngày 21 tháng 3 năm 2024, người sáng lập Nvidia, Jensen Huang, đã có buổi thảo luận với tám kỹ sư của Google và cảm ơn họ vì đã giới thiệu kiến trúc Transformer, nền tảng giúp cho trí tuệ nhân tạo hiện đại trở nên khả thi. Điều đáng ngạc nhiên là người sáng lập NEAR cũng nằm trong danh sách tám người này.

Máy biến áp là gì?

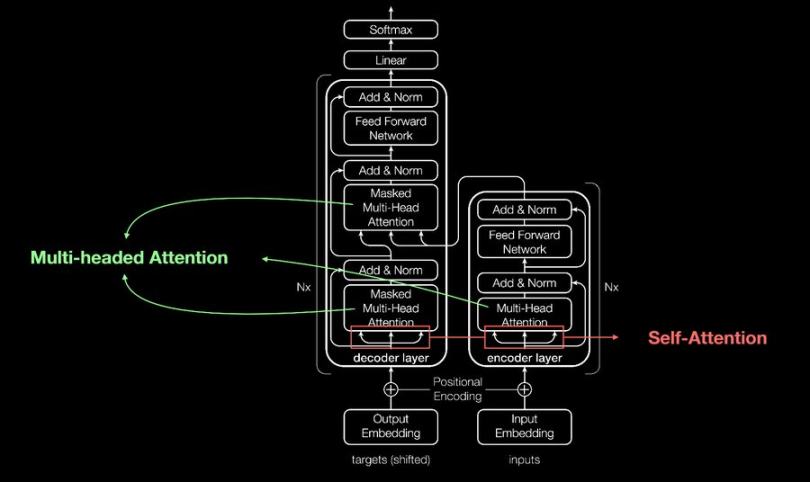

Transformer là một loại mạng nơ-ron.

Mạng nơ-ron là gì? Lấy cảm hứng từ cấu trúc và chức năng của bộ não con người, nó xử lý thông tin thông qua lượng lớn các nơ-ron nhân tạo được kết nối với nhau, nhưng nó không phải là bản sao hoàn chỉnh của bộ não con người .

Nói một cách đơn giản, bộ não con người giống như rừng mưa Amazon, với nhiều vùng khác nhau và vô số đường dẫn kết nối chúng. Các tế bào thần kinh giống như những cầu nối giữa các đường dẫn này; chúng có thể gửi và nhận tín hiệu đến và từ bất kỳ phần nào của rừng mưa. Do đó, sự kết nối chính là đường dẫn, chịu trách nhiệm liên kết hai vùng não khác nhau.

Điều này mang lại cho bộ não của chúng ta khả năng học tập vô cùng mạnh mẽ; chúng có thể học nhanh, nhận biết các mẫu và cung cấp kết quả chính xác. Các mạng thần kinh như Transformer cố gắng đạt được khả năng học tập tương tự như bộ não con người, mặc dù công nghệ hiện tại của chúng chỉ tiên tiến bằng chưa đến 1% so với bộ não con người .

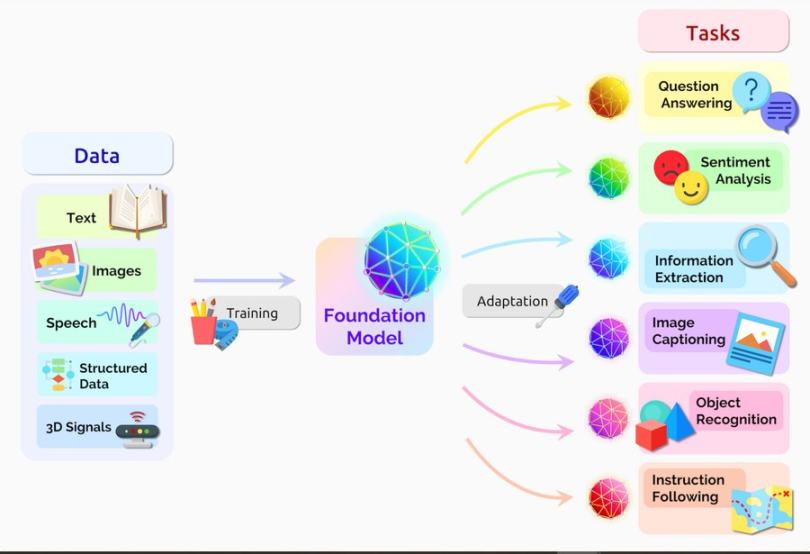

Trong những năm gần đây, Transformer đã đạt được những tiến bộ đáng kể trong lĩnh vực trí tuệ nhân tạo tạo sinh. Nhìn lại quá trình phát triển của trí tuệ nhân tạo hiện đại, chúng ta có thể thấy rằng trí tuệ nhân tạo thời kỳ đầu chủ yếu giống như Siri và các ứng dụng nhận dạng giọng nói khác.

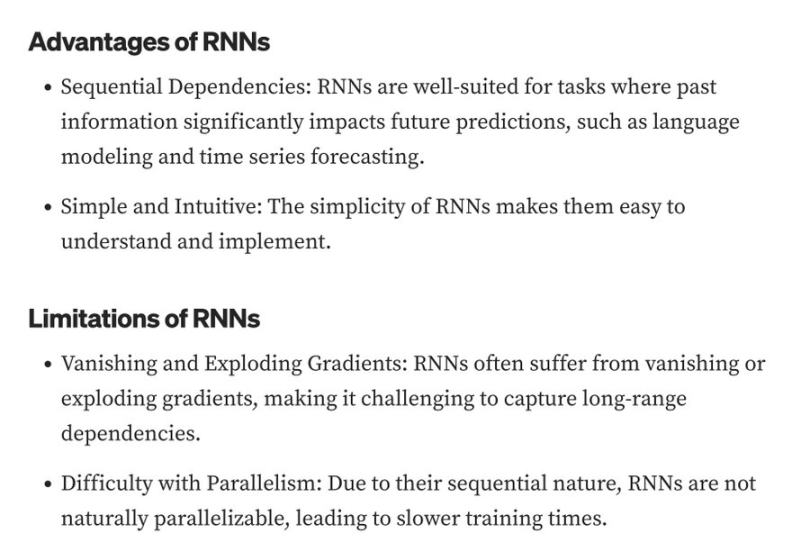

Tất cả các ứng dụng này đều được xây dựng bằng mạng nơ-ron hồi quy (RNN). RNN có một số hạn chế, đã được giải quyết và cải thiện bởi Transformer - Transformer giới thiệu cơ chế tự chú ý cho phép chúng phân tích tất cả các phần của bất kỳ chuỗi nào cùng một lúc, từ đó nắm bắt được các mối quan hệ phụ thuộc tầm xa và nội dung ngữ cảnh.

Chúng ta vẫn đang ở giai đoạn rất sớm trong chu kỳ đổi mới của Transformer. Hiện có một số phiên bản phái sinh khác nhau của Transformer, chẳng hạn như XLNet, BERT và GPT.

GPT là có tiếng nhất trong đó , nhưng khả năng dự đoán các sự kiện của nó vẫn còn hạn chế.

Khi các mô hình ngôn ngữ quy mô lớn (LLM) có khả năng dự đoán các sự kiện dựa trên dữ liệu và mô hình trong quá khứ, điều đó sẽ đánh dấu bước tiến lớn tiếp theo trong trí tuệ nhân tạo hiện đại và cũng sẽ đẩy nhanh tiến trình của chúng ta hướng tới trí tuệ nhân tạo tổng quát (AGI) .

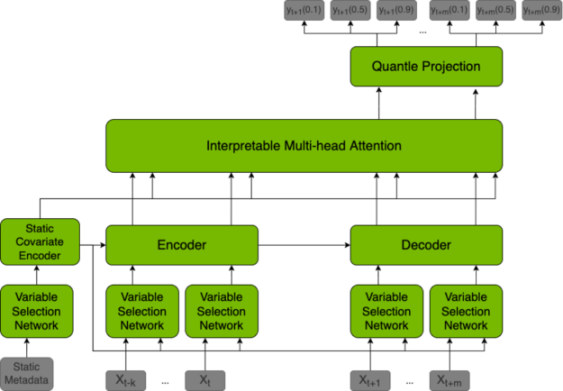

Để đạt được khả năng dự đoán này, các mô hình ngôn ngữ quy mô lớn (LLM) cần sử dụng các bộ chuyển đổi hợp nhất thời gian (TFT), là các mô hình dự đoán các giá trị tương lai dựa trên dữ liệu khác nhau và cũng có thể giải thích các dự đoán mà chúng đưa ra.

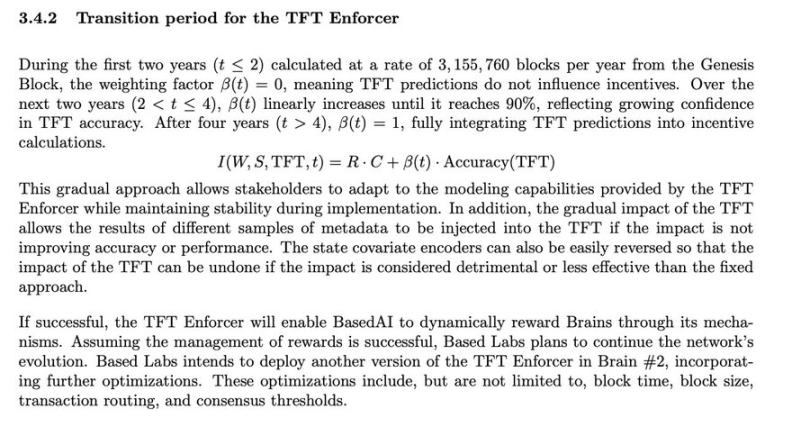

Bên cạnh dự đoán, TFT cũng có thể được sử dụng trong lĩnh vực blockchain. Bằng cách định nghĩa các quy tắc cụ thể trong mô hình, TFT có thể tự động thực hiện các thao tác sau: quản lý hiệu quả quá trình đồng thuận, cải thiện tốc độ tạo khối, thưởng cho các trình xác thực trung thực và trừng phạt các trình xác thực gian lận .

Về cơ bản, các mạng blockchain có thể cung cấp nhiều phần thưởng khối hơn cho các trình xác thực có điểm uy tín cao hơn, dựa trên lịch sử bỏ phiếu, lịch sử Đề án khối, lịch sử phạt, số tiền Staking , mức độ hoạt động và các thông số khác.

Cơ chế đồng thuận của chuỗi công khai về cơ bản là một trò chơi giữa các trình xác thực, yêu cầu hơn hai phần ba số trình xác thực phải đồng ý về việc ai sẽ tạo ra khối tiếp theo. Quá trình này có thể dẫn đến nhiều bất đồng và tranh chấp, đây là một trong những yếu tố góp phần vào sự kém hiệu quả của các mạng chuỗi công khai như Ethereum .

TFT có thể đóng vai trò như một cơ chế đồng thuận, cải thiện hiệu quả bằng cách tăng thời gian tạo khối và thưởng cho các trình xác thực dựa trên uy tín sản xuất khối. Ví dụ, BasedAI, áp dụng mô hình TFT vào quy trình đồng thuận của mình, sử dụng mô hình này để phân phối việc phát hành token cho các trình xác thực và người tham gia mạng lưới.

BasedAI cũng đề xuất sử dụng công nghệ FHE để cho phép các nhà phát triển lưu trữ các mô hình ngôn ngữ lớn bảo vệ quyền riêng tư (Zk-LLM) trên cơ sở hạ tầng AI phi tập trung của mình có tên là "Brains". Bằng cách tích hợp công nghệ FHE vào các mô hình ngôn ngữ lớn, có thể bảo vệ dữ liệu riêng tư của người dùng khi họ chọn kích hoạt các dịch vụ AI cá nhân hóa.

Khi mọi người tin tưởng rằng dữ liệu sẽ được crypto và hoàn toàn riêng tư, và sẵn sàng đóng góp dữ liệu, chúng ta có thể đạt được bước đột phá trong trí tuệ nhân tạo tổng quát (AGI) . Khoảng trống này đang được lấp đầy bởi các công nghệ tập trung vào quyền riêng tư như Tính toán mù mạng Nillion, Học máy không kiến thức (Zero-Knowledge Machine Learning - ZkML) và Mã hóa đồng hình (Homomorphic Crypto- FHE).

Tuy nhiên, tất cả các công nghệ tập trung vào quyền riêng tư này đều đòi hỏi nguồn tài nguyên tính toán lượng lớn, điều đó có nghĩa là chúng vẫn đang trong giai đoạn ứng dụng ban đầu.