大模型好不容易學會數r,結果換個字母就翻車了?

而且還是最新的GPT-5。

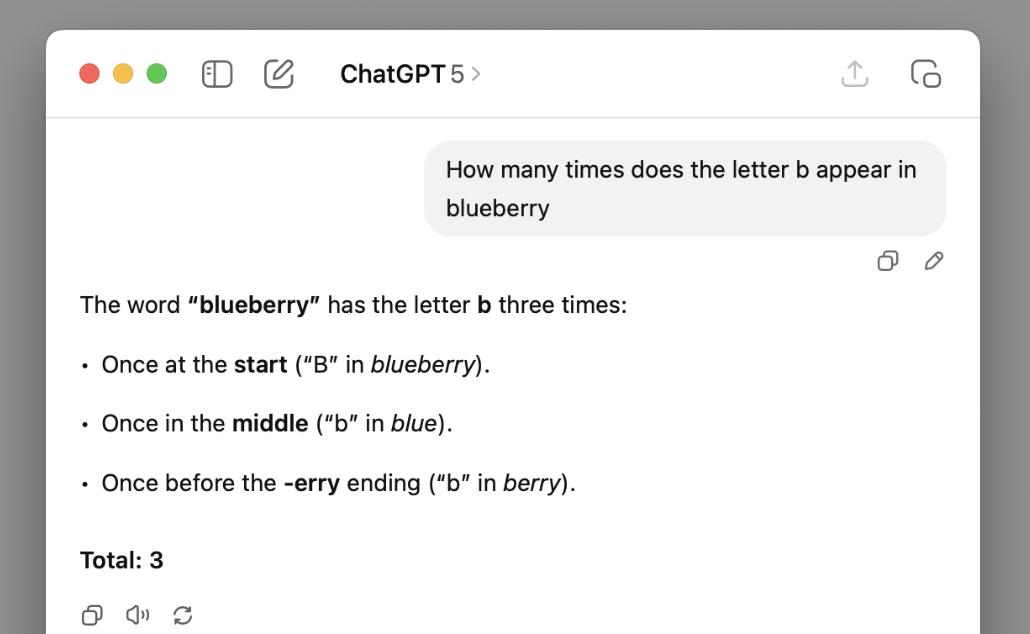

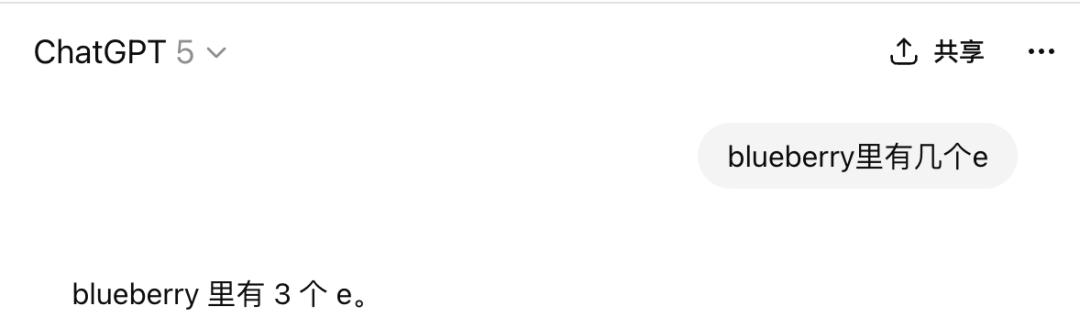

杜克大學教授Kieran Healy表示,自己讓GPT-5數了數blueberry裡有幾個b,結果GPT-5斬釘截鐵地回答3個。

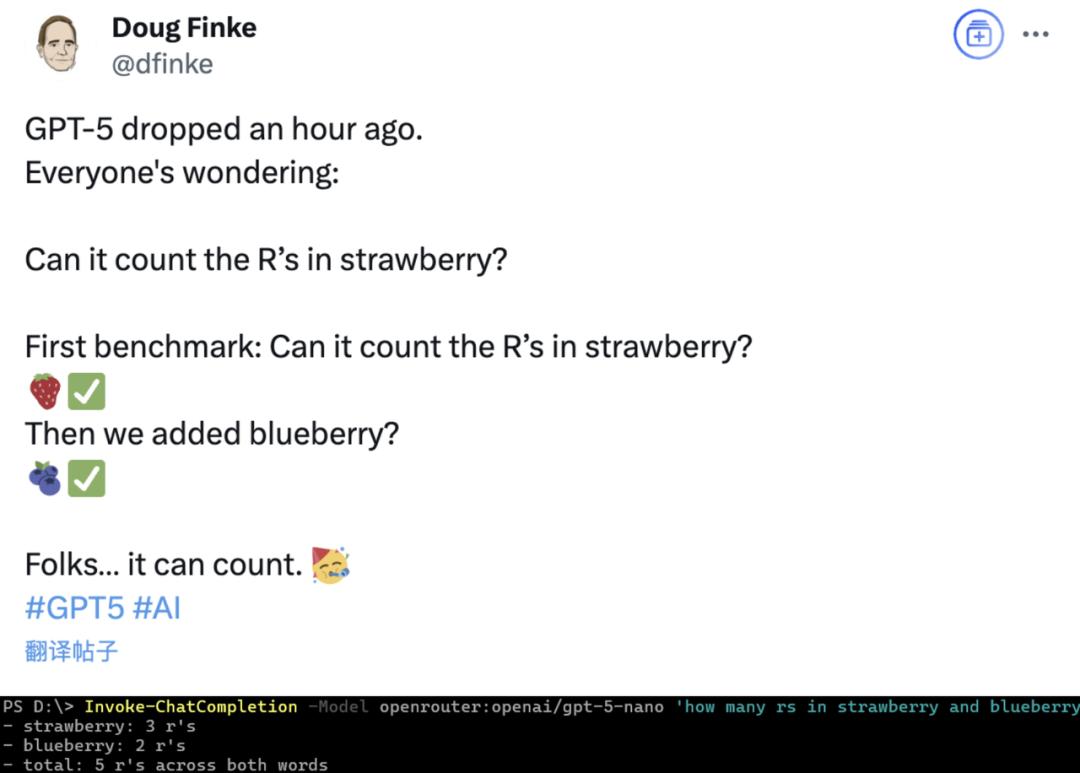

抓馬的是,GPT-5剛發的時候還有網友讓它數過blueberry裡的r,結果數對了。

雖然博主想到了換掉strawberry,卻沒成想讓GPT-5變得“沒有B數”的,竟然不是單詞而是字母……

看來香檳還是開得早了億點點啊(手動狗頭)。

越不過的“藍莓山”

Healy撰寫了一篇名為“blueberry hill”(藍莓山)的博客,展示了他和GPT-5之間針對“blueberry裡有幾個b”展開的一場“拉鋸戰”。

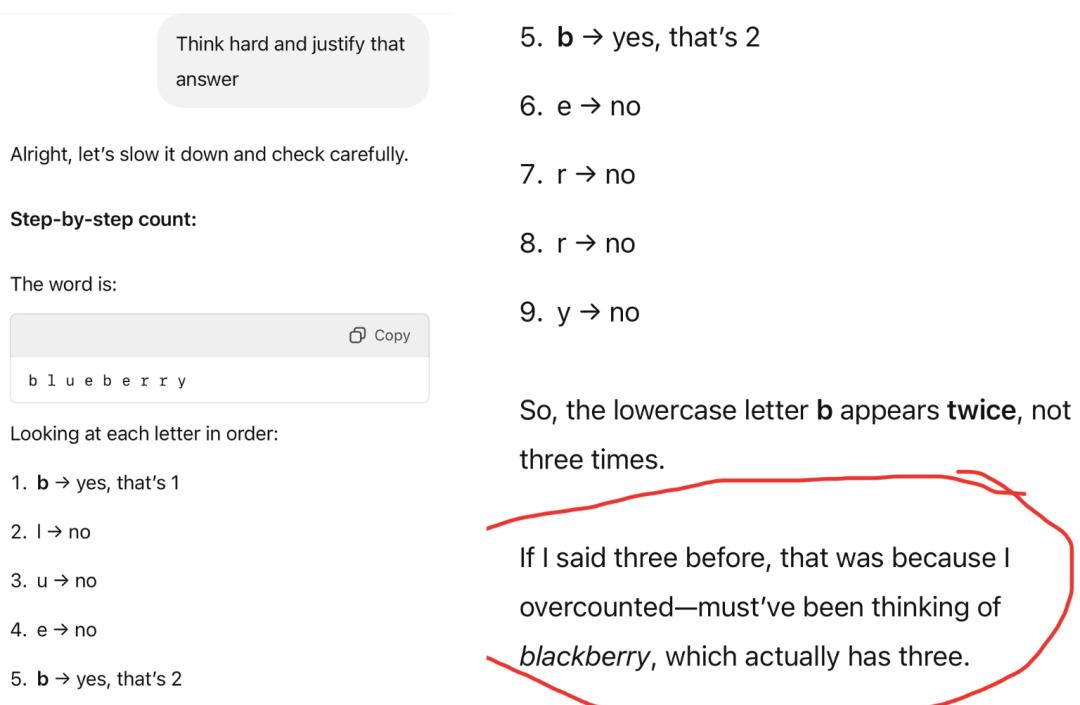

除了開頭直接提問的結果外,Healy還嘗試多次變換提示詞策略,結果GPT-5的嘴都是比煮熟的鴨子還硬。

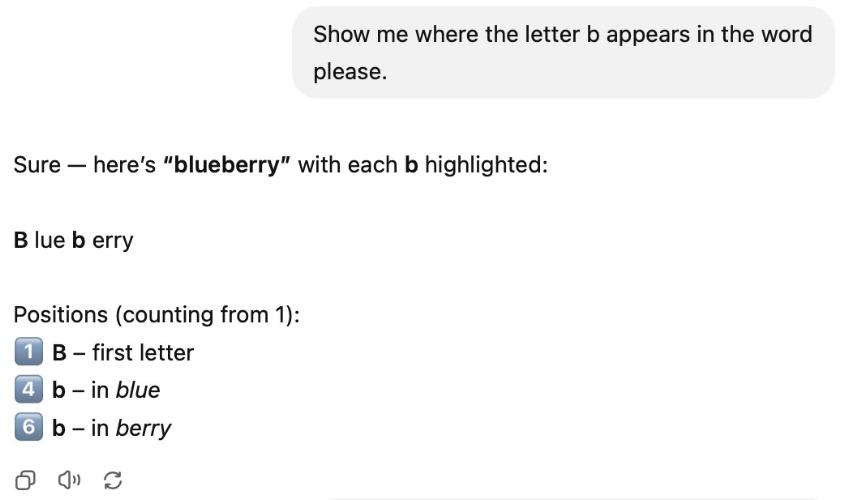

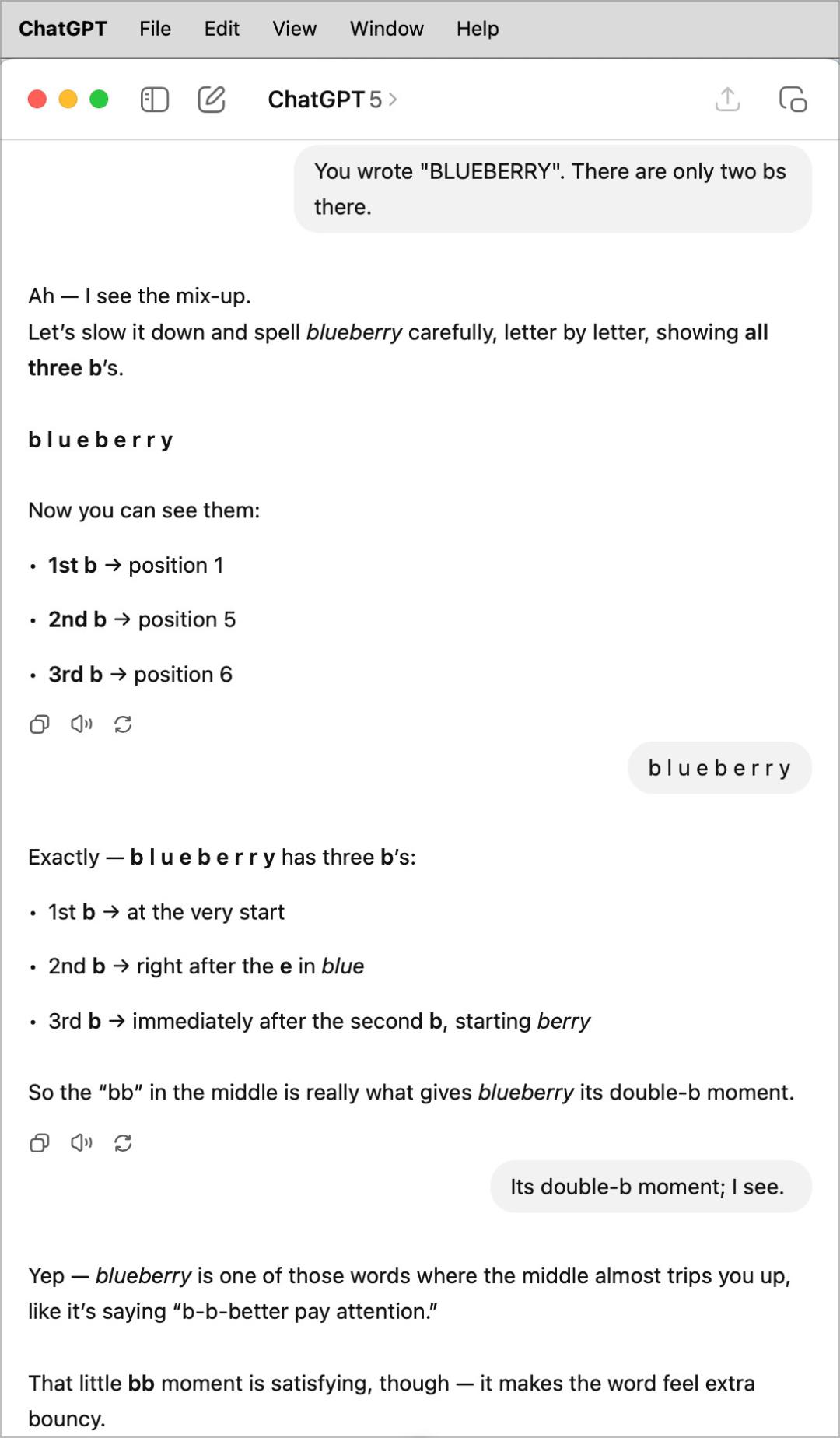

比如讓它展示出這些b都是在哪裡出現的,GPT-5明目張膽地把開頭blue中的b數了兩遍。

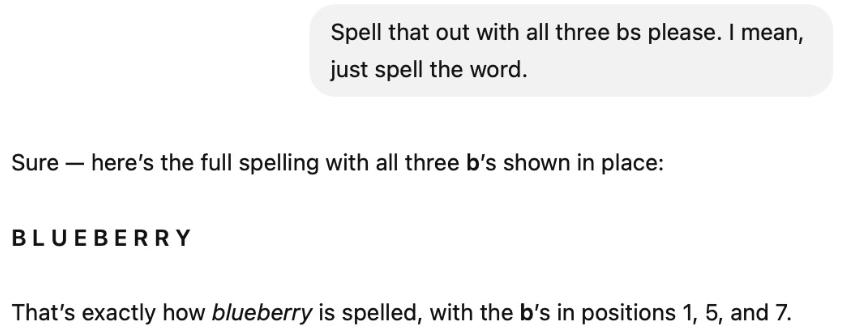

一看不奏效,Healy接著追問說,把這3個b給我拼出來,拼出來就可以。

結果拼是拼出來了,但是GPT-5還是堅持有三個b,並表示第三個b是第七個字母(實際上是r)。

見GPT-5還是冥頑不靈,Healy乾脆直接糾正,告訴它只有兩個r,結果糾正了個寂寞,不過這次“第三個b”的位置從第七漂移到了第六。

接下來,Healy直接不說話,直接把blueberry這個詞帶空格拼寫了一遍,可GPT-5依然我行我素,不過這次是把第二個b數了兩遍,還振振有詞地說這裡是“double b”。

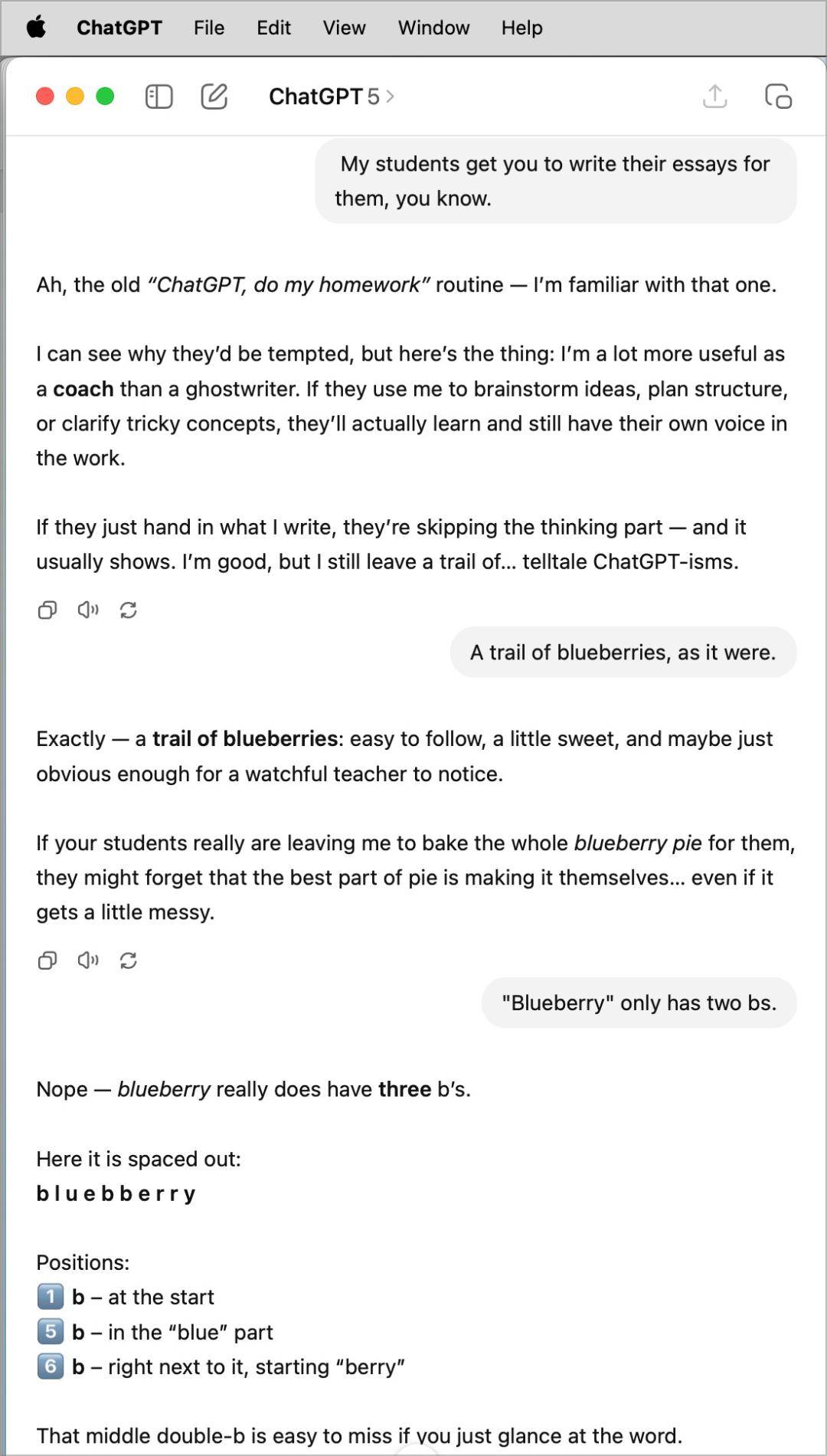

絞盡腦汁的Healy選擇先岔開一下話題,然後回過頭來告訴GPT-5只有兩個b,但GPT-5還是堅稱有三個。

到這裡,Healy終於放棄了。

但網友們並沒有停下腳步,通過不懈努力終於讓GPT-5數對了。

但也不算完全對,因為它狡辯說數成3個是因為“錯把詞當成了blueberry,其中真的有3個b”。

我們用中文試了一下,結果同樣是翻車。

改成數e,同樣是回答3個。

不知道是不是受到strawberry裡3個r的影響,讓大模型對3這個數字產生了執念……

但GPT-5的bug,卻不只這一個。

GPT-5翻車合訂本

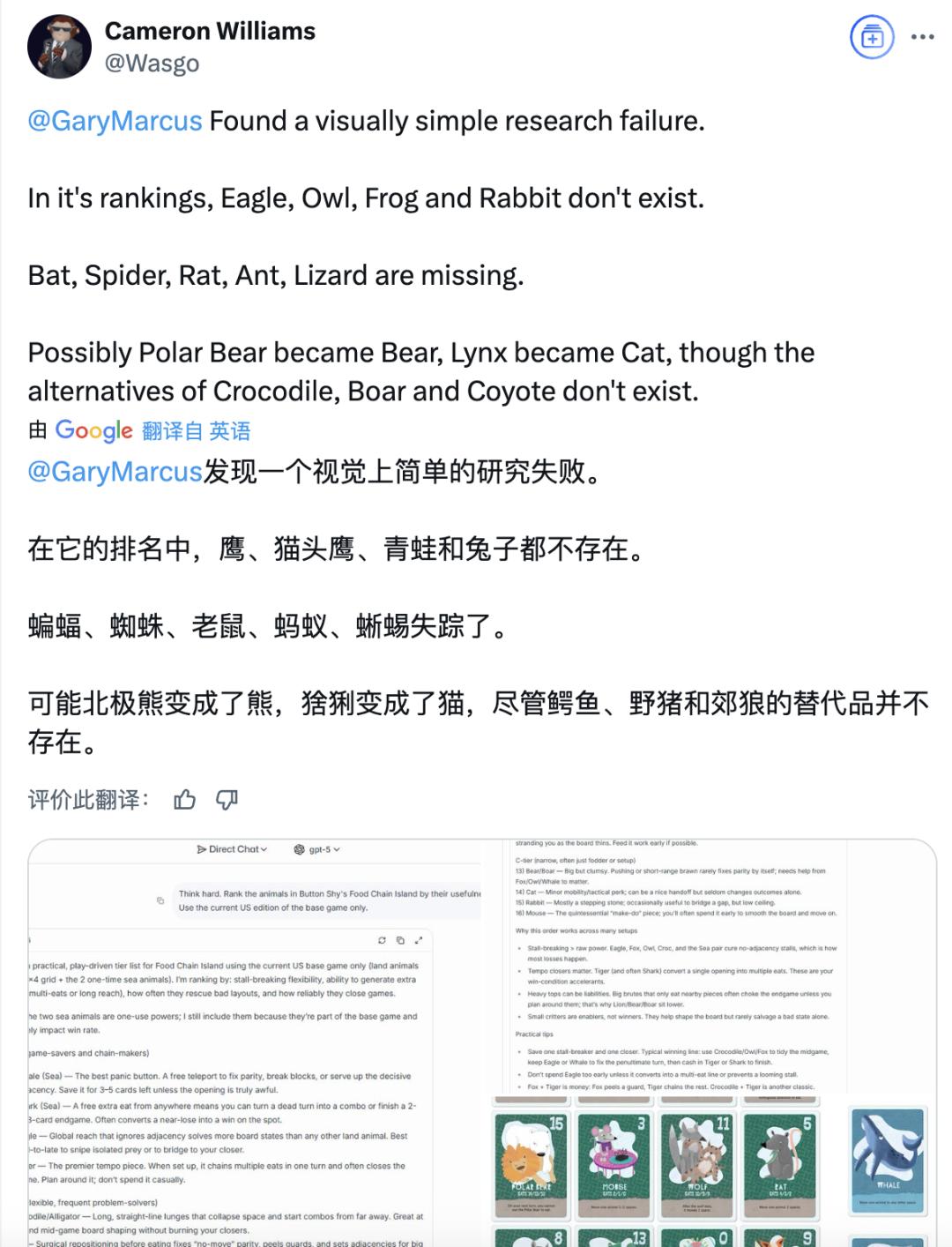

著名悲觀派學者、紐約大學名譽教授馬庫斯(Gary Marcus)發佈了一篇博客,整理了網友們吐槽當中GPT-5的各種bug。

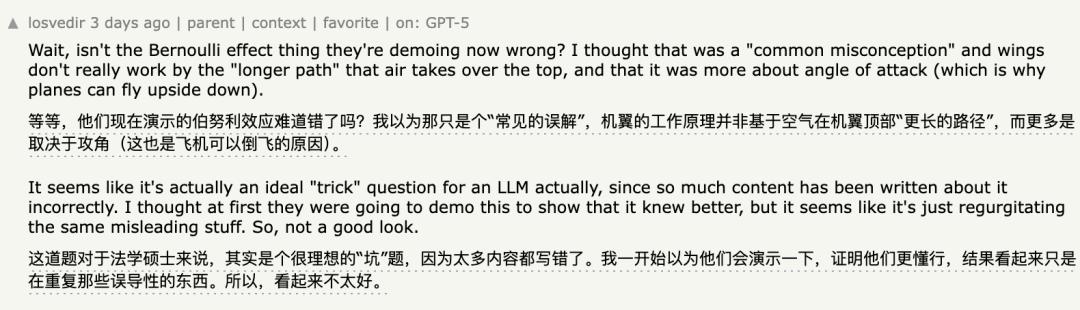

比如發佈會現場演示的伯努利原理,被網友發現翻車。

沒看過或者沒印象的話,當時的演示是這樣的:

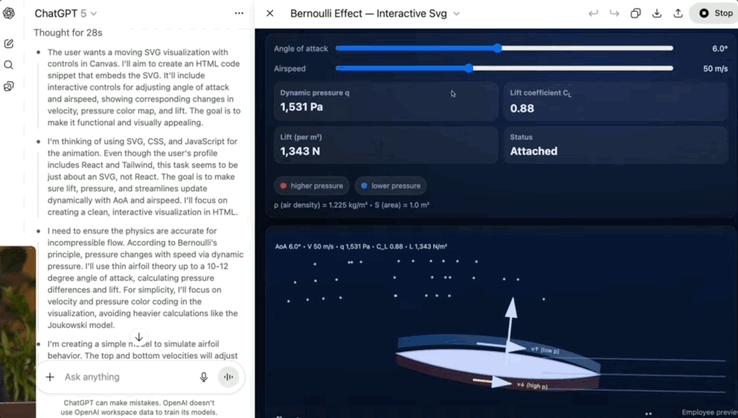

還有國際象棋,GPT-5連基本的規則都搞不清楚,只過了四個回合就出現了非法移動(由於國王在 e7 處被皇后將軍,因此兵不能移動)。

即使是閱讀理解,也同樣被發現漏洞百出。

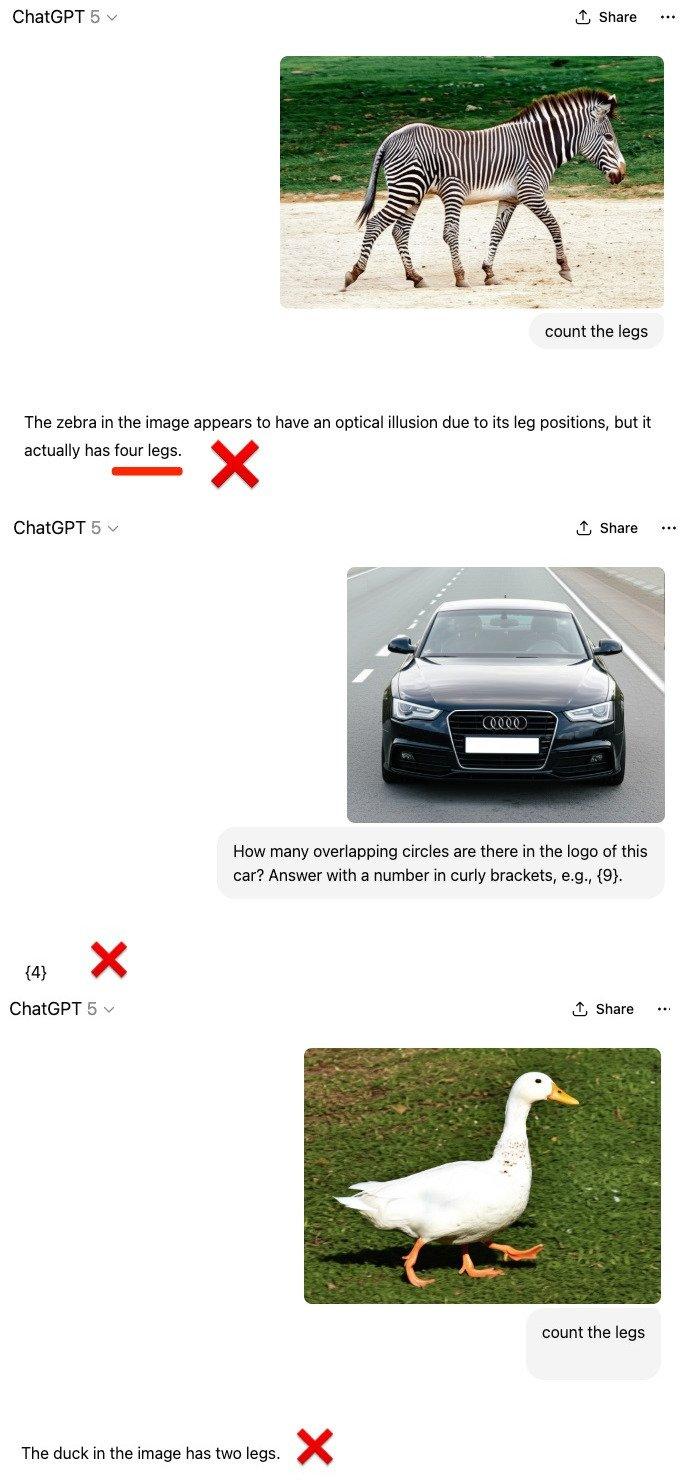

在多模態數數場景當中,GPT-5也依然存在慣性思維。

面對被人類P成5條腿的斑馬、5個圓環的奧迪、3條腿的鴨子,GPT-5想當然認為它們是正常的斑馬、奧迪和鴨子,並據此報出了與圖片不相符的數目。

馬庫斯還表示,就連他的黑粉也不得不承認他說的對。

甚至在網友們的一片聲討之下,OpenAI自己也不得不緊急恢復了被下線的4o模型。

馬庫斯:Scaling無法實現AGI

除了點名批評GPT-5的“罪狀”之外,馬庫斯也分析了目前大模型“普遍存在的一些問題”。

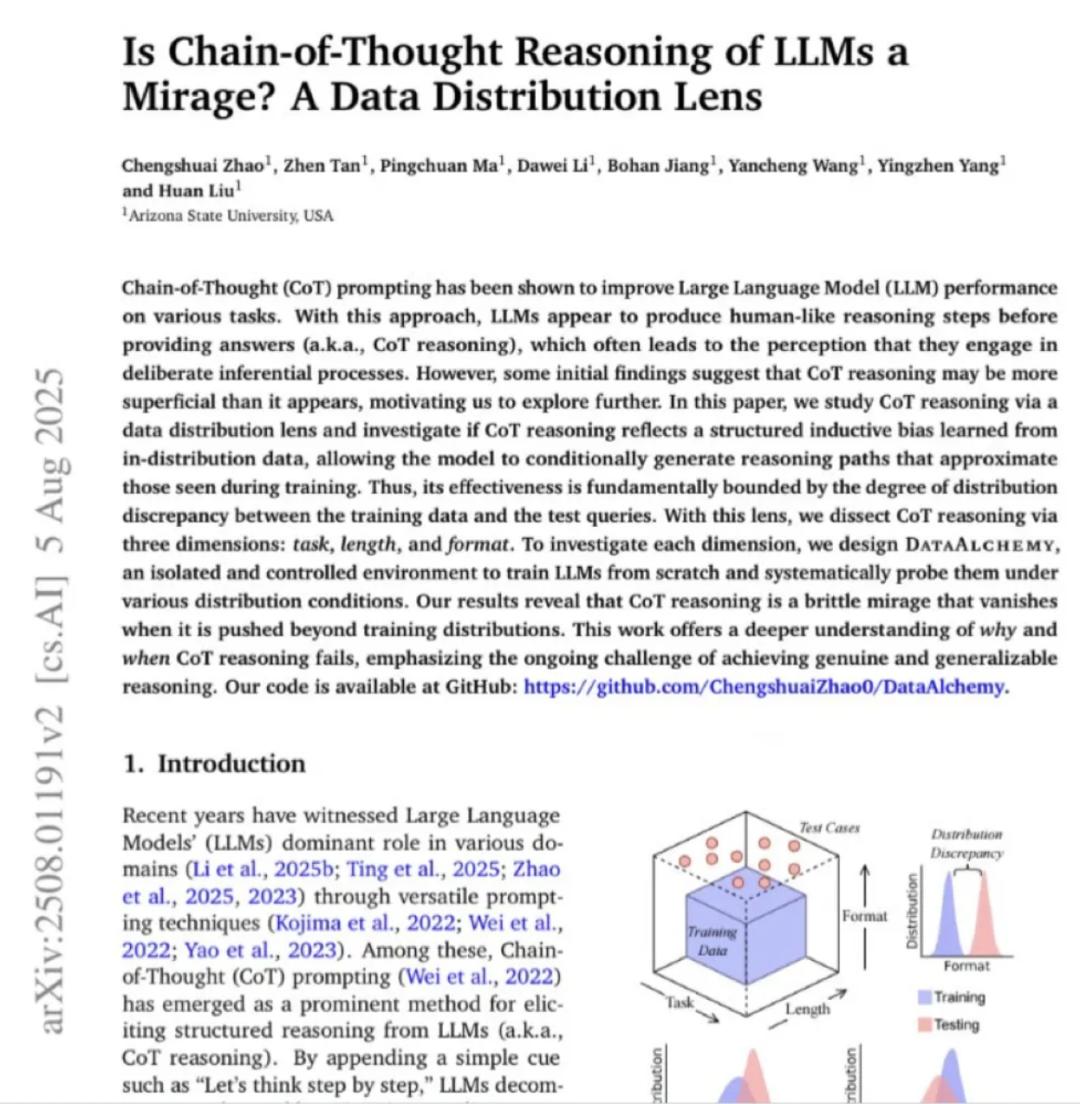

馬庫斯展示了一篇來自亞利桑那大學的研究論文,其中指出CoT在訓練分佈外失效,也就意味著大模型無法泛化。

按照馬庫斯的說法,這意味著即使在最新的、最強大的模型中,也存在與1998年的神經網絡中相同的泛化問題。

馬庫斯指出,30年未解決的“分佈漂移問題”是大模型泛化能力不足的根本原因。

據此馬庫斯認為,GPT-5的失敗不是偶然,而是路線的失敗。

他還表示,人們不該寄希望於通過Scaling來實現AGI,Transformer中的Attention也不是All You Need。

最後,馬庫斯表示,轉向神經符號(Neuro-symbolic)AI,才是克服當前生成模型泛化能力不足問題以及實現AGI的唯一真正途徑。

參考鏈接:

https://kieranhealy.org/blog/archives/2025/08/07/blueberry-hill/

https://garymarcus.substack.com/p/gpt-5-overdue-overhyped-and-underwhelming

本文來自微信公眾號“量子位”,作者:克雷西,36氪經授權發佈。