Cái gì? Giới AI lại có động thái mới rồi à?

Mặc dù lần này không như DeepSeek, Manus gây chấn động như vậy, nhưng có thể ảnh hưởng không nhỏ đến sự phát triển của ngành AI.

Gần đây, một công ty nhỏ ít tiếng tăm là Inception Labs đã gây ra một tin lớn, nói rằng họ đã phát triển mô hình mở rộng quy mô thương mại toàn cầu đầu tiên (dLLM) có tên là Mercury.

Và cái gọi là mô hình mở rộng này có thể sẽ gây ra một làn sóng, hoàn toàn lật đổ đường hướng cơ bản của các mô hình lớn trong hơn 3 năm qua.

Họ cũng thực sự đưa ra dữ liệu, trong số các bài kiểm tra, Mercury Coder cơ bản là đánh bại GPT-4o Mini và Claude 3.5 Haiku, những mô hình mà mọi người đã sử dụng quá nhiều.

Hơn nữa, những mô hình này đã được tối ưu hóa đặc biệt cho tốc độ tạo ra, nhưng Mercury vẫn nhanh hơn tới 10 lần so với chúng.

Không chỉ vậy, Mercury còn có thể đạt tốc độ xử lý trên 1000 Token mỗi giây trên chip NVIDIA H100, trong khi các mô hình lớn phổ biến thường phải sử dụng các chip AI tùy chỉnh để đạt được tốc độ này.

Bạn phải biết rằng, để đạt được tốc độ xử lý Token cao hơn, các chip AI tùy chỉnh gần như đã trở thành một lĩnh vực cạnh tranh mới của các nhà sản xuất.

Ngoài tốc độ siêu siêu siêu nhanh, chúng ta cũng có thể thấy từ hệ tọa độ kiểm tra của Artificial Analysis rằng chất lượng tạo ra của Mercury cũng rất tuyệt vời.

Mặc dù hiện tại vẫn chưa bằng những mô hình hàng đầu như Claude3.5 Haiku, nhưng xét về hiệu suất đọc nhanh, duy trì được chất lượng tạo ra như vậy đã là rất tuyệt vời rồi.

Chúng tôi cũng đã thử vài ví dụ đơn giản trong Playground của Mercury Coder được công bố chính thức, và thấy rằng hiệu quả tạo ra thực sự rất tốt, và tốc độ thực sự cực nhanh.

Lời nhắc: Viết một trò chơi rắn săn mồi bằng HTML5 (Implement the game Snake in HTML5.Include a reset button.Make sure the snake doesn't move too fast .)

Lời nhắc: Viết một trò chơi dò mìn bằng HTML5, CSS và Javascript (Write minesweeper in HTML5 , CSS , and Javascript.Include a timer and a banner that declares the end of the game .)

Lời nhắc: Tạo một trò chơi Pong bằng HTML5 (Create a pong game in HTML5.)

Có lẽ nhiều bạn xem thấy điều này sẽ nghĩ rằng, cũng không có gì quá đặc biệt, tại sao lại nói rằng ngành AI có thể sẽ có sự thay đổi lớn?

Điểm đáng sợ của Mercury không phải là hiệu quả thực tế của nó có bao tuyệt vời, mà quan trọng hơn là nó mang lại một loạt những khả năng mới cho ngành AI: Ai nói rằng các mô hình ngôn ngữ lớn nhất định phải đi theo con đường Transformer?

Trong kỷ nguyên AI này, mọi người chắc đã nghe đến Transformer và Diffusion đến mức tai nhức cả rồi, lúc thì Transformer tự lập, lúc thì Diffusion tự bay, hoặc là hai người hợp tác với nhau.

Nhưng nói cùng, hai cái này thực ra đại diện cho hai hướng tiến hóa khác nhau của AI, thậm chí có thể nói, cơ chế "tư duy" của Transformer và Diffusion khác nhau.

Transformer là suy nghĩ "điển hình" của con người, nó có một thuộc tính tự hồi quy, nghĩa là nó có khái niệm trước sau, bạn phải tạo ra kết quả ở phía trước trước, sau đó mới nghĩ ra cái ở phía sau.

Vì vậy, những gì chúng ta thấy hiện nay trong việc tạo ra AI, đều là từng từ từng câu, từ trên xuống dưới, dần dần phát triển.

Còn Diffusion, thì lại trái ngược với logic thông thường, trực tiếp từ mờ ảo đến rõ ràng.

Nghĩa là bạn hỏi nó câu hỏi, nó sẽ không có một logic được sắp xếp theo 1, 2, 3, 4... mà là nó đã nghĩ ra tất cả các dạng trả lời trong đầu, nhưng những câu trả lời này đều mờ ảo, sau đó từng bước làm cho tất cả các câu trả lời trở nên rõ ràng, cho đến khi tạo ra kết quả.

Lấy một ví dụ rất phổ biến trong cuộc sống là khi bạn đeo kính, khi bạn tháo kính ra nhìn thì tất cả đều mờ ảo, nhưng bạn vẫn nhìn thấy tất cả, và khi từng tấm kính được đặt lên, cuối cùng bạn nhìn thấy rõ mọi thứ.

Vì vậy, kết quả tạo ra của Mercury đều là một đống mã lộn xộn mờ ảo, sau đó nó "biu biu biu" nhanh chóng và hoàn thành hết.

Giống như vậy

Về sự so sánh hiệu quả của hai cái này, tôi cảm thấy rằng trước đây đã từng có một bài phát biểu nổi tiếng, có người đã sử dụng một cách so sánh trực quan hơn, có thể giúp mọi người hiểu rõ hơn.

CPU giống như Transformer hiện nay

GPU giống như Diffusion hiện nay

Thực ra, chỉ từ cách mô tả đơn giản như vậy, mọi người cũng có thể hiểu rằng Transformer thực sự phù hợp hơn với cách suy nghĩ logic của con người, vì vậy khi các mô hình ngôn ngữ lớn vừa bùng nổ, cơ bản là Transformer một mình chinh phục thế giới.

Nhưng dần dần, Transformer bắt đầu lộ ra những hạn chế của mình.

Trong đó, vấn đề khiến mọi người đau đầu nhất chính là, phía sau cơ chế chú ý rất tuyệt vời của Transformer, là sự gia tăng theo cấp số nhân của độ phức tạp tính toán (công thức độ phức tạp tính toán là O(n²d) (n là độ dài chuỗi, d là chiều đặc trưng)).

Sự gia tăng theo cấp số nhân của độ phức tạp tính toán đã gây ra nhiều hạn chế, chẳng hạn như tốc độ suy luận của mô hình giảm đáng kể, trong các lĩnh vực như văn bản dài, video, v.v., tốc độ tạo ra rõ ràng không thể đáp ứng nhu cầu thực tế.

Hơn nữa, khi độ phức tạp liên tục tăng lên, nhu cầu về tài nguyên phần cứng cũng tăng theo cấp số nhân, nhu cầu phần cứng này cản trở việc AI thực sự đi vào cuộc sống của mọi người.

Vì vậy, ngành công nghiệp luôn tìm cách giảm độ phức tạp tính toán của mô hình Transformer.

Như DeepSeek, công ty có thể bùng nổ nhờ việc định lượng, chưng cất, nén mô hình, thực ra cũng dựa trên nhu cầu cấp bách này.

Vì vậy, sự xuất hiện của Mercury dường như cũng nhắc nhở mọi người rằng, nếu giảm độ phức t

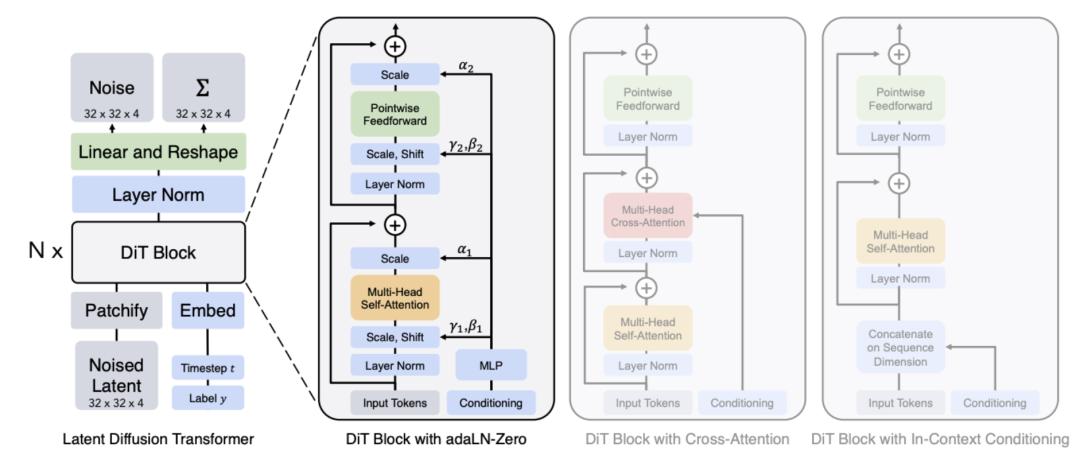

Thậm chí còn xuất hiện mô hình sora của OpenAI, sử dụng mô hình kết hợp Transformer và Diffusion gọi là Diffusion Transformer (DiTs).

Mặc dù lý tưởng rất đẹp, nhưng trước đây Diffusion gần như bị mọi người tuyên án tử hình, vì họ cảm thấy nó không thể kiểm soát được mô hình ngôn ngữ.

Bởi vì đặc điểm của Diffusion là không có tự động hồi quy, không cần phụ thuộc vào ngữ cảnh, do đó có thể tiết kiệm tài nguyên và tăng tốc độ sinh ra.

Tuy nhiên, độ chính xác của việc sinh ra có phần khó kiểm soát, giống như các mô hình hiện nay về sinh văn bản, sinh video, vẫn khó kiểm soát các chi tiết chính xác như bàn tay, ăn mì, văn bản, v.v.

Tuy nhiên, thành tựu đột phá của Mercury lần này, thực sự cũng là lần đầu tiên chứng minh với mọi người rằng, Diffusion cũng có thể làm được những việc mà Transformer làm được.

Tuy nhiên, đáng tiếc là hiện tại Mercury chưa công bố bất kỳ tài liệu kỹ thuật nào, chúng tôi không thể biết thêm về cách họ giải quyết vấn đề chất lượng nội dung sinh ra.

Nhưng từ những đối thủ mà họ chọn, như Claude3.5 Haiku, GPT4-omini, Qwen2.5 coder 7B, DeepSeek V2 lite, v.v., cũng có thể thấy rằng, rõ ràng mô hình ngôn ngữ Diffusion mạnh nhất Mercury cũng chưa thể quá lớn.

Thậm chí qua kiểm tra của chúng tôi, ngoài việc sinh ra kết quả khá chính xác với các lời nhắc đề xuất, nếu sử dụng một số lời nhắc tùy chỉnh, xác suất lỗi của nó lại rất cao.

Lời nhắc: Sử dụng HTML để viết một hoạt ảnh mô phỏng hệ Mặt Trời (Use HTML to write an animation of the solar system simulation operation)

Tuy nhiên, không thể phủ nhận rằng, thành tựu của Mercury là đáng kể, đặc biệt khi xem xét vị thế mạnh của Diffusion trong việc sinh ra đa phương thức, cũng khiến người ta không khỏi tưởng tượng, nếu như con đường của Diffusion mới là hướng đi đúng đắn hơn của các mô hình ngôn ngữ lớn của AI (có vẻ như cũng không phải là không thể), thì sự tiến hóa liên kết trong tương lai có vẻ sẽ thuận lợi hơn.

Gần đây, tôi vừa xem một bộ phim có tên "Arrival", trong đó người ngoài hành tinh không tuân theo logic chuỗi 1, 2, 3, 4... của con người, rõ ràng các cách tư duy khác nhau sẽ mang lại nhiều khả năng hơn.

Vậy thì câu hỏi đặt ra là, ai nói AI phải suy nghĩ giống như con người? Đối với họ, liệu cách tư duy của Diffusion có phù hợp hơn với thuộc tính "sinh vật silic" không?

Tất nhiên, những điều này chỉ là những suy đoán lung tung của tôi, nhưng điều thú vị là, Mercury vừa là Thủy Tinh trong hệ Mặt Trời, vừa là thần truyền tin trong thần thoại La Mã, đặc điểm của họ là chạy rất nhanh, và trong chiêm tinh học, nó cũng biểu trưng cho cách tư duy và khả năng giao tiếp của con người.

Chúng ta cũng có thể mong đợi rằng, sự xuất hiện của Mercury sẽ mang lại một hướng đi mới cho AI.

Nguồn hình ảnh và thông tin:

X.com

Trang web chính thức của Mercury

OpenAI: Generating videos on Sora

techcrunch: Inception emerges from stealth with a new type of AI model

AimResearch: What Is a Diffusion LLM and Why Does It Matter?

Zhihu: Làm thế nào để đánh giá mô hình ngôn ngữ lớn Diffusion Mercury coder của Inception Lab?

Bài viết này được trích từ tài khoản WeChat công cộng "Chê bai", tác giả: Bát Giác, biên tập: Giang Giang & Diện Tiên, được 36Kr ủy quyền đăng tải.