Năm 1849, sau khi tin tức lan truyền rằng vàng đã được phát hiện ở California, Hoa Kỳ, cơn sốt vàng bắt đầu. Vô số người đổ xô đến vùng đất mới này, một số từ Bờ biển phía Đông, một số từ lục địa Châu Âu và những người Hoa di cư thế hệ đầu tiên đến Hoa Kỳ, đầu tiên họ gọi nơi này là "Núi Vàng", sau đó gọi là "San Francisco". “.

Nhưng dù thế nào đi chăng nữa, những người đào vàng đến vùng đất mới này cần có thức ăn, quần áo, nơi ở và phương tiện đi lại, tất nhiên, điều quan trọng nhất là thiết bị khai thác vàng - xẻng. Tục ngữ có câu: "Muốn làm tốt công việc, trước tiên phải mài giũa công cụ." Để đãi vàng hiệu quả hơn, mọi người bắt đầu đổ xô đến những người bán xẻng một cách điên cuồng, mang theo của cải.

Hơn một trăm năm sau, cách San Francisco không xa về phía nam, hai công ty ở Thung lũng Silicon đã bắt đầu một cơn sốt đào vàng mới: OpenAI là công ty đầu tiên khám phá ra “mỏ vàng” của kỷ nguyên AI, và Nvidia là công ty đầu tiên loạt "người bán xẻng." Như trong quá khứ, vô số người và công ty bắt đầu đổ về vùng đất nóng mới này, nhặt "xẻng" của thời đại mới và bắt đầu đào vàng.

Điểm khác biệt là ngày xưa hầu như không có rào cản kỹ thuật nào với cái xẻng, nhưng ngày nay GPU của Nvidia là sự lựa chọn của mọi người. Kể từ đầu năm nay, chỉ riêng ByteDance đã đặt hàng hơn 1 tỷ đô la GPU từ Nvidia, bao gồm 100.000 thẻ tăng tốc A100 và H800. Baidu, Google, Tesla , Amazon, Microsoft... Những công ty lớn này đã đặt hàng ít nhất hàng chục nghìn GPU từ Nvidia trong năm nay.

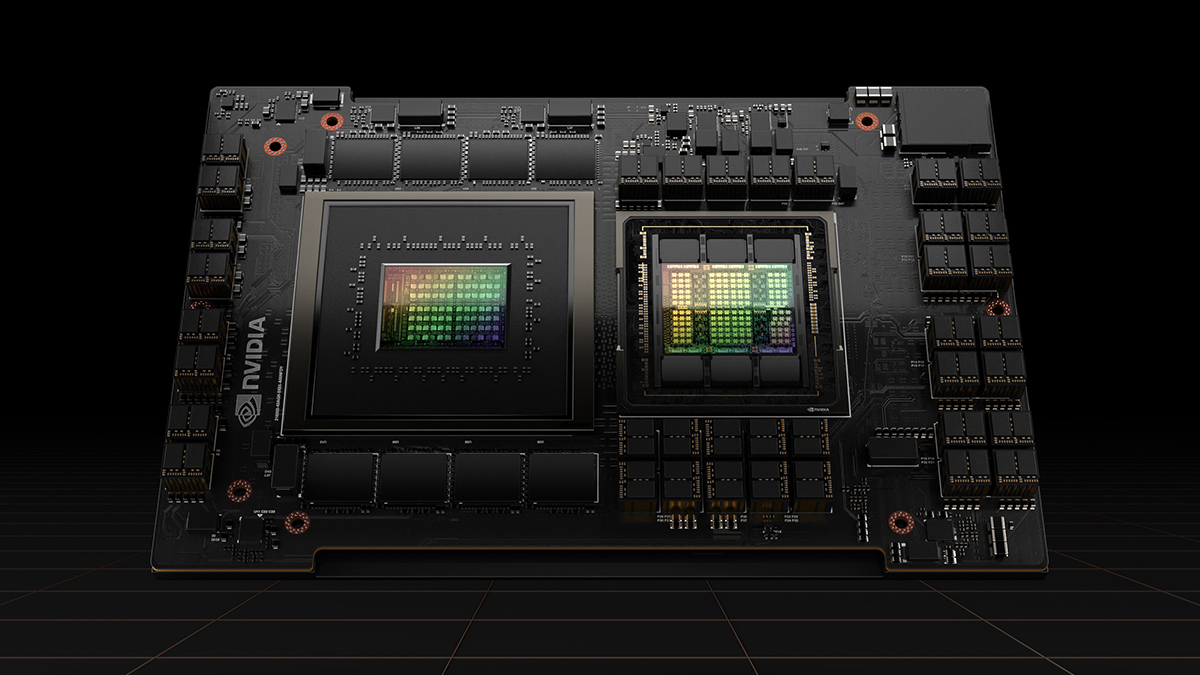

GPU H100, hình ảnh/Nvidia

Nhưng điều này vẫn chưa đủ. Giám đốc điều hành Megvii Yin Qi cho biết trong một cuộc phỏng vấn với Caixin vào cuối tháng 3 rằng chỉ có khoảng 40.000 chiếc A100 ở Trung Quốc có thể được sử dụng cho đào tạo người mẫu quy mô lớn. Khi sự bùng nổ AI tiếp tục, phiên bản thiến của GPU cao cấp thế hệ trước A100 - A800 của Nvidia từng tăng lên 100.000 nhân dân tệ tại Trung Quốc.

Tại một cuộc họp riêng vào tháng 6, CEO OpenAI Sam Altman một lần nữa cho biết tình trạng thiếu GPU trầm trọng đã khiến nhiều nỗ lực tối ưu hóa ChatGPT bị đình trệ. Theo tính toán của TrendForce, một cơ quan tư vấn kỹ thuật, OpenAI cần khoảng 30.000 A100 để hỗ trợ quá trình tối ưu hóa và thương mại hóa liên tục ChatGPT.

Ngay từ đợt bùng phát ChatGPT mới vào tháng 1 năm nay, tình trạng thiếu Tỷ lệ băm AI đã kéo dài gần nửa năm, tại sao các công ty lớn này vẫn thiếu GPU và Tỷ lệ băm?

ChatGPT thiếu card đồ họa? Nvidia mất tích

Để mượn một khẩu hiệu: không phải tất cả GPU đều là Nvidia. Tình trạng thiếu GPU thực chất là sự thiếu hụt GPU cao cấp của Nvidia. Đối với đào tạo mô hình AI lớn, bạn có thể chọn GPU Nvidia A100, H100 hoặc phiên bản rút gọn A800, H800 được Nvidia đặc biệt ra mắt sau lệnh cấm vào năm ngoái.

Việc sử dụng AI bao gồm hai liên kết, đào tạo và suy luận, cái trước có thể được hiểu là tạo ra các mô hình và cái sau có thể được hiểu là sử dụng các mô hình. Quá trình đào tạo trước và tinh chỉnh mô hình AI lớn, đặc biệt là quá trình đào tạo trước, tiêu tốn rất nhiều Tỷ lệ băm, đặc biệt là hiệu suất do một GPU cung cấp và khả năng truyền dữ liệu giữa nhiều thẻ. Nhưng ngày nay, chip AI có thể cung cấp hiệu quả tính toán trước đào tạo mô hình quy mô lớn (chip AI tổng quát chỉ đề cập đến chip dành cho AI):

Không thể nói không nhiều, chỉ có thể nói rất ít.

Một tính năng quan trọng của một mô hình lớn là ít nhất 100 tỷ tham số cấp độ, đòi hỏi một lượng lớn Tỷ lệ băm để đào tạo, việc truyền và đồng bộ hóa dữ liệu giữa nhiều GPU sẽ khiến một số Tỷ lệ băm của GPU không hoạt động, do đó hiệu suất của nó càng cao. một GPU , con số càng thấp thì GPU được sử dụng càng hiệu quả và chi phí tương ứng càng thấp.

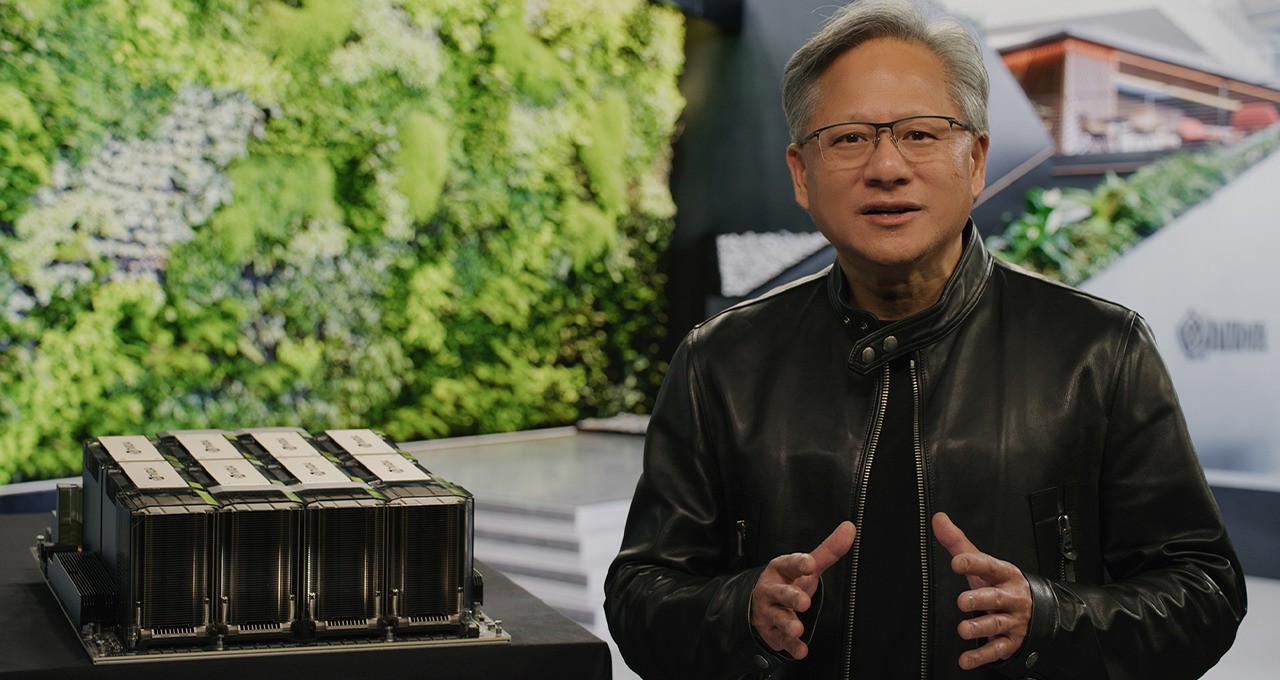

Siêu máy tính NVIDIA DGX H100 AI, ảnh/Nvidia

A100 và H100 được Nvidia phát hành từ năm 2020, một mặt có Tỷ lệ băm cao của một thẻ đơn, mặt khác, chúng có lợi thế về băng thông cao. Tỷ lệ băm FP32 của A100 đạt 19,5 TFLOPS (nghìn tỷ phép tính dấu phẩy động mỗi giây) và H100 cao tới 134 TFLOPS.

Đồng thời, việc đầu tư vào các công nghệ giao thức truyền thông như NVLink và NVSwitch cũng đã giúp Nvidia xây dựng một hệ thống bảo vệ sâu hơn . Lên đến H100, NVLink thế hệ thứ tư có thể hỗ trợ tới 18 liên kết NVLink, với tổng băng thông là 900GB/giây, gấp 7 lần băng thông của PCIe 5.0.

A800 và H800 được tùy chỉnh cho thị trường Trung Quốc có Tỷ lệ băm gần như giống nhau , chủ yếu là để tránh các tiêu chuẩn quy định và băng thông đã bị cắt giảm tương ứng khoảng một phần tư rưỡi. Theo Bloomberg, H800 mất nhiều thời gian hơn 10%-30% so với H100 cho cùng một tác vụ AI.

Nhưng dù vậy, hiệu quả tính toán của A800 và H800 vẫn vượt xa các chip GPU và AI khác. Đây là lý do tại sao sẽ có trí tưởng tượng "trăm hoa đua nở" trên thị trường lý luận AI, bao gồm cả chip AI tự phát triển của các công ty điện toán đám mây lớn và các công ty GPU khác có thể chiếm một phần nhất định, nhưng trong đào tạo AI thị trường đòi hỏi hiệu năng cao hơn thì chỉ có “Một nhà thống trị” Nvidia.

Băng thông "dao" H800, ảnh / Nvidia

Tất nhiên, đằng sau sự "thống trị của một gia đình", hệ sinh thái phần mềm cũng là hệ thống bảo vệ công nghệ cốt lõi của Nvidia. Có rất nhiều bài viết về vấn đề này, nhưng tóm lại, điều quan trọng nhất là nền tảng điện toán hợp nhất CUDA mà Nvidia đã ra mắt và khẳng định vào năm 2007 đã trở thành cơ sở hạ tầng của thế giới AI ngày nay. được phát triển dựa trên CUDA, giống như Android và iOS dành cho các nhà phát triển ứng dụng di động.

Tuy nhiên, xét về mặt logic, Nvidia cũng hiểu rằng GPU cao cấp của họ rất được ưa chuộng, sau Tết Nguyên đán, đã có nhiều thông tin cho rằng Nvidia đang bổ sung các đơn hàng đúc wafer để đáp ứng nhu cầu tăng mạnh của thị trường toàn cầu trong vài tháng trở lại đây , nó sẽ có thể tăng đáng kể xưởng đúc Năng lực sản xuất, xét cho cùng, không phải là quy trình 3nm tiên tiến nhất của TSMC .

Tuy nhiên, vấn đề nằm chính xác ở liên kết xưởng đúc.

GPU cao cấp của Nvidia không thể tách rời TSMC

Như chúng ta đã biết, lượng điện tử tiêu dùng giảm và việc tiếp tục tiêu hủy hàng tồn kho đã dẫn đến sự sụt giảm chung về tỷ lệ sử dụng công suất của các xưởng đúc wafer lớn, nhưng quy trình sản xuất tiên tiến của TSMC là một ngoại lệ.

Do sự bùng nổ AI được kích hoạt bởi ChatGPT, A100 và H100 4nm dựa trên quy trình 7nm của TSMC đang khẩn trương bổ sung các đơn đặt hàng và dây chuyền sản xuất 5/4nm của TSMC đã gần hoạt động hết công suất. Những người trong Chuỗi cung ứng cũng dự đoán rằng số lượng lớn đơn đặt hàng SHR (mức xử lý khẩn cấp nhất) của Nvidia cho TSMC sẽ kéo dài trong một năm.

Nói cách khác, năng lực sản xuất của TSMC không đủ để đáp ứng nhu cầu mạnh mẽ trong ngắn hạn của Nvidia. Không có gì ngạc nhiên khi một số nhà phân tích tin rằng do GPU A100 và H100 luôn trong tình trạng thiếu nguồn cung nên bất kể từ góc độ kiểm soát rủi ro hay giảm chi phí, cần phải tìm Samsung hoặc thậm chí Intel cho xưởng đúc bên ngoài TSMC.

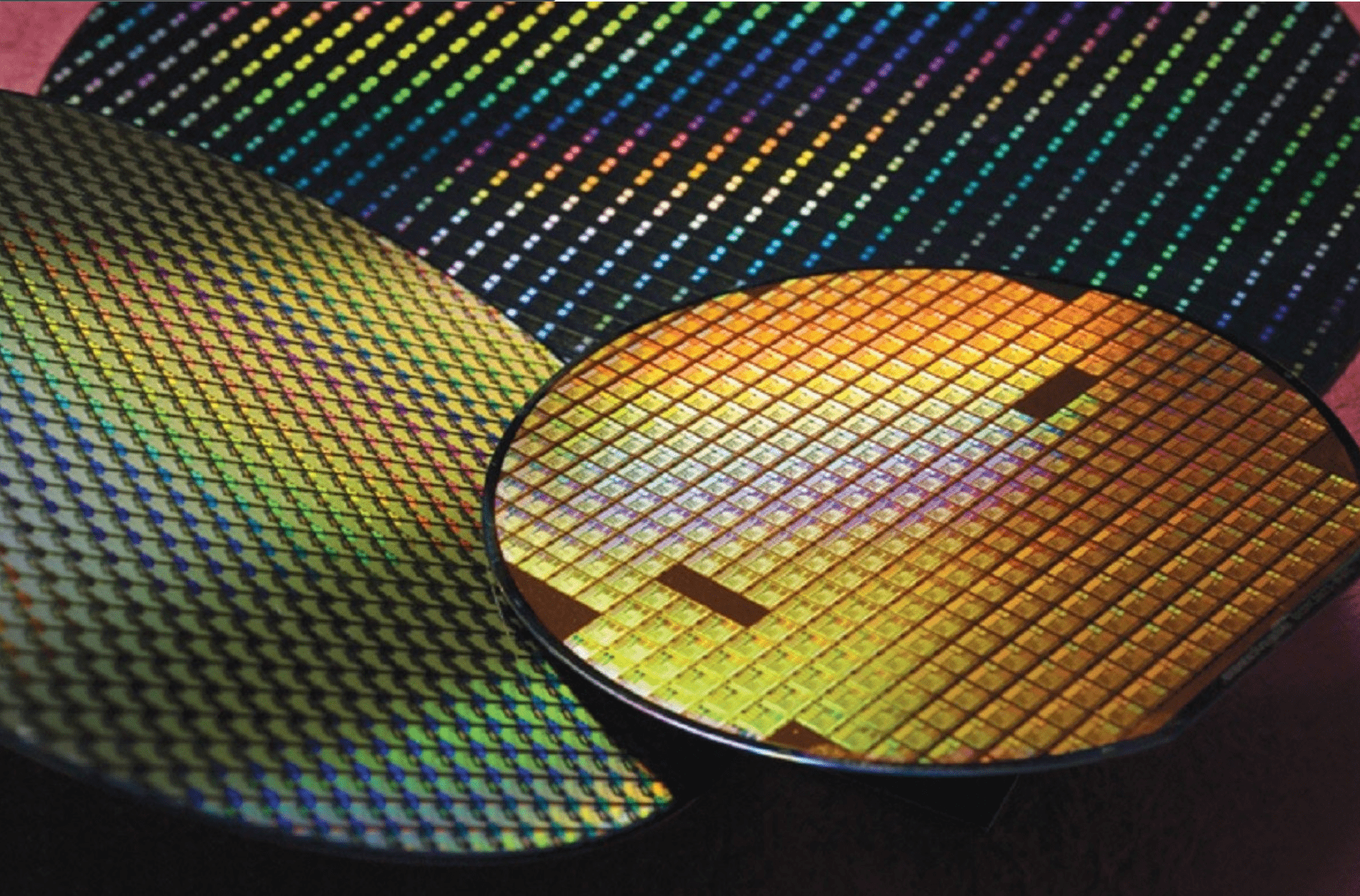

Sản xuất chip trên tấm silicon bán dẫn, ảnh/TSMC

Nhưng hóa ra Nvidia không hề có ý định đó, ít nhất là trong ngắn hạn, và không đời nào rời bỏ TSMC. Ngay trước khi Sam Altman phàn nàn rằng GPU của Nvidia là không đủ, nhà sáng lập kiêm CEO của Nvidia, Huang Renxun đã nói tại COMPUTEX rằng các chip thế hệ tiếp theo của Nvidia vẫn sẽ được chuyển giao cho TSMC.

Lý do kỹ thuật cốt lõi là, từ V100, A100 đến H100, các thẻ tăng tốc cao cấp của Nvidia đều sử dụng công nghệ đóng gói tiên tiến CoWoS của TSMC để giải quyết vấn đề tích hợp lưu trữ và điện toán chip trong bối cảnh Tỷ lệ băm AI cao. Và công nghệ lõi đóng gói tiên tiến của CoWoS: không có TSMC.

Vào năm 2012, TSMC đã ra mắt công nghệ đóng gói tiên tiến CoWoS độc quyền, giúp hiện thực hóa dịch vụ một cửa từ xưởng đúc wafer đến đóng gói thiết bị đầu cuối. Các khách hàng bao gồm Nvidia, Apple và nhiều nhà sản xuất chip khác đã áp dụng công nghệ này trong tất cả các sản phẩm cao cấp. Để đáp ứng nhu cầu cấp thiết của Nvidia, TSMC thậm chí đã áp dụng phương thức thầu phụ một phần, nhưng nó không bao gồm quy trình CoWoS và TSMC vẫn tập trung vào phần đóng gói tiên tiến có giá trị nhất.

Theo ước tính của Nomura Securities, năng lực sản xuất CoWoS hàng năm của TSMC sẽ vào khoảng 70.000 đến 80.000 tấm wafer vào cuối năm 2022 và dự kiến sẽ tăng lên 140.000 đến 150.000 tấm wafer vào cuối năm 2023. Đến cuối năm 2024, nó dự kiến sẽ thách thức năng lực sản xuất 200.000 tấm wafer.

Tuy nhiên, xa không thể chữa cháy gần. Năng lực sản xuất bao bì CoWoS tiên tiến của TSMC đang thiếu hụt trầm trọng. Kể từ năm ngoái, các đơn đặt hàng CoWoS của TSMC đã tăng gấp đôi. Năm nay, nhu cầu từ Google và AMD cũng rất lớn. Ngay cả Nvidia cũng sẽ phấn đấu hơn nữa để đạt được những ưu tiên cao hơn thông qua mối quan hệ cá nhân giữa Huang Renxun và người sáng lập TSMC Zhang Zhongmou.

TSMC, Hình /

viết ở cuối

Do dịch bệnh và những thay đổi địa chính trị trong vài năm qua, mọi người đều nhận ra rằng một công nghệ tiên tiến được xây dựng trên cát vụn là rất quan trọng. Sau ChatGPT, AI lại thu hút sự chú ý trên toàn thế giới và với mong muốn về trí tuệ nhân tạo và Tỷ lệ băm tăng tốc, vô số đơn đặt hàng chip cũng đổ về.

Việc thiết kế và sản xuất GPU cao cấp đòi hỏi đầu tư và tích lũy R&D trong thời gian dài, đồng thời phải đối mặt với những rào cản phần cứng và phần mềm không thể vượt qua, điều này cũng dẫn đến việc trong "bữa tiệc Tỷ lệ băm" này, Nvidia và TSMC có thể nhận được hầu hết trong số họ Chiếc bánh và quyền được nói.

Cho dù đó là mối quan tâm ngày nay về AI tổng quát hay làn sóng học tập sâu cuối cùng tập trung vào nhận dạng hình ảnh, thì tốc độ mà các công ty Trung Quốc đang bắt kịp về khả năng của phần mềm AI là điều hiển nhiên đối với tất cả mọi người. Tuy nhiên, khi các công ty Trung Quốc chi những khoản tiền khổng lồ và quay lưng lại với AI, họ hiếm khi tập trung vào phần cứng cấp thấp hơn.

Nhưng đằng sau sự tăng tốc của AI, hai trong số bốn GPU quan trọng nhất đã bị hạn chế ở Trung Quốc và hai GPU còn lại là A800 và H800 không chỉ làm chậm tốc độ bắt kịp của các công ty Trung Quốc mà còn không thể loại trừ rủi ro bị hạn chế. . So với các cuộc cạnh tranh về mô hình lớn, có lẽ, chúng ta cần nhìn nhận sự cạnh tranh của các công ty Trung Quốc ở mức độ thấp hơn.

Bài báo này đến từ " Ray Technology ", 36 Krypton được phép xuất bản.