이 기사는 기계로 번역되었습니다

원문 표시

AI 시대의 핵심 자산은 기억력과 추상적 사고력입니다. 오랜 실험 끝에 마침내 "로컬 메모리 + 클라우드 LLM" 아키텍처를 구현하는 데 성공했습니다. 핵심 아이디어는 다음과 같습니다.

메모리는 핵심 자산이므로 클라우드에 전적으로 맡길 수 없습니다.

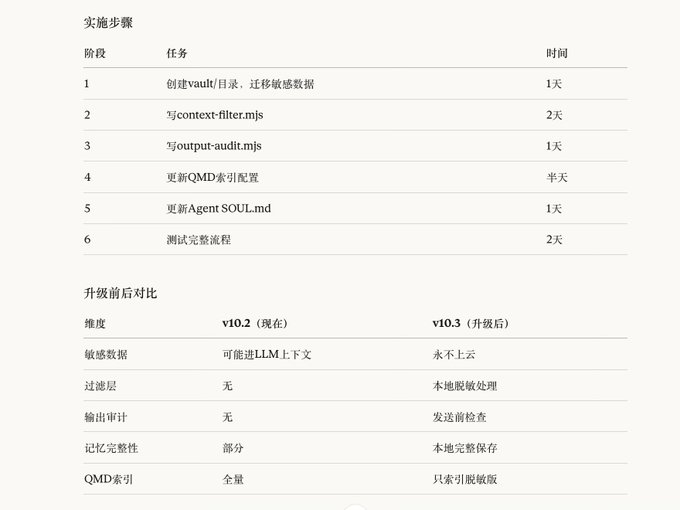

입력 → 로컬 메모리(완료) → 필터링 계층 → 클라우드 LLM → 감사 → 출력 제 접근 방식은 여러 계층으로 구성됩니다.

1. 모든 메모리 정보를 로컬에 저장* — 마크다운 파일 + 로컬 벡터 데이터베이스

필터링 없이 모든 것을 녹화하세요.

이게 진짜 내 모습이야.

2. 클라우드는 필터링된 컨텍스트만 검색합니다.

민감한 정보는 별도로 저장되며 LLM 컨텍스트에 포함되지 않습니다.

-출력 감사— 전송 전에 검사를 수행하십시오

👌

AI에 다음 프롬프트를 전송하세요.

실행 업그레이드: 로컬 메모리 + 필터링 계층 아키텍처

핵심 원칙: 메모리는 핵심 자산입니다. 중요한 정보는 절대 클라우드에 업로드해서는 안 됩니다.

== 보안 규칙 (최우선 순위) ==

1. 각 수정 후에는 시스템이 올바르게 작동하는지 테스트한 다음 다음 단계로 진행하세요.

2. 여러 항목을 동시에 수정하지 마세요.

3. 변경하기 전에 구성을 백업하세요. 예: cp openclaw.json openclaw.json.bak

4. x.com/bitfish/status…

향후 애플과 같은 단말기 제조업체들도 로컬 LLM 엣지 컴퓨팅 모델을 성공적으로 구현할 수 있을 것으로 보인다.

Twitter에서

면책조항: 상기 내용은 작자의 개인적인 의견입니다. 따라서 이는 Followin의 입장과 무관하며 Followin과 관련된 어떠한 투자 제안도 구성하지 않습니다.

라이크

즐겨찾기에 추가

코멘트

공유